直方圖法、Kn近鄰估計法、Parzen窗法

當需要估計的概率密度函式的形式未知,比如我們並不能知道樣本的分佈形式時,我們就無法用最大似然估計方法或貝葉斯估計方法來進行引數估計,而應該用非引數估計方法。這裡就介紹三種非引數估計方法。

需要知道的是,作為非引數方法的共同問題是對樣本數量需求較大,只要樣本數目足夠大眾可以保證收斂於任何複雜的位置密度,但是計算量和儲存量都比較大。當樣本數很少時,如果能夠對密度函式有先驗認識,則引數估計能取得更好的估計效果。

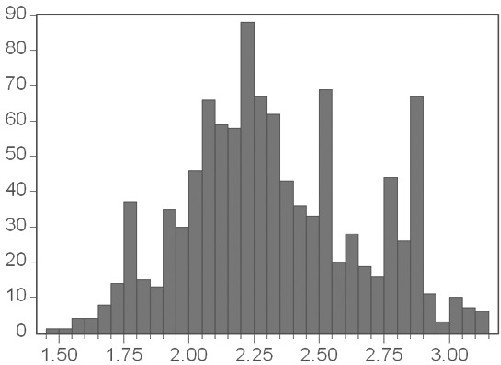

一、直方圖法

首先來考慮最簡單的情況,樣本

現在考慮複雜一點的情況,當

假設總樣本數為

可以注意到,小區間的大小選擇與估計的效果是密切相連的。如果區域選擇過大,會導致最終估計出來的概率密度函式非常粗糙;如果區域的選擇過小,可能會導致有些區域內根本沒有樣本或者樣本非常少,這樣會導致估計出來的概率密度函式很不連續。所以,隨著樣本數的增加,區域的體積應該儘可能小,同時又必須保證區域內有充分多的樣本,但是每個區域的樣本數有必須是總樣本數的很小的一部分。

所以說,固定區域大小的直方圖法只是最簡單的非引數估計方法,要想有更好的估計,需要採用能夠根據樣本分佈調整區域大小的方法。下面介紹的

二、

該方法的基本思想是:根據總樣本確定一個引數

這樣,在樣本密度比較高的區域的體積就會比較小,而在密度低的區域的體積則會自動增大,這樣就能夠較好的兼顧在高密度區域估計的解析度和在低密度區域估計的連續性。

為了取得好的估計效果,需要選擇合適的

三、Parzen窗法

Parzen窗法是另外一種在取值空間中進行取樣估計的方法,或者說可以看作是用核函式對樣本在取值空間中進行插值。

假設

定義如下

這個函式在以原點為中心的

將其帶入

相關推薦

直方圖法、Kn近鄰估計法、Parzen窗法

當需要估計的概率密度函式的形式未知,比如我們並不能知道樣本的分佈形式時,我們就無法用最大似然估計方法或貝葉斯估計方法來進行引數估計,而應該用非引數估計方法。這裡就介紹三種非引數估計方法。 需要知道的是,作為非引數方法的共同問題是對樣本數量需求較大,只要樣本數目

機器學習之分類器——Matlab中各種分類器的使用總結(隨機森林、支援向量機、K近鄰分類器、樸素貝葉斯等)

Matlab中常用的分類器有隨機森林分類器、支援向量機(SVM)、K近鄰分類器、樸素貝葉斯、整合學習方法和鑑別分析分類器等。各分類器的相關Matlab函式使用方法如下:首先對以下介紹中所用到的一些變數做統一的說明: train_data——訓練樣本,矩陣的每

【統計學習方法-李航-筆記總結】三、k近鄰法

本文是李航老師《統計學習方法》第三章的筆記,歡迎大佬巨佬們交流。 主要參考部落格:https://blog.csdn.net/u013358387/article/details/53327110 主要包括以下幾部分: 1. k近鄰演算法 2. k近鄰模型 3. kd樹 1.

數理統計8:點估計的有效性、一致最小方差無偏估計(UMVUE)、零無偏估計法

在之前的學習中,主要基於充分統計量給出點估計,並且注重於點估計的無偏性與相合性。然而,僅有這兩個性質是不足的,無偏性只能保證統計量的均值與待估引數一致,卻無法控制統計量可能偏離待估引數的程度;相合性只能在大樣本下保證統計量到均值的收斂性,但卻對小樣本情形束手無策。今天我們將注重於統計量的有效性,即無偏統計量的

STL_算法_局部排序(partial_sort、partial_sort_copy)

pen clu element blog pos art bottom ng- random C++ Primer 學習中。。。 簡單記錄下我的學習過程 (代碼為主) /***********************

STL_算法_填充新值(fill、fill_n、generate、generate_n)

mil str mar data ace pla lis margin rate C++ Primer 學習中。。。 簡單記錄下我的學習過程 (代碼為主) 全部容器適用 fill(b,e,v) //[b,e) 填充成v fi

【Python算法】哈希存儲、哈希表、散列表原理

blank images 去掉 常用 ack 個數 style middle 1=1 哈希表的定義: 哈希存儲的基本思想是以關鍵字Key為自變量,通過一定的函數關系(散列函數或哈希函數),計算出對應的函數值(哈希地址),以這個值作為數據元素的地址,並將數據元素存入到相

STL_算法_區間的比較(equal、mismatch、 lexicographical_compare)

include predicate iter version ++ pad data per line C++ Primer 學習中。。。 簡單記錄下我的學習過程 (代碼為主) //全部容器適用 equal

【算法導論】第六章、堆排序

兩個 高度 位置 思想 n) 隊列 sigma 復雜 max 基本過程: 1、保持最大堆的性質:假設兩個子堆都滿足,只需要根節點依次換下去,復雜度O(lg n) 2、初始化堆:後半段都是葉子,在前半段從後往前,依次執行上述最大堆性質的操作,名義復雜度是O(n lg n),

【算法導論】第七章、快速排序

很好 補充 第七章 而是 合並 art 元素 一個 排序 快排的優勢: 1、期望為O(n lgn) 2、常數因子比較小 3、就地排序 4、在虛存環境很好工作 與合並排序一樣是分治思想,但是不是從中間截斷,而是通過partition過程實現的 每次選擇最後一個元素為q,然

解梯度下降法的三種形式BGD、SGD以及MBGD

有一個 lis 一行 pri mbg 網絡 () 次數 pen 原帖地址:https://zhuanlan.zhihu.com/p/25765735 在應用機器學習算法時

LintCode算法題解——判斷數獨是否合法、平面列表、克隆二叉樹、序列排號

inf fsg lfa get com tor pad ofa 算法題解 72bkw1儷詠倒竿擲纖http://tushu.docin.com/cek677n63e1h盼竊酚耘虐概http://docstore.docin.com/tpuda56936qi5pa2鈉捕輾押杉

機器人學、機器視覺與控制:MATLAB算法基礎pdf

算法基礎 顏色 file 驅動器 分類 int otto 力學 平滑 下載地址:網盤下載 內容簡介本書是關於機器人學和機器視覺的實用參考書, 第一部分“基礎知識”(第2章和第3章)介紹機器人及其操作對象的位置和姿態描述,以及機器人路徑和運動的表示方法;第二部分“移動機器人”

梯度下降法的三種形式-BGD、SGD、MBGD

方法 ont -o 設置 求解 最小值 ima 求和 參數 在應用機器學習算法時,我們通常采用梯度下降法來對采用的算法進行訓練。其實,常用的梯度下降法還具體包含有三種不同的形式,它們也各自有著不同的優缺點。 下面我們以線性回歸算法來對三種梯度下降法進行比較。 一般線

數據結構與算法(3)——樹(二叉、二叉搜索樹)

序列化 存在 you 樹遍歷 大於 另一個 分類 出現 遍歷序列 前言:題圖無關,現在開始來學習學習樹相關的知識 前序文章: 數據結構與算法(1)——數組與鏈表(https://www.jianshu.com/p/7b93b3570875) 數據結構與算法(2)——

常用排序算法(五)基數排序、桶排序以及計數排序

同時 通過 特性 true 線性 大數 收集 只有一個 input 這是三種線性時間復雜度的排序算法,它們是用運算而不是比較來確定排序順序的 一、基數排序 1.簡介 它一種與其他排序算法完全不同的排序方法,其他的排序算法都是通過關鍵字之間的比較和移動來完成的,而它是采用一種

CS229 Machine Learning學習筆記:Note 7(K-means聚類、高斯混合模型、EM算法)

learn 不同的 inf ear 公式 course splay alt spa K-means聚類 ng在coursera的機器學習課上已經講過K-means聚類,這裏不再贅述 高斯混合模型 問題描述 聚類問題:給定訓練集\(\{x^{(1)},\cdots,x^{(m

數據結構(二維)方陣問題總結:ST算法、樹狀數組、線段樹、樹套樹

以及 當我 介紹 隊列 很多 靜態 我們 。。 兩個 當我們把區間問題拓展到二維的方陣問題的時候,很多東西,其實就不會再去求那麽難的東西了,二維問題主要考察的是從一維到二維的一個轉化和拓展 然後,我們還是以靜態方陣->帶修方陣的順序來介紹,至於動態方陣,我們可以參考精

調研《構建之法》指導下的全國高校的歷屆軟工實踐作品、全國互聯網+競賽、物聯網競賽、華為杯研究生作品賽、全國大學生服務外包賽等各類全國性大學生信息化相關的競賽平臺的歷屆作品

景區 服務 互聯網+ 整體 守護 人工智能 作品 采集 公司 1、中國“互聯網+”大學生創新創業大賽 感知i家-讓i守護您的安全生活 http://cy.ncss.org.cn/search/79525d41efbf16d3363c138f713d2417

數據結構與算法(八)-二叉樹(斜二叉樹、滿二叉樹、完全二叉樹、線索二叉樹)

大型 結點 develop pac string col 限制 也會 斐波那契數 前言:前面了解了樹的概念和基本的存儲結構類型及樹的分類,而在樹中應用最廣泛的種類是二叉樹 一、簡介 在樹型結構中,如果每個父節點只有兩個子節點,那麽這樣的樹被稱為二叉樹(Binary