機器學習實戰----利用AdaBoost元演算法的實現

整理一下寫的非常好的關於AdaBoost演算法的部落格:

1.1 基於第一步,因此外層迴圈即為資料集特徵的迴圈;

1.1.1 如果是按照第一個特徵來劃分類別,那麼第一個特徵點中存在節點,即樹的左右分支,這個時候怎樣判斷是左還是右呢?

1.1.2 首先根據資料大小跟定一個閾值T,這裡我們T=minx+INT*stup,即最小特徵值(第一個座標的最小值或者。。。。。)+(1,2,3,4,5.....)*步長,這個閾值隨著整數值INT的改變而迴圈改變;大於閾值T的則為“rt”,反之則為“lt”;

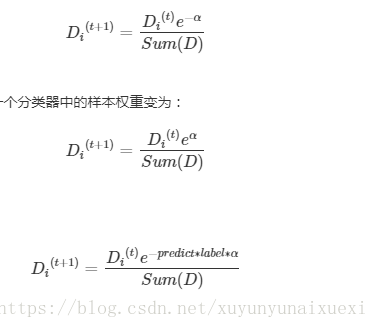

1.1.3判斷錯誤率,初始化一個5*1的列向量e,全部為1,如果預測結果和標籤相同,則將初始化對應的值修改為0,最後再用一個權重向量D.T*e,這個值即為最後的錯誤率,如果這個錯誤率小於一定的閾值,即為最有的決策樹。

《機器學習實戰》這本書上的程式碼就是利用了這一公式,自己理解半天沒懂,這篇部落格幫了大忙。

推導+案例

相關推薦

機器學習實戰——利用AdaBoost元演算法提高分類效能 實現記錄

問題:TypeError: __new__() takes from 2 to 4 positional arguments but 6 were given def loadSimpData(): datMat = matrix([1. ,2.1],

機器學習實戰----利用AdaBoost元演算法的實現

整理一下寫的非常好的關於AdaBoost演算法的部落格:1.1 基於第一步,因此外層迴圈即為資料集特徵的迴圈;1.1.1 如果是按照第一個特徵來劃分類別,那麼第一個特徵點中存在節點,即樹的左右分支,這個時候怎樣判斷是左還是右呢?1.1.2 首先根據資料大小跟定一個閾值T,這裡

機器學習(利用adaboost元算法提高分類性能)

ear tarray 我們 imp quit figure cte 訓練樣本 這一 元算法背後的思路是對其他算法進行組合的一種方式,A from numpy import * def loadSimpData(): datMat = matrix([[ 1. ,

第七章:整合學習(利用AdaBoost元演算法...)

---恢復內容開始--- 整合學習其實不能算一個演算法,應該算是一種框架,集百家之長。整合演算法具體有Bagging與Boosting兩種大類。兩者區別: 1)Bagging是並行的,它就好比找男朋友,美女選擇擇偶物件的時候,會問幾個閨蜜(幾個演算法)的建議,最後選擇一個綜合得分最高的一個作為男朋

《機器學習實戰》AdaBoost方法的演算法原理與程式實現

一、引言提升(boosting)方法是一種常用的統計學習方法,應用廣泛且有效,在分類問題中,它通過改變訓練樣本的權重,學習多個分類器,並將這些分類器進行線性組合,提高分類的效能。對於分類問題,給定一個訓練樣本集,比較粗糙的分類規則(弱分類器),要比精確分類規則(強分類器)容易

【機器學習實戰之一】:C++實現K-近鄰演算法KNN

本文不對KNN演算法做過多的理論上的解釋,主要是針對問題,進行演算法的設計和程式碼的註解。 KNN演算法: 優點:精度高、對異常值不敏感、無資料輸入假定。 缺點:計算複雜度高、空間複雜度高。 適用資料範圍:數值型和標稱性。 工作原理:存在一個樣本資料集合,也稱作訓練樣本集,

《機器學習實戰》——k-近鄰演算法Python實現問題記錄

《機器學習實戰》第二章k-近鄰演算法,自己實現時遇到的問題,以及解決方法。做個記錄。 1.寫一個kNN.py儲存了之後,需要重新匯入這個kNN模組。報錯:no module named kNN. 解決方法:1.將.py檔案放到 site_packages 目錄下

機器學習實戰——SVM支援向量機 實現記錄

問題:TypeError: data type not understood alphas = mat(zeros(m,1)) 原因是zeros(())格式不對,更改後: alphas = mat(zeros((m,1))) 問題:關於IDLE中換行,回車前面出現很多空格的情況

利用AdaBoost元演算法提高分類效能

一、元演算法 元演算法是對其他演算法進行組合的一種方式。我們自然可以將不同的分類器組合起來,而這種組合結果則被稱為整合演算法或者元演算法。 整合學習的結果通過投票法產生,即“少數服從多數” 從這個例子中得出:要獲得好的整合,個體學習器應“好而不同”,即個體學習器要有一定的“準確性”,即

【機器學習實戰】FP-growth演算法詳解

Here is code 背景 apriori演算法 需要多次掃描資料,I/O 大大降低了時間效率 1. fp-tree資料結構 1> 項頭表 記錄所有的1項頻繁集出現的次數,並降序排列 2> fp tree 根據項頭表,構建fp樹 3>

《機器學習實戰》使用ID3演算法構造決策樹

決策樹是一個基本回歸和分類的演算法 決策樹的優點: 1.易於理解和解釋,並且可以視覺化。 2.幾乎不需要資料預處理。決策樹還不支援缺失值。 3.可以同時處理數值變數和分類變數。其他方法大都適用於分析一種變數的集合。 4.可以處理多值輸出變數問題。 決策樹的缺點: 決策樹

機器學習實戰:K近鄰演算法--學習筆記

一、KNN的工作原理 假設有一個帶有標籤的樣本資料集(訓練樣本集),其中包含每條資料與所屬分類的對應關係。 輸入沒有標籤的新資料後,將新資料的每個特徵與樣本集中資料對應的特徵進行比較。 1) 計算新資料與樣本資料集中每條資料的距離。 2) 對求得的所有距離進

《機器學習實戰》二分-kMeans演算法(二分K均值聚類)

首先二分-K均值是為了解決k-均值的使用者自定義輸入簇值k所延伸出來的自己判斷k數目,其基本思路是: 為了得到k個簇,將所有點的集合分裂成兩個簇,從這些簇中選取一個繼續分裂,如此下去,直到產生k個簇。 虛擬碼: 初始化簇表,使之包含由所有的點組成的簇。 repeat &n

機器學習之BP神經網路演算法實現影象分類

BP 演算法是一個迭代演算法,它的基本思想為:(1) 先計算每一層的狀態和啟用值,直到最後一層(即訊號是前向傳播的);(2) 計算每一層的誤差,誤差的計算過程是從最後一層向前推進的(這就是反向傳播演算法名字的由來);(3) 更新引數(目標是誤差變小),迭代前面兩

機器學習實戰——使用FP-growth演算法來發現頻繁集

問題:RuntimeError: dictionary changed size during iteration #問題程式碼 for k in headerTable.keys(): if headerTable[k]< minSup:

機器學習實戰——1.1K近鄰演算法

宣告:參考書目《機器學習實戰》作者: Peter Harrington 出版社: 人民郵電出版社 譯者: 李銳 / 李鵬 / 曲亞東 / 王斌 參考部落格 Jack-Cui 作者個人網站:http://cuijiahua.com/ 公式: K近鄰演算法的

《機器學習實戰》Logistic迴歸演算法(1)

-0.017612 14.053064 0 -1.395634 4.662541 1 -0.752157 6.5386200 -1.322371 7.152853 0 0.42336311.054677 0 0.406704 7.067335 1 0

機器學習實戰筆記-K近鄰演算法2(改進約會網站的配對效果)

案例二.:使用K-近鄰演算法改進約會網站的配對效果 案例分析: 海倫收集的資料集有三類特徵,分別是每年獲得的飛行常客里程數、玩視訊遊戲所耗時間百分比、 每週消費的冰淇淋公升數。我們需要將新資

機器學習實戰之k-近鄰演算法(3)---如何視覺化資料

關於視覺化: 《機器學習實戰》書中的一個小錯誤,P22的datingTestSet.txt這個檔案,根據網上的原始碼,應該選擇datingTestSet2.txt這個檔案。主要的區別是最後的標籤,作者原來使用字串‘veryLike’作為標籤,但是Python轉換會出現Val

《機器學習實戰》使用Apriori演算法和FP-growth演算法進行關聯分析(Python版)

===================================================================== 《機器學習實戰》系列部落格是博主閱讀《機器學