特徵值分解與奇異值分解及其應用

SVD奇異值分解

正交矩陣

正交矩陣

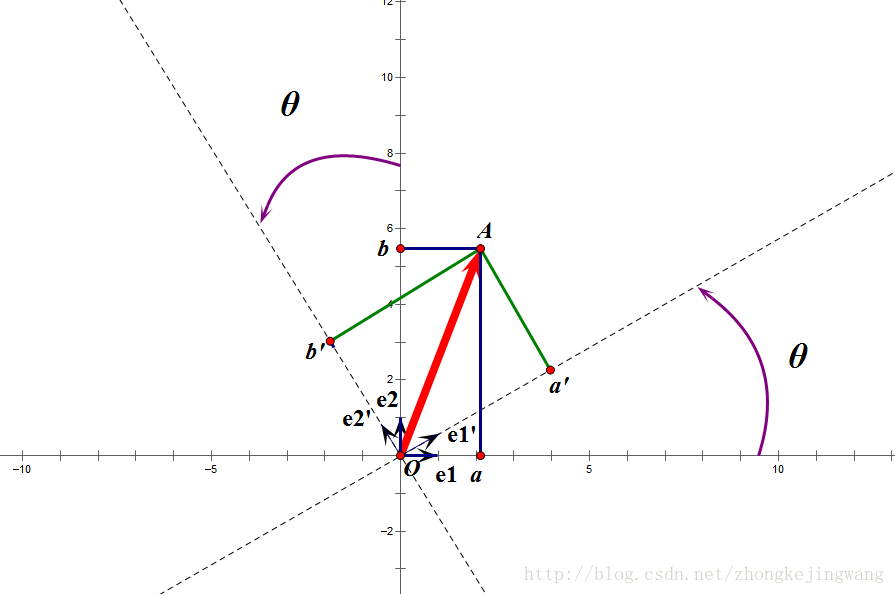

正交矩陣對應著正交變換,特點在於不改變向量的尺寸(模)和任意兩個向量的夾角。在x-y座標系中,通俗地講,就是旋轉兩個座標軸,得到新的互相垂直的座標軸,求向量在新座標系中的投影。

正交變換舉例

圖片摘自此處。 例如向量

,在原始

可以代入求得矩陣 ,且可觀察到矩陣的行向量之間都是正交的,列向量之間也是正交的。

正交矩陣的性質

正交陣的逆等於其轉置

特徵值分解

特徵值分解

是

滿秩對稱方陣(對稱陣的特徵向量之間兩兩正交),有

個特徵值

,對應

個特徵向量

,有:

可以理解為向量 在 的作用下,保持方向不變,只進行比例為 的縮放。特徵向量所在的直線包含了所有特徵向量(稱為特徵空間)。

以上 個等式寫成矩陣形式( 是 的列向量!)

等式兩邊右乘 的逆,得到 的特徵值分解:

進一步,由於特徵向量矩陣 各列相互正交,所以 是正交陣,正交陣的逆等於其轉置:

相關推薦

特徵值分解與奇異值分解及其應用

SVD奇異值分解 正交矩陣 正交矩陣 正交矩陣對應著正交變換,特點在於不改變向量的尺寸(模)和任意兩個向量的夾角。在x-y座標系中,通俗地講,就是旋轉兩個座標軸,得到新的互相垂直的座標軸,求向量在新座標系中的投影。 正交變換舉例

矩陣特徵值分解與奇異值分解含義解析及應用

此文有一半轉載自他出,主要在這進行個整理,具體內容文中都有相關的轉載連結。特徵值與特徵向量的幾何意義矩陣的乘法是什麼,別隻告訴我只是“前一個矩陣的行乘以後一個矩陣的列”,還會一點的可能還會說“前一個矩陣的列數等於後一個矩陣的行數才能相乘”,然而,這裡卻會和你說——那都是表象。

矩陣的特徵值分解與奇異值分解的幾何意義

1、首先,矩陣可以認為是一種線性變換:確定了定義域空間與目標空間的兩組基,就可以很自然地得到該線性變換的矩陣表示。即矩陣A可以通過Ax=b將一個向量x線性變換到另一個向量b,這個過程中,線性變換的作用包

【PCA與LDA】特徵值分解與奇異值分解以及影象壓縮處理原理

上一次寫了關於PCA與LDA的文章,PCA的實現一般有兩種,一種是用特徵值分解去實現的,一種是用奇異值分解去實現的。在上篇文章中便是基於特徵值分解的一種解釋。特徵值和奇異值在大部分人的印象中,往往是停留在純粹的數學計算中。而且線性代數或者矩陣論裡面,也很少講任何跟特徵值與奇異值有關的應用背景。奇異值分

機器學習的數學基礎 - 特征分解與奇異值分解

src ron 特征 技術 ima 基礎 bsp posit pos 特征分解 奇異值分解(Singular Value Decomposition, SVD) 機器學習的數學基礎 - 特征分解與奇異值分解

線性代數基礎(矩陣、範數、正交、特徵值分解、奇異值分解、跡運算)

目錄 基礎概念 矩陣轉置 對角矩陣 線性相關 範數 正交 特徵值分解 奇異值分解 跡運算 行列式 如果這篇文章對你有一點小小的幫助,請給個關注喔~我會非常開心的~ 基礎概念 標量:一個標量就是一個單獨的數字 向量:一個向量就是一列數字 矩

特徵值分解、奇異值分解、PCA概念整理

這裡V就是上面的右奇異向量,另外還有: 這裡的σ就是奇異值,u就是上面說的左奇異向量。【證明那個哥們也沒給】 奇異值σ跟特徵值類似,在矩陣Σ中也是從大到小排列,而且σ的減少特別的快,在很多情況下,前10%甚至1%的奇異值的和就佔了全部的奇異值之和的99%以上了。也就是說,我們也可以用前r( r

特徵值分解, 奇異值分解

Ref: https://en.wikipedia.org/wiki/Eigendecomposition_of_a_matrix http://www.cnblogs.com/pinard/p/6251584.html http

特徵值分解,奇異值分解svd

特徵值分解: 特徵值分解(Eigen decomposition),又稱譜分解(Spectral decomposition)是將矩陣分解為由其特徵值和特徵向量表示的矩陣之積的方法。需要注意只有方陣才可以施以特徵值分解。 N 維非零向量 v 是 N

數學基礎系列(六)----特徵值分解和奇異值分解(SVD)

一、介紹 特徵值和奇異值在大部分人的印象中,往往是停留在純粹的數學計算中。而且線性代數或者矩陣論裡面,也很少講任何跟特徵值與奇異值有關的應用背景。 奇異值分解是一個有著很明顯的物理意義的一種方法,它可以將一個比較複雜的矩陣用更小更簡單的幾個子矩陣的相乘來表示,這些小矩陣描述的是矩陣的重要的特性。就像是

SVD分解(奇異值分解)求旋轉矩陣

參考文獻:http://igl.ethz.ch/projects/ARAP/svd_rot.pdf 一 問題描述 假設P={p1,p2,...,pn}和Q={q1,q2,...,qn}是兩組Rd空間中的對應點集,現在想要根據這個兩個點集的資料來計算出它們之間的剛性轉置

矩陣分解:奇異值分解(SVD)詳解

SVD分解 SVD分解是淺層語義分析(LSA)的數學基礎,本文是我的LSA學習筆記的一部分,之所以單獨拿出來,是因為SVD可以說是LSA的基礎,要理解LSA必須瞭解SVD,因此將LSA筆記的SVD一節單獨作為一篇文章。本節討論SVD分解相關數學問題,一個分為3個部分,第

特征值分解和奇異值分解

雲計 做到 mpi img .cn wikipedia cti 雲計算 position 特征值和奇異值在大部分人的印象中,往往是停留在純粹的數學計算中。而且線性代數或者矩陣論裏面,也很少講任何跟特征值與奇異值有關的應用背景。 奇異值分解是一個有著很明顯的物理意義的

[數學] 奇異值分解SVD的理解與應用

資料 blank art use 過濾 ble 對角線 cos .net 看一個預測的代碼,在預處理數據的時候使用了svd。了解了一下svd相關資料,比較喜歡第一篇文章的解釋,不過第二篇也很簡單。 https://blog.csdn.net/ab_use/article/d

機器學習中的數學-強大的矩陣奇異值分解(SVD)及其應用

版權宣告: 本文由LeftNotEasy釋出於http://www.cnblogs.com/LeftNotEasy/archive/2011/01/19/svd-and-applications.html 前言: &nb

機器學習:奇異值分解SVD簡介及其在推薦系統中的簡單應用

轉載自:https://www.cnblogs.com/lzllovesyl/p/5243370.html 本文先從幾何意義上對奇異值分解SVD進行簡單介紹,然後分析了特徵值分解與奇異值分解的區別與聯絡,最後用python實現將SVD應用於推薦系統。 1.SVD詳解 SVD(singul

奇異值分解SVD簡介及其在推薦系統中的簡單應用

本文先從幾何意義上對奇異值分解SVD進行簡單介紹,然後分析了特徵值分解與奇異值分解的區別與聯絡,最後用python實現將SVD應用於推薦系統。 1.SVD詳解 SVD(singular value decomposition),翻譯成中文就是奇異值分解。SVD的用處有

奇異值分解(SVD)原理與在降維中的應用

奇異值分解(Singular Value Decomposition,以下簡稱SVD)是在機器學習領域廣泛應用的演算法,它不光可以用於降維演算法中的特徵分解,還可以用於推薦系統,以及自然語言處理等領域。是很多機器學習演算法的基石。本文就對SVD的原理做一個總結,

SVD奇異值分解 中特徵值與奇異值的數學理解與意義

前言 之前的部落格中SVD推薦演算法寫得不是很嚴謹,r̂ ui=∑Ff=1PufQfi+μ+bu+bir^ui=∑f=1FPufQfi+μ+bu+bi 更像是矩陣分解多一點,沒有涉及到SVD的數學意義,這篇部落格大概會寫一些數學SVD的數學理解,以及SVD在P

奇異值的物理意義是什麼?強大的矩陣奇異值分解(SVD)及其應用

強大的矩陣奇異值分解(SVD)及其應用 一、奇異值與特徵值基礎知識: 特徵值分解和奇異值分解在機器學習領域都是屬於滿地可見的方法。兩者有著很緊密的關係,我在接下來會談到,特徵值分解和奇異值分解的目的都是一樣,就是提取出一個矩陣最重要的特徵。先談談特徵值分解吧: 1)特徵值: 如果說一個向量v是方陣