斯坦福ML公開課筆記15—隱含語義索引、奇異值分解、獨立成分分析

斯坦福ML公開課筆記15

我們在上一篇筆記中講到了PCA(主成分分析)。PCA是一種直接的降維方法,通過求解特徵值與特徵向量,並選取特徵值較大的一些特徵向量來達到降維的效果。

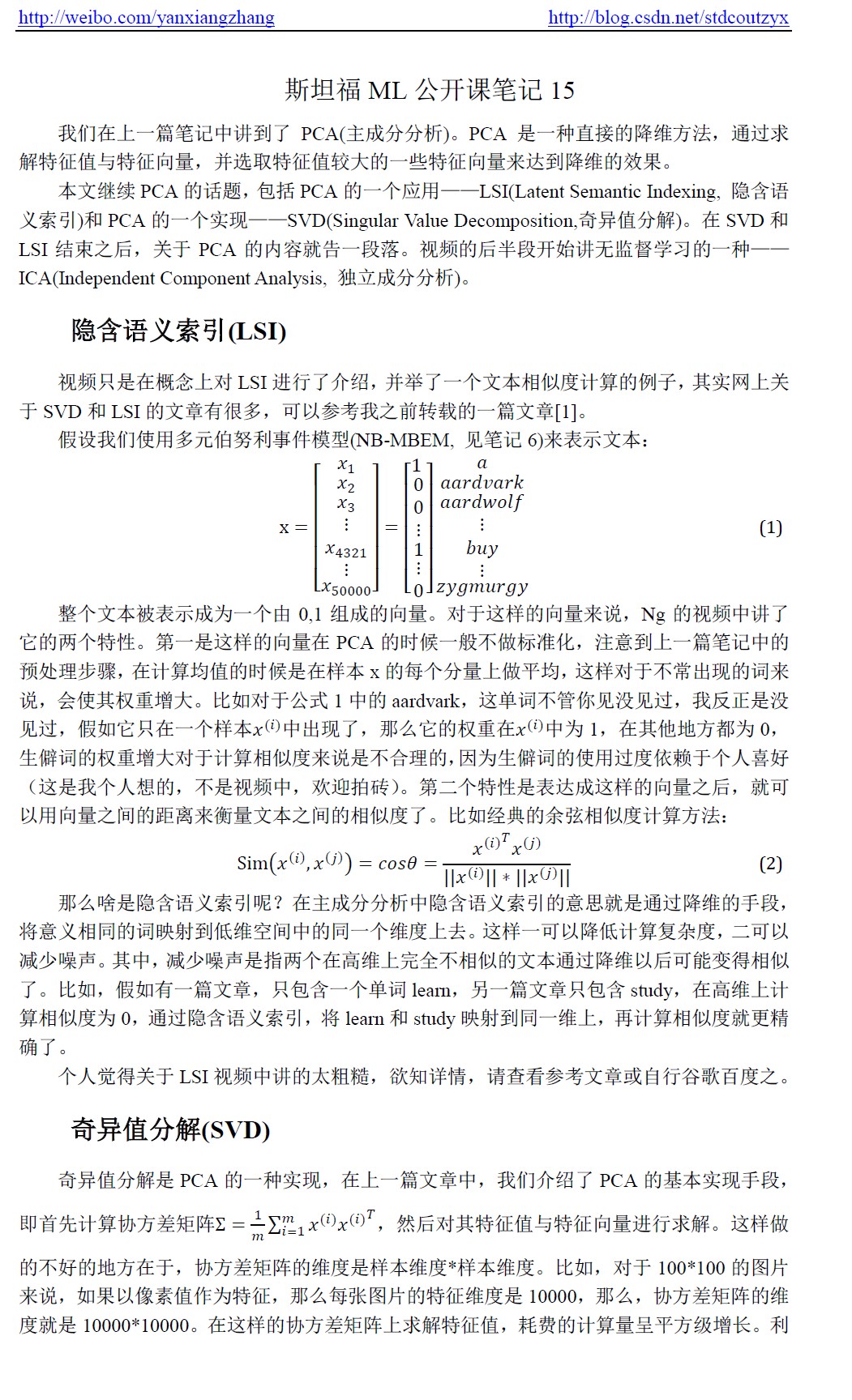

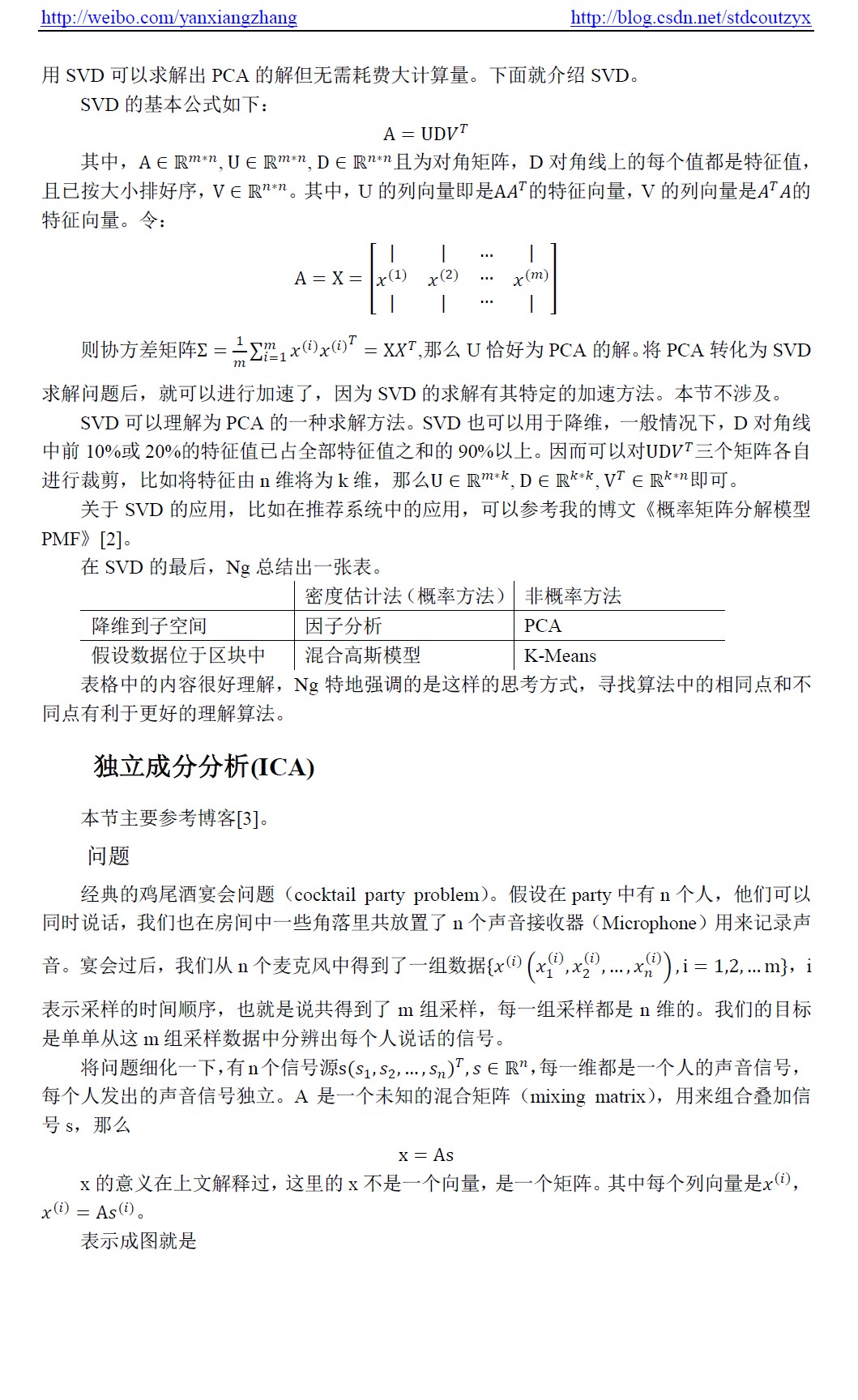

本文繼續PCA的話題,包括PCA的一個應用——LSI(Latent Semantic Indexing, 隱含語義索引)和PCA的一個實現——SVD(Singular Value Decomposition,奇異值分解)。在SVD和LSI結束之後,關於PCA的內容就告一段落。視訊的後半段開始講無監督學習的一種——ICA(Independent Component Analysis, 獨立成分分析)。

本筆記的13-15部分的pdf已上傳csdn資源中,下載請猛擊

相關推薦

斯坦福ML公開課筆記15—隱含語義索引、奇異值分解、獨立成分分析

斯坦福ML公開課筆記15 我們在上一篇筆記中講到了PCA(主成分分析)。PCA是一種直接的降維方法,通過求解特徵值與特徵向量,並選取特徵值較大的一些特徵向量來達到降維的效果。 本文繼續PCA的話題,包

斯坦福ML公開課筆記14——主成分分析

上一篇筆記中,介紹了因子分析模型,因子分析模型使用d維子空間的隱含變數z來擬合訓練資料,所以實際上因子分析模型是一種資料降維的方法,它基於一個概率模型,使用EM演算法來估計引數。 本篇主要介紹PCA(

斯坦福公開課筆記,day10.30.18

1 一個線性查詢函式的泛型實現 example1: int lsearch (int key, int array[], int size) { for (int i =0; i< size; i++) { if (array[i] == key) { r

斯坦福機器學習公開課筆記 十三 推薦系統

也歡迎大家轉載本篇文章。分享知識,造福人民,實現我們中華民族偉大復興! 授課老師:Andrew Ng1、problem formulation(問題產生)在平時購物的時候我們都會看到網站把向我們推薦的商品放在醒目位置,其實這就是推薦

斯坦福機器學習網易公開課筆記1

之前在coursera上看了Andrew Ng的機器學習課程,那個課程比較簡明,適合對機器學習有一個整體的印象,但是很多細節的內容和推導都忽略了。現在想要了解機器學習更多,所以開始看Andrew Ng在網易公開課上的機器學習課程,並對每一講整理筆記,以促使自己更好的理解和記

斯坦福機器學習公開課筆記(十五)--[應用]照片OCR技術

1、problem description and pipeline(問題描述和流水線) OCR是optical character recognition的縮寫,翻譯過來就是光學字元辨識。照片中的OCR技術其實就是識別中照片中存在的字元,例如下面這幅圖: 關於過程

斯坦福機器學習公開課筆記(十三)--推薦系統

授課老師:Andrew Ng 1、problem formulation(問題產生) 在平時購物的時候我們都會看到網站把向我們推薦的商品放在醒目位置,其實這就是推薦系統。現在考慮一個電影推薦系統的例子,我們擁有一些使用者對於一些電影的評分,如下: 從上面可以看到,使

斯坦福機器學習公開課筆記(一)--單變數線性迴歸

授課老師:Andrew Ng 1、model representation(建立模型) 考慮一個問題,如果給定一些房屋售價和房屋面積的資料,現在要預測給定其他面積時的房屋售價,那該怎麼辦?其實這是一個線性迴歸問題,給定的資料作為訓練樣本,用其訓練得到一個表示售價和麵積關

斯坦福大學公開課 iOS應用開發教程學習筆記(第四課) Views 檢視

第四課名稱: Views 檢視 課程開始老師懷念了一會老喬。接著介紹這次的課程分為兩部分,一部分是Calculator的Demo,一部分是Views. 課程開始到第四課,其實斯坦福的課程裡是有作業的,人家已經做完了第一個作業了,就是完善計算器這個程式,完成一個比較複雜

機器學習公開課筆記第九周之大數據梯度下降算法

機器學習 nbsp gradient min 三種 依次 再看 獲得 mini 一,隨機梯度下降法(Stochastic Gradient Descent) 當訓練集很大且使用普通梯度下降法(Batch Gradient Descent)時,因為每一次\(\theta\)

廣義線性模型 - Andrew Ng機器學習公開課筆記1.6

sans luci art 能夠 tro ron 便是 import grand 在分類問題中我們如果: 他們都是廣義線性模型中的一個樣例,在理解廣義線性模型之前須要先理解指數分布族。 指數分

斯坦福大學公開課機器學習:Neural Networks,representation: non-linear hypotheses(為什麽需要做非線性分類器)

繼續 例子 產生 成本 log repr 概率 .cn 成了 如上圖所示,如果用邏輯回歸來解決這個問題,首先需要構造一個包含很多非線性項的邏輯回歸函數g(x)。這裏g仍是s型函數(即 )。我們能讓函數包含很多像這的多項式,當多項式足夠多時,那麽你也許能夠得到可以

斯坦福大學公開課機器學習:Neural network-model representation(神經網絡模型及神經單元的理解)

如何 work 單元 pre 結果 mda s函數 額外 權重 神經網絡是在模仿大腦中的神經元或者神經網絡時發明的。因此,要解釋如何表示模型假設,我們先來看單個神經元在大腦中是什麽樣的。如下圖,我們的大腦中充滿了神經元,神經元是大腦中的細胞,其中有兩點值得我們註意,一是神經

斯坦福大學公開課機器學習: advice for applying machine learning - evaluatin a phpothesis(怎麽評估學習算法得到的假設以及如何防止過擬合或欠擬合)

class 中一 技術分享 cnblogs 訓練數據 是否 多個 期望 部分 怎樣評價我們的學習算法得到的假設以及如何防止過擬合和欠擬合的問題。 當我們確定學習算法的參數時,我們考慮的是選擇參數來使訓練誤差最小化。有人認為,得到一個很小的訓練誤差一定是一件好事。但其實,僅

斯坦福大學公開課機器學習: advice for applying machine learning | regularization and bais/variance(機器學習中方差和偏差如何相互影響、以及和算法的正則化之間的相互關系)

交叉 來講 相對 同時 test 如果 開始 遞增 相互 算法正則化可以有效地防止過擬合, 但正則化跟算法的偏差和方差又有什麽關系呢?下面主要討論一下方差和偏差兩者之間是如何相互影響的、以及和算法的正則化之間的相互關系 假如我們要對高階的多項式進行擬合,為了防止過擬合現象

斯坦福大學公開課機器學習:advice for applying machine learning | learning curves (改進學習算法:高偏差和高方差與學習曲線的關系)

繪制 學習曲線 pos 情況 但我 容量 繼續 並且 inf 繪制學習曲線非常有用,比如你想檢查你的學習算法,運行是否正常。或者你希望改進算法的表現或效果。那麽學習曲線就是一種很好的工具。學習曲線可以判斷某一個學習算法,是偏差、方差問題,或是二者皆有。 為了繪制一條學習曲

斯坦福大學公開課機器學習: advice for applying machine learning | deciding what to try next(revisited)(針對高偏差、高方差問題的解決方法以及隱藏層數的選擇)

ice 簡單 pos .com img 想要 技術 分割 就是 針對高偏差、高方差問題的解決方法: 1、解決高方差問題的方案:增大訓練樣本量、縮小特征量、增大lambda值 2、解決高偏差問題的方案:增大特征量、增加多項式特征(比如x1*x2,x1的平方等等)、減少la

斯坦福大學公開課機器學習:machine learning system design | trading off precision and recall(F score公式的提出:學習算法中如何平衡(取舍)查準率和召回率的數值)

ron 需要 color 不可 關系 machine 同時 機器學習 pos 一般來說,召回率和查準率的關系如下:1、如果需要很高的置信度的話,查準率會很高,相應的召回率很低;2、如果需要避免假陰性的話,召回率會很高,查準率會很低。下圖右邊顯示的是召回率和查準率在一個學習算

斯坦福大學公開課機器學習:machine learning system design | data for machine learning(數據量很大時,學習算法表現比較好的原理)

ali 很多 好的 info 可能 斯坦福大學公開課 數據 div http 下圖為四種不同算法應用在不同大小數據量時的表現,可以看出,隨著數據量的增大,算法的表現趨於接近。即不管多麽糟糕的算法,數據量非常大的時候,算法表現也可以很好。 數據量很大時,學習算法表現比

從零到一學習計算機視覺:朋友圈爆款背後的計算機視覺技術與應用 | 公開課筆記...

分享人 | 葉聰(騰訊雲 AI 和大資料中心高階研發工程師)整 理 | Leo出 品 | 人工智