android ffmpeg+OpenGL播放yuv+openSL 快放 慢放 視訊播放器

這裡是完整的音視訊播放器,功能如下(這裡有iOS版的):

視訊是通過opengl 播放yuv資料,音訊是opensl播放。

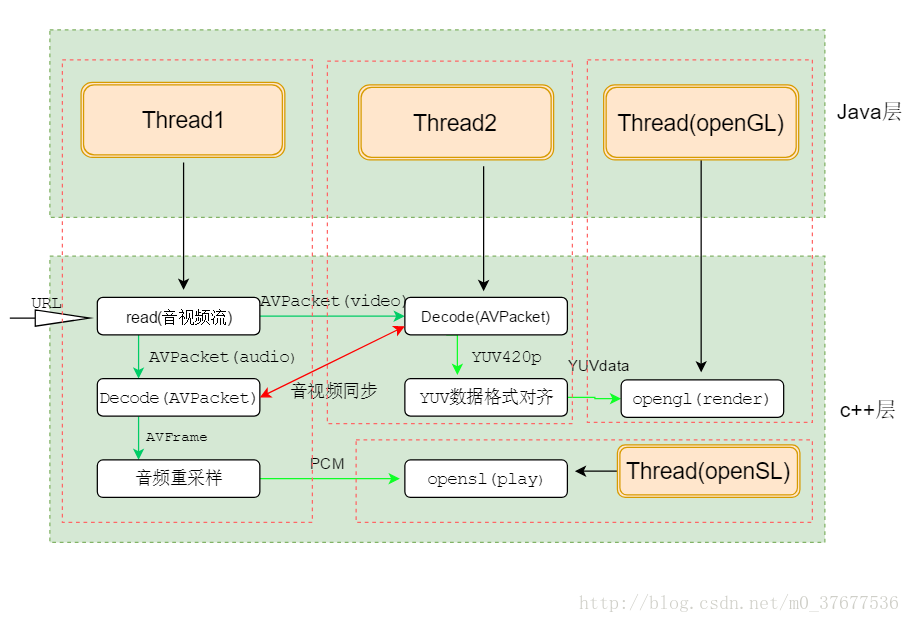

app執行流程如下圖:

紅色虛線內的是一個執行緒的執行,總共涉及到四個執行緒。

java層幾乎沒有播放器的內容,ffmpeg,opengl,opensl都是在c++層執行,所以可以原封不動的遷移到其他平臺,如ios,不過c/c++程式碼ios程式設計師看起來不太友好,有ios版的,ios版的有yuv->RGB->image的方法,有ffmpeg解碼播放流程圖,解碼播放流程一目瞭然。

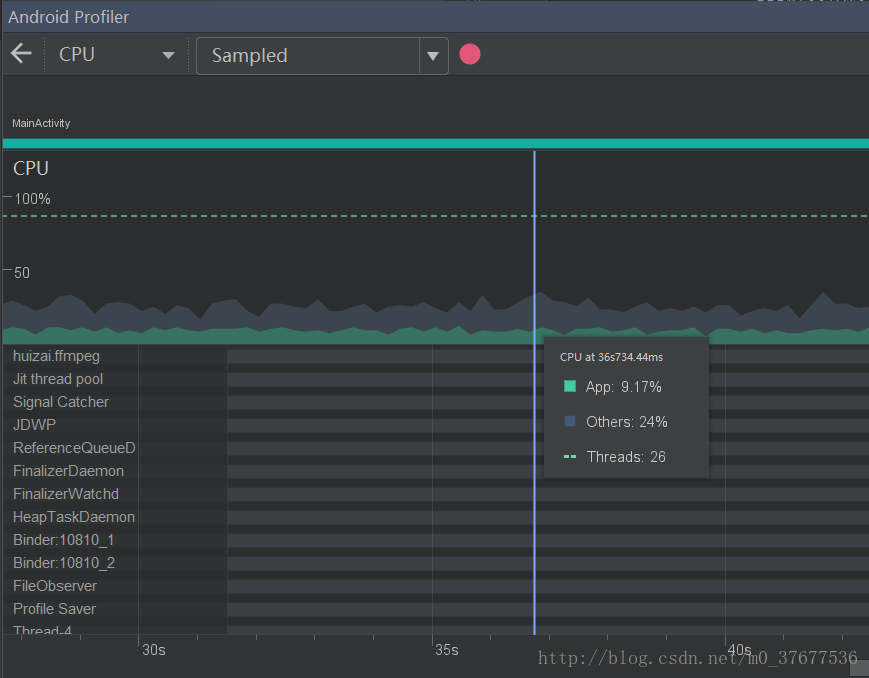

看一下app表現,小米6播放每分鐘100M等級的視訊:

可以看到cpu使用在10%左右,很省電了有沒有100M每分鐘,一部電影是十幾G的清晰度。

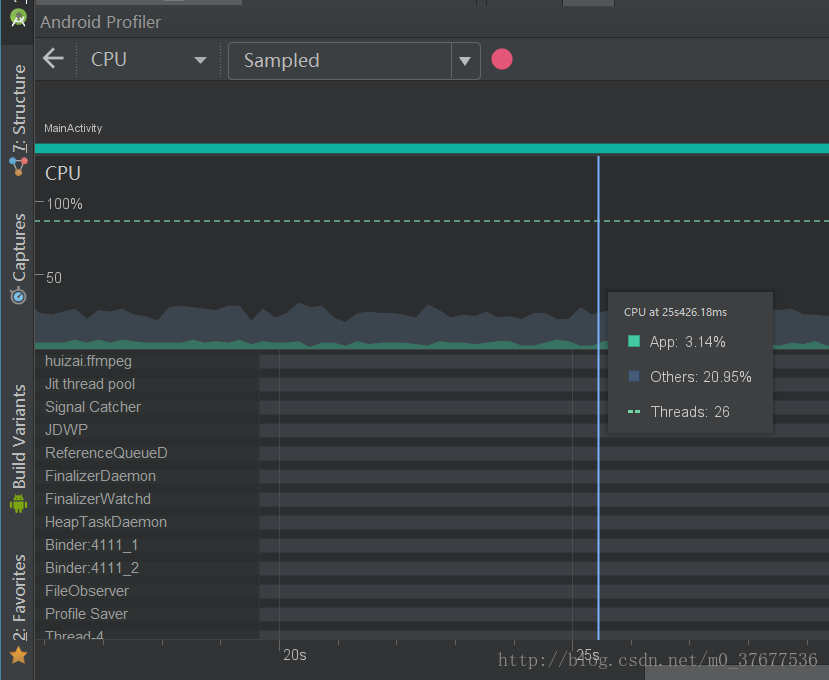

再看常規清晰度720p:

cpu消耗只有3%左右,這也就是直播清晰度了,這cpu消耗還能說什麼。

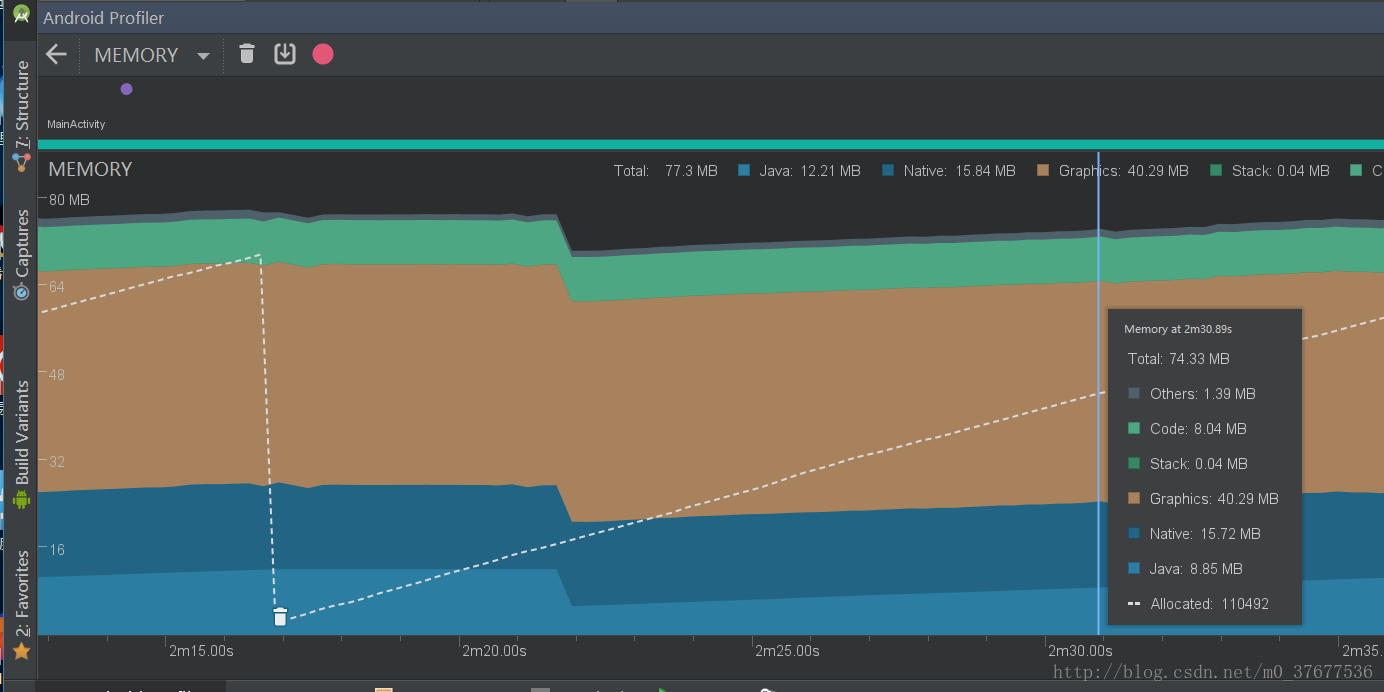

看記憶體優化:

整個播放過程native層記憶體佔用都在15M左右波動,Graphics佔用記憶體也沒變化,播放過程中記憶體釋放很到位,沒有記憶體增長。大家可以自行測試。

這裡給大家看下ffmpeg解碼程式碼:

FFmpeg.h

//

// Created by huizai on 2017/11/22.

//

#ifndef FFMPEG_DEMO_FFMPEGDECODER_H

#define FFMPEG_DEMO_FFMPEGDECODER_H

#include "JniDefine.h"

#include "YUV_GL_DATA.h" FFmpeg.cpp

//

// Created by huizai on 2017/11/22.

//

#include "FFmpeg.h"

int OpenAndInitDecoder(Decoder * decoder){

//1.註冊所有元件

av_register_all();

avformat_network_init();

//2.開啟輸入視訊檔案

//封裝格式上下文,統領全域性的結構體,儲存了視訊檔案封裝格式的相關資訊

decoder->pFormatCtx = avformat_alloc_context();

int ret = avformat_open_input(&decoder->pFormatCtx, decoder->url, NULL, NULL);

if (ret != 0) {

return ret;

} else{

FFLOGI("視訊長度:%d",decoder->pFormatCtx->duration);

}

decoder->totleMs = (int)(decoder->pFormatCtx->duration/AV_TIME_BASE)*1000;

avformat_find_stream_info(decoder->pFormatCtx, NULL);

//分別找到音訊視訊解碼器並開啟解碼器

for (int i = 0; i < decoder->pFormatCtx->nb_streams; i++) {

AVStream *stream = decoder->pFormatCtx->streams[i];

AVCodec * codec = avcodec_find_decoder(stream->codecpar->codec_id);

AVCodecContext * codecCtx = avcodec_alloc_context3(codec);

avcodec_parameters_to_context(codecCtx, stream->codecpar);

if (codecCtx->codec_type == AVMEDIA_TYPE_VIDEO) {

printf("video\n");

decoder->videoStreamIndex = i;

decoder->pVideoCodec = codec;

decoder->pVideoCodecCtx = codecCtx;

int err = avcodec_open2(decoder->pVideoCodecCtx, decoder->pVideoCodec, NULL);

if (err != 0) {

char buf[1024] = {0};

av_strerror(err, buf, sizeof(buf));

printf("open videoCodec error:%s", buf);

return false;

}

}

if (codecCtx->codec_type == AVMEDIA_TYPE_AUDIO) {

printf("audio\n");

decoder->audioStreamIndex = i;

decoder->pAudioCodec = codec;

decoder->pAudioCodecCtx = codecCtx;

int err = avcodec_open2(decoder->pAudioCodecCtx, decoder->pAudioCodec, NULL);

if (err != 0) {

char buf[1024] = {0};

av_strerror(err, buf, sizeof(buf));

printf("open audionCodec error:%s", buf);

return false;

}

if (codecCtx->sample_rate != SAMPLE_RATE) {

decoder->sampleRate = codecCtx->sample_rate;

}

}

}

decoder ->pYuv = av_frame_alloc();

decoder ->pPcm = av_frame_alloc();

decoder ->channel = CHANNEL;

decoder ->sampleSize = SAMPLE_SIZE;

decoder ->sampleRate = decoder->pAudioCodecCtx->sample_rate;

// printf("open acodec success! sampleRate:%d channel:%d sampleSize:%d fmt:%d\n",

// decoder->sampleRate,decoder->channel,decoder->sampleSize,decoder->pAudioCodecCtx->sample_fmt);

FFLOGI("open acodec success! sampleRate:%d channel:%d fmt:%d\n",

decoder->pAudioCodecCtx->sample_rate,decoder->pAudioCodecCtx->channels,decoder->pAudioCodecCtx->sample_fmt);

return ret;

}

int Read(Decoder * decoder){

//這裡先不加執行緒鎖,在啟動多執行緒的地方統一加鎖

// AVPacket * pkt = malloc(sizeof(AVPacket));

if (!decoder->pFormatCtx) {

return -1;

}

int err = av_read_frame(decoder->pFormatCtx,&decoder->pkt);

if (err != 0) {

printError("av_read_pkt_error:",err);

if (err == -541478725){

//讀取檔案結束

return -9;

}

return -2;

}

return 0;

}

int Decode(Decoder* decoder,AVPacket packet){

if (!decoder->pFormatCtx) {

return -1;

}

//分配AVFream 空間

if (decoder->pYuv == NULL) {

decoder->pYuv = av_frame_alloc();

}

if (decoder->pPcm == NULL) {

decoder->pPcm = av_frame_alloc();

}

AVCodecContext * pCodecCtx;

AVFrame * tempFrame;

if (packet.stream_index == decoder->videoStreamIndex) {

pCodecCtx = decoder->pVideoCodecCtx;

tempFrame = decoder->pYuv;

}else if (packet.stream_index == decoder->audioStreamIndex){

pCodecCtx = decoder->pAudioCodecCtx;

tempFrame = decoder->pPcm;

}else{

return -1;

}

if (!pCodecCtx) {

return -1;

}

int re = avcodec_send_packet(pCodecCtx,&packet);

if (re != 0) {

char errorBuf[1024] = {0};

av_make_error_string(errorBuf,1024,re);

FFLOGE("send pkt error:%s",errorBuf);

return -1;

}

re = avcodec_receive_frame(pCodecCtx, tempFrame);

if (re != 0) {

char errorBuf[1024] = {0};

av_make_error_string(errorBuf,1024,re);

FFLOGE("receive av_data error:%s",errorBuf);

return -1;

}

if (packet.stream_index == decoder->videoStreamIndex) {

decoder->vFps = (int)((packet.pts * r2d(decoder->pFormatCtx->streams[decoder->videoStreamIndex]->time_base))*1000);

}else if (packet.stream_index == decoder->audioStreamIndex){

decoder->aFps = (int)((packet.pts * r2d(decoder->pFormatCtx->streams[decoder->audioStreamIndex]->time_base))*1000);

}

FFLOGI("[D]");

return 0;

}

int Min(int a,int b){

return a>b?b:a;

}

void copyDecodedFrame(unsigned char *src, unsigned char *dist,int linesize, int width, int height)

{

width = Min(linesize, width);

if (sizeof(dist) == 0) {

return;

}

for (int i = 0; i < height; ++i) {

memcpy(dist, src, width);

dist += width;

src += linesize;

}

}

int YuvToGLData(Decoder *decoder){

if (!decoder->pFormatCtx || !decoder->pYuv ||decoder-> pYuv->linesize[0] <= 0) {

return -1;

}

//把資料重新封裝成opengl需要的格式

unsigned int lumaLength= (unsigned int)(decoder->pYuv->height)*(Min(decoder->pYuv->linesize[0], decoder->pYuv->width));

unsigned int chromBLength=(unsigned int)((decoder->pYuv->height)/2)*(Min(decoder->pYuv->linesize[1], (decoder->pYuv->width)/2));

unsigned int chromRLength=(unsigned int)((decoder->pYuv->height)/2)*(Min(decoder->pYuv->linesize[2], (decoder->pYuv->width)/2));

decoder->yuvFrame.luma.dataBuffer = (unsigned char*)malloc(lumaLength);

decoder->yuvFrame.chromaB.dataBuffer = (unsigned char*)malloc(chromBLength);

decoder->yuvFrame.chromaR.dataBuffer = (unsigned char*)malloc(chromRLength);

decoder->yuvFrame.width=(unsigned int)decoder->pYuv->width;

decoder->yuvFrame.height=(unsigned int)decoder->pYuv->height;

if (decoder->pYuv->height <= 0) {

free(decoder->yuvFrame.luma.dataBuffer);

free(decoder->yuvFrame.chromaB.dataBuffer);

free(decoder->yuvFrame.chromaR.dataBuffer);

return -1;

}

copyDecodedFrame(decoder->pYuv->data[0],decoder->yuvFrame.luma.dataBuffer,decoder->pYuv->linesize[0],

decoder->pYuv->width,decoder->pYuv->height);

copyDecodedFrame(decoder->pYuv->data[1], decoder->yuvFrame.chromaB.dataBuffer,decoder->pYuv->linesize[1],

decoder->pYuv->width / 2,decoder->pYuv->height / 2);

copyDecodedFrame(decoder->pYuv->data[2], decoder->yuvFrame.chromaR.dataBuffer,decoder->pYuv->linesize[2],

decoder->pYuv->width / 2,decoder->pYuv->height / 2);

return 0;

}

int ToPcm(Decoder * decoder,AACFrame * frame){

if (!decoder->pFormatCtx || !decoder->pPcm) {

return -1;

}

// printf("sample_rate:%d,channels:%d,sample_fmt:%d,channel_layout:%llu,nb_samples:%d\n",pAudioCodecCtx->sample_rate,pAudioCodecCtx->channels,pAudioCodecCtx->sample_fmt,pAudioCodecCtx->channel_layout,pPcm->nb_samples);

//音訊重取樣

if (decoder->pSwrCtx == NULL) {

decoder->pSwrCtx = swr_alloc();

swr_alloc_set_opts(decoder->pSwrCtx,

AV_CH_LAYOUT_STEREO,//2聲道立體聲

AV_SAMPLE_FMT_S16, //取樣大小 16位

decoder->sampleRate,

decoder->pAudioCodecCtx->channel_layout,

decoder->pAudioCodecCtx->sample_fmt,// 樣本型別

decoder->pAudioCodecCtx->sample_rate,

0, 0);

int ret = swr_init(decoder->pSwrCtx);

char errorBuf[1024] = {0};

av_make_error_string(errorBuf,1024,ret);

FFLOGE("swr_init error:%s",errorBuf);

}

uint8_t * tempData[1];

tempData[0] = (uint8_t*)frame->dataBuffer;

int len = swr_convert(decoder->pSwrCtx, tempData, 10000, (const uint8_t**)decoder->pPcm->data,decoder->pPcm->nb_samples);

if (len < 0) {

char errbuf[1024] = {0};

FFLOGE("swr_convert error:%d",len);

return 0;

}

int outSize = av_samples_get_buffer_size(NULL,

CHANNEL,

len,

AV_SAMPLE_FMT_S16,0);

frame->length = (unsigned int)outSize;

FFLOGI("nb_smples:%d,des_smples:%d,outSize:%d",decoder->pPcm->nb_samples,len,outSize);

return 0;

}

void printError(const char * flag,int ret){

char errorbuf[1024] = {0};

av_make_error_string(errorbuf, 1024, ret);

FFLOGE("%s,ret:%d,%s", flag, ret, errorbuf);

}

double r2d(AVRational r){

return r.num == 0 || r.den == 0 ? 0.:(double)r.num/(double)r.den;

可以跟iOS版的對比一下,根本沒區別,都是一樣的,要不怎麼說跨平臺技術呢。程式碼說明可以去看ios版的有簡單說明。也可以下載原始碼debug進行了解。

說明一點,想要做優化的,就是我這裡執行緒鎖加的很粗糙,這樣會造成不同執行緒對資源的等待,會有點點不流暢,應該精細到每一句就好了,自己去調吧。

相關推薦

android ffmpeg+OpenGL播放yuv+openSL 快放 慢放 視訊播放器

這裡是完整的音視訊播放器,功能如下(這裡有iOS版的): 視訊是通過opengl 播放yuv資料,音訊是opensl播放。 app執行流程如下圖: 紅色虛線內的是一個執行緒的執行,總共涉及到四個執行緒。 java層幾乎沒有播放器的內容,ffmpe

android ffmpeg+OpenGL播放yuv+openSL 快放 慢放 視訊播放器

這裡是完整的音視訊播放器,功能如下(這裡有iOS版的): 視訊是通過opengl 播放yuv資料,音訊是opensl播放。 app執行流程如下圖: 紅色虛線內的是一個執行緒的執行,總共涉及到四個執行緒。 java層幾乎沒有播放器的內容,ffmpeg,opengl,opensl都

Android開發實戰使用(VR技術實現360°全景視訊播放功能)

一.在build.gradle中引入谷歌VR的SDK依賴 compile 'com.google.vr:sdk-videowidget:1.10.0' 二.注意支援的最小SDK minSdkVersion 19 targetSdkVersi

FFmpeg+OpenGL ES+OpenSL ES打造Android視訊播放器-楊萬里-專題視訊課程

FFmpeg+OpenGL ES+OpenSL ES打造Android視訊播放器—651人已學習 課程介紹 使用C++語言,用FFmpeg、OpenGL ES、OpenSL ES和MediaCodec打造Android視訊播放器。授課計劃 視訊錄播形式,講解課程

android ffmpeg+opensl 音訊解碼播放、暫停、進度seek、時間、上/下一首

類似文章太多,但是大多程式碼都有記憶體溢位的問題,而且都缺少c層呼叫java層的例子,實際上有了參考博文後,還是有很多坑需要自己填。不過,看了很多博主和帖子後還是能夠解決一些問題,但是有些問題,根本找不到,所以我把音訊解碼播放還有控制部分做了比較詳細的例子。

基於FFmpeg 和 OpenGL 的視訊播放 【C++】

環境: GLFW版本為 2.7.9 GLM版本為 0.9.4.6(需自己編譯生成 dll 和 lib) OpenGL 3.+ 以下程式碼僅僅通過ffmpeg解碼視訊(沒有處理音訊流),然後通過OpenGL進行顯示(或通過Shader對視訊幀進行處理)

基於NDK、C++、FFmpeg的android視訊播放器開發實戰-夏曹俊-專題視訊課程

基於NDK、C++、FFmpeg的android視訊播放器開發實戰—1796人已學習 課程介紹 課程包含了對流媒體(拉流)的播放,演示了播放rtmp的香港衛視,支援rtsp攝像頭和h

android平臺下基於ffmpeg和ANativeWindow實現簡單的視訊播放器

音視訊實踐學習 android全平臺編譯ffmpeg以及x264與fdk-aac實踐 ubuntu下使用nginx和nginx-rtmp-module配置直播推流伺服器 android全平臺編譯ffmpeg合併為單個庫實踐 android-studio使用c

Android FFmpeg系列——4 子執行緒播放音視訊

利用工作閒餘時間,終於實現在子執行緒播放音視訊! 上一接學習了在 C 使用多執行緒,接著就是利用 C 多執行緒同時播放音視訊(暫時還不同步)。 不多說,直接上碼。 程式碼 // C 層播放器結構體 typedef struct _Player { //

Android 實時錄音和回放,邊錄音邊播放 (KTV迴音效果)

// 錄音執行緒 class recordSound implements Runnable { @Override public void run() { Log.d(TAG, "

Android------視訊播放器(包含全屏播放,快退,快進,騰訊新聞的列表播放等)

前段時間做了一個新聞APP,涉及到了列表視訊播放,和騰訊新聞APP差不多,總結了一下程式碼,寫了一個Demo來分享給大家。用了 TabLayout+RecylerView+自定義視訊控制元件 完成的 列表中支援全屏播放來看看效果圖: 列表類程式碼:public clas

Android視訊播放框架——封裝FFMPEG的Vitamio

FFMPEG是開源免費的音視訊編解碼器,但由於是基於C++的,JAVA是無法操作的 提供了一個基於JAVA的開源是視訊的開源框架 Vitamio 特點: 封裝了FFMPEG的視訊播放框架對外提供的

FFmpeg總結(十二)用ffmpeg與nginx實現直播多路流並發播放

xxx 開源 conf ref itl rect arc med rtm 圖:撒哈拉沙漠 下載 nginx 和 nginx-rtmp源碼: http://nginx.org/download/nginx-1.5.10.tar.gz https://github.com/a

關於Unity中UGUI圖片Image實現仿視頻播放窗口的四角縮放功能

重置 assert clas () strong unity 操作 寬度 腳本 應用方法:將下面腳本掛載在需要實現四角縮放功能的UI圖片上即可. 自定義拖拽精度(與邊界距離多少內觸發)m_validityWidth. 1 /********************

android全平臺編譯ffmpeg視訊解碼器實踐

目錄 配置環境 新建decode工程 配置環境 作業系統: ubuntu 16.05 注意: ffmpeg庫的編譯使用的是android-ndk-r10e版本,使用高版本編譯會報錯 而android-studio工程中配合cmake使用的版本則是a

Android 仿抖音仿美拍視訊播放列表

首先實現方式是 1.RecyclerView 2.ViewPager 我這裡實現的方式是用的RecyclerView,歡迎大家共同探討

QtPlayer——基於FFmpeg的Qt音視訊播放器

QtPlayer——基於FFmpeg的Qt音視訊播放器 本文主要講解一個基於Qt GUI的,使用FFmpeg音視訊庫解碼的音視訊播放器,同時也是記錄一點學習心得,本人也是多媒體初學者,也歡迎大家交流,程式執行圖如下: QtPlayer基於FFmpeg的Q

android,Exoplayer實現視訊播放器

bundle配置: implementation 'com.google.android.exoplayer:exoplayer-core:2.8.1'implementation 'com.google.android.exoplayer:exoplayer-dash:2.8.1'implementati

android視訊播放框架Vitamio

分享一下我老師大神的人工智慧教程!零基礎,通俗易懂!http://blog.csdn.net/jiangjunshow 也歡迎大家轉載本篇文章。分享知識,造福人民,實現我們中華民族偉大復興!

Android ffmpeg編譯

首先,被這部分煩的不行的可以去github裡clone一些別人的成品輕鬆拿到適合Android的編譯結果 說下自己的環境 win10 x64 VMware® Workst