論文:Threat of Adversarial Attacks on Deep Learning in Computer Vision: A Survey翻譯工作

ACKNOWLEDGEMENTS: The authors thank Nicholas Carlini (UC Berkeley) and Dimitris Tsipras (MIT) for feedback to improve the survey quality. We also acknowledge X. Huang (Uni. Liverpool), K. R. Reddy (IISC), E. Valle (UNICAMP), Y. Yoo (CLAIR) and others for providing pointers to make the survey more comprehensive. This research was supported by ARC grant DP160101458.

摘要:深度學習時現在飛速發展的人工智慧的核心技術。在計算機視覺領域,它已成為從自動駕駛以及監控安防應用鄰域的主力軍。儘管神經網路已經被證明在解決複雜問題的領域(通常超越人類的能力範圍)取得了成功,但是最近的研究表明,神經網路很容易受到對輸入進行微小擾動的對抗性攻擊,導致模型預測出不正確的結果。以圖片為例,一個難以察覺到的微小擾動就足以欺騙深度學習模型,對抗性攻擊給深度學習成功投入到實際應用帶來了一系列的威脅。近來,這一事實也使得這一方向取得了大量的發展。本文首先對機器視覺鄰域的深度學習對抗性攻擊展開課整合性的調查。我們回顧設計對抗性攻擊的工作,分析此類攻擊的存在性並提出針對它們的防禦措施。為了強調對抗性攻擊可能出現在實際生活條件中,我們分別審查評估真實場景中對抗性攻擊的功效。最後,借鑑已審閱的論文,我們為這個方向上的研究提供了一個更加廣闊的視野。

索引條目:深度學習,對抗性擾動,黑盒攻擊,白盒攻擊,對抗性學習,擾動檢測。

1 簡介

深度學習技術為機器學習以及人工智慧社群的那些經歷了許多嘗試的難題帶來了突破性的進展。因此,它正在以前所未有的規模被用來解決艱難的科學問題,例如,大腦回路的重構;分析DNA的突變;研究潛在的藥物分子的構效以及分析粒子加速器的資料。深度學習已經變成了語音識別以及自然語言理解領域解決許多挑戰性任務的最佳選擇。

在計算機視覺領域,在Krizhevsky 等人於2012年公佈卷積神經網路(CNN)在一個大規模的富有挑戰性的資料集上表現出了極佳的效能之後,深度學習成為了關注的焦點。目前深度學習普及的一個重要功勞也可以歸功於這項開創性的工作。只從2012年以來計算機視覺社群已經為深度學習的做出了大量有價值的貢獻。這也使得了它為醫藥科學以及移動應用等領域遇到的問題提供瞭解決的 方案。最近人工智慧領域彙總基於零樣本學習的AlphaGo Zero取得了突破性的發展,這也要歸功於深度殘差網路(ResNet),其一開始是為圖片識別任務而提出的。

隨著深度神經網路模型的持續改善,高效的深度學習軟體庫的開發以及在硬體上訓練神經網路模型變得更加的容易,深度學習已經快速地投入到安防領域的應用當中。例如:自動駕駛、安防監控、惡意軟體檢測、無人機以及機器人,以及聲控識別技術。隨著真實世界中深度學習的發展,例如面部識別的ATM機,已經安全臉部識別的移動手機,都預示著深度學習所取得的革命性成果,特別是這些源自於機器視覺的問題在我們的日常生活中扮演了一個重要的角色。

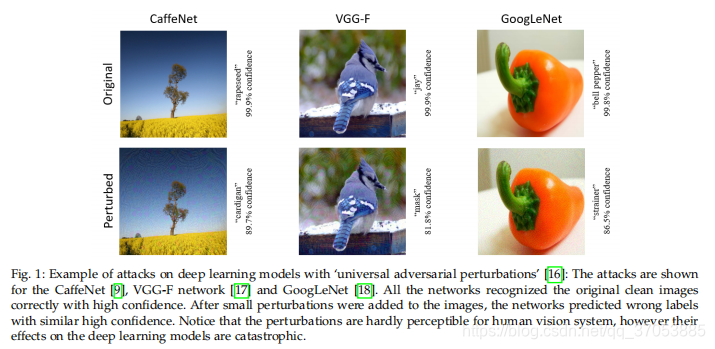

Szegedy等人認為,深度學習能夠以驚人的精度執行各種計算機視覺任務。他們在影象分類上發現了一個神經網路的有趣的弱點。他們表示儘管神經網路取得了很高的分類準確率,但他們很容易受到影象上微小的擾動(人類視覺系統很難察覺到)所帶來的對抗性攻擊。這樣的攻擊可以完全改變神經網路分類器在該圖片上的預測結果。更加糟糕的是,攻擊模型可以使得神經網路在錯誤的預測上報告出更高的置信度,而且相同的圖片擾動可以欺騙多網路分類器。這些研究發現的成果使得研究人員更加地關注深度學習的對抗性攻擊以及一般的深度學習防禦機制。

由於Szegedy等人的發現,關於計算機視覺中深度學習的對抗性攻擊的研究,已經得出了幾個有趣的結果。例如,除了圖片的對抗性擾動之外,Moosavi-Dezfooli等人表明,在任意一張圖片上都存在著廣泛的可以欺騙神經網路分類器的擾動。(如圖1所示).與此類似地, Athalye 等人表明3D打印出來的物體可以欺騙深度神經網路分類器(見圖4.3.)本文結合計算機視覺中深度學習研究的意義及其在現實生活中的潛在應用,與此同時,提出了第一個關於計算機視覺中深度學習的對抗性攻擊的綜合性調查。本文旨在為除了計算機視覺社群之外提供更廣泛的讀者群,因此它只涉及到深度學習和影象處理的基本知識。 但它也為感興趣的讀者提供了重要貢獻的技術細節的相關討論。

在第二部分中我們主要描述了機器視覺的中涉及到的對抗性攻擊的相關術語。在第三部分中,我們回顧了影象分類任務中的對抗性攻擊以及除此之外的一些內容。然後用一個單獨的部分專門介紹處理現實世界中對抗性攻擊的方法,這些方法將會在第四部分中重點介紹。在第五部分中我們也會重點分析現實中存在的對抗性攻擊。而在第六部分中我們將會介紹針對對抗性攻擊所採取的防禦措施。在第7部分中,我們基於所評論的文獻提供了更廣泛的研究方向。 最後在第八部分中我們將得出結論。

2、定義相關術語

·在這一部分中,我們將會闡述一些在機器視覺學術界常用的一些術語。以下的文章中也有對於相關術語的相同定義。

·對抗性示例/影象是有意擾亂的乾淨影象的修改版本,它通過向圖片中加入噪聲來欺騙深度學習技術,尤其是深度神經網路。

·對抗性擾動指的是將噪聲新增到清晰的圖片當中以生成對抗性樣例

· 對抗性學習指的是利用對抗性圖片包括清晰的原圖來訓練機器學習模型

· 對手更常見的是指建立對抗性示例的人。 但是,在某些情況下,示例本身也稱為對手

·黑盒攻擊指的是在測試期間向目標模型喂入不利用任何模型的先驗知識所生成的對抗性示例。在一些例子中,人們也假定對手具有有限的模型相關知識(比如模型的訓練過程以及結構)。但需要明確的是,模型中的引數是未知的。在另外的一些例項中,使用目標模型的相關先驗資訊則被稱為半黑盒攻擊。在本文中我們使用前一種約定方式。

·檢測器是一種用於檢測影象是否是一個對抗性的機制。

·欺騙率指的是圖片擾動對模型正確預測的結果所帶來的改變的比率。

· one-shot/one-step的方法指的是通過一步的計算來生成對抗性的擾動。例如與只計算模型損失梯度一次相反的是利用迭代的方法多次執行相同的計算以獲得單個擾動。但最後的計算開銷通常比較大。

·對於人類感知,準不可察覺的擾動會非常輕微地損害影象,這對於人眼很難辨別出來

· 整流器用於修改對抗性示例以將目標模型的預測結果恢復為對原先的未經擾動的示例的預測。

·目標攻擊用於欺騙一個模型,使其錯誤地預測攻擊性圖片的標籤,