三張簡圖搞懂GBDT

首先假設你有初步的瞭解什麼是決策樹,CART樹,整合,Adaboost, boosting的一些概念。

下面我們先了解什麼是提升樹

都知道,在每個基分類器(CART樹)生成的過程,有一個最小化損失函式的步驟,那麼對於迴歸樹來說,當我們使用的損失函式是平方損失誤差的話,來看看是什麼情況:

(注意圖片上的標註紅字)

看了紅字,我覺得大家應該能理解有些書上說的殘差,擬合什麼的了。

搞懂了提升樹,那麼來看看什麼是GBDT,它也是提升樹,只不過是用梯度求解的方法,那麼當採用平方損失作為損失函式時,你可以先計算一下此時損失函式的梯度值是什麼,你會恍然大悟。

我們來看看下面的圖片,平方損失的負梯度

總的來說,當我們用梯度去代替或近似殘差,結合所以樣本的特徵向量,也就是用(X,r殘差)去生成迴歸樹,再生成提升樹的過程,其實就是GBDT的過程。

最後看一下提升樹的演算法流程:

希望大家能夠看懂!!!!

相關推薦

三張簡圖搞懂GBDT

首先假設你有初步的瞭解什麼是決策樹,CART樹,整合,Adaboost, boosting的一些概念。 下面我們先了解什麼是提升樹 都知道,在每個基分類器(CART樹)生成的過程,有一個最小化損失函式的步驟,那麼對於迴歸樹來說,當我們使用的損失函式是平方損失誤差的

一張圖搞懂android事件分發機制

事件分發機制在安卓中非常重要,這個事情如果搞不懂,會困擾你很多事情。比如說,應用了github上的某個大神的庫,如果發現這個庫實現了你需求的80%,還有那麼20%需要你結合實際需求來實現

一張圖搞懂Spring bean的完整生命週期

一張圖搞懂Spring bean的生命週期,從Spring容器啟動到容器銷燬bean的全過程,包括下面一系列的流程,瞭解這些流程對我們想在其中任何一個環節怎麼操作bean的生成及修飾是非常有幫助的。 Bean的完整生命

4張圖搞懂floorMod

https .com ado tex jpg 文檔 process 分享 51cto 在java中floorMod很多人看了官方說明文檔仍然不懂,以下用四張圖來說明,希望大家能豁然開朗。4張圖搞懂floorMod

一張圖搞懂Ajax原理

監聽 javascrip 理解 state 進度 調用 end 最好的 let 本文整理在,我的github上。歡迎Star。 原理 說起ajax,就不得不說他背後的核心對象XMLHttpRequest,而說到XMLHttpRequest我覺得,從它的readyStat

八大排序演算法—16張圖搞懂基數排序

>原創公眾號:bigsai 轉載需聯絡筆者 ## 前言 在排序演算法中,大家可能對桶排序、計數排序、基數排序不太瞭解,不太清楚其演算法的思想和流程,也可能看過會過但是很快就忘記了,但是不要緊,幸運的是你看到了本篇文章。本文將通俗易懂的給你講解基數排序。 基數排序,是一種原理簡單,但實現複雜的排序。

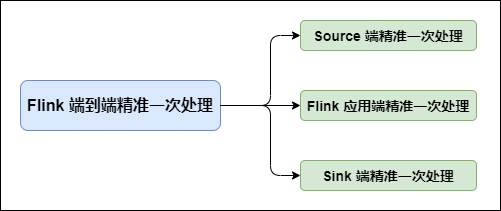

硬核!八張圖搞懂 Flink 端到端精準一次處理語義 Exactly-once(深入原理,建議收藏)

### Flink 在 Flink 中需要端到端精準一次處理的位置有三個:  - **Source 端**:資料從上一階段進入到 Flink 時,

[乾貨]一張地鐵圖看懂人工智慧演算法發展(含程式碼)---轉自AlphaTree

“ 或許你曾經困擾過:明明自家產品有自己的資料,明明演算法模型很多開源,可為什麼開發起來卻問題多多? 要麼拿到問題無從下手?”每一個大廚,心中都有自己的菜譜。要烹製一桌山珍海味,美味佳餚,自然要熟知三件事,原料(模型),調料(優化演算法)和祕籍菜譜(這裡常常只paper:pa

成為一枚優秀的創業者,必須學會畫的三張腦圖

創業是創業者對自己擁有的資源或通過努力能夠擁有的資源進行優化整合,從而創造出更大經濟或社會價值的過程。 我們知道創業開始會遇到很多困難,很多難點,但是隻要留心不忽略每個細節然後整理出來總有云開見天日。 所以,想要做一枚優秀的創業者,應該懂得如何將創業構思一步步執行,這

一套圖 搞懂“時間複雜度”

寫在前面: 這篇文章是在公眾號: 程式設計師小灰 中釋出的。是我到目前為止所看到的關於時間複雜度介紹的最好的文

資料結構與演算法—一文多圖搞懂雙鏈表

前言 前面講過線性表中順序表和連結串列的實現和性質。但是在資料結構與演算法中,雙向連結串列無論在考察還是運用中都佔有很大的比例,筆者旨在通過本文與讀者一起學習分享雙鏈表相關知識。 雙鏈表介紹 與單鏈表區別 邏輯上沒有區別。他們均是完成線性表的內容。主要的區別是結構上的構造有所區別。

三分鐘帶您搞懂代理模式

全文共1439字,預計閱讀時間:10分鐘 定義: 代理模式(Proxy),為其他物件提供一種代理以控制對這個物件的訪問。 代理模式是一種比較貼近於生活的設計模式,現實生活中也有很多代理模式的例子: 住酒店不一定需要親自到酒店去,還可以通過微信支付下的同程藝龍來訂酒店。 我們可以通過中介去找房子

40 張圖帶你搞懂 TCP 和 UDP

## 前言 歡迎閱讀「程式設計師cxuan」 的文章,從今往後,你就是我的讀者了。 我的 github bestJavaer 已經收錄此文章,目錄在 https://github.com/crisxuan/bestJavaer 希望你可以給我一個 star 哦! 這一篇文章是計算機網路連載文章的第四

一張圖輕松搞懂javascript event對象的clientX,offsetX,screenX,pageX區別

png javascrip 區域 文檔 .cn 標準屬性 分享 clas src 先總結下區別: event.clientX、event.clientY 鼠標相對於瀏覽器窗口可視區域的X,Y坐標(窗口坐標),可視區域不包括工具欄和滾動條。IE事件和標準事件都定義了這2

三張圖秒懂Redis叢集設計原理

edis叢集設計包括2部分:雜湊Slot和節點主從,本篇博文通過3張圖來搞明白Redis的叢集設計。 節點主從: 主從設計不算什麼新鮮玩意,在資料庫中我們也經常用主從來做讀寫分離,直接上圖: 圖上能看得到的資訊: 1, 只有1個Master,可以有N個sla

三張圖弄懂如何在READMD.md使用基本的markdown語法

最近看到被人GitHub專案上的READMD排版得很漂亮,就去了解了一下,原來背後是用markdown語法編寫的,md即markdown的縮寫,READMD也是支援markdown語法的,同時大部分部落格的視覺化編寫也有一定的markdown基礎,所以掌握markdown基本

Android-三張圖搞定Touch事件傳遞機制

上圖之前先講下Android事件的基礎知識: 1.所有的Touch事件都封裝到MotionEvent裡面 2.事件處理包括三種情況,分別為:傳遞—-dispatchTouchEvent()函式、攔截——onInterceptTouchEvent()函式、消費

玩轉Web之servlet(三)---一張圖看懂B/S架構

學WEB, 首先 要明白B/S架構,本文將簡單說一下小編的愚見,若有不當,歡迎大家指正。 首先,什麼是B/S架構?B/S是Broweser/Server的縮寫,即瀏覽器/伺服器模式,簡單說就是客戶端使用瀏覽器,服務端使用Web伺服器,客戶端與服務端之間使用http協議進行通

【智慧製造】三張圖讀懂人工智慧在工廠如何具體應用

西門子智慧製造解決方案 西門子提出的數字雙胞胎方案,就是通過軟體把工廠數字化模擬一遍,通過資料進行生產、經驗管理的分析 與決策。咋一看挺完美,從底層的裝置到資料採集、裝置控制,再到製造執行系統mes、倉儲、資產物流,再到ERP和供應鏈管理,好像企業的生產管理流程都涉及了。但是企業的經營、客戶智慧化問題一直

一張圖讓你搞懂JavaScript的繼承與原型鏈

前面的話 javascript裡的關係又多又亂。作用域鏈是一種單向的鏈式關係,還算簡單清晰;this機制的呼叫關係,稍微有些複雜;而關於原型,則是prototype、proto和constructor的三角關係。本文先用一張圖開宗明義,然後詳細解釋原型的三