SVM中的訓練演算法:序列最小最優化演算法SMO的讀書筆記

阿新 • • 發佈:2019-02-06

最近重看李航的統計學習方法,看SVM這章,細細的對了一下其中將SMO的這一張,記得去年這會兒看這本書的SMO這章還有點懵懵懂懂,並在書上寫了自己一些疑問的筆記,今年重新看發現之前的疑問不再是疑問了,於是做個筆記總結一下,總結一下。

首先線性可分支援向量機的構建條件是需要線性可分的。與感知機不同的是,SVM還加了一個約束:最大間隔。因此與感知機只考慮誤分類點的損失函式不同,SVM是唯一存在的。而感知機是有多個解的。(下圖為感知機的形式)

線性SVM的原始問題描述如下:

該問題的對偶問題描述如下:

其中的alpha為對應樣本點的拉格朗日系數。 因為這裡我們關注的是SMO演算法的推導過程,因此對偶問題的描述的具體推導過程,可參考李航的《統計學習方法》。在此不展開細講。 看到這裡不知你是否跟我當初看書的時候有同樣的疑問,那就是上面這個描述中只有alpha,難道不能用再用一次拉格朗日方程,然後對alpha求導,這樣不是就可以直接用梯度下降法了嗎? 答案是不行的:因為上面的問題描述不符合拉格朗日對偶性中構建拉格朗日方程的條件,條件3是有上下限的(下圖為拉格朗日對偶性的原始問題)

那麼SVM本身能不能夠利用梯度下降法來求解呢? 答案是:可以的。 因為線性SVM本身是等價於合頁損失函式+最小化的二階範數的(如下圖)

式子中的+表示的是

順便說一下,上面損失函式的第一項意味著,當SVM的函式間隔>1 的時候,損失才為0,否則損失為 1-y(w*x+b),這意味著SVM對於正確劃分的要求更加高。 這裡再貼一下書中關於感知機,SVM和0-1損失的比較,來說明上面的SVM對於正確劃分的要求更加高這個問題。

再說回SVM是否可以用梯度下降法來求解呢?看之前的損失函式形式(下圖)

這裡面只有w,沒有約束,然後求解的是使該式子最小的w,那麼當然可以用梯度下降法了。 具體的求解方法,不在這裡詳細敘述有興趣的童鞋可以看一下,下面這篇blog,連線如下: 再回到正題SMO,在正式講解SMO之前,我覺得還需要介紹一下其他的關於SVM的求解優化演算法,這樣有助於理解SMO是怎樣來的,增加理解SMO這個演算法。 我這裡貼一段看的一篇關於SVM的論文綜述的一部分。(論文:支援向量機理論與演算法研究綜述,丁世飛,齊丙娟,譚紅豔) SVM訓練演算法有三大類:塊演算法(chunking algorithm);分解演算法(decomposition algorithm);增量演算法(incremental algorithm) 1.塊演算法: Chunking演算法[10]

這裡需要需要注意的是:

具體來說:

基本就是上面式子的展開,沒什麼東西,注意這裡Kij = k(xi,xj)是核函式,因此kij =kji,這是核函式的定義來的。

看到這裡不知道大家是不是跟我當初第一次看一樣,有點懵為什麼y1!=y2 => alpha1-alpha2=k;y1=y2 => alpha1 + alpha2 = k; 因為對於二分類問題來說(y 為 +1, -1),y1 != y2 那麼就是 y1/y2 = -1 ,當y1 = y2 那麼 y1/y2 = 1。所以才有了上面的圖中的式子。

對於這裡的L,H 的確定,不知大家有沒有想清楚,首先L,H是alpha2的上下界,因此如下圖所示。

那麼對於y1 != y2 則 alpha2 = alpha1 - k; k = alpha1 - alpha2 y1 = y2 則 alpha 2 = k - alpha1; k = alpha1 + alpha2 帶入對應的極值點 alpha1 = 0 或C的時候,就得到了,上面的L,H 上下界的關係了。

這個定理李航書上幾乎手把手的教你證明了,感覺大家可以跟著書上推一遍,應該就比較能理解整個過程了。這裡就不貼上過來,因為書確實將的比較細緻了。

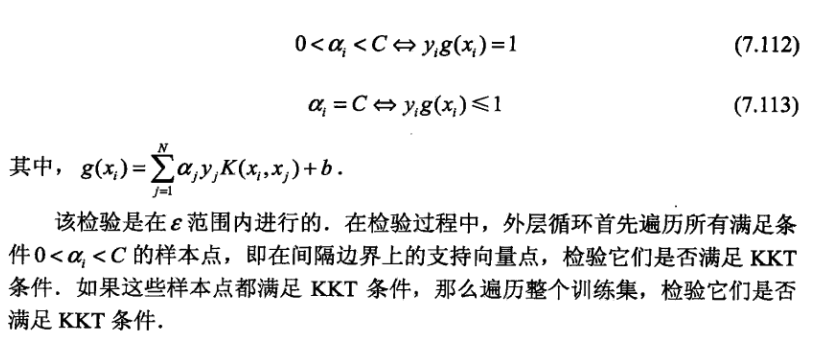

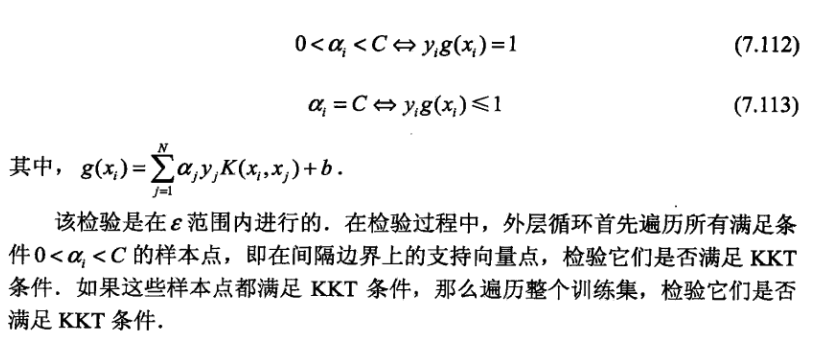

不知道你是不是跟我一樣比較疑惑,什麼叫KKT違反最嚴重的點?我想應該是該樣本點帶入yi*g(xi)後與1的差最大的點吧。

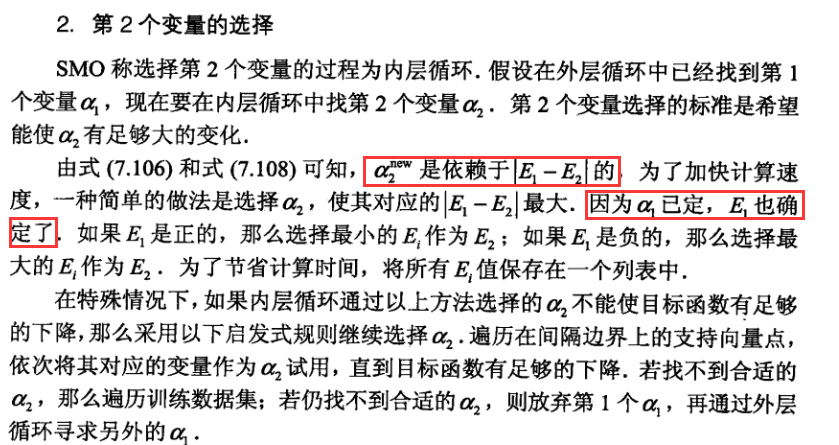

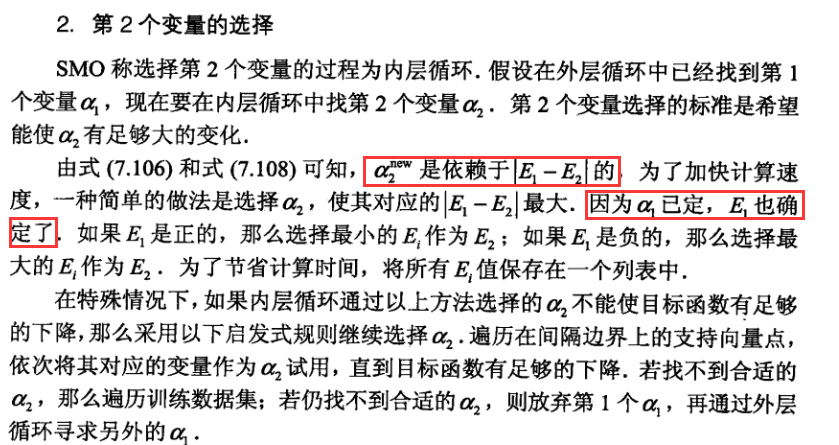

這裡其實就是外層alpha1定了,那麼內層alpha2應該也就定了的意思。只是有些特殊情況下目標函式不能產生足夠的下降,所以才會啟發式的選擇alpha2,直到擁有足夠的下降。如果一直找不到就更換外層迴圈的alpha1,這也是為什麼這個方法稱之為啟發式的演算法的原因:有規則,但也不完全遵從規則。

我們可以看到,在更細Ei 的時候,我們只需要更行對應的支援向量即可。 最後:

參考文獻: 《統計學習方法》李航 [10] BOSER B E, GUYON I M, VAPNIK V N. A training algorithm for optimal margin classifiers[C]//Proceedings of The Fifth Annual Workshop on Computational Learning Theory. New York: ACM Press, 1992: 144-152. [11] OSUNA E, FRENUD R, GIROSI F. An improved training algorithm for support vector machines[C] Proceedings of IEEE Workshop on Neural Networks for Signal Processing.New York, USA: [s.n.], 1997: 276-285. [12] JOACHIMS T. Making large-scale support vector machine learning practical[C]//Advances in Kernel Methods:Support Vector Learning. Cambridge, MA: The MIT Press,1998. [13] PLATT J. Fast training of support vector machines using sequential minimal optimization[C] dvances in Kernel Methods: Support Vector Learning. Cambridge, MA: The MIT Press, 1998. [14] DAI Liu-ling, HUANG He-yan, CHEN Zhao-xiong.Ternary sequential analytic optimization algorithm for SVM classifier design[J]. Asian Journal of Information Technology, 2005, 4(3): 2-8. [15] KEERTHI S S, SHEVADE S K, BHATTAEHARYYA C. Improvements to platt's SMO algorithm for SVM classifier design[J]. Neural Computation, 2001, 13(3): 637- 649. [16] PLATT J. Using analytic QP and sparseness to speed training support vector machines[C] Advances in Neural Information Processing Systems. [S.l]: MIT Press, 1999,557-563. [17] SYED N, LIU H, SUNG K. Incremental learning with support vector machines[C] International Joint Conference on Artificial Intelligence. Sweden: Morgan kaufmann publishers, 1999: 352-356. [18] GAUWENBERGHS G, POGGIO T. Incremental and decremental support vector machine[J]. Machine Learning.2001, 44 (13): 409- 415. [19] RALAIVOLA L, FLORENCE D’ALCHÉ-BUC.Incremental support vector machine learning: a local approach[C] Proceedings of International Conference on Neural Networks. Vienna, Austria: [s.n.], 2001: 322-330. [20] 孔銳, 張冰. 一種快速支援向量機增量學習演算法[J]. 控制與決策, 2005, 20(1): 1129- 1132. KONG Rui, ZHANG Bing. A fast incremental learning algorithm for support vector machine[J]. Control And Decision, 2005, 20(1): 1129- 1132. [21] 孔波, 劉小茂, 張鈞. 基於中心距離比值的增量支援向量機[J]. 計算機應用, 2006, 26(6): 1434-1436.KONG Bo, LIU Xiao-mao, ZHANG Jun. Incremental support vector machine based on center distance ratio[J].Journal of Computer Applications, 2006, 26(6): 1434-1436. [22] 李東暉, 杜樹新, 吳鐵軍. 基於殼向量的線性支援向量機快速增量學習演算法[J]. 浙江大學學報, 2006, 40(2):202- 215.

線性SVM的原始問題描述如下:

該問題的對偶問題描述如下:

其中的alpha為對應樣本點的拉格朗日系數。 因為這裡我們關注的是SMO演算法的推導過程,因此對偶問題的描述的具體推導過程,可參考李航的《統計學習方法》。在此不展開細講。 看到這裡不知你是否跟我當初看書的時候有同樣的疑問,那就是上面這個描述中只有alpha,難道不能用再用一次拉格朗日方程,然後對alpha求導,這樣不是就可以直接用梯度下降法了嗎? 答案是不行的:因為上面的問題描述不符合拉格朗日對偶性中構建拉格朗日方程的條件,條件3是有上下限的(下圖為拉格朗日對偶性的原始問題)

那麼SVM本身能不能夠利用梯度下降法來求解呢? 答案是:可以的。 因為線性SVM本身是等價於合頁損失函式+最小化的二階範數的(如下圖)

式子中的+表示的是

順便說一下,上面損失函式的第一項意味著,當SVM的函式間隔>1 的時候,損失才為0,否則損失為 1-y(w*x+b),這意味著SVM對於正確劃分的要求更加高。 這裡再貼一下書中關於感知機,SVM和0-1損失的比較,來說明上面的SVM對於正確劃分的要求更加高這個問題。

再說回SVM是否可以用梯度下降法來求解呢?看之前的損失函式形式(下圖)

這裡面只有w,沒有約束,然後求解的是使該式子最小的w,那麼當然可以用梯度下降法了。 具體的求解方法,不在這裡詳細敘述有興趣的童鞋可以看一下,下面這篇blog,連線如下: 再回到正題SMO,在正式講解SMO之前,我覺得還需要介紹一下其他的關於SVM的求解優化演算法,這樣有助於理解SMO是怎樣來的,增加理解SMO這個演算法。 我這裡貼一段看的一篇關於SVM的論文綜述的一部分。(論文:支援向量機理論與演算法研究綜述,丁世飛,齊丙娟,譚紅豔) SVM訓練演算法有三大類:塊演算法(chunking algorithm);分解演算法(decomposition algorithm);增量演算法(incremental algorithm) 1.塊演算法: Chunking演算法[10]

這裡需要需要注意的是:

具體來說:

基本就是上面式子的展開,沒什麼東西,注意這裡Kij = k(xi,xj)是核函式,因此kij =kji,這是核函式的定義來的。

看到這裡不知道大家是不是跟我當初第一次看一樣,有點懵為什麼y1!=y2 => alpha1-alpha2=k;y1=y2 => alpha1 + alpha2 = k; 因為對於二分類問題來說(y 為 +1, -1),y1 != y2 那麼就是 y1/y2 = -1 ,當y1 = y2 那麼 y1/y2 = 1。所以才有了上面的圖中的式子。

對於這裡的L,H 的確定,不知大家有沒有想清楚,首先L,H是alpha2的上下界,因此如下圖所示。

那麼對於y1 != y2 則 alpha2 = alpha1 - k; k = alpha1 - alpha2 y1 = y2 則 alpha 2 = k - alpha1; k = alpha1 + alpha2 帶入對應的極值點 alpha1 = 0 或C的時候,就得到了,上面的L,H 上下界的關係了。

這個定理李航書上幾乎手把手的教你證明了,感覺大家可以跟著書上推一遍,應該就比較能理解整個過程了。這裡就不貼上過來,因為書確實將的比較細緻了。

不知道你是不是跟我一樣比較疑惑,什麼叫KKT違反最嚴重的點?我想應該是該樣本點帶入yi*g(xi)後與1的差最大的點吧。

這裡其實就是外層alpha1定了,那麼內層alpha2應該也就定了的意思。只是有些特殊情況下目標函式不能產生足夠的下降,所以才會啟發式的選擇alpha2,直到擁有足夠的下降。如果一直找不到就更換外層迴圈的alpha1,這也是為什麼這個方法稱之為啟發式的演算法的原因:有規則,但也不完全遵從規則。

我們可以看到,在更細Ei 的時候,我們只需要更行對應的支援向量即可。 最後:

參考文獻: 《統計學習方法》李航 [10] BOSER B E, GUYON I M, VAPNIK V N. A training algorithm for optimal margin classifiers[C]//Proceedings of The Fifth Annual Workshop on Computational Learning Theory. New York: ACM Press, 1992: 144-152. [11] OSUNA E, FRENUD R, GIROSI F. An improved training algorithm for support vector machines[C] Proceedings of IEEE Workshop on Neural Networks for Signal Processing.New York, USA: [s.n.], 1997: 276-285. [12] JOACHIMS T. Making large-scale support vector machine learning practical[C]//Advances in Kernel Methods:Support Vector Learning. Cambridge, MA: The MIT Press,1998. [13] PLATT J. Fast training of support vector machines using sequential minimal optimization[C] dvances in Kernel Methods: Support Vector Learning. Cambridge, MA: The MIT Press, 1998. [14] DAI Liu-ling, HUANG He-yan, CHEN Zhao-xiong.Ternary sequential analytic optimization algorithm for SVM classifier design[J]. Asian Journal of Information Technology, 2005, 4(3): 2-8. [15] KEERTHI S S, SHEVADE S K, BHATTAEHARYYA C. Improvements to platt's SMO algorithm for SVM classifier design[J]. Neural Computation, 2001, 13(3): 637- 649. [16] PLATT J. Using analytic QP and sparseness to speed training support vector machines[C] Advances in Neural Information Processing Systems. [S.l]: MIT Press, 1999,557-563. [17] SYED N, LIU H, SUNG K. Incremental learning with support vector machines[C] International Joint Conference on Artificial Intelligence. Sweden: Morgan kaufmann publishers, 1999: 352-356. [18] GAUWENBERGHS G, POGGIO T. Incremental and decremental support vector machine[J]. Machine Learning.2001, 44 (13): 409- 415. [19] RALAIVOLA L, FLORENCE D’ALCHÉ-BUC.Incremental support vector machine learning: a local approach[C] Proceedings of International Conference on Neural Networks. Vienna, Austria: [s.n.], 2001: 322-330. [20] 孔銳, 張冰. 一種快速支援向量機增量學習演算法[J]. 控制與決策, 2005, 20(1): 1129- 1132. KONG Rui, ZHANG Bing. A fast incremental learning algorithm for support vector machine[J]. Control And Decision, 2005, 20(1): 1129- 1132. [21] 孔波, 劉小茂, 張鈞. 基於中心距離比值的增量支援向量機[J]. 計算機應用, 2006, 26(6): 1434-1436.KONG Bo, LIU Xiao-mao, ZHANG Jun. Incremental support vector machine based on center distance ratio[J].Journal of Computer Applications, 2006, 26(6): 1434-1436. [22] 李東暉, 杜樹新, 吳鐵軍. 基於殼向量的線性支援向量機快速增量學習演算法[J]. 浙江大學學報, 2006, 40(2):202- 215.