深度學習影象處理(分類or檢測)中結果的評價方法-mAP簡介

阿新 • • 發佈:2019-02-09

多標籤影象分類(Multi-label Image Classification)任務中圖片的標籤不止一個,因此評價不能用普通單標籤影象分類的標準,即mean accuracy,該任務採用的是和資訊檢索中類似的方法—mAP(mean Average Precision)。mAP雖然字面意思和mean accuracy看起來差不多,但是計算方法要繁瑣得多。

P-R曲線的繪製

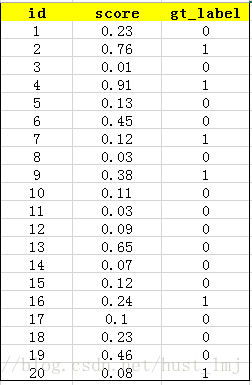

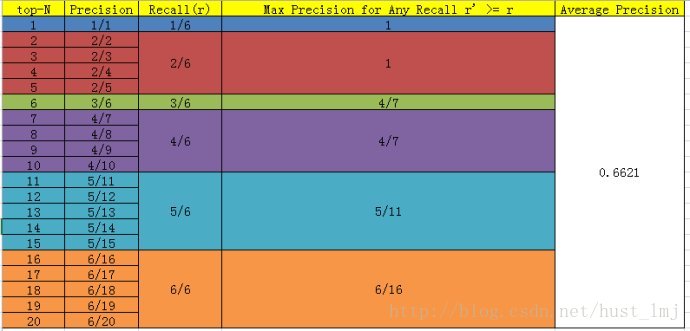

- 用訓練好的模型得到所有測試樣本的confidence score,本例中某一類有20個測試樣本。(每一類的P-R曲線、AP均單獨計算)

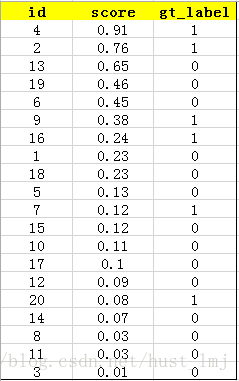

- 對該類的confidence score排序,得到:

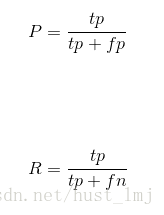

- 計算top-1到top-N(N是所有測試樣本個數,本文中為20)對應的precision和recall,這兩個標準的定義如下:

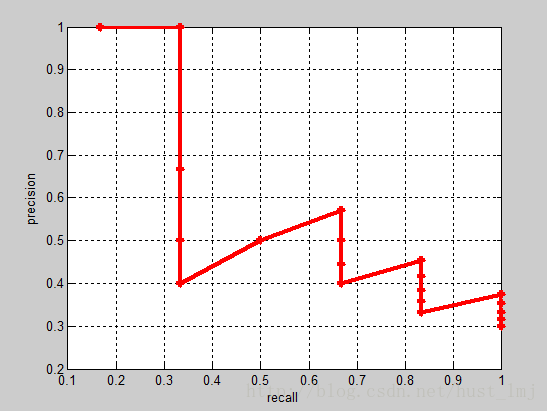

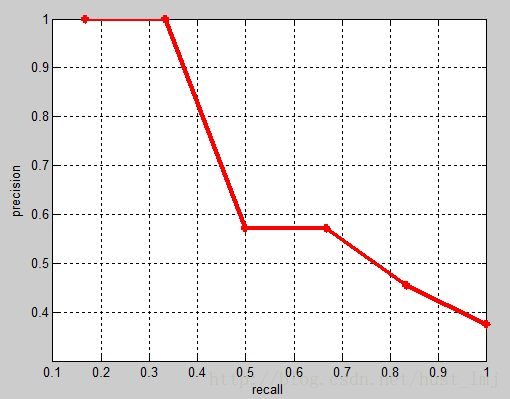

直觀的理解就是,第一次我們排序後第一個樣本的confidence作為劃分正負樣本的閾值,此時,只有第一個判斷為正,其他均為負樣本(因為其他樣本的confidence均小於第一個樣本的confidence),計算該閾值情況下的recall(1/1=1)和precision(1/1=1);然後第二次將排序後第二個樣本的confidence作為劃分正負樣本的閾值,依次類推到最後一個。顯然隨著閾值的降低,我們選定的樣本越來也多,recall一定會越來越高,而precision整體上會呈下降趨勢。把recall當成橫座標,precision當成縱座標,即可得到常用的precision-recall曲線。這個例子的P-R曲線如下:

AP的計算

PASCAL VOC CHALLENGE自2010年後就換了新計算方法。新的計算方法假設這N個樣本中有M個正例,那麼我們會得到M個recall值(1/M, 2/M, …, M/M),對於每個recall值r,我們可以計算出對應(r’ > r)的最大precision,然後對這M個precision值取平均即得到最後的AP值。計算方法如下:

相應的Precision-Recall曲線中被用於計算AP的部分如下(每一個recall的節點都取precision的最大值連線起來):

mAP的計算

AP衡量的是學出來的模型在每個類別上的好壞,mAP衡量的是學出的模型在所有類別上的好壞,得到AP後mAP的計算就變得很簡單了,就是取所有AP的平均值。

注:本文修改自原文,有增刪。