(翻譯)Sequence to Sequence Learning with Neural Networks

2 模型

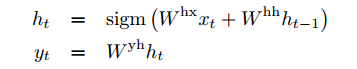

RNN,給定一個輸入序列(x1,x2,…,xT),RNN通過迴圈計算下面的式子得到一個輸出序列(y1,y2,…,yT)

如何一個input和output是對應的,比如輸入單詞,輸出是詞性,就可以用RNN對映,

本文是解決輸入輸出之間沒有對應關係的時候的問題,比如聊天,輸入是5個詞,輸出是10個詞,

相關推薦

(翻譯)Sequence to Sequence Learning with Neural Networks

2 模型 RNN,給定一個輸入序列(x1,x2,…,xT),RNN通過迴圈計算下面的式子得到一個輸出序列(y1,y2,…,yT) 如何一個input和output是對應的,比如輸入單詞,輸出是詞性,就可以用RNN對映, 本文是解決輸入輸出之間沒有對應關

論文筆記-Sequence to Sequence Learning with Neural Networks

map tran between work down all 9.png ever onf 大體思想和RNN encoder-decoder是一樣的,只是用來LSTM來實現。 paper提到三個important point: 1)encoder和decoder的LSTM

Sutskever2014_Sequence to Sequence Learning with Neural Networks

INFO: Sutskever2014_Sequence to Sequence Learning with Neural Networks ABSTRACT Use one LSTM to read the input sequence, one timestep at a

【論文閱讀】Sequence to Sequence Learning with Neural Networks

看論文時查的知識點 前饋神經網路就是一層的節點只有前面一層作為輸入,並輸出到後面一層,自身之間、與其它層之間都沒有聯絡,由於資料是一層層向前傳播的,因此稱為前饋網路。 BP網路是最常見的一種前饋網路,BP體現在運作機制上,資料輸入後,一層層向前傳播,然後計算損失函式,得到損失函式的殘差

Sequence to Sequence Learning with Neural Networks

用神經網路進行序列到序列的學習 摘要 1.介紹 2.模型 3.實驗 3.1 Dataset details 3.2 Decoding and Rescoring 3.3 Reversing the Source Sent

論文復現Sequence to sequence learning with neural networks

Sequence to sequence learning with neural networks <模型彙總-7>基於CNN的Seq2Seq模型-Convolutional Sequence to Sequence Learning Sequence

Sequence to Sequence Learning with Neural Networks論文閱讀

[論文下載](https://papers.nips.cc/paper/5346-sequence-to-sequence-learning-with-neural-networks.pdf)  作者

深度學習論文翻譯解析(六):MobileNets:Efficient Convolutional Neural Networks for Mobile Vision Appliications

論文標題:MobileNets:Efficient Convolutional Neural Networks for Mobile Vision Appliications 論文作者:Andrew G.Howard Menglong Zhu Bo Chen ..... 論文地址:ht

An Introduction to Deep Learning and Neural Networks

aitopics.org uses cookies to deliver the best possible experience. By continuing to use this site, you consent to the use of cookies. Learn more » I und

Deep learning with Theano 官方中文教程(翻譯)(四)—— 卷積神經網路(CNN)

供大家相互交流和學習,本人水平有限,若有各種大小錯誤,還請巨牛大牛小牛微牛們立馬拍磚,這樣才能共同進步!若引用譯文請註明出處http://www.cnblogs.com/charleshuang/。 文章中的程式碼截圖不是很清晰,可以去上面的原文網址去檢視。 1、動機 卷積神經網路(CNN

Deep learning with Theano 官方中文教程(翻譯)(三)——多層感知機(MLP)

供大家相互交流和學習,本人水平有限,若有各種大小錯誤,還請巨牛大牛小牛微牛們立馬拍磚,這樣才能共同進步!若引用譯文請註明出處http://www.cnblogs.com/charleshuang/。 下面。http://deeplearning.net/tutorial/mlp.html#mlp 的中

Sequence to Sequence 實現機器翻譯(keras demo)

最近在研究對話機器人,剛好看了幾篇論文,參考keras demo理解。 原理請參考: - Sequence to Sequence Learning with Neural Networks https://arxiv.org/abs/1409.32

深度學習方法(八):自然語言處理中的Encoder-Decoder模型,基本Sequence to Sequence模型

歡迎轉載,轉載請註明:本文出自Bin的專欄blog.csdn.net/xbinworld。技術交流QQ群:433250724,歡迎對演算法、技術感興趣的同學加入。 Encoder-Decoder(編碼-解碼)是深度學習中非常常見的一個模型框架,比如無監督演

翻譯(三)Stairway to T-SQL: Beyond The Basics Level 9: Dynamic T-SQL Code

數據庫表 studio 應用程序 cmd char 結束 管理 分代 應對 Stairway to T-SQL: Beyond The Basics Level 9: Dynamic T-SQL Code By Gregory Larsen, 2016/07/

論文閱讀筆記(一)LeNet--Gradient-Based Learning Applied to Document Recognition

輸入 共享 rbf map 內部 field dex title 手動 作者:Yann LeCun,Leon Botton, Yoshua Bengio,and Patrick Haffner這篇論文內容較多,這裏只對部分內容進行記錄:以下是對論文原文的翻譯:在傳統的模式識

機器翻譯模型之Fairseq:《Convolutional Sequence to Sequence Learning》

近年來,NLP領域發展迅速,而機器翻譯是其中比較成功的一個應用,自從2016年穀歌宣佈新一代谷歌翻譯系統上線,神經機器翻譯(NMT,neural machine translation)就取代了統計機器翻譯(SMT,statistical machine translation),在翻譯

【leetcode】128.(Hard)Longest Consecutive Sequence

解題思路: 我的想法是:排序—剔重—找最大連續數 這個做法其實時間複雜度沒到O(n)但是也通過了 提交程式碼: class Solution { public int longestConsecutive(int[] nums) { if(nums.length=

Facebook的Fairseq模型詳解(Convolutional Sequence to Sequence Learning)

1. 前言 近年來,NLP領域發展迅速,而機器翻譯是其中比較成功的一個應用,自從2016年穀歌宣佈新一代谷歌翻譯系統上線,神經機器翻譯(NMT,neural machine translation)就取代了統計機器翻譯(SMT,statistical machine translation),在翻譯質量上面

Convolutional Sequence to Sequence Learning筆記

摘要:序列到序列學習的流形方法對映輸入序列到一個變長輸出序列通過迴圈神經網路。我們引入一個完全依賴於卷積神經網路的架構。和迴圈模型相比,所有元素計算可以並行化更好利用GPU並且當非線性的兩固定並不依賴於輸入長度時更容易優化。 簡介: 和迴圈層相比,卷積層對固

deep learning tutorial 翻譯(theano學習指南4(翻譯)- 卷積神經網路 )

from theano.tensor.nnet import conv rng = numpy.random.RandomState(23455) # instantiate 4D tensor for input input = T.tensor4(name='input') # initializ