深度學習:迴圈神經網路(RNN)的變體LSTM、GRU

阿新 • • 發佈:2019-02-13

訪問請移步至,這裡有能“擊穿”平行宇宙的亂序並行位元組流…

假設我們試著去預測“I grew up in France… I speak fluent French”最後的詞French。當前的資訊建議下一個詞可能是一種語言的名字,但是如果我們需要弄清楚是什麼語言,我們是需要先前提到的離當前位置很遠的 France 的上下文的。這說明相關資訊和當前預測位置之間的間隔就肯定變得相當的大。

不幸的是,在這個間隔不斷增大時,RNN 會喪失學習到連線如此遠的資訊的能力。

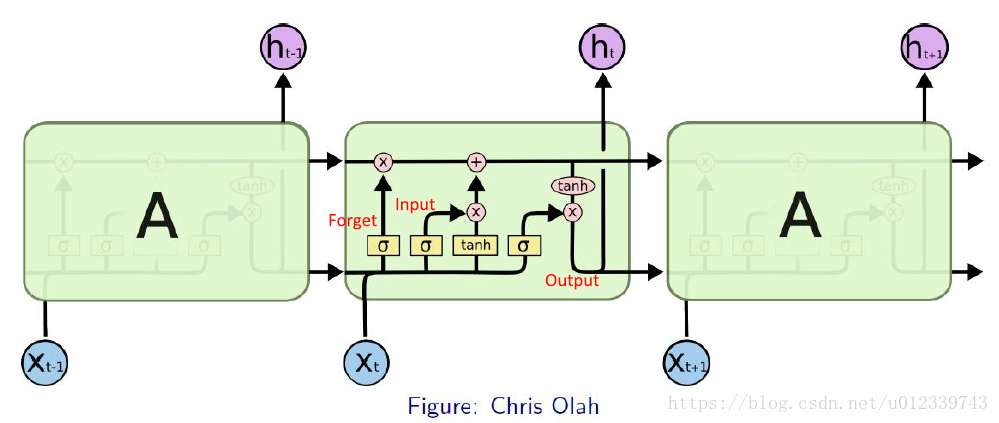

LSTM

Long Short-Term Memory—— 一般就叫做 LSTM,是一種 RNN特殊的型別,可以學習長期依賴資訊。

LSTM 通過刻意的設計來避免長期依賴問題。記住長期的資訊在實踐中是 LSTM 的預設行為,而非需要付出很大代價才能獲得的能力!

- 忘記門,在我們 LSTM 中的第一步是決定我們會從細胞狀態中丟棄什麼資訊。這個決定通過一個稱為忘記門層完成。(eg. 一句話中,當我們看到

新的主語,我們希望忘記舊的主語。) - 輸入門,確定什麼樣的新資訊被存放在細胞狀態中。

- 輸出門,實際去執行——丟棄掉我們確定需要丟棄的資訊,更新需要更新的資訊。

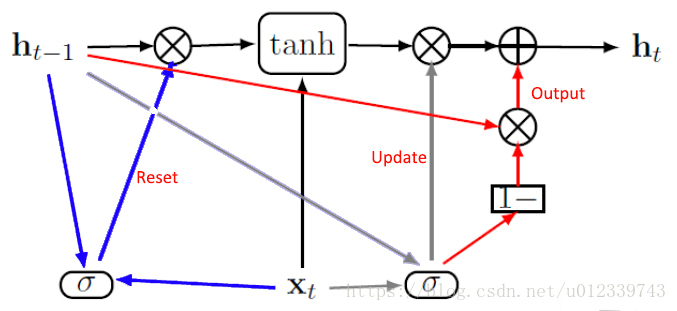

GRU

Gated Recurrent Unit——一般叫做GRU,作為LSTM的一種變體,通過分析LSTM架構中哪些部分是真正需要的,進行了改進,將忘記門和輸入門合成了一個單一的更新門

- 復位門,控制當前狀態中哪些部分用於計算下一個目標狀態。

- 更新門,在極端情況下,可以選擇全部複製或者完全替換。

復位和更新門能獨立地“忽略”狀態向量的一部分。

References:

[1] [譯] 理解 LSTM 網路

[2] 王亮老師《深度學習》講義