2.2.6 學習率衰減

學習率衰減

加快神經網路的另一個辦法就是隨著時間推移慢慢減少學習率。我們將這個稱之為學習率衰減。

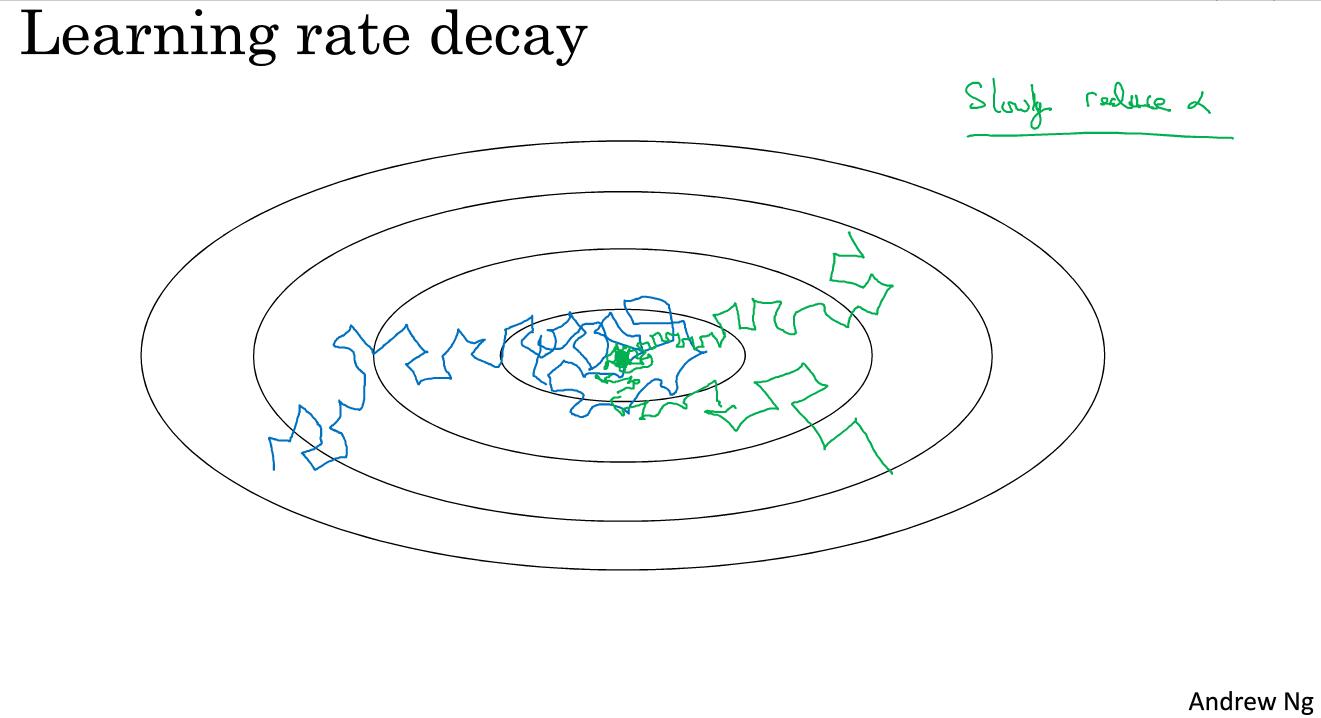

如圖中藍色線所示,當mini-batch不大的時候,噪聲會比較明顯。最後不會精確地收斂,而是在最小值附近不斷地波動。但是如果我們不斷減少學習率,最後情況就如同圖中綠線所示,最後會在最小值附近很小的一塊區域不斷波動,而不會在比較大的區域裡。

減小學習率的方法如下:

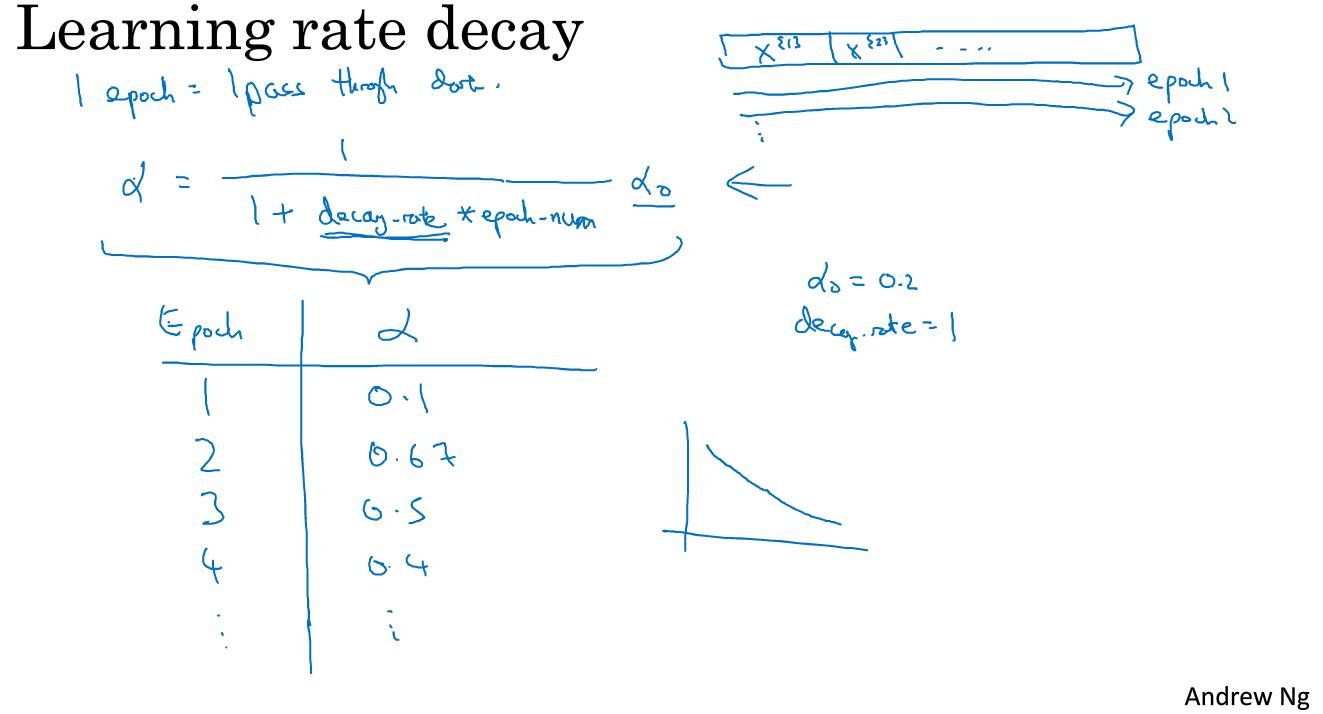

我們需要在第一代的時候遍歷一遍資料,第一次遍歷整個資料集稱為第一代,第二次遍歷整個資料集稱為第二代。我們一般的計算公式是

其中decay-rate稱為衰減率,這個也是我們需要調整的超引數。從圖中我們可以看到,如果decay-rate的值是1,隨著epoch-num的數值不斷增加,學習率在不斷下降。

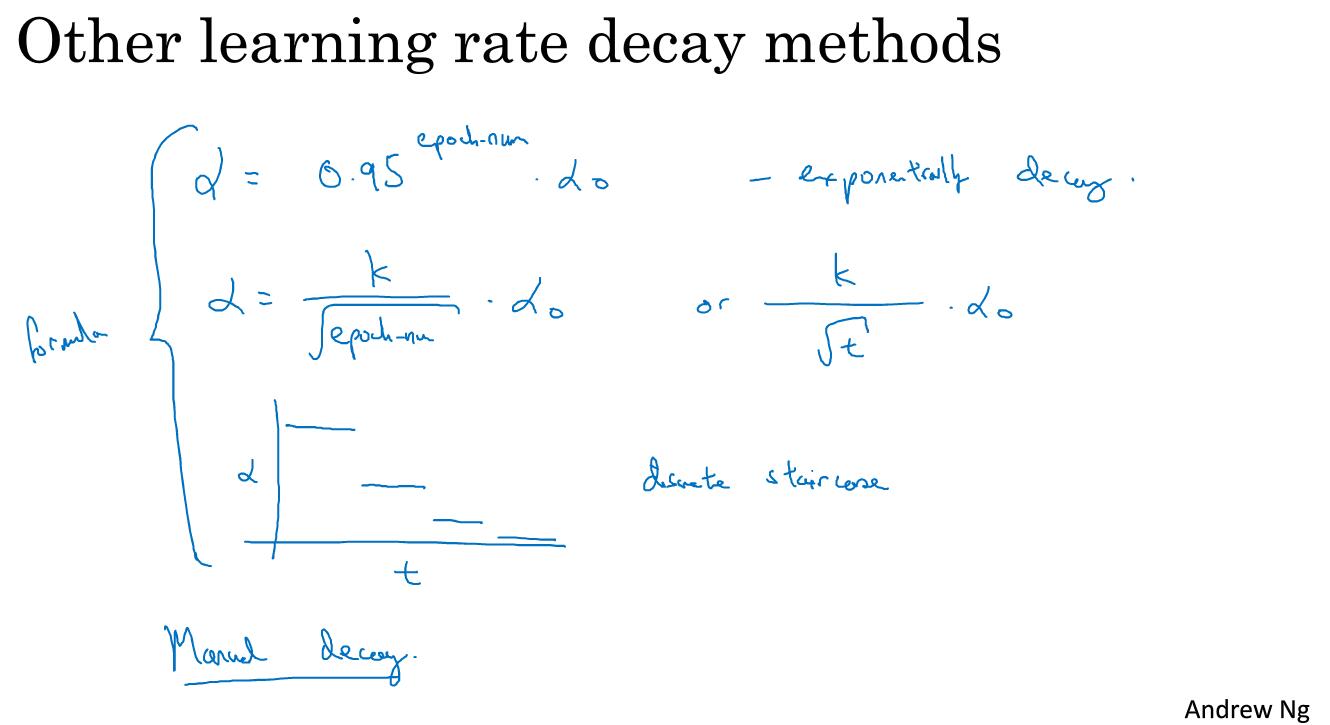

除了這個學習率衰減公式,還有別的衰減公式。

相關推薦

2.2.6 學習率衰減

學習率衰減 加快神經網路的另一個辦法就是隨著時間推移慢慢減少學習率。我們將這個稱之為學習率衰減。 如圖中藍色線所示,當mini-batch不大的時候,噪聲會比較明顯。最後不會精確地收斂,而是在最小值附近不斷地波動。但是如果我們不斷減少學習率,最後情況就如

Python 2.7.6 安裝lxml模塊[ubuntu14.04 LTS]

targe 分享 python round .html back ubunt 文件 ati lxml --->首字母是字母l,不是數字1 lxml 2.x : https://pypi.python.org/pypi/lxml/2.3 1xml官網:http

CentOS 6.6編譯安裝Nginx1.6.2+MySQL5.6.21+PHP5.6.3

strong 版權 刪除 type lis /tmp tar err conf 準備篇: CentOS 6.6系統安裝配置圖解教程 http://www.osyunwei.com/archives/8398.html 一、配置防火墻,開啟80端口、3306端口 vi /et

2.4.6 處理表單 的 工作原理的解釋

原理 rsvp 視圖 渲染 解釋 ash response 通過 填充 1.使用模型綁定 第一個 RsvpForm 動作方法渲染了對應的視圖——RsvpForm.cshtml 文件,生成了對應的表單。 第二個 RsvpForm 動

CentoS 6.X安裝xtrabackup 2.2.13

xtrabackup、數據備份、mysql備份 作為一線運維或者DBA對數據備份絕對不會陌生,mysqldump、xtrabackup等常見備份姿勢更是非常熟悉,還有很多商業備份工具以及其他的開源備份工具,所謂的冷備、熱備、增量備份什麽的,各種名詞直接晃悠的你頭疼。接下來跟著我繼續踩一遍軟件安裝的坑吧。操

anaconda安裝Opencv報錯:Could NOT find PythonLibs: Found unsuitable version "2.7.6",

list open version packages 拷貝 uitable /usr req imp 機器上裝了兩個python,一個是默認的,一個是anaconda。安裝opencv時就報錯了: -- Found PythonInterp: /home/deeplp/an

例2-3 6名運動員射擊成績的箱線圖

-1 2-2 箱子 箱線圖 比較 http 運動 表示 分布 由圖可以看出,在6名運動員中,平均成績最高的是克裏斯蒂安·賴茨(中位數為10.20),最低的是基思·桑德森(中位數為9.80);從射擊成績的分布來看,列昂尼德·葉基莫夫的成績比較集中(沒有離群點),而羅曼·邦達

2.2.6版本extras裏提供libtool有bug

編譯 lib ras master cnblogs color ext ast log 系統默認安裝的libtool沒法編譯contrib,要把它刪掉,而vlc-2.2.6的extras裏的libtool有bug。從最新git-master上面下載extras文件夾,用來替

centos7.2 rabbitmq3.6.2源碼部署

function contain kernel 遠程訪問 syntax table 配置 div 界面 1、安裝所有依賴包yum install -y gcc ncurses ncurses-base ncurses-devel ncurses-libs ncurses-s

python之路--web--2--Django-6-跨站請求偽造

跨站 orm 使用 ade safe spa doctype n) java 三、 跨站請求偽造 一、簡介 django為用戶實現防止跨站請求偽造的功能,通過中間件 django.middleware.csrf.CsrfViewMiddleware 來完成。而對於djang

Elastic Stack5.2.2升級到6.0.0註意事項

process out ict oca tor eas isa 調整 ash 最近把Elastic Stack從5.2.2版本升級到6.0.0版本,性能確實有所提高,文檔記錄了升級過程中需要註意的一些問題。 架構圖 一、Filebeat 6.0版本filebeat p

CentOS 7.2 安裝Gerrit 2.14.6

config nta body 情況 sso www order false src 1.環境 本文使用VMWare虛擬機進行實驗。 2核CPU,4GB內存,20GB硬盤,IP:192.168.159.131 CentOS 7.2最小安裝(CentOS-7-x86_64-

Ext3 Functhion擴展的5個實例方法 p135 4.2.7.6

src blog 技術分享 mage alt 圖片 img com 4.2 Ext3 Functhion擴展的5個實例方法 p135 4.2.7.6

2018年2月6日無奈的一天

不出 很多 自己 code 生活 上班 發現 無奈 過年 今天上班忙裏偷閑寫代碼,發現自己真心寫不出來登錄界面的代碼。下班又在公司從19點(吃完飯)到21點,我真的真的真的生憋不出來,好無奈啊!!!一個多月了,進度課程上顯示拉後了3個星期。。。想想也是,自己那2天打魚

2.2.6 掛起和繼續執行

一次 pack 現在 中斷線程 main 新建 cep pub 狀態 package 第二章.新建線程;/** * Created by zzq on 2018/1/17. */public class 線程中斷 { public static void main(S

Linux學習筆記第三周第二次課(2月6日)

gid ins 目錄 隨機 useradd 生成 echo tab 設置 3.4 usermod命令更改用戶屬性usermod,更改UID,命令為#usermod -u 編號;更改GID,命令為#usermod -g 編號;更改用戶家目錄,命令為#usermod -d 編號

Centos 6 apache httpd 2.2 主要配置詳解( 一 )

apache 2.2 httpd2.2 centos 6 實驗環境:VMware Workstation Pro 14(試用版) 系統平臺: CentOS release 6.9 (Final) 內核 2.6.32-696.el6.x86_64 Server versio

centos7.2+mysql5.6.35+subversion1.9.7+apache+https+php5.6.20+manmanager1.10(一)

賬戶 停止 file set and .gz rep kcon start 最近因為windows平臺的powershell病毒,導致所有windows服務器都需要遷移到linux,其中也包括svn,遷移過程中遇到很多坑逐一踩過後,現在就過程記錄下 這套環境是使用的cent

Centos 6.9中 http-2.2 中的一些基本操作和 https 的實現

http http-2.2 https 首先聲明: 接下來的所有的操作都是基於防火墻和selinux關閉的情況下;是基於本地的實現;1.建立httpd服務,要求: 1) 提供兩個基於名稱的虛擬主機www1, www2;要求每個虛擬主機都有單獨的錯誤日誌

2.1.6

minus msu cap 子集 pan 一個 mat ots spa 26.設\(E\)是可測集\(,m(E)>0.\)證明存在\(x\in E,\)使得對於任意\(\delta>0,\)有\(m(E\cap B(x,\delta))>0.\) 27.若