基於hanlp的es分詞外掛

阿新 • • 發佈:2019-07-01

摘要:elasticsearch是使用比較廣泛的分散式搜尋引擎,es提供了一個的單字分詞工具,還有一個分詞外掛ik使用比較廣泛,hanlp是一個自然語言處理包,能更好的根據上下文的語義,人名,地名,組織機構名等來切分詞

Elasticsearch

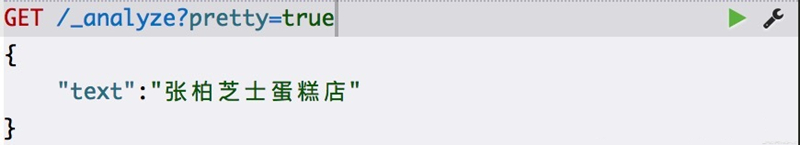

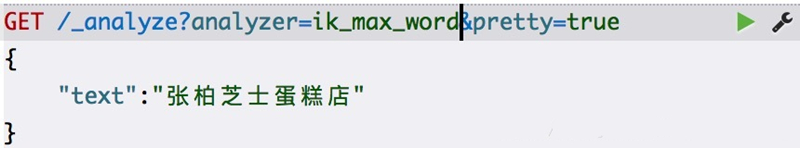

預設分詞

輸出:

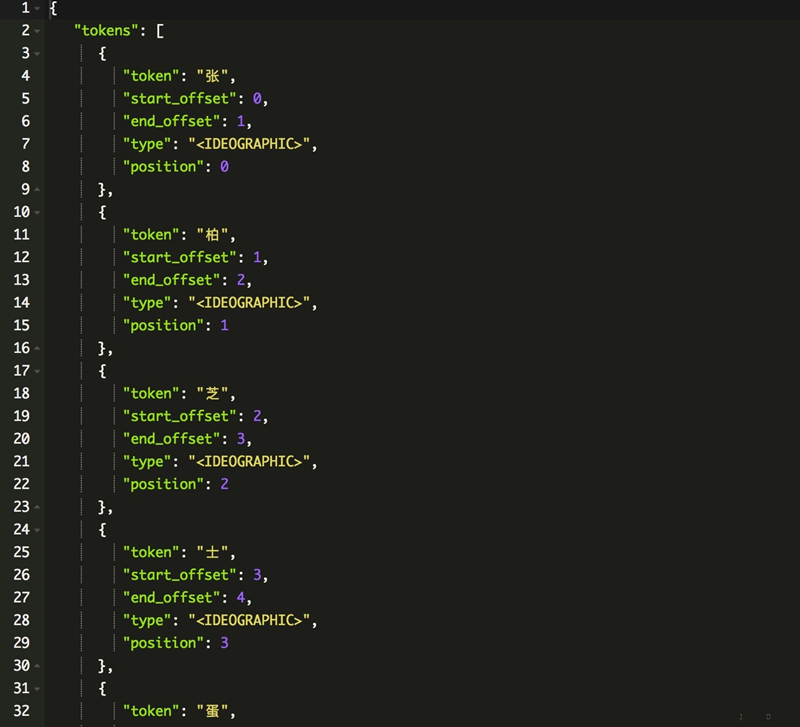

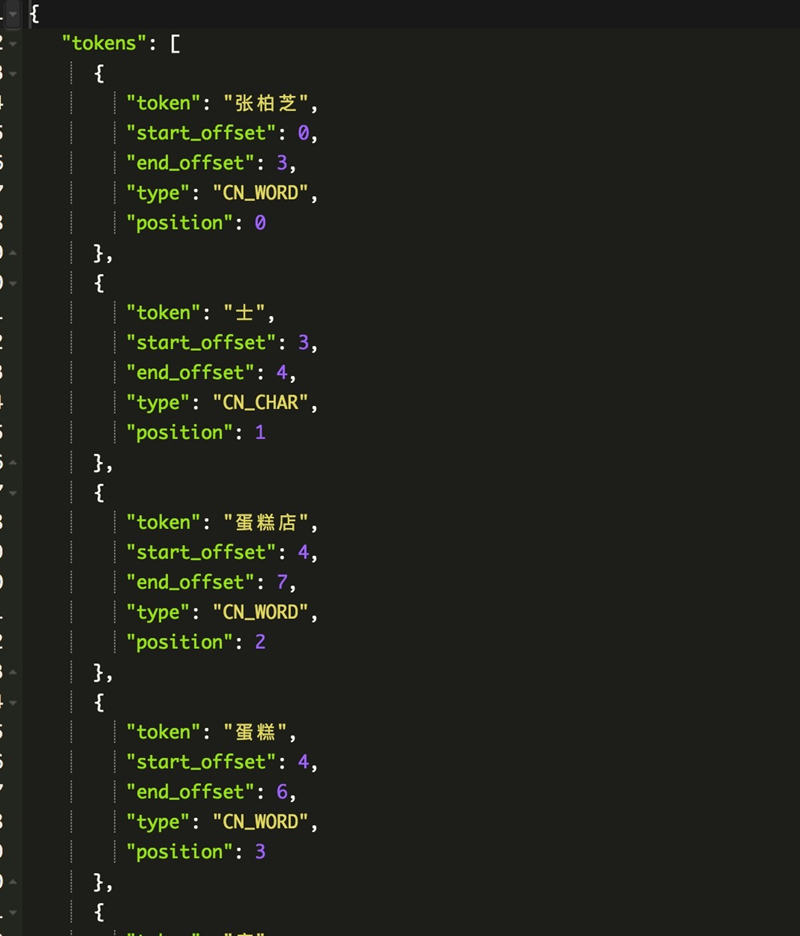

IK分詞

輸出:

hanlp分詞

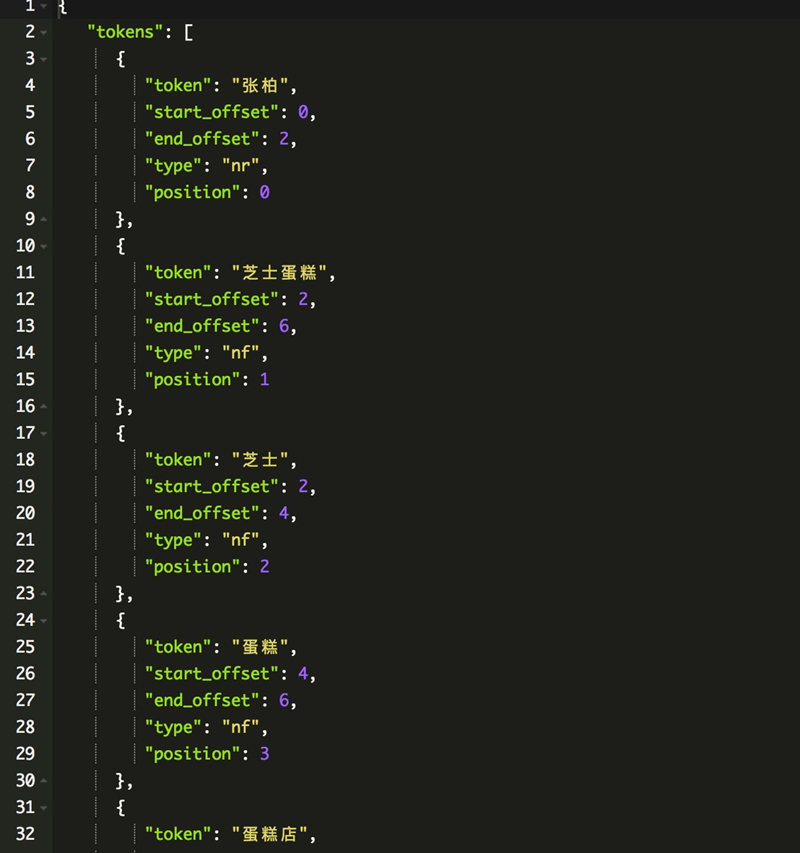

輸出:

ik分詞沒有根據句子的含義來分詞,hanlp能根據語義正確的切分出詞

安裝步驟:

1、進入https://github.com/pengcong90/elasticsearch-analysis-hanlp,下載外掛並解壓到es的plugins目錄下,修改analysis-hanlp目錄下的hanlp.properties檔案,修改root的屬性,值為analysis-hanlp下的data

目錄的地址

2、修改es config目錄下的jvm.options檔案,最後一行新增

-Djava.security.policy=../plugins/analysis-hanlp/plugin-security.policy

重啟es

GET /_analyze?analyzer=hanlp-index&pretty=true

{

“text”:”張柏芝士蛋糕店”

}

測試是否安裝成功

analyzer有hanlp-index(索引模式)和hanlp-smart(智慧模式)

自定義詞典

修改plugins/analysis-hanlp/data/dictionary/custom下的 我的詞典.txt檔案

格式遵從[單詞] [詞性A] [A的頻次]

修改完後刪除同目錄下的CustomDictionary.txt.bin檔案

重啟es服務