2015_DNN-Based Speech Bandwidth Expansion and Adding High-Frequency Missing Features Narrowband Speech

論文全名:DNN-Based Speech Bandwidth Expansion and Its Application to Adding High-Frequency Missing Features for Automatic Speech Recognition of Narrowband Speech

論文地址:基於DNN的語音頻寬擴充套件及其在窄帶語音自動識別中加入高頻缺失特徵的應用

論文程式碼:github

部落格作者:凌逆戰

部落格地址:https://www.cnblogs.com/LXP-Never/p/12361112.html

摘要

我們提出了一些增強技術來提高從窄帶到寬頻擴頻(BWE)中的語音質量,解決了三個在實際應用中可能非常關鍵的問題,即:(1)窄帶頻譜和估計的高頻頻譜之間的不連續性,(2) 測試和訓練話語之間的能量不匹配,(3)擴大了域外語音訊號的頻寬。通過頻寬擴充套件語音中高頻特徵缺失的固有預測,我們還探討了在窄帶語音中加入這些估計特徵的可行性,以提高窄帶語音自動識別(ASR)的系統性能。利用最近提出的一種基於深度神經網路的語音BWE系統,該技術不僅改進了傳統的主客觀測量方法,而且將窄帶語音識別的誤字率從8.67%降低到8.26%在20000字的《華爾街日報》(Wall Street Journal)開放詞彙ASR任務中,寬頻擴充套件語音識別率接近8.12%。

索引詞:深度神經網路,語音頻寬擴充套件,自動語音識別

1 引言

語音頻寬從窄帶擴充套件到寬頻的研究已有幾十年[1,2,3,4],目的是提高窄帶語音的收聽質量,如現有的公共交換電話網(PSTN)的收聽質量[5,6]。即使現在用於語音傳輸的頻寬不再受到嚴格的限制,我們仍然有大量的裝置來傳輸和接收窄帶語音。例如,大多數藍芽耳機[7]仍在窄帶語音。因此,將語音頻寬從窄帶(頻寬為4khz)擴充套件到寬頻(頻寬為8khz或更高)仍將有益於我們的日常生活。

另一方面,人類並不是唯一一個在人類計算機介面(HCI)系統中投入大量研究和工程努力的物件[8,9,10],口語對話系統[11,12,13]能夠理解自然的人類語言並做出反應。因此,如果頻寬擴充套件可以提高人和計算機的語音清晰度,同時基於窄帶通道的計算機輔助系統可以提供更好的使用者體驗,不僅可以提高語音質量,還可以提高自動語音識別(ASR)的潛在精度[14,15,16] 。

傳統的頻寬擴充套件通常側重於估計高頻頻帶的頻譜包絡和低頻頻帶的激勵來恢復高頻頻譜[17,18,19,20]。最近的一些研究也表明,直接估算高頻頻譜是可行的[21,22]。我們之前的工作[23]表明,基於DNN的BWE可以在這種情況下工作得很好。然而,存在一個叫做譜不連續的問題。在[24]中,通過旋轉窄帶頻譜的端點並平滑高頻分量來擬合它,解決了類似的問題。

基於DNN在大多數基於DNN的迴歸任務中固有的平滑輸出的觀察,我們建議聯合估計整個寬頻譜而不是僅僅預測高頻譜。結果發現,與傳統的想法相反,這種DNN框架可以消除窄帶和高頻譜之間的過度不連續性,它還可以減小預測的寬頻訊號的窄帶譜和估計的低頻譜之間的差異。BWE的另一個關鍵問題是測試和訓練話語之間的能量不匹配。語音活動檢測(VAD[25, 26])和語音能量調節步驟在一定程度上有幫助。利用倒譜系數的低頻成分能夠表徵給定語音[27]的平均能量特性,我們還建議將它們加入到DNN訓練中。結果發現,這種訓練方法可以較好地解決測試話語域外的問題,其中用於BWE測試中使用的測試話語與基於DNN的BWE訓練中使用的測試話語在聲學上有很大的不同。此外,為了擴充套件域外語音的頻寬,還需要解決通道失配問題。在我們的實驗中,我們發現話語歸一化可以減少一些由偏置向量在對數譜域中建模的通道失配。

通過預測DNN訓練中的整個寬頻頻譜,在DNN訓練中加入cesptral特徵,以及話語歸一化化,這三種改進技術比我們最近提出的基於DNN的BWE系統[23]有了很大的改進,我們的實驗結果表明,這三種改進技術能夠解決提高人類聽力質量的三個關鍵問題,即:(1)窄帶譜和估計的高頻譜之間的不連續性;(2)測試和訓練語句之間的能量不匹配;(3)擴充套件域外語音訊號頻寬的能力。增強BWE語音訊號的質量在主觀和客觀測試中都表現出良好的效能。

此外,為了提高語音識別系統的識別精度,我們還探討了在已有的窄帶語音基礎上增加附加高頻譜的語音特徵的可行性。我們對《華爾街日報》20000字開放詞彙量任務的ASR進行的初步實驗證實,如果系統基於相同的體系結構和訓練策略,寬頻語音的錯誤率(WER)為8.12%,可以始終優於窄帶語音,WER為8.67%。儘管如此,在擴頻語音上使用相同的設計,其功耗為8.26%,與寬頻語音的效能接近。這一令人鼓舞的結果將激勵我們在未來的工作中探索新的演算法來估計丟失的高頻譜中的額外語音特徵,以便利用現有的許多窄帶語音語料庫,甚至將它們與現有的寬頻語音資料庫相結合,以進一步提高ASR效能。

2 基於DNN的頻帶擴充套件

2.1 特徵提取

在我們最近的工作[23]中,提出了一個基於dnn的BWE系統。雖然客觀和主觀的表現都很好,但當使用對數功率譜(LPS)作為特徵時,預測高頻帶引數常常會導致低頻(0~ 4khz)到高頻(4~ 8khz)之間的過渡點出現不連續問題。為了減少這個問題,一種可能的補救方法是通過補償能量間隙來平滑這些轉換處的語音引數。我們最近的實驗表明,一個基於DNN的BWE系統可以預測整個寬頻頻譜,而不僅僅是缺失的高頻頻段。通過這樣做,它將導致預測的低頻帶和原始窄帶之間的輕微不匹配,這通常在語譜圖中很難注意到,但在使用客觀測量時會暴露出來。

對於BWE,窄帶訊號的LPS$Z^{LPS}$和寬頻訊號的LPS$X^{LPS}$被用作DNN的輸入和輸出特徵,並在特徵輸入DNN之前對其進行零均值 單位方差歸一化[28]。設$\mu_n$和$\mu_w$為訓練資料LPS特徵的均值向量,$\sum_n$和$\sum_w$為各特徵維上對應的方差。然後輸入特徵為$(Z^{LPS}-\mu_n)*\sum_n^{-1}$,DNN的輸出為$Y$,估計的寬頻LPS$X^{\hat{}}$的輸出遵循以下關係:

$$公式1:\hat{X}^{\mathrm{LPS}}=Y \cdot \Sigma_{w}+\mu_{w}$$

最近的一些研究表明,Mel-filter bank的[29]特性在基於DNN的ASR系統中表現良好。此外,我們可以很容易地將LPS轉換為對數Mel-filter bank特性,如下所示

$$公式2:X^{\mathrm{MFB}}=\ln \left[\exp \left(X^{\mathrm{LPS}}\right) \times F\right]$$

其中$X^{LPS}$為N維寬頻LPS特徵向量,F為帶K個濾波器bin的Mel-filter bank的$N*K$矩陣。對於窄帶訊號及其相應的Mel filter特徵$Z^{MFB}$,由於其頻率範圍和bin數目不同,通常窄帶訊號的bins較少,因此所用的濾波器組矩陣與寬頻訊號的濾波器組矩陣不同。濾波器箱的數量是通過確保窄帶訊號具有與寬頻訊號濾波器箱最相似的濾波器箱來確定的。

2.2 DNN訓練

我們使用Kaldi工具包[28]來訓練DNN。首先對受限玻爾茲曼機(RBM)進行無監督預訓練[30]。然後,在判別微調中,使用最小平方和誤差(MSSE[31])準則,試圖最小化預測寬頻特徵和期望寬頻訊號的真實寬頻特徵之間的歐氏距離。設$[Y;R]$為DNN的輸出,其中R是一些用於正則化的額外輸出向量,將從最終輸出Y截斷,目標函式為

$$公式3:\begin{aligned} \min & \frac{1}{2}\left\|\left(X^{\mathrm{LPS}}-\mu_{w}\right) \Sigma_{w}^{-1}-Y\right\|_{2}^{2}+\\ & \frac{\rho}{2}\left\|f\left(X^{\mathrm{LPS}}\right)-R\right\|_{2}^{2}+\frac{\gamma}{2}\left(\|Y\|_{2}^{2}+\|R\|_{2}^{2}\right) \end{aligned}$$

其中$\rho $是懲罰因子,第三項是整個輸出向量的L2損失,但在這項工作γ被設定為0。$f(\cdot)$可以是任何函式,如果$f(X^{LPS})$不是BWE的目標,則為多工學習[32]。這裡我們在第二項中使用了倒譜的下半部分,即$f(\cdot)$正在進行離散餘弦變換(DCT),並放棄了上半部分的引數。這樣可以更好地處理輸入窄帶訊號與訓練資料有較大偏差時可能出現的能量不匹配問題。

3 基於BWE語音的語音識別

本文所採用的ASR聲學模型也是前饋DNNs[33]。首先將窄帶訊號的頻譜通過基於DNN的BWE系統得到估計的寬頻譜,然後利用估計的寬頻譜提取特徵向量(log Mel filter bank),將其輸入到用於ASR的DNN聲學模型中。

在典型的DNN聲學模型設定中,隱含層通常由sigmoid單元構成,輸出層為softmax層,直接建模依賴依賴於上下文的三音狀態,有時也稱為senones[34]。通過最大化訓練框架上的對數後驗概率來訓練DNN。這等價於最小化交叉熵目標函式。設$X$為整個訓練集,其中包含T幀,即$o^{1:T}\in X$,則相對於x的損失為

$$公式4:\mathcal{L}^{1: T}=-\sum_{t=1}^{T} \sum_{j=1}^{J} \tilde{\mathbf{p}}^{t}(j) \log p\left(C_{j} | \mathbf{o}^{t}\right)$$

其中$p(C_j|o^t)$是senone $j$的後驗概率,$\tilde{p}^t$是第$t$幀的目標概率。在DNN系統的實際應用中,目標概率$\tilde{p}^t$通常是通過與現有系統進行強制對齊而獲得的,結果是目標條目等於1。利用小批次隨機梯度下降法(SGD)[35]對訓練過程中所有神經引數進行更新,該方法通過合理的小批次大小使所有的矩陣都適合GPU記憶體。採用預訓練方法初始化DNN引數。

4 實驗和結果分析

4.1 實驗步驟

我們在華爾街日報(WSJ0)語料庫[36]上進行了實驗,麥克風語音以16位 解析度16 kHz取樣,而交換機(SWB1)語料庫[37]以16位 解析度8 kHz取樣。訓練集中有31166個話語的WSJ0(約50小時訓練,10小時驗證)被用來訓練BWE模型。在寬頻訊號上,STFT的視窗大小為400個樣本,幀移為160個樣本,而窄帶訊號的視窗大小為200個樣本,增益為80個樣本。特徵提取採用漢明窗。寬頻訊號的Mel-filter bank有29個bin,範圍從0 Hz到8000 Hz,前22個bin的範圍從0 Hz到4132 Hz。窄帶特徵提取了覆蓋0 Hz到4000 Hz頻率範圍的22個濾波器組bin的係數。將MSSE訓練的基本學習率設定為$10^{-5}$,採用newbob方法[38],當均方誤差減小小於0.25%時學習率減半,當均方誤差減小小於0.25時停止。採用小批量訓練[39],批量大小32個話語,動量(momentum)率0.9。

在《華爾街日報》20k開放詞彙表任務的ASR實驗中,使用WSJ0材料(SI-84)訓練DNN聲學模型。使用WSJ0標準適配集(si et ad, 8個說話者,每個說話者40個句子)對新增到與說話者無關的DNN中的仿射變換進行適配。使用標準開放詞彙量2萬字(20k) 閱讀 NVP Senneheiser麥克風(si_et_20, 8個說話者* 40個句子)資料進行評估。解碼過程中採用了標準的三源語言模型。ASR的效能是根據單詞錯誤率(WER)給出的。

4.2 基於DNN的BWE模型的客觀評價

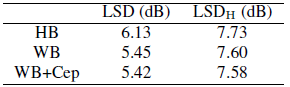

我們採用了[23,40]中的DNN結構設定,在輸入端有11幀,每層有3個隱藏層,每層有2048個隱藏節點。這裡的11幀表示將5個前幀和5個後幀與當前幀連線在一起,以輸入DNNs層。客觀的測量方法是對數譜失真(LSD)[41]和以[23]為例的分段信噪比(segmental signal-tonoise ratio, segmental snr)[42]。結果如表1和表2所示,其中LSDH為高頻頻譜的LSD, HB表示DNN僅訓練為預測高頻引數,WB表示DNN將預測整個寬頻引數,WB+Cep表示DNN同時學習LPS和倒譜引數。

表1左列的LSD結果表明,當訓練DNN預測整個寬頻引數(WB)時,它可以減少將寬頻訊號的窄帶譜和低頻譜之間的總體差別(從HB得到的6.13dB降低到5.45dB),而造成這種差異的原因可能是用於從寬頻訊號生成窄帶訊號的通道(模擬為低通濾波器或帶通濾波器)。此外,學習倒譜和LPS引數(WB+Cep)進一步將LSD降低到5.42db。對於表1右欄的LSDH(高頻LSD)結果也可以得出類似的結論。

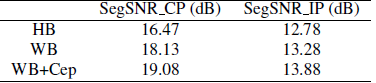

此外,如表2所示,所提出的WB+Cep DNN訓練策略在SEGSRN上取得了比WB(本研究中提出的)和HB(在[23]中提出的)更大的增益,僅給出了寬頻訊號的實際相位(CP)和窄帶訊號(在[23]中IP)的高頻成像相位的重構訊號的結果。很明顯,左柱的CP值提高了0.95分貝(從18.13分貝提高到19.08分貝)。即使在右欄的IP情況下,當相位沒有被重新估計時,我們仍然獲得0.6db的增益(從13.28到13.88db)。

表1:華爾街日報測試集的LSD

表2:WSJ測試集的SegSNR

4.3 域外資料集的主觀測試

DNN模型具有很強的學習能力和魯棒性。這促使我們測試域外窄帶語音。我們用來訓練BWE系統的資料集是相對乾淨和穩定的WSJ0,我們選擇交叉測試系統的資料集是相對困難的SWB集,它可能包含有回聲的語音以外的其他語音,有時還包含多個揚聲器。為了減少通道失配,如果我們使用失配資料集進行訓練和測試,這可能是最重要的問題,在這種情況下,在話語級別執行歸一化,每個話語將有自己的$\mu_n^i$和$\sum_n^i$進行規範化。

我們還對訓練資料進行了話語水平歸一化,並使用新的特徵對DNN進行了重新訓練,但DNN結構相同。由於SWB資料是真實的窄帶語音,頻寬僅為3.4khz,因此我們建立了3.5khz~7khz的BWE系統,並對其特徵維數進行了相應的修正。另一方面,SWB語句沒有$\mu_w$和$\sum_w$,沒有$\mu_w$和$\sum_w$就不容易重建LPS和波形。這裡我們借用了《華爾街日報》的資料估算出的$\mu_w$和$\sum_w$,並分別對它們應用了$b_i$和$s_i$。假設$\mu_{wn}$是$\mu_w$的低頻部分,$\sum_{wn}$是$\sum_w$的低頻部分,那麼

$$公式5:b_{i}=\overline{\mu_{n}^{i}-\mu_{w n}}$$

$$公式6:s_{i}=\left|\Sigma_{n}^{i} \cdot \Sigma_{w n}^{-1}\right|^{\frac{1}{M}}$$

其中$i$是話語的索引,$\bar{\cdot}$給出向量所有項的平均值,$|\cdot|$是決定因素,M為窄帶特徵向量的維數。在此基礎上,採用窄帶相位(IP)的[23]方法重建了聽力測試的波形。

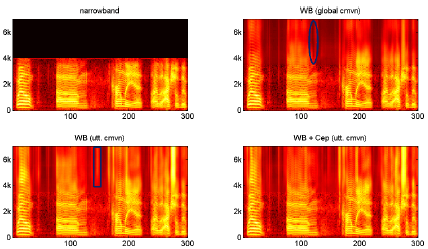

圖3顯示了一個SWB語句示例。如果只使用全域性歸一化(右上角),估計的高頻頻譜清晰度較低,能量較少,橢圓區域出現多幀高頻缺失,這可能是由於DNN沒有找到對應的模式造成的。如果使用話語水平歸一化(左下面板),高頻頻譜中有更多的能量,但矩形區域顯示噪聲被擴充套件為一個子音。我們認為這主要是由於能量不匹配,訓練資料在相同的能量水平上沒有噪音(非語音聲音)。所提出的聲譜圖在所有聲音上都有很好的表現,使聲譜圖更加清晰和準確。

圖3:SWB語音示例的頻譜圖:左上原始窄帶語音、右上bBWE語音(具有全域性規範化)、左下BWE語音(使用語音歸一化)和右下BWE語音(使用語音歸一化和倒譜多工學習)。

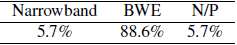

我們邀請了喬治亞理工學院的男女學生到我們的實驗室來測試他們對頻寬擴充套件語音的偏好。沒有一個志願者在BWE工作。隨機選擇SWB測試集1%的子集,每個志願者聽從1%子集中隨機選擇的10個序列。在偏好測試中,志願者一次被給予兩個沒有其他資訊的平行序列,並被要求選擇他們的首選或無首選(N/P)。結果如表3所示,在大多數情況下,頻寬擴充套件序列比其他兩種選擇具有更好的質量(幾乎90%)和更高的清晰度。只有在少數情況下,當志願者更喜歡窄帶語音時,才會被描述為噪音更小或聲音更柔和。

表3:SWB偏好測試

4.4 《華爾街日報》20000字開放詞彙任務中的ASR

最後,我們利用WSJ0材料(SI-84)對DNN聲學模型進行了初步的ASR測試。利用Kaldi toolkit[28]分別對原始寬頻語音、只有寬頻語音的低頻頻譜(0~ 4khz)的窄帶語音和由窄帶語音擴充套件而來的語音頻寬(4.2中的WB)分別訓練ASR系統的基於DNN的聲學模型。然後使用三個模型對測試集上的語音進行解碼,單詞錯誤率如表4所示。原始寬頻語音的執話率為8.12%,窄帶語音的執話率為8.67%,相對於原始寬頻語音的執話率降低了6.8%,而BWE語音的執話率為8.26%,相對於窄帶語音的執話率降低了4.7%,相對於原始寬頻語音的執話率降低了1.7%。

表4:WER來自20k單詞開放詞彙《華爾街日報》ASR任務的寬頻、寬頻和窄帶語音訓練資料。

5 總結和未來工作

為了提高BWE在聽覺質量和語音識別方面的效能,本文提出了一種基於DNN的BWE框架。為了解決以往工作中出現的頻譜不連續問題,提高系統在能量失配和通道失配情況下的效能,我們探索了三種新的技術。實驗結果表明,客觀測量對域內測試話語有顯著的改善,對域外窄帶話語的主觀聽力測試進一步證實了系統在實際應用中的效能提高。初步的ASR實驗表明,BWE技術可以提高窄帶語音的識別效能。未來的工作將集中於遷移BWE增強的ASR框架,以通過額外的通道匹配和規範化來處理實際世界中的域資料集。

6 參考文獻

[1] J. Epps and W. H. Holmes, A new technique for wideband enhancement of coded narrowband speech, in Proc. IEEE Workshop on Speech Coding, 1999, pp. 174 176.

[2] S. Vaseghi, E. Zavarehei, and Q. Yan, Speech bandwidth extension: extrapolations of spectral envelop and harmonicity quality of excitation, in Proc. ICASSP, vol. 3, 2006.

[3] J. Han, G. J. Mysore, and B. Pardo, Language informed bandwidth expansion, in Proc. IEEE Workshop on Machine Learning for Signal Processing, 2012, pp. 1 6.

[4] H. Seo, H.-G. Kang, and F. Soong, A maximum a posterior-based reconstruction approach to speech bandwidth expansion in noise, in Proc. ICASSP, 2014, pp. 6087 6091.

[5] L. A. Litteral, J. B. Gold, D. C. Klika Jr, D. B. Konkle, C. D. Coddington, J. M. McHenry, and A. A. Richard III, PSTN architecture for video-on-demand services, 1993, US Patent 5,247,347.

[6] C. Marvin, When old technologies were new. Oxford University Press, 1997.

[7] J. C. Haartsen and E. Radio, The bluetooth radio system, in IEEE Personal Communications, 2000.

[8] B. Laurel and S. J. Mountford, The art of human-computer interface design. Addison-Wesley Longman Publishing Co., Inc., 1990.

[9] B. Shneiderman, Designing the user interface: strategies for effective human-computer interaction. Addison-Wesley Reading, MA, 1992, vol. 2.

[10] R. Sharma, V. Pavlovic, and T. S. Huang, Toward multimodal human-computer interface, Proc. of the IEEE, vol. 86, no. 5, pp. 853 869, 1998.

[11] V. Zue, S. Seneff, J. R. Glass, J. Polifroni, C. Pao, T. J. Hazen, and L. Hetherington, JUPlTER: a telephone-based conversational interface for weather information, IEEE Trans. Speech Audio Process., vol. 8, no. 1, pp. 85 96, 2000.

[12] J. D. Williams and S. Young, Partially observable Markov decision processes for spoken dialog systems, Computer Speech & Language, vol. 21, no. 2, pp. 393 422, 2007.

[13] R. Pieraccini and J. Huerta, Where do we go from here? research and commercial spoken dialog systems, in 6th SIGdial Workshop on Discourse and Dialogue, 2005.

[14] S. E. Levinson, L. R. Rabiner, and M. M. Sondhi, An introduction to the application of the theory of probabilistic functions of a Markov process to automatic speech recognition, The Bell System Technical Journal, vol. 62, no. 4, pp. 1035 1074, 1983.

[15] C.-H. Lee, F. K. Soong, and K. K. Paliwal, Automatic speech and speaker recognition: advanced topics. Springer Science & Business Media, 1996, vol. 355.

[16] C. Weng, D. Yu, S. Watanabe, and B.-H. F. Juang, Recurrent deep neural networks for robust speech recognition, in Proc. ICASSP, 2014, pp. 5532 5536.

[17] B. Iser and G. Schmidt, Bandwidth extension of telephony speech, in Speech and Audio Processing in Adverse Environments. Springer, 2008, pp. 135 184.

[18] Y. Nakatoh, M. Tsushima, and T. Norimatsu, Generation of broadband speech from narrowband speech based on linear mapping, Electronics and Communications in Japan (Part II: Electronics), vol. 85, no. 8, pp. 44 53, 2002.

[19] K.-Y. Park and H. S. Kim, Narrowband to wideband conversion of speech using GMM based transformation, in Proc. ICASSP, vol. 3, 2000, pp. 1843 1846.

[20] G.-B. Song and P. Martynovich, A study of HMM-based bandwidth extension of speech signals, Signal Processing, vol. 89, no. 10, pp. 2036 2044, 2009. [21] K. Kalgaonkar and M. A. Clements, Sparse probabilistic state mapping and its application to speech bandwidth expansion, in Proc. ICASSP, 2009, pp. 4005 4008.

[22] H. Seo, H.-G. Kang, and F. Soong, A maximum a posterior-based reconstruction approach to speech bandwidth expansion in noise, in Proc. ICASSP, 2014, pp. 6087 6091.

[23] K. Li and C.-H. Lee, A deep neural network approach to speech bandwidth expansion, in Proc. ICASSP, 2015.

[24] B. Iser and G. Schmidt, Neural networks versus codebooks in an application for bandwidth extension of speech signals, in Proc. INTERSPEECH, 2003, pp. 565 568.

[25] J. Ramirez, J. M. G orriz, and J. C. Segura, Voice activity detection: Fundamentals and speech recognition system robustness. INTECH Open Access Publisher, 2007.

[26] S. Morita, M. Unoki, X. Lu, and M. Akagi, Robust voice activity detection based on concept of modulation transfer function in noisy reverberant environments, in Chinese Spoken Language Processing (ISCSLP), 9th International Symposium on, 2014, pp. 560 564.

[27] O. Viikki and K. Laurila, Cepstral domain segmental feature vector normalization for noise robust speech recognition, Speech Communication, vol. 25, no. 1, pp. 133 147, 1998.

[28] D. Povey, A. Ghoshal, G. Boulianne, L. Burget, O. Glembek, N. Goel, M. Hannemann, P. Motlicek, Y. Qian, P. Schwarz et al., The Kaldi speech recognition toolkit, in Proc. ASRU, 2011, pp. 1 4.

[29] S. Molau, M. Pitz, R. Schluter, and H. Ney, Computing melfrequency cepstral coefficients on the power spectrum, in Proc. ICASSP, vol. 1, 2001, pp. 73 76.

[30] D. H. Ackley, G. E. Hinton, and T. J. Sejnowski, A learning algorithm for Boltzmann machines, Cognitive Science, vol. 9, no. 1, pp. 147 169, 1985.

[31] D. M. Allen, Mean square error of prediction as a criterion for selecting variables, Technometrics, vol. 13, no. 3, pp. 469 475, 1971.

[32] R. Caruna, Multitask learning: A knowledge-based source of inductive bias, in Proc. ICML, 1993, pp. 41 48.

[33] G. E. Dahl, D. Yu, L. Deng, and A. Acero, Context-dependent pre-trained deep neural networks for large-vocabulary speech recognition, IEEE Trans. Audio, Speech, and Lang. Process., vol. 20, no. 1, pp. 30 42, 2012.

[34] M.-Y. Hwang and X. Huang, Shared-distribution hidden Markov models for speech recognition, IEEE Trans. Speech Audio Process., vol. 1, no. 4, pp. 414 420, 1993.

[35] O. Dekel, R. Gilad-Bachrach, O. Shamir, and L. Xiao, Optimal distributed online prediction, in Proc. ICML, 2011, pp. 713 720.

[36] D. B. Paul and J. M. Baker, The design for the Wall Street Journal-based CSR corpus, in HLT 91 Proceedings of the workshop on Speech and Natural Language, 1992, pp. 357 362.

[37] J. J. Godfrey and E. Holliman, Switchboard-1 release 2, Linguistic Data Consortium, Philadelphia, 1997.

[38] ICSI QuickNet toolbox. Newbob approach is implemented in the toolbox. [Online]. Available: http://www1.icsi.berkeley.edu/Speech/qn.html

[39] G. E. Hinton, A practical guide to training restricted Boltzmann machines, Dept. Comput. Sci., Univ. Toronto, Tech. Rep. UTML TR 2010 003, 2010.

[40] Y. Xu, J. Du, L. Dai, and C.-H. Lee, An experimental study on speech enhancement based on deep neural networks, IEEE Signal Process. Lett., pp. 65 68, 2014.

[41] I. Cohen and S. Gannot, Spectral enhancement methods, in Springer Handbook of Speech Processing. Springer, 2008, pp. 873 902.

[42] S. R. Quackenbush, T. P. Barnwell, and M. A. Clements, Objective measures of speech quality. Prentice Hall Englewood Cliffs, NJ, 1