從5個經典工作開始看語義SLAM

本文試圖概括Semantic SLAM的主要思路和近年工作,⻓期更新。但因水平有限,若有錯漏,感謝指正。

(更好的公式顯示效果,可關注文章底部的公眾號)

Semantic SLAM

簡介

至今為止,主流的 SLAM 方案 [1] 基於處於畫素層級的特徵點,更具體地,它們往往只能用角點或邊緣來提取路標。人類是通過物體在影象中的運動來推測相機的運動,而非特定畫素點。

Semantic SLAM 是研究者試圖利用物體資訊的方案,其在Deep Learning的推動下有了較大的發展,成為了相對獨立的分支,就方法(非裝置)而言,其在整個SLAM領域所處位置如下圖:

目前而言,所謂 Semantic 是將基於神經網路的語義分割、目標檢測、例項分割等技術用於 SLAM 中,多用於特徵點選取、相機位姿估計,更廣泛地說,端到端的影象到位姿、從分割結果建標記點雲、場景識別、提特徵、做迴環檢測等使用了神經網路的方法都可稱為 Semantic SLAM [2]。

語義和 SLAM 的結合的體現有以下兩點 [3]:

SLAM 幫助語義。

檢測和分割任務都需要大量的訓練資料,在 SLAM 中,由於我們可以估計相機的運動,那麼各個物體在影象中位置的變化也可以被預測出來,產生大量的新資料為語義任務提供更多優化條件,且節省人工標定的成本。

語義幫助 SLAM。

一方面,語義分割把運動過程中的每一張圖片都帶上語義標籤,隨後傳統 SLAM 將帶標籤的畫素對映到3D空間中,就能得到一個帶有標籤的地圖。這提供了高層次的地圖,有利於機器人自主理解和人機互動。

另一方面,語義資訊亦可為迴環檢測、Bundle Adjustment 帶來更多的優化條件,提高定位精度。

僅實現前者的工作往往稱為 Semantic Mapping,後者才認為是真正的 Semantic SLAM。

發展方向

分別從 Semantic Mapping 和 Real Semantic SLAM 兩方面,介紹一些主要思路。

Semantic Mapping

這類工作要求特徵點是 dense 或 semi-dense 的(否則 Mapping 無意義),因此往往用 RGB-D 的 SLAM 方案,亦或是單目相機的 semi-dense LSD-SLAM 方案 [4]。

有兩種 Mapping 方式:

將2D影象的語義分割結果,即帶標籤的畫素,對映到3D點雲中。

研究人員嘗試讓 SLAM 所得的資訊(特別是相機位姿),能夠提高語義分割的效能。其中一種是使用 SemanticFusion [5] 的 Recursive Bayes 方法:根據 SLAM 對畫素點運動的估計,當前幀的畫素的語義分類概率 與 前一幀舊位置上的分類概率相乘作為最終概率,即畫素的概率會沿著各幀累乘,因而增強語義分割的結果。

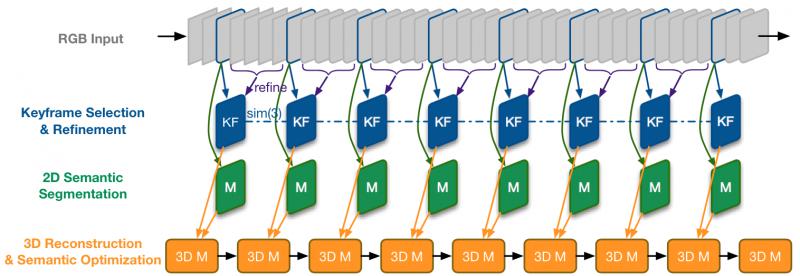

這一方法被基於單目相機的工作 [6] 沿用,整體框架描述如下。

LSD-SLAM + DeepLab-v2 (語義分割)

流程:輸入 -> 選關鍵幀並 refine(非關鍵幀用於增強深度估計)-> 2D語義分割 -> 語義優化+3D重建

① 為保證速度,僅對關鍵幀來進行語義分割,

② 其他幀用 small-baseline stereo comparisons [7] 對關鍵幀做深度估計的優化

③ 使用 Recursive Bayes 增強語義分割

④ 3D重建的優化使用條件隨機場(CRF),同 SemanticFusion

第二種 Mapping 方式則以 Object 為單位構建地圖 [8][9]。相比於一堆標記了類別的 voxel,包含一個個物體的語義地圖,將更有價值。

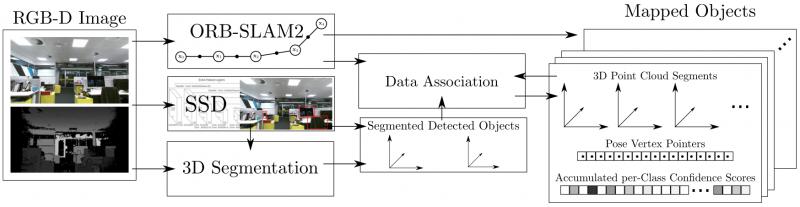

此部分的重點在於如何做資料關聯(Data Association),即跟蹤已識別 Object 和發現新 Object,以 [8] 為例描述如下。

使用 RGB-D 和 ORB-SLAM2 可構建一個 dense 的點雲。

對於關鍵幀,SSD 檢測出多個 Object,應用無監督的3D分割方法 [10] 為每一個 Object 分配點雲序列,並存儲起來。

資料關聯:得到一組分割結果(Object, 對應點雲)後,據點雲重心的歐式距離,在找出最接近的一組候選 Object,如果超過 50% 的點對的距離小於一個閾值(文中 2cm),就認為是匹配到的 Object,否則認為是新 Object,儲存下來。

匹配為同一 Object 的兩個點雲,直接累加分類概率(置信度)。這和上文提到的 Recursive Bayes 方法很像,即利用 SLAM 提供的物體多角度資訊,增強分割結果。

(注:本文的 Related Work 寫得很好)

Real Semantic SLAM

此部分為本文的重點。相對來說,真正的 Semantic SLAM (即語義建圖和 SLAM 定位相互促進)發展較晚(基本是2017年後)。

在 Bundle Adjustment (BA) 方法中,我們同時優化相機位姿和 3D 座標位置,使得重投影到 2D 影象的畫素點與實際觀測(多個相機,多個特徵點)的總誤差最小。

那麼如何將語義資訊融合進來呢?

思路一:同個 3D 點重投影之後,應保持語義一致。

這又是重投影優化問題,可以加入到 BA 公式中加強優化目標,關鍵是如何量化重投影誤差,就好像傳統 BA 的重投影誤差通過與實際觀測的畫素距離來量化。

ICRA 2017 的著名工作 Probabilistic Data Association for Semantic SLAM [11] 使用了此思路,其量化重投影誤差的方法在於:使用概率模型計算出來的物體中心,重投影到影象上,應該接近檢測框的中心。而資料關聯(到底要接近哪個檢測框中心),由一組權重決定,最後 “BA” 和 “權重更新” 通過 EM 演算法交替優化。

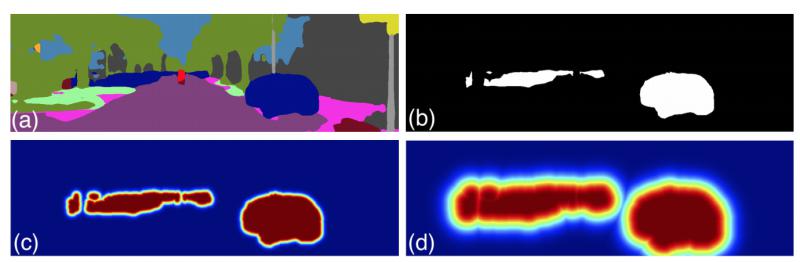

ECCV 2018 上的工作 VSO [12] 與之類似,重投影誤差通過與目標類別的語義區域的遠近來量化。有幾個細節比較巧妙,下面展開說明。

如上圖所示,(a) 為語義分割圖,(b) 為類別 “Car” 的區域,在(c) (d) 中,根據與 Car 區域的距離,概率值從1 (紅) 變為 0 (藍)。 其他類別如Tree,也會產生此概率分佈圖。

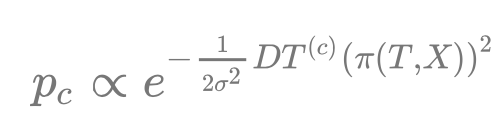

其中 距離 到 概率 的轉化,利用了下方的高斯分佈,(c) (d) 的不同是方差

導致的。這是在為量化重投影誤差做準備。對於一個空間點P(擁有座標

)來說,重投影之後計算得到一個概率:

其中

計算了重投影的結果

與類別 c 區域的最近距離,最後得到的

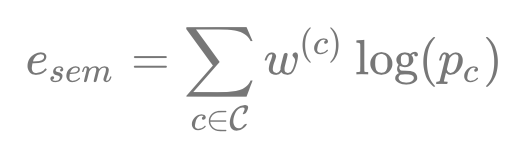

用於計算重投影誤差:

權重

的存在是為了解決資料關聯,即空間點P應該以哪一個類別的區域為目標,

。其由多個相機下的

值累乘,即多個角度觀測投票決定。

會加到普通的 BA 優化公式中,使用 EM 演算法進行優化,E 步更新權重

,而 M 步優化三維點P座標和相機位姿(普通的 BA 過程)。

個人理解,之所以使用高斯分佈,是因為其函式有“驟降”之處,那麼方差

可以起到決定閾值的作用,讓距離超過閾值的類別區域更快得到一個小權重

,多個相機的投票下,資料關聯很快就能穩定下來,可以加速優化。

(為簡化說明,上述公式已被簡化,去除了對於多個相機、空間點的索引,詳見原文)

思路二:從語義資訊可以推斷出動態區域。

傳統 SLAM 方法幾乎都是假設當前場景是靜態的,當面對含有運動物體的場景時,運動物體上的特徵點將對相機位姿估計產生巨大的偏差。面對這一困難的主要解決方式是去掉這些動態的特徵點,而語義分割十分適合找出這些動態區域。

語義分割有兩個特點,一是把平面區域的許多畫素點聯絡起來,二是給區域帶上了分類標籤。

前者有利於確定物體是否真的在運動,因為單個特徵點的偏移並不能確定運動的發生(可能是 SLAM 系統一直存在的觀測噪聲),若是一群有關聯的特徵點普遍發生了較大的偏移,就可以斷定為是動態的。

後者有利於預判物體是否會運動,比如標籤是人的區域幾乎是動態的,而牆壁則可斷定是靜態的(甚至不用去計算偏移)。

IROS 2018 的 DS-SLAM [13] 基於第一個特點,以區域為單位判斷是否動態,而一些工作如 [14] 僅利用了第二個特點,較為暴力地直接排除某些區域(天空,車)的特徵點。

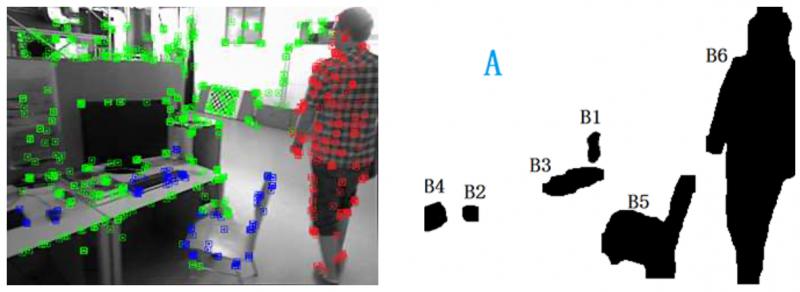

把這兩個特點都用上的是 ICRA 2019 的工作 [15], 簡述如下。

利用語義分割,將一些類別(

)區域定義為背景(綠色),其他類別(

)區域定義為可移動物體。

接下來使用運動判定,以區分可移動物體當前是靜止(藍色)還是運動(紅色)的。

運動判定的規則如下:對於某一語義區域內,過往估計的特徵點的 3D 位置,投影到當前的新影象上,重投影位置若和對應特徵點的歐式距離大於一定閾值,則定義為移動點,如果該區域移動點的比例大於一定閾值則判定為移動區域。

思路三:語義資訊提供的物體級別的描述,擁有季節(光線)不變性。

這一思路可以用在如何用已有的 3D 地圖定位。

傳統的特徵點(擁有描述子),在多變的環境下十分不魯棒,容易跟丟。而語義分割的結果,相對而言是穩定的,此外,若以物體級別來做定位(拿語義標籤來匹配地圖),更符合人類直覺。

ICRA 2018 和 2019 的工作 [16] [17] 使用了本思路。

思路四:待總結

更好的閱讀效果、更多相關內容可關注公眾號 【小林同學的腦回路】↓ ↓ ↓