詳解Go中記憶體分配

阿新 • • 發佈:2021-01-30

> 轉載請宣告出處哦~,本篇文章釋出於luozhiyun的部落格:https://www.luozhiyun.com

>

> 本文使用的go的原始碼15.7

## 介紹

Go 語言的記憶體分配器就借鑑了 TCMalloc 的設計實現高速的記憶體分配,它的核心理念是使用多級快取將物件根據大小分類,並按照類別實施不同的分配策略。TCMalloc 相關的資訊可以看這裡:http://goog-perftools.sourceforge.net/doc/tcmalloc.html。

即如果要分配的物件是個小物件(<= 32k),在每個執行緒中都會有一個無鎖的小物件快取,可以直接高效的無鎖的方式進行分配;

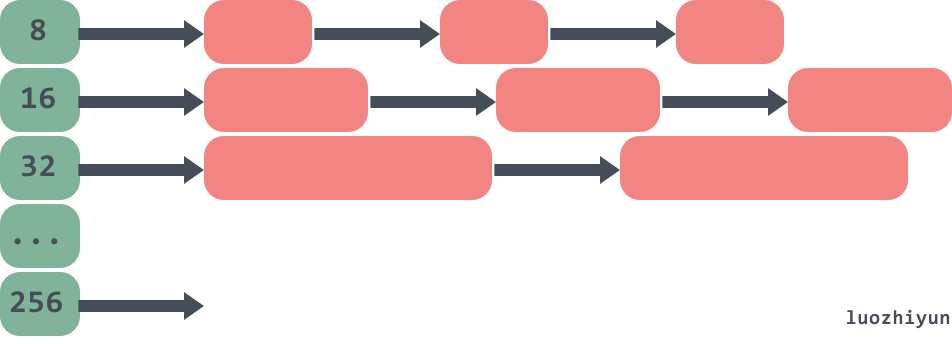

如下:物件被分到不同的記憶體大小組中的連結串列中。

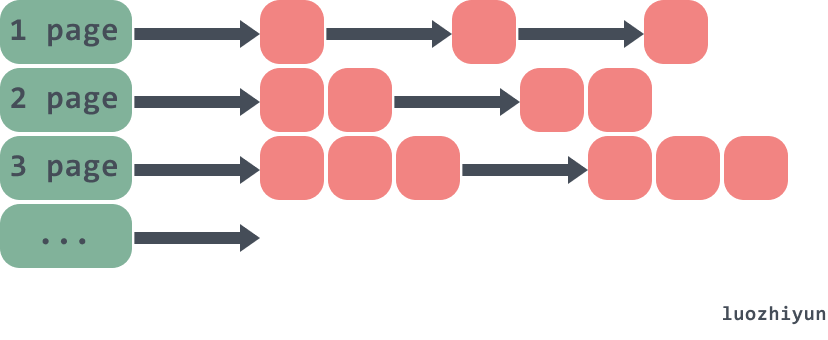

如果是個大物件(>32k),那麼頁堆進行分配。如下:

雖然go記憶體分配器最初是基於tcmalloc的,但是現在已經有了很大的不同。所以上面的一些結構會有些許變化,下面再慢慢絮叨。

因為記憶體分配的原始碼比較複雜,為了方便大家除錯,所以在進行原始碼分析之前,先看看是如何斷點彙編來進行除錯的。

### 斷點除錯彙編

目前Go語言支援GDB、LLDB和Delve幾種偵錯程式。只有Delve是專門為Go語言設計開發的除錯工具。而且Delve本身也是採用Go語言開發,對Windows平臺也提供了一樣的支援。本節我們基於Delve簡單解釋如何除錯Go彙編程式。專案地址:https://github.com/go-delve/delve

安裝:

```

go get github.com/go-delve/delve/cmd/dlv

```

首先編寫一個test.go的一個例子:

```go

package main

import "fmt"

type A struct {

test string

}

func main() {

a := new(A)

fmt.Println(a)

}

```

然後命令列進入包所在目錄,然後輸入`dlv debug`命令進入除錯:

```powershell

PS C:\document\code\test_go\src>