Machine Learning - week 1

Matrix 定義及基本運算

Transposing

To "transpose" a matrix, swap the rows and columns.

We put a "T" in the top right-hand corner to mean transpose:

Inverse of matrix

The Inverse of A is A-1 only when:

A × A-1 = A-1 × A = I

Sometimes there is no Inverse at all.

Line Regression Model and Cost Function

m: 訓練集的數量;

X: 輸入的訓練集

y:輸出

(x(i), y(i)):第 i 個訓練集

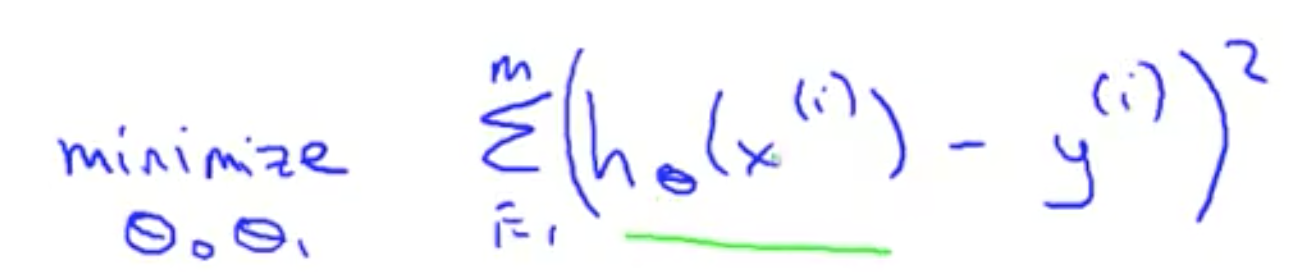

Cost Function

確定了 hθ(x) = θ0 + θ1x,那麽如何選擇 θ?

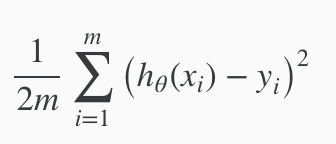

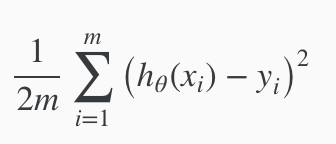

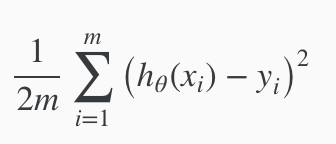

選擇合適的 θ 使 hθ(x) 可以靠近 y 在我們的訓練集數據中。hθ(x) 靠近 y 用數學形式表示為  。,在前面加上 1/m,表示平均值。再除以2,平均值的一半。所以最後變為

。,在前面加上 1/m,表示平均值。再除以2,平均值的一半。所以最後變為  。理論上來說,1 / 2m 不影響函數的趨勢。但是加上之後可以排除 m 的影響,獲取數據偏差大小,便於比較、觀察。

。理論上來說,1 / 2m 不影響函數的趨勢。但是加上之後可以排除 m 的影響,獲取數據偏差大小,便於比較、觀察。

比較 hθ

hθ(x) 是對 y 的預測。當 θ 固定時才存在。hθ(x) 為縱坐標,X 為橫坐標。

J(θ) 是 cost function,計算不同 θ 情況下,預測與實際的偏離程度。J(θ) 為縱坐標,θ 為橫坐標。

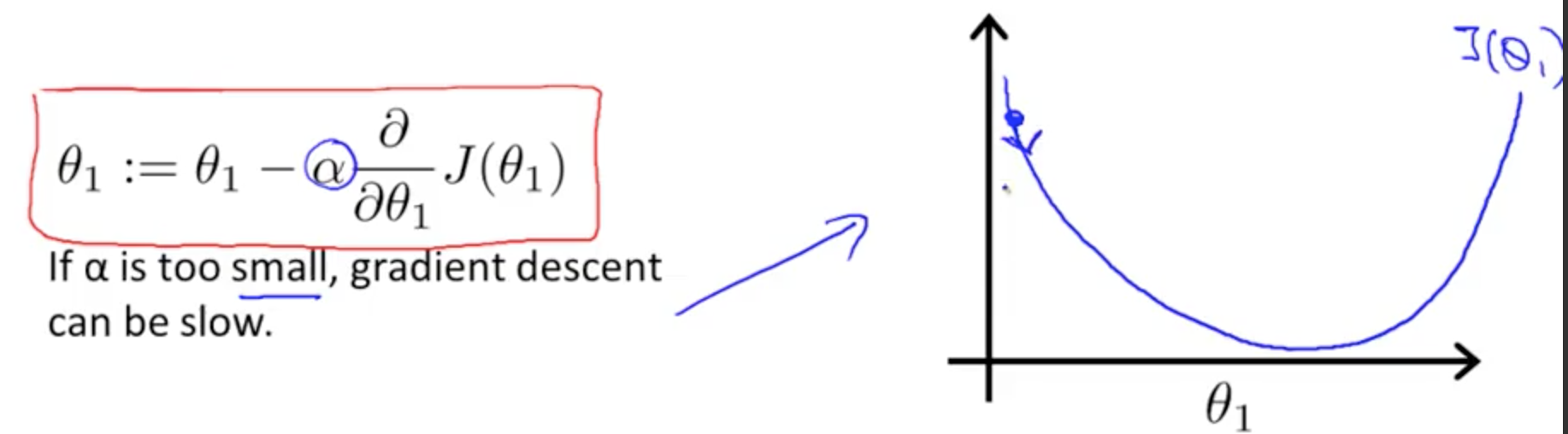

Gradient decent(梯度下降)

上一節提到,cost function 是隨著 θ 變化的,所以要找到 cost function 的最小值,就要改變 θ。就由本函數來完成。

- 從一組 θ 的初始值開始

- 不斷改變 θ 的值直到我們找到了期望的最小值

α 是學習速率。右圖中學習速率 * 斜率是正數,可知 θ 是逐漸減小的。

梯度下降能夠到達最低點,即使學習速率是固定的。由於越接近最低點,斜率越小。所以,不需要隨著時間減小 α。

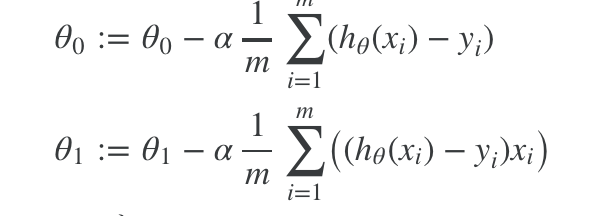

Gradient Decent For Linear Regression

上節介紹了 Gradient Decent 的是什麽,這裏介紹其與 Linear Regression 的結合。

hθ(x) = θ0 + θ1x

對  ,對 θ0 求導變為

,對 θ0 求導變為 ![]() ;

;

對  ,對 θ1 求導變為

,對 θ1 求導變為 ![]() (復合函數求導);

(復合函數求導);

參考

導數

Machine Learning - week 1