Week One - 5. 代價函式

Square Error Function

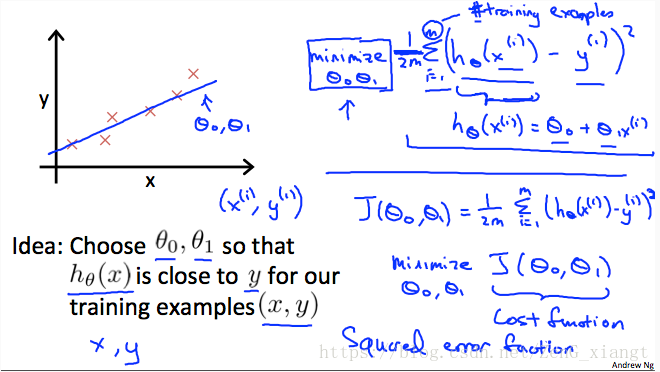

線上性迴歸中,如何選擇引數以達到最好的效果呢?或者說我們如果定義最好呢?基本想法是讓擬合的直線儘量靠近已知的資料點。

具體一點就是:

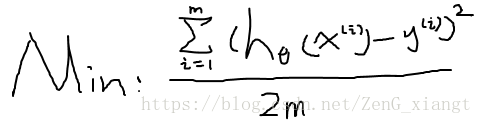

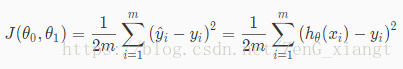

這裡cost function就是,如圖

這裡其實是Square Error Function, 在迴歸問題中很普遍,其他問題中還會出現其他代價函式。

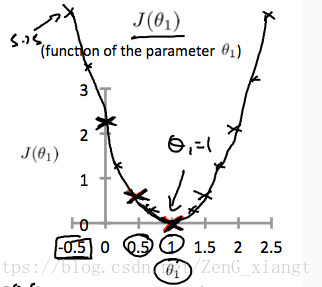

這裡我們發現代價函式其實關於引數的一個函式,如圖:

相關推薦

Week One - 5. 代價函式

Square Error Function 線上性迴歸中,如何選擇引數以達到最好的效果呢?或者說我們如果定義最好呢?基本想法是讓擬合的直線儘量靠近已知的資料點。 具體一點就是: 這裡cost fu

深度學習框架tensorflow學習與應用5(softmax函式+交叉熵代價函式和二次代價函式的比較)

import tensorflow as tf from tensorflow.examples.tutorials.mnist import input_data # In[3]: #載入資料集 mnist = input_data.read_data_sets("MNIST_data",o

Week one(N32-shaolong)

ech linux的發行版 協調 及其 -h 本地 媒體 都是 argument 描述計算機的組成及其功能 按系列羅列linux的發行版本,並描述不同發行版之間的聯系與區別 描述linux的哲學思想,並按照自己的理解對其進行解釋性描述 說明linuxd系統上命令的使用格式;

CPP-week one

發的 需要 句法 c++ python基礎 one python print 學校 #はじめまして、cppさん 初次接觸c++ 語法和python差不多 但是長好多ヽ(*。>Д<)o゜ 第一次寫 直接輸入print(“Hello World!”)╮(╯▽╰)╭

找工作筆試面試那些事兒(5)---建構函式、解構函式和賦值函式

作者:寒小陽 時間:2013年9月。 出處:http://blog.csdn.net/han_xiaoyang/article/details/10833931。 宣告:版權所有,轉載請註明出處,謝謝。 類的建構函式、解構函式與賦值函式 &

JavaScript:學習筆記(5)——箭頭函式=>以及實踐

JavaScript:學習筆記(5)——箭頭函式=>以及實踐 ES6標準新增了一種新的函式:Arrow Function(箭頭函式)。本文參考的連結如下: MDN箭頭函式:https://developer.mozilla.org/zh-CN/docs/Web/JavaScript/

機器學習基礎(六)—— 交叉熵代價函式(cross-entropy error)

分享一下我老師大神的人工智慧教程!零基礎,通俗易懂!http://blog.csdn.net/jiangjunshow 也歡迎大家轉載本篇文章。分享知識,造福人民,實現我們中華民族偉大復興!

Week One - 4.模型的表示

在Andrew Ng的課程中,有些表示符號是固定的: m : 訓練集的大小-訓練集中樣本數量 x’s: 特徵 y’s: 目標變數 (x,y): 單個訓練集樣本 : 第i個訓練集樣本 整個監督學習的過程如下圖 h: 僅僅是對

Week One - 3. Andrew Ng - 非監督學習

在前面的監督學習中,已獲取的資料集中包含正確答案,因此計算機可以通過學習來發現資料和正確答案之間的關係,進而進行預測。接下來,我們要計算機學習那些為賦予正確答案的資料。 在上圖中,我們對於資料的類別一無所知,現在只有x1和x2兩個特徵,對於無監督演算法,我們能做的就是

Week One - 2. Andrew Ng - 監督學習

情景一 假設你想預測房價, 你朋友的房子面積是750,你想知道這房子能賣多少錢,機器學習演算法如何做到這一點呢? 橫座標:房子的面積 縱座標:房子的價格,單位是1000$ 方法一: 擬合

Week One - 1. Andrew Ng - 什麼是機器學習?

Definition 定義(1): 在不需要具體程式設計的情況下賦予計算機自我學習的能力。 - Arthur Samuel(1959)。例如: 程式的編寫者可能是某個領域的菜鳥,例如圍棋,但是通過機器學習,計算機獲得瞭如果才能贏得策略,成為了圍棋高手。 定義(2):

11.5筆記 函式

---恢復內容開始--- 函式 函式在呼叫的時候,會形成一個私有作用域,內部的變數不會被外面訪問,這種保護機制叫閉包。這就意味著函式呼叫完畢, 這個函式形成的棧記憶體會被銷燬,但有時候我們不希望被銷燬。 &

線性迴歸——代價函式

Training Set 訓練集 Size in feet2(x) Price in 1000's(y) 2104 460 1416 232 1534 315

交叉熵代價函式(cross-entropy cost function)

1.從方差代價函式說起 代價函式經常用方差代價函式(即採用均方誤差MSE),比如對於一個神經元(單輸入單輸出,sigmoid函式),定義其代價函式為: 其中y是我們期望的輸出,a為神經元的實際輸出【 a=σ(z), where z=wx+b 】。 在訓練神經網路過程中,我

《OpenCV3程式設計入門》——3.1.5 imshow()函式

imshow()函式用於在指定的視窗顯示一幅影象。 函式格式: void imshow(const string& winname, InputArray mat); 引數說明: 第一個引數:const string&型別的winname,指需要顯示的視窗標識名稱

深度學習基礎--loss與啟用函式--sigmiod與softmax;對數損失函式與交叉熵代價函式

sigmiod與softmax sigmiod就是邏輯迴歸(解決二分類問題);softmax是多分類問題的邏輯迴歸 雖然邏輯迴歸能夠用於分類,不過其本質還是線性迴歸。它僅線上性迴歸的基礎上,在特徵到結果的對映中加入了一層sigmoid函式(非線性)對映,即先把特徵線性求和,然後使

Laravel 5.5 建構函式中的session(判斷是否登入)

留給自己馬克一下 public function __construct() { $this->request = request(); // 驗證是否登入 $this->middleware(function ($request, $ne

吳恩達深度學習筆記(7)--邏輯迴歸的代價函式(Cost Function)

邏輯迴歸的代價函式(Logistic Regression Cost Function) 在上一篇文章中,我們講了邏輯迴歸模型,這裡,我們講邏輯迴歸的代價函式(也翻譯作成本函式)。 吳恩達讓我轉達大家:這一篇有很多公式,做好準備,睜大眼睛!代價函式很重要! 為什麼需要代價函式: 為

【Ian Goodfellow課件】梯度下降與神經網路代價函式的結構

本課件主要內容包括: 導數與二階導數 方向曲率 泰勒級數近似 臨界點 牛頓法 牛頓法失效的情況 為何不會收斂? 鞍點或區域性極小值更常見嗎? 為何優化過程如此之慢? 二維子空間視覺化

神經網路中sigmoid 與代價函式

1.從方差代價函式說起 代價函式經常用方差代價函式(即採用均方誤差MSE),比如對於一個神經元(單輸入單輸出,sigmoid函式),定義其代價函式為: 其中y是我們期望的輸出,a為神經元的實際輸出【 a=σ(z), where z=wx+b 】。 在訓練神經網路過程中,我們通過梯度下降演算