009-LSTM網路-長短記憶網路

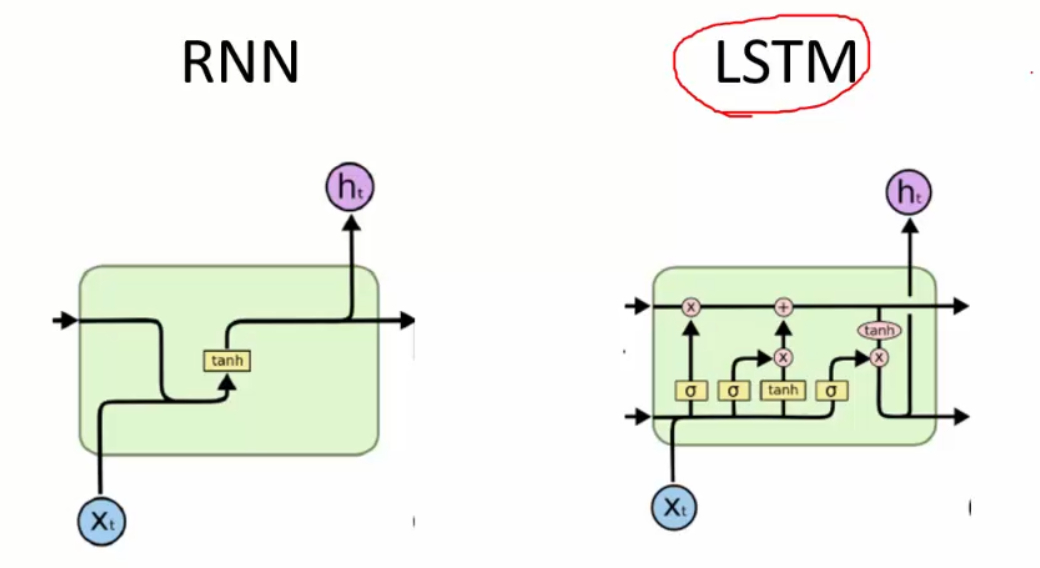

基於RNN網路的2個缺陷(全部記憶,梯度消失),現有RNN網路的升級版LSTM

LSTM要做的一件事就是本次有選擇的記憶用到下一次的遞迴工作中。

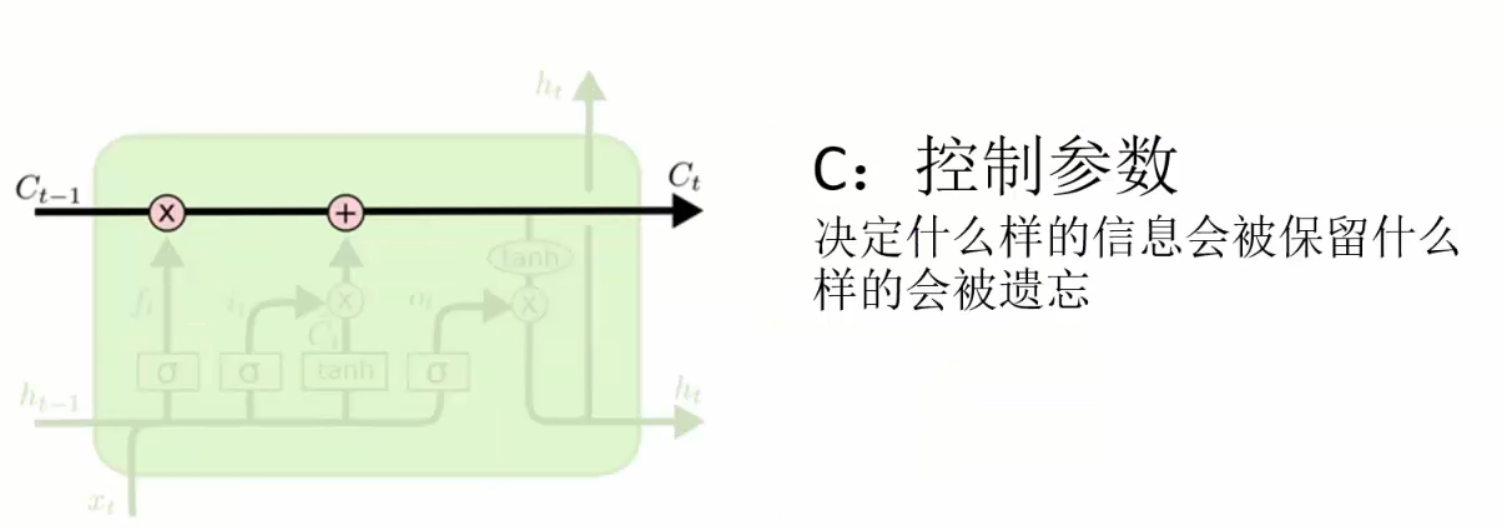

LSTM網路中,與RNN最大的區別,也是LSTM網路中最核心的東西就是控制記憶的引數C了

C是一個矩陣,用來和輸入做內積,用實際的數字控制輸入哪些該遺忘,哪些該記憶。比如0,0.1,0.5,1,0.8....等等

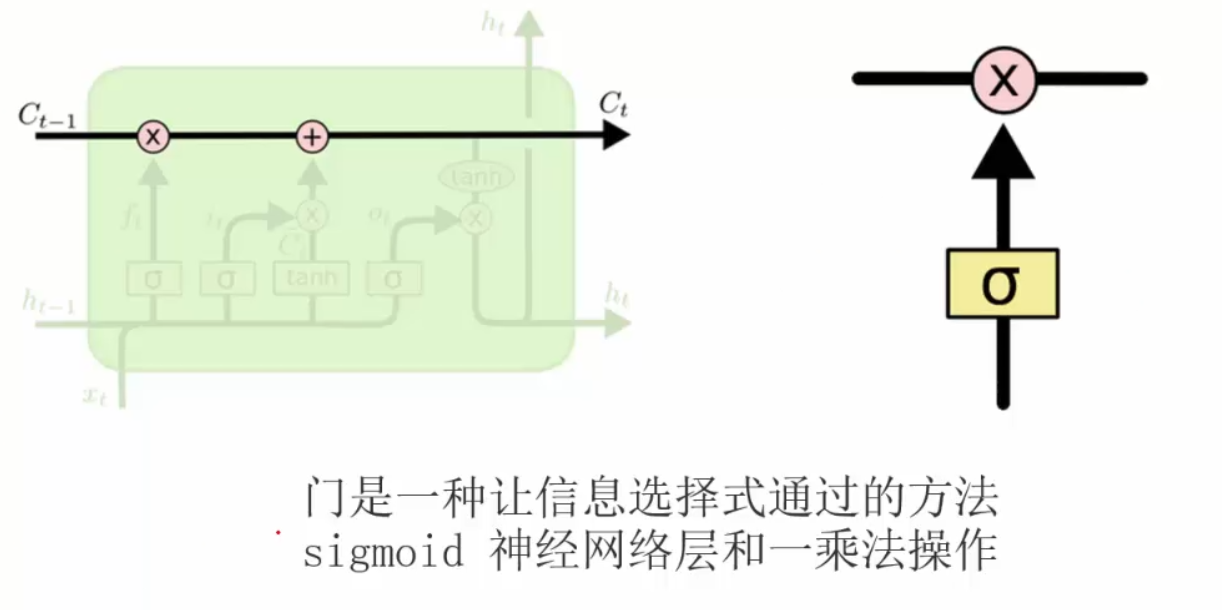

先來複習一下神經網路中的門單元:

決定丟棄(遺忘)的資訊

是上一次的輸出值

是上一次的輸出值

表示本次的輸入資料值

表示本次的輸入資料值

表示經過sigmoid函式將本次的輸入

表示經過sigmoid函式將本次的輸入 與

與 對映完成之後,進行本模組內的輸出,輸出值在0~1

對映完成之後,進行本模組內的輸出,輸出值在0~1

表示上一個神經元傳過來的記憶矩陣,決定哪些該遺忘,與

表示上一個神經元傳過來的記憶矩陣,決定哪些該遺忘,與

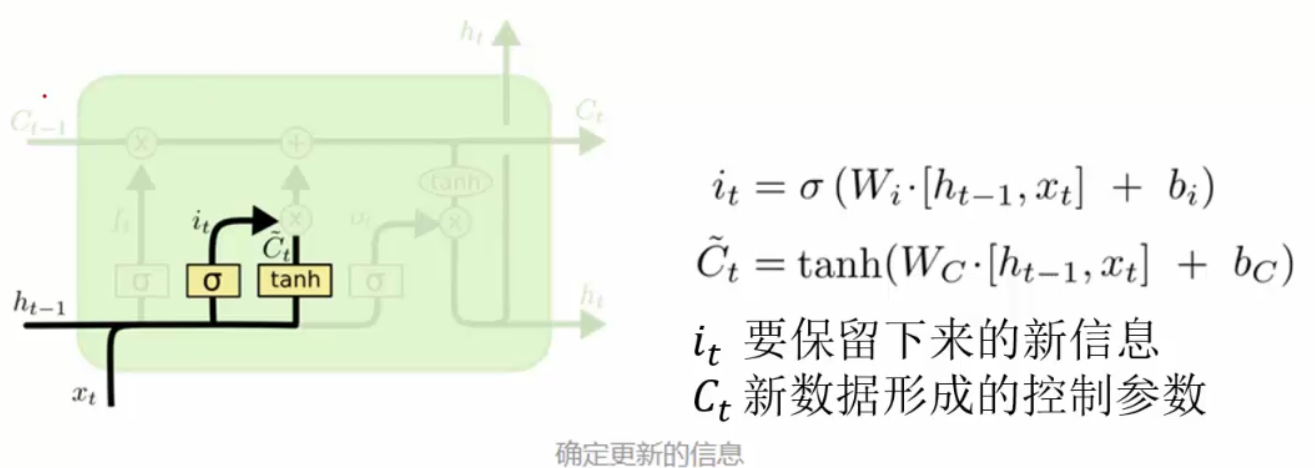

決定要保留(記憶)的資訊:

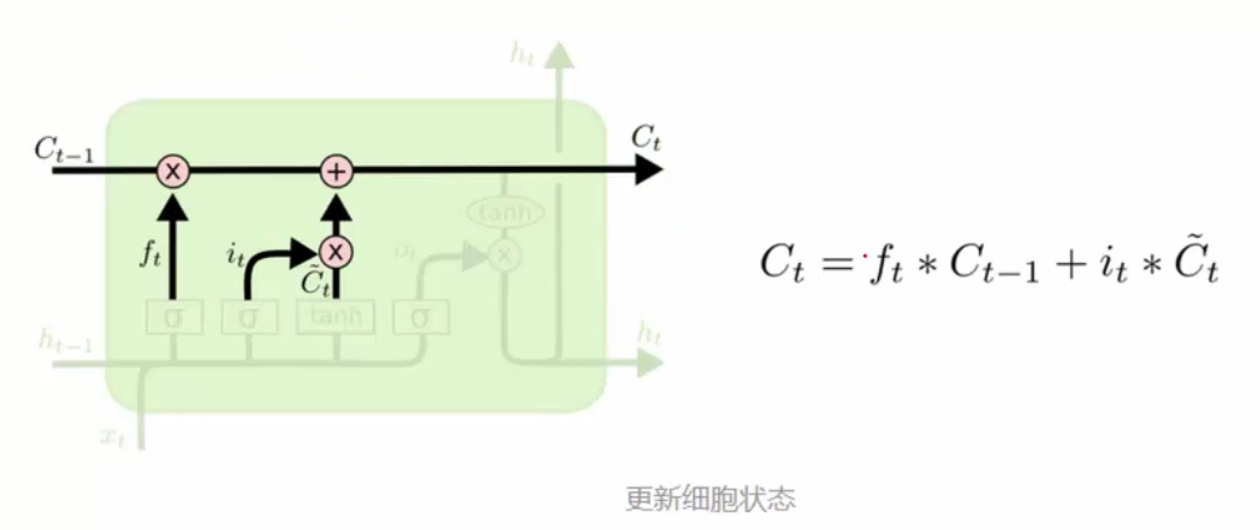

更新細胞資訊:

表示要遺忘的資訊,

表示要遺忘的資訊,

表示要記憶的資訊

表示要記憶的資訊

那麼就有一個新的 作用域之後的工作。

作用域之後的工作。

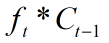

得到輸出值:

我們最終所需要的就是 ,

,

表示原始資料,也就是什麼都沒有忘記的資料。

表示原始資料,也就是什麼都沒有忘記的資料。

那麼 就用上一步更新完的

就用上一步更新完的 來和

來和 內積得到記憶結果

內積得到記憶結果

整體LSTM網路的架構:

實際應用中,LSTM使用的是比RNN多的。

相關推薦

009-LSTM網路-長短記憶網路

基於RNN網路的2個缺陷(全部記憶,梯度消失),現有RNN網路的升級版LSTM LSTM要做的一件事就是本次有選擇的記憶用到下一次的遞迴工作中。 LSTM網路中,與RNN最大的區別,也是LSTM網路中最核心的東西就是控制記憶的引數C了 C是一個矩陣,用來和輸入做內積,用實際的數字控制輸入哪些該遺忘,

雙向長短記憶網路(BiLSTM)

關於理解LSTM的一篇英文部落格非常經典,可以去這裡閱讀,本文也參考了該博文。 迴圈神經網路(RNN) BiLSTM是RNN的一種延伸,因此,要理解BiLSRM就必須首先弄明白什麼是RNN。 普通神經網路的侷限 假設我們對於普通的神經網路模型已經比較熟悉,那

長短時記憶網路(LSTM)基礎

往期回顧 在上一篇文章中,我們介紹了迴圈神經網路以及它的訓練演算法。我們也介紹了迴圈神經網路很難訓練的原因,這導致了它在實際應用中,很難處理長距離的依賴。在本文中,我們將介紹一種改進之後的迴圈神經網路:長短時記憶網路(Long Short Term Memory

基於PyTorch的LSTM長短時記憶網路實現MNIST手寫數字

本篇部落格主要介紹在PyTorch框架下,基於LSTM實現手寫數字的識別。在介紹LSTM長短時記憶網路之前,我先介紹一下RNN(recurrent neural network)迴圈神經網路.RNN是一種用來處理序列資料的神經網路,序列資料包括我們說話的語音、一段文字等等。它

長短時記憶網路LSTM

因為迴圈神經網路很難訓練的原因,這導致了它在實際應用中,很難處理長距離的依賴。我們將介紹一種改進之後的迴圈神經網路:長短時記憶網路(Long Short Term Memory Network, LSTM),它成功的解決了原始迴圈神經網路的缺陷,成為當前最流行的RNN,在語音

RNN學習筆記(一):長短時記憶網路(LSTM)

一、前言 在影象處理領域,卷積神經網路(Convolution Nerual Network,CNN)憑藉其強大的效能取得了廣泛的應用。作為一種前饋網路,CNN中各輸入之間是相互獨立的,每層神經元的訊號只能向下一層傳播,同一卷積層對不同通道資

長短期記憶(LSTM)系列_LSTM的建模方法(1)——生成式LSTM網路,Encoder-Decoder LSTM網路,CNN LSTM(LRCN)網路建模介紹

導讀 文中介紹了三種LSTM的建模應用,分別是生成式LSTM網路,Encoder-Decoder LSTM網路,CNN LSTM(LRCN)網路。 大致介紹了一下每種網路的建模方法和應用場景,這裡僅做了解即可 原文連結: 生成性長短期記憶網路 編碼器 - 解碼器長短期儲存

長短期記憶(LSTM)系列_LSTM的資料準備(4)——如何歸一化標準化長短期記憶網路的資料

導讀: 在訓練神經網路(例如長短期記憶復現神經網路)時,可能需要縮放序列預測問題的資料。 當輸入資料序列分佈並不標準,或者變化幅度(標準差)過大時,這會減慢網路的學習和收斂速度,也會阻礙網路的學習效率。 因此您需要了解如何歸一化和標準化序列預測資料,以及如何確定將哪中形式用於輸入和輸出變

Keras中長短期記憶網路LSTM的5步生命週期

Keras中長短期記憶網路LSTM的5步生命週期

長短期記憶網路(LSTM)的基礎知識、邏輯結構、實際物理結構

一、LSTM的基礎知識 輸入層:(batch_size, time_steps, input_dim) LSTM輸入層的維度是3 (1)batch_size:量級——每次訓練輪次(batch)中資料量大小 (2)time_steps:時間維度——每個訓練批次(batch)中單個輸入資

記憶網路RNN、LSTM與GRU

一般的神經網路輸入和輸出的維度大小都是固定的,針對序列型別(尤其是變長的序列)的輸入或輸出資料束手無策。RNN通過採用具有記憶的隱含層單元解決了序列資料的訓練問題。LSTM、GRU屬於RNN的改進,解決了RNN中梯度消失爆炸的問題,屬於序列資料訓練的常

機器學習與Tensorflow(5)——迴圈神經網路、長短時記憶網路

1.迴圈神經網路的標準模型 前饋神經網路能夠用來建立資料之間的對映關係,但是不能用來分析過去訊號的時間依賴關係,而且要求輸入樣本的長度固定 迴圈神經網路是一種在前饋神經網路中增加了分虧連結的神經網路,能夠產生對過去資料的記憶狀態,所以可以用於對序列資料的處理,並建立不同時段資料之間

長短期記憶網路(Long Short-Term Memory,LSTM)及其變體雙向LSTM和GRU

LSTM(Long Short-Term Memory)長短期記憶網路,是一種時間遞迴神經網路,適合於處理和預測時間序列中間隔和延遲相對較長的重要事件。LSTM是解決迴圈神經網路RNN結構中存在的“梯度消失”問題而提出的,是一種特殊的迴圈神經網路。最常見的一個例子就是:當我們

長短期記憶網路LSTM(matlab)

if(n~=1) %% 更新weight_input_x temp=train(1:input_num,n)'*W_input_x+h_state(:,n-1)'*W_input_h; for num=1:output_num for m=1:data_length

LSTM - 長短期記憶網路

## 迴圈神經網路(RNN) 人們不是每一秒都從頭開始思考,就像你閱讀本文時,不會從頭去重新學習一個文字,人類的思維是有持續性的。傳統的卷積神經網路沒有記憶,不能解決這一個問題,迴圈神經網路(Recurrent Neural Networks)可以解決這一個問題,在迴圈神經網路中,通過迴圈可以解決沒有記憶的

序列模型(3)---LSTM(長短時記憶)

false 我們 height 需要 img 問題 決定 mov clas 一、RNN回顧 略去上面三層,即o,L,y,則RNN的模型可以簡化成如下圖的形式: 二、LSTM模型結構: 整體模型: 由於RNN梯度消失的問題,大牛們對於序列索引位置t的隱藏結構做

非監督特徵學習與深度學習(十五)--------長短記憶(Long Short Term Memory,LSTM)

LSTM LSTM概述 長短記憶(Long Short Term Memory,LSTM)是一種 RNN 特殊的型別,可以學習長期依賴資訊,它引入了自迴圈的巧妙構思,以產生梯度長時間持續流動的路徑,解決RNN梯度消失或爆炸的問題。在手寫識別、

論文解讀:記憶網路(Memory Network)

在瞭解vqa問題的論文時,發現有很多論文采用了記憶網路的思路,模擬推理過程,這篇文章主要總結關於記憶網路的三篇經典論文,目的是對記憶網路有個認識。分別是: MEMORY NETWORKS,End-To-End Memory Networks,Ask Me Anything: Dynami

BE, GE or NE ACM-ICPC 2018 徐州賽區網路預賽 (記憶化搜尋)

題意:兩個人玩遊戲,輪流操作,每次操作有三個選項,當前值+x,當前值-x,當前值變成相反數。然後還有一個區間【L,R】,若第最後得分大於等於R,第一個人贏,小於等於L 第二個人贏。否則平局。問最後誰獲勝。 題解:記憶化搜尋。定義dp【i】【j】為第 i 輪等分為 j 的

長短記憶神經網絡LSTM

put oid mem 計算公式 內容 targe ref stat com 轉載:https://www.jianshu.com/p/dcec3f07d3b5 長短時記憶網絡(Long Short Term Memory Network, LSTM),是一種改進之後的循環