SVM(支援向量機)

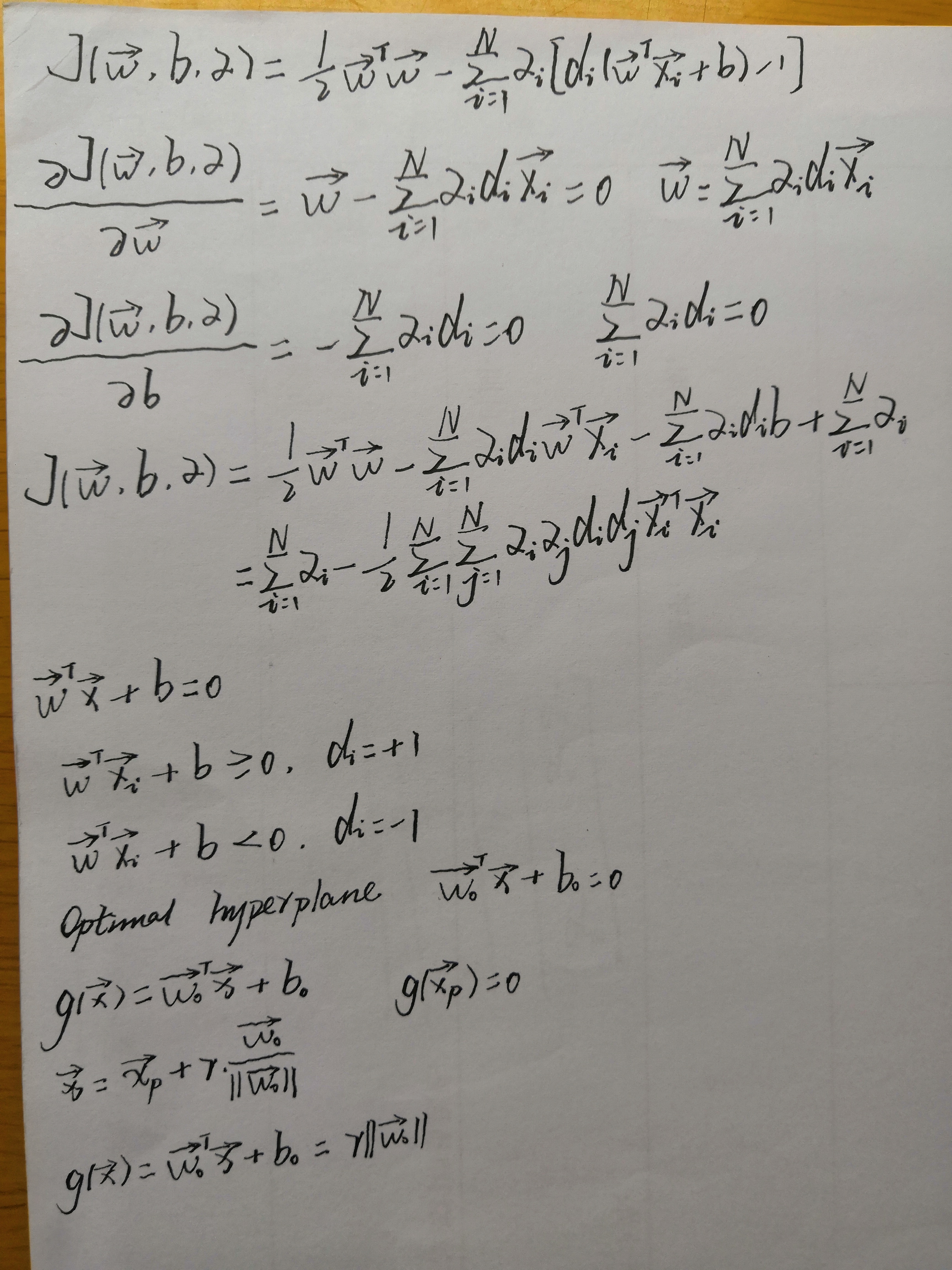

Basically, the support vector machine is a binary learning machine with some highly elegant properties. Given a training sample, the support vector machine constructs a hyperplane as the decision surface in such a way that the margin of separation between positive and negative examples is maximized. Maximizing the margin of separation between binary classes is equivalent to minimizing the Euclidean norm of the weight vector w.

相關推薦

[機器學習]svm支援向量機介紹

1 什麼是支援向量機 支援向量機是一種分類器,之所以稱為 機 是因為它會產生一個二值決策結果,即它是一個決策機。 Support Vector Machine, 一個普通的SVM就是一條直線罷了,用來完美劃分linearly separable的兩類。但這又不是一條

【SVM-tutorial】SVM-支援向量機綜述

原文地址:https://www.svm-tutorial.com/ (這篇文章是翻譯 Alexandre KOWALCZYK 的SVM tutorial ,這篇tutorial 寫的很詳細,沒有很好的數學背景的同學也可以看的懂,作者細心的從最基礎的知識講起,帶領我們一步步的認識這個複雜

機器學習實戰——SVM支援向量機 實現記錄

問題:TypeError: data type not understood alphas = mat(zeros(m,1)) 原因是zeros(())格式不對,更改後: alphas = mat(zeros((m,1))) 問題:關於IDLE中換行,回車前面出現很多空格的情況

SVM(支援向量機)

Basically, the support vector machine is a binary learning machine with some highly elegant properties. Given a training sample, the support vector machi

機器學習 (十一) SVM-支援向量機

春夜喜雨 好雨知時節,當春乃發生。 隨風潛入夜,潤物細無聲。 野徑雲俱黑,江船火獨明。 曉看紅溼處,花重錦官城。 前言 週末很多城市下開了雨,下雨中也不乏忙忙碌碌的人們,有的天不亮已經忙碌匆

SVM支援向量機系列理論(九) 核嶺迴歸

1. 嶺迴歸問題 嶺迴歸就是使用了L2正則化的線性迴歸模型。當碰到資料有多重共線性時(自變良量存在高相關性),我們就會用到嶺迴歸。 嶺迴歸模型的優化策略為: minw 1N∑i(yi−w⋅zi)2+λNwTw&nbs

SVM支援向量機系列理論(八) 核邏輯迴歸

kernel 邏輯迴歸(KRL)就是使用Representer Theory在L2正則的邏輯迴歸模型中應用核技巧。 1. Representer Theoem Representer Theoem是說,對於任何一個L2正則化的線性模型,其最優的權重向量 w∗

SVM支援向量機系列理論(七) 線性支援向量機與L2正則化 Platt模型

7.1 軟間隔SVM等價於最小化L2正則的合頁損失 上一篇 說到, ξi ξ i \xi_i 表示偏離邊界的度量,若樣本點

SVM支援向量機系列理論(四) 軟間隔支援向量機

4.1 軟間隔SVM的經典問題 4.2 軟間隔SVM的對偶問題 4.2.1 軟間隔SVM的對偶問題學習演算法 4.3 軟間

SVM支援向量機系列理論(六) SVM過擬合的原因和SVM模型選擇

6.1 SVM 過擬合的原因 實際我們應用的SVM模型都是核函式+軟間隔的支援向量機,那麼,有以下原因導致SVM過擬合: 選擇的核函式過於powerful,比如多項式核中的Q設定的次數過高 要求的間隔過大,即在軟間隔支援向量機中C的引數過大時,表示比較重視間隔,堅持要資

SVM支援向量機系列理論(五)SVM中幾種核函式的對比

核函式可以代表輸入特徵之間特殊的相似性。 5.1 線性核 形式: K(x,x′)=xTx′ K ( x ,

SVM支援向量機系列理論(三) 非線性支援向量機與核函式技巧

3.1 核技巧解決非線性SVM 3.1.1 非線性SVM解決思路 3.1.2 核技巧下SVM 3.2 Mercer核

SVM支援向量機系列理論(二) 線性可分SVM模型的對偶問題

2.1 對偶問題 2.1.1 原始問題的轉換 2.2.2 強對偶性和弱對偶性 2.3.3 SVM模型的對偶問題形式求解

機器學習演算法——SVM(支援向量機)

文章目錄 1. SVM簡介 2. SVM的一些概念 2.1 函式間隔與幾何間隔 2.2 支援向量 3. SVM模型目標函式與優化 3.1 SVM模型目標函式的推導(線性可分)

05 SVM - 支援向量機 - 概念、線性可分

一、SVM概念 支援向量機(Support Vector Machine, SVM)本身是一個__二元分類演算法__,是對感知器演算法模型的一種擴充套件,現在的SVM演算法支援__線性分類__和__非線性分類__的分類應用,並且也能夠直接將SVM應用於__迴歸應用__中,同時通過OvR或者OvO

機器學習7:SVM(支援向量機)

支援向量機 優化目標 大間距分類器 數學原理 核函式一 核函式二 使用 優化目標 對於邏輯迴歸的假設函式而言,在y=1的情況下,我們希望假設函式約等於1,且z遠大於0;在y=0的情況下,我們希望假設函式約等於

Python Spark 之SVM支援向量機

資料準備 和決策樹分類一樣,依然使用StumbleUpon Evergreen資料進行實驗。 Local模式啟動ipython notebook cd ~/pythonwork/ipynotebook PYSPARK_DRIVER_PYTHON=

斯坦福CS229機器學習筆記-Lecture8- SVM支援向量機 之核方法 + 軟間隔 + SMO 演算法

作者:teeyohuang 本文系原創,供交流學習使用,轉載請註明出處,謝謝 宣告:此係列博文根據斯坦福CS229課程,吳恩達主講 所寫,為本人自學筆記,寫成部落格分享出來 博文中部分圖片和公式都來源於CS229官方notes。

NG機器學習總結-(七)SVM支援向量機

一、損失函式 在邏輯迴歸中,我們的預測函式和損失函式為: 預測函式: 損失函式: 我們知道當y分別是1和0的時候,其cost函式如下黑色曲線部分: 不難看出,當 y=1時,隨著 z 取值變大,預測損失變小,因此,邏輯迴歸想要在面對正樣本 y=1時

SVM支援向量機和美麗的畫圖方法

SVM支援向量機python 線性可分的資料初探 生成一點線性可分的資料看看 什麼樣的直線可以分開這些點呢 SVM的獨特思想:最小間隔最大化 直觀理解 訓練 線性可分的資料初探