paper_reading:Online Feature Selection線上特徵選擇

Online Feature Selection: A Limited-Memory Substitution

Algorithm and Its Asynchronous Parallel Variation

線上特徵選擇:有限儲存器替換演算法及其非同步並行變化

ABSTRACT摘要

基於優化演算法的線上特徵選擇有兩個缺點:

-

the penalty term for L1 norm term is hard to choose;usually cross validation

L1正則化的罰函式很難確定,一般用交叉驗證來確定 -

the memory usage is hard to control or predict

記憶體很難管理

提出:

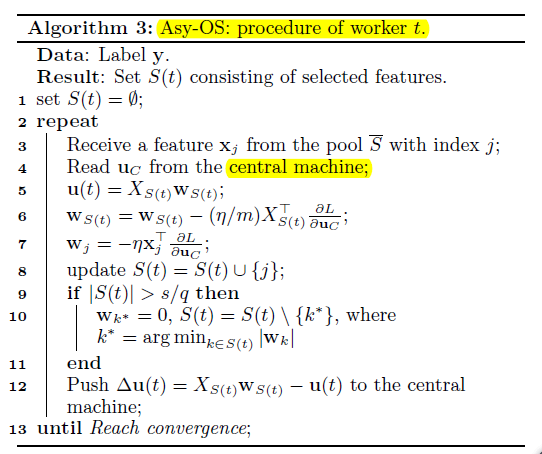

a limited-memory and model parameter free online feature selection algorithm, namely online substitution (OS) algorithm. an asynchronous parallel extension for OS (Asy-OS)

有限記憶體和模型引數遊離線上特徵選擇演算法,即線上替換(OS)演算法,並且加入非同步平行擴充套件。

關鍵詞:Feature Selection; Online Learning; Asynchronous Parallel

Optimization

1.INTRODUCTION介紹

*two types of online feature selection algorithms:*一般有兩種特選演算法:

- statistical algorithms 基於統計學的特選

- optimization based algorithms* 基於優化演算法的特選(本文主要討論)

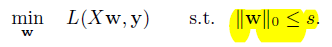

我們引入*online feature selection algorithm,線上特選演算法,主要解決以下L0範數約束問題:

其中,X是np的矩陣,n是樣本數量,p是特徵數量,y是標記向量,s是我們想要選取的特徵數量

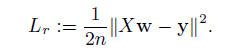

關於損失函式的格式,一般的,對於線性迴歸, L的形式為平方損失:

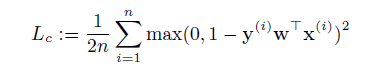

對於分類,L的形式為平方合頁損失:

當y屬於[-1,+1]的時候,L也可以是logistic regression loss,

SVM regression loss等等,在這篇文章中,不對L做限制。

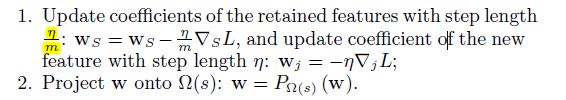

為了解決第一個問題,主要的思路是使用預測梯度下降projected gradient descent (Proj-GD),這使得正常的梯度下降步驟將當前點投射到L0球上。which makes a normal gradient descent step and projects the current point onto the L0 ball.

但是有個很嚴重的問題,做這個演算法需要得到所有的特徵,in order to use Proj-GD to do feature selection, we must have the access to all the features.

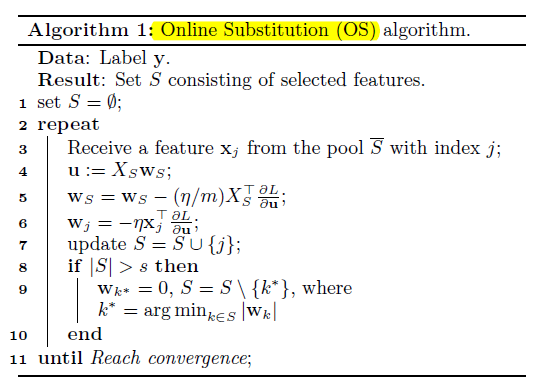

解決方法:線上替換 online substitution

方法:當s不滿,特徵總是接受,當s滿了,則替換的標準是比較新特徵的潛力S中最差的特徵。在迭代k,如果即將到來的特徵具有索引j,那麼過程是:

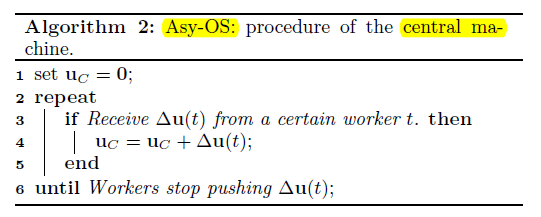

中央機器獲得一個u_c,接受各個工人的差分,

以上均沒有涉及到非同步