python 資料表格的合併和重塑--pd.concat

阿新 • • 發佈:2018-11-15

在進行資料的處理時,經常會進行表格的合併和重塑,pandas中有幾種實用的方法,在此介紹一種pd.concat

1 concat

concat函式是在pandas底下的方法,可以將資料根據不同的軸作簡單的融合

pd.concat(objs, axis=0, join='outer', join_axes=None, ignore_index=False,

keys=None, levels=None, names=None, verify_integrity=False) 引數說明

objs: series,dataframe或者是panel構成的序列lsit

axis: 需要合併連結的軸,0是行,1是列

join:連線的方式 inner,或者outer

其他一些引數不常用,用的時候再補上說明。

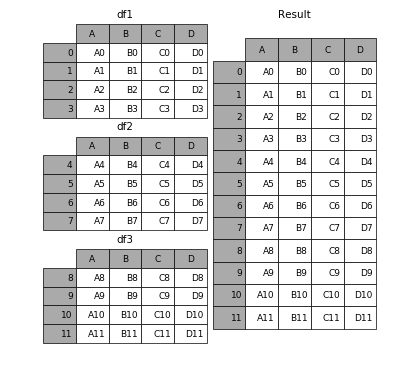

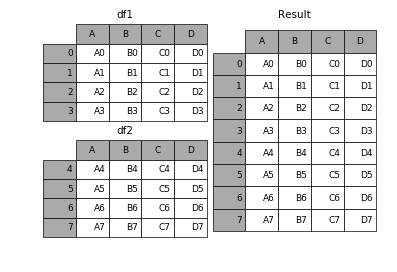

1.1 相同欄位的表首尾相接

# 現將表構成list,然後在作為concat的輸入

In [4]: frames = [df1, df2, df3]

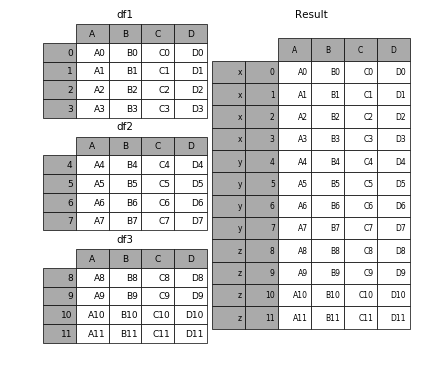

In [5]: result = pd.concat(frames)要在相接的時候在加上一個層次的key來識別資料來源自於哪張表,可以增加key引數

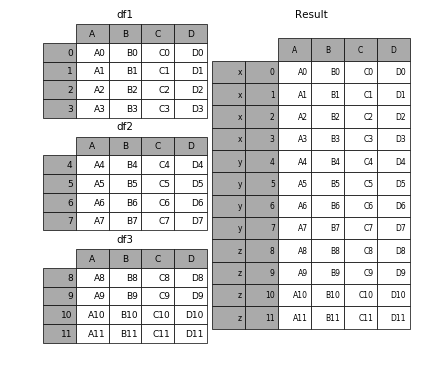

In [6]: result = pd.concat(frames, keys=['x', 'y', 'z'])效果如下

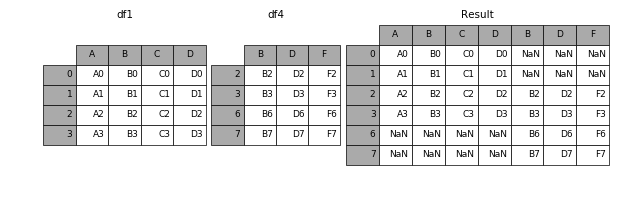

1.2 橫向表拼接(行對齊)

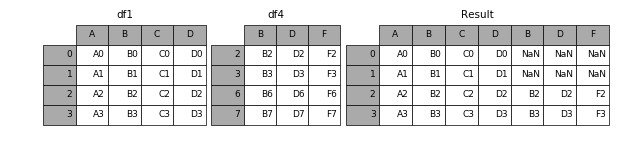

1.2.1 axis

當axis = 1的時候,concat就是行對齊,然後將不同列名稱的兩張表合併

In [9]: result = pd.concat([df1, df4], axis=1)

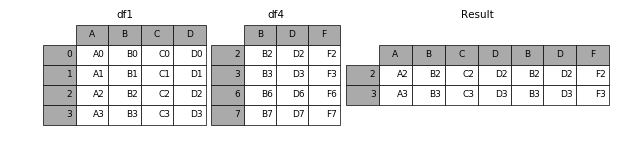

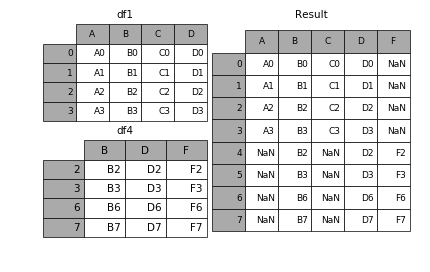

1.2.2 join

加上join引數的屬性,如果為’inner’得到的是兩表的交集,如果是outer,得到的是兩表的並集。

In [10]: result = pd.concat([df1, df4], axis=1, join='inner')

1.2.3 join_axes

如果有join_axes的引數傳入,可以指定根據那個軸來對齊資料

例如根據df1表對齊資料,就會保留指定的df1表的軸,然後將df4的表與之拼接

In [11]: result

1.3 append

append是series和dataframe的方法,使用它就是預設沿著列進行憑藉(axis = 0,列對齊)

In [12]: result = df1.append(df2)

1.4 無視index的concat

如果兩個表的index都沒有實際含義,使用ignore_index引數,置true,合併的兩個表就睡根據列欄位對齊,然後合併。最後再重新整理一個新的index。

1.5 合併的同時增加區分資料組的鍵

前面提到的keys引數可以用來給合併後的表增加key來區分不同的表資料來源

1.5.1 可以直接用key引數實現

In [27]: result = pd.concat(frames, keys=['x', 'y', 'z'])

1.5.2 傳入字典來增加分組鍵

In [28]: pieces = {'x': df1, 'y': df2, 'z': df3}

In [29]: result = pd.concat(pieces)

1.6 在dataframe中加入新的行

append方法可以將 series 和 字典就夠的資料作為dataframe的新一行插入。

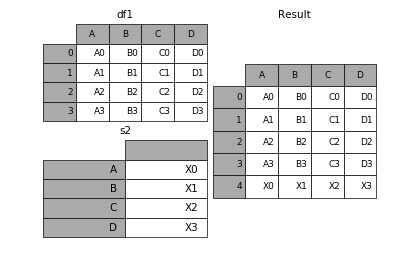

In [34]: s2 = pd.Series(['X0', 'X1', 'X2', 'X3'], index=['A', 'B', 'C', 'D'])

In [35]: result = df1.append(s2, ignore_index=True)表格列欄位不同的表合併

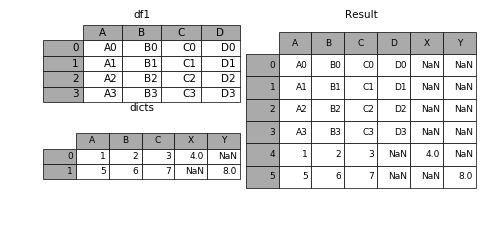

如果遇到兩張表的列欄位本來就不一樣,但又想將兩個表合併,其中無效的值用nan來表示。那麼可以使用ignore_index來實現。

In [36]: dicts = [{'A': 1, 'B': 2, 'C': 3, 'X': 4},

....: {'A': 5, 'B': 6, 'C': 7, 'Y': 8}]

....:

In [37]: result = df1.append(dicts, ignore_index=True)