深度學習基礎--卷積計算和池化計算公式

卷積計算和池化計算公式

卷積

卷積計算中,()表示向下取整。

輸入:n* c0* w0* h0

輸出:n* c1* w1* h1

其中,c1就是引數中的num_output,生成的特徵圖個數。

w1=(w0+2pad-kernel_size)/stride+1;

h1=(h0+2pad-kernel_size)/stride+1;

如果設定stride為1,前後兩次卷積部分存在重疊。如果設定pad=(kernel_size-1)/2,則運算後,寬度和高度不變。

相關推薦

深度學習:卷積,反池化,反捲積,卷積可解釋性,CAM ,G_CAM

憑什麼相信你,我的CNN模型?(篇一:CAM和Grad-CAM):https://www.jianshu.com/p/1d7b5c4ecb93 憑什麼相信你,我的CNN模型?(篇二:萬金油LIME):http://bindog.github.io/blog/2018/02/11/model-ex

深度學習基礎--卷積計算和池化計算公式

卷積計算和池化計算公式 卷積 卷積計算中,()表示向下取整。 輸入:n* c0* w0* h0 輸出:n* c1* w1* h1 其中,c1就是引數中的num_output,生成的特徵圖個數。 w1=(w0+2pad-kernel_size)/stride+1;

【深度學習】卷積神經網路的卷積層和池化層計算

一、簡介 \quad\quad 卷積神經網路(Convolutional neural network, CNN),

【深度學習】基於im2col的展開Python實現卷積層和池化層

一、回顧 上一篇 我們介紹了,卷積神經網的卷積計算和池化計算,計算過程中視窗一直在移動,那麼我們如何準確的取到視窗內的元素,並進行正確的計算呢? 另外,以上我們只考慮的單個輸入資料,如果是批量資料呢? 首先,我們先來看看批量資料,是如何計算的 二、批處理 在神經網路的

自己動手實現深度學習框架-6 卷積層和池化層

程式碼倉庫: https://github.com/brandonlyg/cute-dl (轉載請註明出處!) # 目標 上個階段使用MLP模型在在MNIST資料集上實現了92%左右的準確率,達到了tensorflow同等模型的水平。這個階段要讓cut

深度學習基礎--卷積神經網路的不變性

卷積神經網路的不變性 不變性的實現主要靠兩點:大量資料(各種資料);網路結構(pooling) 不變性的型別 1)平移不變性 卷積神經網路最初引入區域性連線和空間共享,就是為了滿足平移不變性。 關於CNN中的平移不變性的來源有多種假設。 一個想法是平移不變性

深度學習基礎--卷積--為什麼卷積核時4維的

為什麼卷積核時4維的 因為本來就是4維的,input_channelkernel_sizekernel_size*output_channel 正常來說,引數的個數不是隻和卷積核大小及數量有關嗎,256個1通道的55的卷積核引數應該是256155吧,和輸入的特徵圖數量應該沒有

深度學習基礎--卷積--反捲積(deconvolution)

反捲積(deconvolution) 這個概念很混亂,沒有統一的定義,在不同的地方出現,意義卻不一樣。 上取樣的卷積層有很多名字: 全卷積(full convolution), 網路內上取樣( in-network upsampling), 微步幅卷積(fractio

深度學習基礎--卷積--區域性連線層(Locally-Connected Layer)

區域性連線層(Locally-Connected Layer) locally-conv的概念來自傳統ML中的模型初始化(隨機樹方法中每個影象的crop都對應特定的一棵樹)。 引數共享這個策略並不是每個場景下都合適的。有一些特定的場合,我們不能把圖片上的這些視窗資料都視作作用等同

深度學習基礎--卷積--加速的卷積運算

加速的卷積運算 convolution在GPU上如何實現,文中介紹了三種方法 1)最直觀的方法是直接實現(即一般的卷積運算) 缺點:這種實現呢需要處理許多的corner case。 文中介紹cuda-convnet2是實現了該種方法,該種方法在不同取值的卷積引數空間效

深度學習基礎--卷積--1D/2D/3D卷積簡介

1D/2D/3D卷積簡介 他們處理的都是input tensor前幾個維度的資訊。 1)1D主要用於NLP中的N_gram,一維卷積又稱時域卷積。 2)2D和3D卷積用於影象。其中2D卷積處理的是一張影象,3D卷積處理的就是多張影象。3D卷積考慮時間

深度學習基礎--卷積--一般的卷積運算

一般的卷積運算 O是輸出input feature map,F是filter, D0是input feature map。 從公式看到如果用迴圈操作,需要7次迴圈,n,k,p,q4次可獨立迴圈,c,r,s是累加操作的迴圈。

深度學習基礎--卷積--1*1的卷積核與全連線的區別

1*1的卷積核與全連線的區別 11的卷積核是輸入map大小不固定的;而全連線是固定的。 11卷積的主要作用有以下兩點: 1)降維( dimension reductionality ),inception中就是這個用。 2)加入非線性,畢竟有啟用

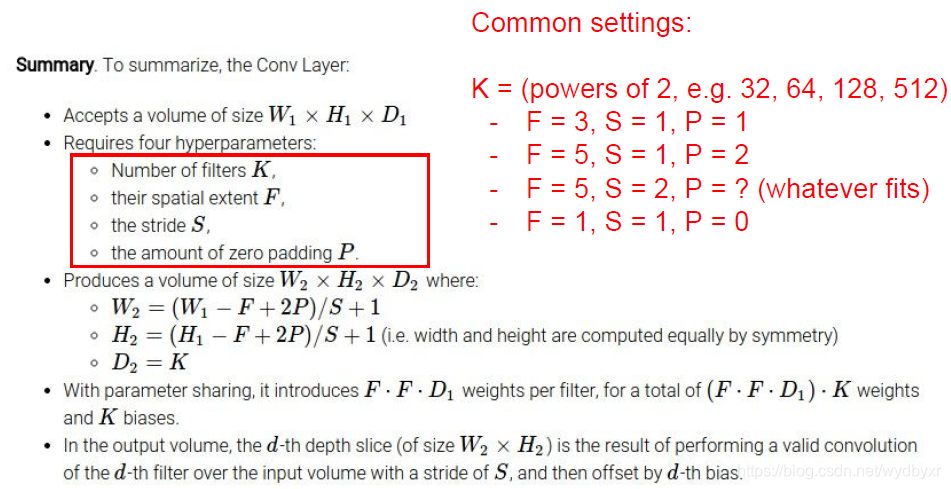

卷積層和池化層後輸出大小方法

卷積後圖片輸出大小几個數W:影象寬,H:影象高,D:影象深度(通道數)F:卷積核寬高,N:卷積核(過濾器)個數S:步長,P:用零填充個數卷積後輸出影象大小: Width=(W-F+2P)/S+1

轉:卷積層和池化層後輸出大小方法

卷積後圖片輸出大小几個數 轉自:https://blog.csdn.net/ddy_sweety/article/details/79798117 W:影象寬,H:影象高,D:影象深度(通道數) F:卷積核寬高,N:卷積核(過濾器)個數 S:步長,P:用零填充個數

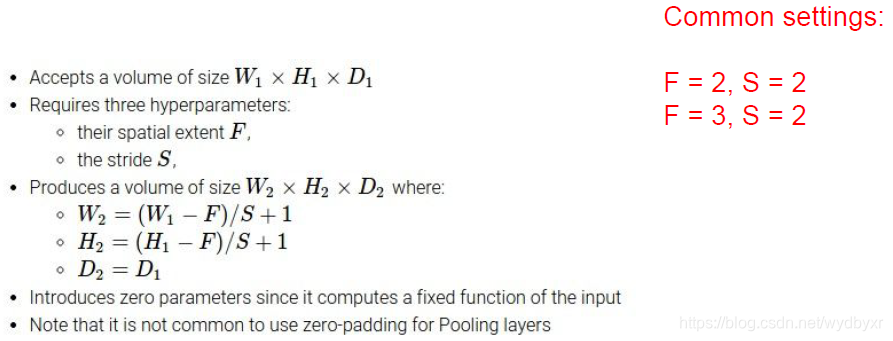

通過卷積層和池化層後輸出大小怎麼得出

通過卷積層與池化層後,特徵圖的大小怎麼計算 這裡引入cs231n中的課件說明一下: 卷積層: 引數:W:寬 H:高 D:深度 K:卷積核的個數 F:卷積核的大小 S:步長 P:用0填充 W/H=[(輸入大小-卷積核大小+2*P)/步長] +1. 舉個例子 上

深度學習中卷積和池化的總結

深度學習中卷積和池化的總結 涉及到padding的設定:https://www.jianshu.com/p/05c4f1621c7e 以及strides=[batch, height, width, channels]中,第一個、第三個引數必須為1的解釋。http://www.itdaa

深度學習中卷積和池化的一些總結

最近完成了hinton的深度學習課程的卷積和池化的這一章節了,馬上就要結束了。這個課程的作業我寫的最有感受,待我慢慢說來。 1:裡面有幾個理解起來的難點,一個是卷積,可以這麼來理解。 這幅圖是對一個5*5的矩陣A進行3*3的矩陣B的卷積,那麼就從最上角到右下角,生成卷積之

深度學習:卷積神經網路,卷積,啟用函式,池化

卷積神經網路——輸入層、卷積層、啟用函式、池化層、全連線層 https://blog.csdn.net/yjl9122/article/details/70198357?utm_source=blogxgwz3 一、卷積層 特徵提取 輸入影象是32*32*3,3是它的深度(即R

深度學習影象卷積後的尺寸計算公式

輸入圖片大小 W×W Filter大小 F×F 步長 S padding的畫素數 P 於是我們可以得出: N = (W − F + 2P )/S+1 輸出圖片大小為 N×N 如:輸入影象為5*5*3,Filter為3*3*3,在zero pad 為1,步長 S=1 (可先忽略這條