深度學習基礎--卷積--一般的卷積運算

一般的卷積運算

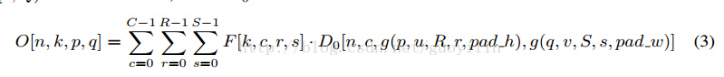

O是輸出input feature map,F是filter, D0是input feature map。

從公式看到如果用迴圈操作,需要7次迴圈,n,k,p,q4次可獨立迴圈,c,r,s是累加操作的迴圈。

O是輸出input feature map,F是filter, D0是input feature map。

從公式看到如果用迴圈操作,需要7次迴圈,n,k,p,q4次可獨立迴圈,c,r,s是累加操作的迴圈。

相關推薦

深度學習基礎--卷積神經網路的不變性

卷積神經網路的不變性 不變性的實現主要靠兩點:大量資料(各種資料);網路結構(pooling) 不變性的型別 1)平移不變性 卷積神經網路最初引入區域性連線和空間共享,就是為了滿足平移不變性。 關於CNN中的平移不變性的來源有多種假設。 一個想法是平移不變性

深度學習基礎--卷積--為什麼卷積核時4維的

為什麼卷積核時4維的 因為本來就是4維的,input_channelkernel_sizekernel_size*output_channel 正常來說,引數的個數不是隻和卷積核大小及數量有關嗎,256個1通道的55的卷積核引數應該是256155吧,和輸入的特徵圖數量應該沒有

深度學習基礎--卷積--反捲積(deconvolution)

反捲積(deconvolution) 這個概念很混亂,沒有統一的定義,在不同的地方出現,意義卻不一樣。 上取樣的卷積層有很多名字: 全卷積(full convolution), 網路內上取樣( in-network upsampling), 微步幅卷積(fractio

深度學習基礎--卷積--區域性連線層(Locally-Connected Layer)

區域性連線層(Locally-Connected Layer) locally-conv的概念來自傳統ML中的模型初始化(隨機樹方法中每個影象的crop都對應特定的一棵樹)。 引數共享這個策略並不是每個場景下都合適的。有一些特定的場合,我們不能把圖片上的這些視窗資料都視作作用等同

深度學習基礎--卷積--加速的卷積運算

加速的卷積運算 convolution在GPU上如何實現,文中介紹了三種方法 1)最直觀的方法是直接實現(即一般的卷積運算) 缺點:這種實現呢需要處理許多的corner case。 文中介紹cuda-convnet2是實現了該種方法,該種方法在不同取值的卷積引數空間效

深度學習基礎--卷積計算和池化計算公式

卷積計算和池化計算公式 卷積 卷積計算中,()表示向下取整。 輸入:n* c0* w0* h0 輸出:n* c1* w1* h1 其中,c1就是引數中的num_output,生成的特徵圖個數。 w1=(w0+2pad-kernel_size)/stride+1;

深度學習基礎--卷積--1D/2D/3D卷積簡介

1D/2D/3D卷積簡介 他們處理的都是input tensor前幾個維度的資訊。 1)1D主要用於NLP中的N_gram,一維卷積又稱時域卷積。 2)2D和3D卷積用於影象。其中2D卷積處理的是一張影象,3D卷積處理的就是多張影象。3D卷積考慮時間

深度學習基礎--卷積--一般的卷積運算

一般的卷積運算 O是輸出input feature map,F是filter, D0是input feature map。 從公式看到如果用迴圈操作,需要7次迴圈,n,k,p,q4次可獨立迴圈,c,r,s是累加操作的迴圈。

深度學習基礎(二)—— 從多層感知機(MLP)到卷積神經網路(CNN)

經典的多層感知機(Multi-Layer Perceptron)形式上是全連線(fully-connected)的鄰接網路(adjacent network)。 That is, every neuron in the network is connec

深度學習基礎--卷積--1*1的卷積核與全連線的區別

1*1的卷積核與全連線的區別 11的卷積核是輸入map大小不固定的;而全連線是固定的。 11卷積的主要作用有以下兩點: 1)降維( dimension reductionality ),inception中就是這個用。 2)加入非線性,畢竟有啟用

機器學習與深度學習系列連載: 第二部分 深度學習(十二)卷積神經網路 3 經典的模型(LeNet-5,AlexNet ,VGGNet,GoogLeNet,ResNet)

卷積神經網路 3 經典的模型 經典的卷積神經網路模型是我們學習CNN的利器,不光是學習原理、架構、而且經典模型的超引數、引數,都是我們做遷移學習最好的源材料之一。 1. LeNet-5 [LeCun et al., 1998] 我們還是從CNN之父,LeCun大神在98年提出的模

機器學習與深度學習系列連載: 第二部分 深度學習(十一)卷積神經網路 2 Why CNN for Image?

卷積神經網路 2 Why CNN 為什麼處理圖片要用CNN? 原因是: 一個神經元無法看到整張圖片 能夠聯絡到小的區域,並且引數更少 圖片壓縮畫素不改變圖片內容 1. CNN 的特點 卷積: 一些卷積核遠遠小於圖片大小; 同樣的pat

《TensorFlow:實戰Google深度學習框架》——6.3 卷積神經網路常用結構

1、卷積層 圖6-8顯示了卷積層神經網路結構中重要的部分:濾波器(filter)或者核心(kernel)。 過濾器可以將當前層神經網路上的一個子節點矩陣轉化為下一層神經網路上的一個單位節點矩陣 。 單位節點矩陣指的是一個長和寬都為1,但深度不限的節點矩陣 。 在一個卷積層巾,過濾器

《TensorFlow:實戰Google深度學習框架》——6.2 卷積神經網路簡介(卷積神經網路的基本網路結構及其與全連線神經網路的差異)

下圖為全連線神經網路與卷積神經網路的結構對比圖: 由上圖來分析兩者的差異: 全連線神經網路與卷積網路相同點 &nb

《TensorFlow:實戰Google深度學習框架》——6.3 卷積神經網路常用結構(池化層)

池化層在兩個卷積層之間,可以有效的縮小矩陣的尺寸(也可以減小矩陣深度,但實踐中一般不會這樣使用),co。池從而減少最後全連線層中的引數。 池化層既可以加快計算速度也可以防止過度擬合問題的作用。 池化層也是通過一個類似過濾器結構完成的,計算方式有兩種: 最大池化層:採用最

深度學習:tensorflow入門:卷積神經網路實現MNIST手寫字型識別

程式碼中./data/mnist/input_data/為真實MNIST資料集的路徑 import tensorflow as tf from tensorflow.examples.tutorials.mnist import input_data # 定義

吳恩達深度學習系列課程筆記:卷積神經網路(一)

本系列文章將對吳恩達在網易公開課“深度學習工程師”微專業內容進行筆記總結,這一部分介紹的是“卷積神經網路”部分。 1、計算機視覺 計算機視覺在我們還是生活中有非常廣泛的應用,以下幾個是最常見的例子: 影象分類: 可以對影象中的物體種類進行判斷,如確定影象中

【深度學習】8:CNN卷積神經網路與sklearn資料集實現數字識別

前言:這個程式碼是自己閒暇無事時候寫的。 因為CNN卷積神經網路用MNIST資料集、sklearn資料集程式碼很多部分都很相似,這一篇就不附詳細說明,原始碼最下。CNN卷積神經網路的工作原理,請詳情參考——【深度學習】5:CNN卷積神經網路原理、MNIST資料

深度學習筆記5-tensorflow實現卷積神經網路

深度學習筆記5-tensorflow實現卷積神經網路 在股票等預測模型中,可以從原始資料提取金融因子等特徵。而影象則無有效特徵,只能藉助SIFT、HOG等提取有效特徵,再集合SVM等機器學習演算法進行影象識別。卷積神經網路(CNN)提取的特徵則可以達到更好的效果,同時它不需要將特徵提取和

吳恩達深度學習:基於Matlab完成卷積神經網路第四課第一週程式設計任務

這兩三個月通過吳恩達老師的課程學習了深度學習,從零開始學理論,做程式設計任務。感覺學了很多知識。現在學到卷積神經網路,想把第一週的程式設計任務、其中的要點上傳和編寫,方便自己以後鞏固。(注:吳恩達老師課程的程式設計任務是用Python來完成的,而我是用ma