深度學習基礎--卷積--1D/2D/3D卷積簡介

1D/2D/3D卷積簡介

他們處理的都是input tensor前幾個維度的資訊。

1)1D主要用於NLP中的N_gram,一維卷積又稱時域卷積。

2)2D和3D卷積用於影象。其中2D卷積處理的是一張影象,3D卷積處理的就是多張影象。3D卷積考慮時間維度的資訊。

相關推薦

深度學習基礎--卷積--1D/2D/3D卷積簡介

1D/2D/3D卷積簡介 他們處理的都是input tensor前幾個維度的資訊。 1)1D主要用於NLP中的N_gram,一維卷積又稱時域卷積。 2)2D和3D卷積用於影象。其中2D卷積處理的是一張影象,3D卷積處理的就是多張影象。3D卷積考慮時間

深度學習基礎--卷積神經網路的不變性

卷積神經網路的不變性 不變性的實現主要靠兩點:大量資料(各種資料);網路結構(pooling) 不變性的型別 1)平移不變性 卷積神經網路最初引入區域性連線和空間共享,就是為了滿足平移不變性。 關於CNN中的平移不變性的來源有多種假設。 一個想法是平移不變性

深度學習基礎--卷積--為什麼卷積核時4維的

為什麼卷積核時4維的 因為本來就是4維的,input_channelkernel_sizekernel_size*output_channel 正常來說,引數的個數不是隻和卷積核大小及數量有關嗎,256個1通道的55的卷積核引數應該是256155吧,和輸入的特徵圖數量應該沒有

深度學習基礎--卷積--反捲積(deconvolution)

反捲積(deconvolution) 這個概念很混亂,沒有統一的定義,在不同的地方出現,意義卻不一樣。 上取樣的卷積層有很多名字: 全卷積(full convolution), 網路內上取樣( in-network upsampling), 微步幅卷積(fractio

深度學習基礎--卷積--區域性連線層(Locally-Connected Layer)

區域性連線層(Locally-Connected Layer) locally-conv的概念來自傳統ML中的模型初始化(隨機樹方法中每個影象的crop都對應特定的一棵樹)。 引數共享這個策略並不是每個場景下都合適的。有一些特定的場合,我們不能把圖片上的這些視窗資料都視作作用等同

深度學習基礎--卷積--加速的卷積運算

加速的卷積運算 convolution在GPU上如何實現,文中介紹了三種方法 1)最直觀的方法是直接實現(即一般的卷積運算) 缺點:這種實現呢需要處理許多的corner case。 文中介紹cuda-convnet2是實現了該種方法,該種方法在不同取值的卷積引數空間效

深度學習基礎--卷積計算和池化計算公式

卷積計算和池化計算公式 卷積 卷積計算中,()表示向下取整。 輸入:n* c0* w0* h0 輸出:n* c1* w1* h1 其中,c1就是引數中的num_output,生成的特徵圖個數。 w1=(w0+2pad-kernel_size)/stride+1;

深度學習基礎--卷積--一般的卷積運算

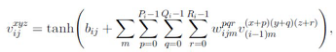

一般的卷積運算 O是輸出input feature map,F是filter, D0是input feature map。 從公式看到如果用迴圈操作,需要7次迴圈,n,k,p,q4次可獨立迴圈,c,r,s是累加操作的迴圈。

深度學習基礎(二)—— 從多層感知機(MLP)到卷積神經網路(CNN)

經典的多層感知機(Multi-Layer Perceptron)形式上是全連線(fully-connected)的鄰接網路(adjacent network)。 That is, every neuron in the network is connec

深度學習基礎--卷積--1*1的卷積核與全連線的區別

1*1的卷積核與全連線的區別 11的卷積核是輸入map大小不固定的;而全連線是固定的。 11卷積的主要作用有以下兩點: 1)降維( dimension reductionality ),inception中就是這個用。 2)加入非線性,畢竟有啟用

深度學習之 TensorFlow(四):卷積神經網絡

padding valid 叠代 val 分析 此外 nbsp drop BE 基礎概念: 卷積神經網絡(CNN):屬於人工神經網絡的一種,它的權值共享的網絡結構顯著降低了模型的復雜度,減少了權值的數量。卷積神經網絡不像傳統的識別算法一樣,需要對數據進行特征提取和數據重

[深度學習]Semantic Segmentation語義分割之空洞卷積DILATED CONVOLUTIONS(4)

論文全稱:《MULTI-SCALE CONTEXT AGGREGATION BY DILATED CONVOLUTIONS》 論文地址:https://arxiv.org/pdf/1511.07122v2.pdf 論文程式碼: python TensorFlow版本 https

吳恩達深度學習筆記(deeplearning.ai)之卷積神經網路(CNN)(上)

1. Padding 在卷積操作中,過濾器(又稱核)的大小通常為奇數,如3x3,5x5。這樣的好處有兩點: 在特徵圖(二維卷積)中就會存在一箇中心畫素點。有一箇中心畫素點會十分方便,便於指出過濾器的位置。 在沒有padding的情況下,經過卷積操作,輸出的資

深度學習進階(六)--CNN卷積神經網路除錯,錯誤歷程總結

總結一下今天的學習過程 (注:我此刻的心情與剛剛三分鐘前的心情是完全不一樣的) (昨天在想一些錯誤,今天又重拾信心重新配置GPU環境,結果很失敗,不過現在好了,在尋思著今天干了什麼的時候,無意間想到是不是自己方法入口不對啊。結果果然很幸運的被我猜到了,,,哈哈哈,我的心情又

深度學習方法(十二):卷積神經網路結構變化——Spatial Transformer Networks

歡迎轉載,轉載請註明:本文出自Bin的專欄blog.csdn.net/xbinworld。 技術交流QQ群:433250724,歡迎對演算法、機器學習技術感興趣的同學加入。 今天具體介紹一個Google DeepMind在15年提出的Spatial T

《深度學習入門之pythoch》 讀書筆記——卷積神經網路

之前就購買了這本書,但是一直處於閒看的狀態,時至年底,深感不能再繼續之前狀態,故從正在閱讀的部分開始寫讀書筆記,之前的會在後邊補充。 原理和結構 卷積神經網路以其強大的計算機視覺能力倍受人們的青睞。 作者首先提出了三個觀點,也就是圖片的三個性質,分別是

【深度學習】基於MatConvNet框架的CNN卷積層與特徵圖視覺化

【題目】 程式設計實現視覺化卷積神經網路的特徵圖,並探究影象變換(平移,旋轉,縮放等)對特徵圖的影響。選擇AlexNet等經典CNN網路的Pre-trained模型,視覺化每個卷積層的特徵圖(網路輸入圖片自行選擇)。其中,第一層全部視覺化,其餘層選

【深度學習理論】一文看懂卷積神經網路

本文主要介紹了神經網路中的卷積神經網路,適合初學者閱讀。概述深度學習和人工智慧是 2016 年的熱詞;2017 年,這兩個詞愈發火熱,但也更加容易混淆。我們將深入深度學習的核心,也就是神經網路。大多數神經網路的變體是難以理解的,並且它們的底層結構元件使得它們在理論上和圖形上是

【轉】深度學習基礎概念理解

器) 好處 網站 water weight tar 直觀 str view 原文鏈接 神經網絡基礎 1)神經元(Neuron)——就像形成我們大腦基本元素的神經元一樣,神經元形成神經網絡的基本結構。想象一下,當我們得到新信息時我們該怎麽做。當我們獲取信息時,我們一般會處

20180813視頻筆記 深度學習基礎上篇(1)之必備基礎知識點 深度學習基礎上篇(2)神經網絡模型視頻筆記:深度學習基礎上篇(3)神經網絡案例實戰 和 深度學習基礎下篇

計算 概念 人臉識別 大量 png 技巧 表現 lex github 深度學習基礎上篇(3)神經網絡案例實戰 https://www.bilibili.com/video/av27935126/?p=1 第一課:開發環境的配置 Anaconda的安裝 庫的安裝 Windo