淺談正則化

一、機器學習正則化

無論是機器學習還是深度學習,正則化都是一項關鍵的技術。其實現階段,我們的模型都可以在訓練集上去的比較好的效果,但我們的模型在測試集上的效果才是我們所關心的。因此正則化就顯得尤為重要,正則化可以防止模型過擬合,增加魯棒性。

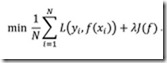

總的來說,監督學習的核心原理就是如下公式 :

該公式分為兩部分,前一項是經驗最小化,後一項為正則項。經驗最小化是為了極大程度的擬合訓練資料,正則項則是為了防止過分擬合訓練資料。機器學習中的正則項有L1正則和L2正則.

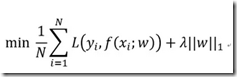

在聊這兩個正則前,我們先說說L0正則。L0正則也就是矩陣中所有非0元素的個數,對於L0正則的理解就是希望引數矩陣W的大多數元素都為0,這樣正則項就會很小。此時,可能會有人會說L1正則不就是在幹這個事嗎?這裡面的原理,扯就一大堆,簡答說:在機器學習中,L0和L1正則都可以實現矩陣的稀疏性,但在實踐中,L1的泛化求解特徵更好一些,所以人們大多使用L1正則而不是用L0正則。對於L1正則而言,L1正規化就是矩陣中各個元素絕對值之和。至於為啥稀疏,稀疏的作用,主要是為了特徵的選擇和易於解釋模型.

相關推薦

淺談正則化

一、機器學習正則化 無論是機器學習還是深度學習,正則化都是一項關鍵的技術。其實現階段,我們的模型都可以在訓練集上去的比較好的效果,但我們的模型在測試集上的效果才是我們所關心的。因此正則化就顯得尤為重要,正則化可以防止模型過擬合,增加魯棒性。 &nb

淺談正則表達式

關鍵字 dex a-z abc regexp 下標 style clas div 正則表達式 1.正則表達式的聲明: (1)字面量聲明: /正則表達式規則/匹配模式 var reg = /^abc$/i (2)new關鍵字聲明: var reg = new Re

淺談正則表示式(Regular Expression)

POSIX 類 perl類 描述----------------------------------------------------------------------------[:alnum:] 字母和數字[:alpha:] \a 字母[:lower:] \l 小寫字母[:upper:] \u 大寫字

淺談正則表達式一

導入 匹配 括號 .com 位置 obj eating www. 貪婪 ‘‘‘ 正則表達式作用:判斷一個字符串是否匹配給定的格式:例如判斷用戶註冊賬號是否滿足格式,抓取頁面鏈接等。 ‘‘‘ import re #使用正則表達式需要導入re模塊 st = "[

淺議過擬合現象(overfitting)以及正則化技術原理

1. 過擬合(overfitting)簡介 0x1:假設空間(hypothesis space) 給定學習演算法 A,它所考慮的所有可能概念的集合稱為假設空間,用符號 H 表示。對於假設空間中的任一概念,我們用符號 h 表示,由於並不能確定它是否真是目標概念,因此稱為“假設”(hypothesis) 1

正則化筆記

等等 平滑 等價 算子 稀疏 比較 orm 數據 解釋 吉譜斯現象Gibbs(又叫吉譜斯效應): 用有限項傅裏葉級數表示有間斷點的信號時,在間斷點附近不可避免的會出現振蕩和超量。超量的幅度不會隨所取項數的增加而減小。只是隨著項數的增多,振蕩頻率變高,並向間斷點處壓縮

[轉] [機器學習] 常用數據標準化(正則化)的方法

機器學習 數據 評價 分享 函數 http mean 常用方法 訓練 數據正則化 目的:為了加快訓練網絡的收斂性,可以不進行歸一化處理 源地址:http://blog.sina.com.cn/s/blog_8808cae20102vg53.html 而在多指標評價體系中,

【轉】正則化相關鏈接

blog class bsp src rop 折疊 img detail link 正則化,歸一化的概念 基於Matlab介紹正則化方法 正則化方法:L1和L2 regularization、數據集擴增、dropout 基於Matlab介紹機器學習中的正則化,理解

簡單解釋一下正則化

等高線 稀疏 相交 出現 貝葉斯 最優 他還 lac 分享 解釋之前,先說明這樣做的目的:如果一個模型我們只打算對現有數據用一次就不再用了,那麽正則化沒必要了,因為我們沒打算在將來他還有用,正則化的目的是為了讓模型的生命更長久,把它扔到現實的數據海洋中活得好,活得久。

正則化

-- ini 泛化 cati 可能 深度 not 增加 algo 在深度學習中,許多策略可以減少測試誤差,可能以增加訓練誤差為代價,這些策略統一稱為正則化。 在《deep learning》中,正則化被定義為 ‘any modification we make to

Regularized least-squares classification(正則化最小二乘法分類器)取代SVM

得出 ack 提高 kernel sys 風險 重要 ref height 在機器學習或者是模式識別其中有一種重要的分類器叫做:SVM 。這個被廣泛的應用於各個領域。可是其計算的復雜度以及訓練的速度是制約其在實時的計算機應用的主要原因。因此也非常非常多的算法

邏輯回歸的正則化

正則 .com logistic 可能 cnblogs 技術 技術分享 img 規範 我們可以規範logistic回歸以類似的方式,我們對線性回歸。作為一個結果,我們可以避免過擬合。下面的圖像顯示了正則化函數,用粉紅色的線顯示出來,是不太可能過度擬合非正則的藍線表示功能:

9月5日 正則化總結筆記

cnblogs 學習 bsp 正常 講解 總結筆記 擬合 線性 預測 ---恢復內容開始--- 學習正則化 一下知識需要全部掌握: 1.線性回歸 2.邏輯回歸 接下來的筆記中,將假設上面的基礎知識全部掌握的程度講解: 學習 正則化 首先 我們需要知道為什麽學習正

改善深層神經網絡:超參數調試、正則化及優化

正則 ria 左右 訓練 訓練集 第一周 1.3 實驗 必須 第一周 深度學習的實用層面 1.1 訓練、驗證、測試集 應用機器學習是個高度叠代的過程:想法--->編碼--->實驗 (1)神經網絡的層數 (2)隱含層神經元個數 (3)學習率 (4)激勵函數

stacked generalization 堆積正則化 堆積泛化 加權特征線性堆積

models tun min use ren bag rec team features https://en.wikipedia.org/wiki/Ensemble_learning Stacking Stacking (sometimes called stacke

機器學習中的正則化

道理 lazy 算法 htbox 而且 有趣的 文章 很難 直接 作者:陶輕松鏈接:https://www.zhihu.com/question/20924039/answer/131421690來源:知乎著作權歸作者所有。商業轉載請聯系作者獲得授權,非商業轉載請註明出處。

吳恩達-深度學習-課程筆記-8: 超參數調試、Batch正則化和softmax( Week 3 )

erp 搜索 給定 via 深度 mode any .com sim 1 調試處理( tuning process ) 如下圖所示,ng認為學習速率α是需要調試的最重要的超參數。 其次重要的是momentum算法的β參數(一般設為0.9),隱藏單元數和mini-batch的

TensorFlow 過擬合與正則化(regularizer)

sdn 就是 one 方式 regular logs none 使用 log 所謂過擬合,就是當一個模型過於復雜後,它可以很好的處理訓練數據的每一個數據,甚至包括其中的隨機噪點。而沒有總結訓練數據中趨勢。使得在應對未知數據時錯誤裏一下變得很大。這明顯不是我們要的結果。 我們

斯坦福大學公開課機器學習: advice for applying machine learning | regularization and bais/variance(機器學習中方差和偏差如何相互影響、以及和算法的正則化之間的相互關系)

交叉 來講 相對 同時 test 如果 開始 遞增 相互 算法正則化可以有效地防止過擬合, 但正則化跟算法的偏差和方差又有什麽關系呢?下面主要討論一下方差和偏差兩者之間是如何相互影響的、以及和算法的正則化之間的相互關系 假如我們要對高階的多項式進行擬合,為了防止過擬合現象

ng機器學習視頻筆記(五) ——過擬合與正則化

哪些 重復 關註 osi 現實 regular 鏈接 梯度下降 簡單 ng機器學習視頻筆記(五) ——過擬合與正則化 (轉載請附上本文鏈接——linhxx) 一、過擬合和欠擬合 1、概念 當針對樣本集和特征值,進行預測的時候,推導θ、梯度下降等,都在