DL之RNN:基於TF利用RNN實現簡單的序列資料型別(DIY序列資料集)的二分類(線性序列&隨機序列)

DL之RNN:基於TF利用RNN實現簡單的序列資料型別(DIY序列資料集)的二分類(線性序列&隨機序列)

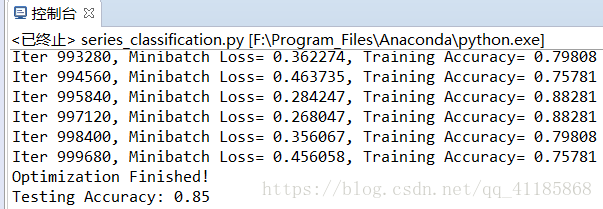

輸出結果

1、test01:training_iters = 1000000

| (32, 20, 1) [[0.336], [0.337], [0.338], [0.339], [0.34], [0.341], [0.342], [0.343], [0.344], [0.345], [0.0], [0.0], [0.0], [0.0], [0.0], [0.0], [0.0], [0.0], [0.0], [0.0]] (32, 2) [1.0, 0.0] (32,) 10 |

|

2、test02:training_iters = 2000000

設計思路

實現程式碼

資料集序列型別

相關推薦

DL之RNN:基於TF利用RNN實現簡單的序列資料型別(DIY序列資料集)的二分類(線性序列&隨機序列)

DL之RNN:基於TF利用RNN實現簡單的序列資料型別(DIY序列資料集)的二分類(線性序列&隨機序列) 序列資料型別&輸出結果 1、test01:training_iters = 1000000 (32, 20, 1) [[0.336], [

DL之RNN:基於TF利用RNN演算法實現~機器為你寫詩~、訓練&測試過程全記錄

DL之RNN:基於TF利用RNN演算法實現~機器為你寫詩~、測試過程全記錄 輸出結果 模型監控 訓練、測試過程全記錄 1、訓練過程 2018-10-13 18:17:33.385001: step: 10/10000... loss: 6.6

DL之RNN:基於TF利用RNN實現簡單的序列資料型別(DIY序列資料集)的二分類(線性序列&隨機序列)

DL之RNN:基於TF利用RNN實現簡單的序列資料型別(DIY序列資料集)的二分類(線性序列&隨機序列) 輸出結果 1、test01:training_iters = 1000000 (3

DL之LSTM之UvP:基於TF利用LSTM基於DIY時間訓練1200個數據預測後200個數據狀態

DL之LSTM之UvP:基於TF利用LSTM基於DIY時間訓練1200個數據預測後200個數據狀態 輸出結果 設計思路 訓練記錄全過程 INFO:tensorflow:loss = 0.496935, step = 1 INFO:t

TF之NN:基於TF利用NN演算法實現根據三個自變數預測一個因變數的迴歸問題

TF之NN:基於TF利用NN演算法實現根據三個自變數預測一個因變數的迴歸問題 實驗資料 說明:利用前四年的資料建立迴歸模型,並對第五年進行預測。 輸出結果 loss is: 913.6623 loss is: 781206160000.0

TF之DCGAN:基於TF利用DCGAN測試自己的資料集並進行生成過程全記錄

訓練的資料集部分圖片 以從網上收集了許多日式動畫為例 訓練過程全記錄 開始訓練…… {'batch_size': <absl.flags._flag.Flag object at 0x000002C943CD16A0>, 'beta1':

DL之RNN:人工智慧為你寫歌詞(林夕寫給陳奕迅)——基於TF利用RNN演算法實現【機器為你作詞】、訓練&測試過程全記錄

DL之RNN:人工智慧為你寫歌詞(林夕寫給陳奕迅)——基於TF利用RNN演算法實現【機器為你作詞】、訓練&測試過程全記錄 輸出結果 1、test01 你的揹包 一個人過我 誰不屬了 不甘心 不能回頭 我的揹包載管這個 誰讓我們是要不可 但求跟你過一生 你把我灌醉 即使嘴角

DL之RNN:人工智慧為你寫周董歌詞——基於TF利用RNN演算法實現【機器為你作詞】、訓練&測試過程全記錄

DL之RNN:人工智慧為你寫周董歌詞——基於TF利用RNN演算法實現~機器為你作詞~、訓練&測試過程全記錄 輸出結果 1、test01 夕海 而我在等待之光 在月前被畫面 而我心碎 你的個世紀 你的時間 我在趕過去 我的不是你不會感覺媽媽 我說不要不要說 我會愛你 我不要你不

DL之RNN:人工智慧為你寫歌詞(林夕寫給陳奕迅)——基於TF利用RNN演算法實現【機器為你作詞】、訓練&測試過程全記錄

DL之RNN:人工智慧為你寫歌詞(林夕寫給陳奕迅)——基於TF利用RNN演算法實現【機器為你作詞】、訓練&測試過程全記錄 輸出結果 1、test01 你的揹包 一個人過我 誰不屬了 不甘心 不能回頭 我的揹包載管這個 誰讓我們是要不可 但求跟你過一生 你把我

NLP之WE之Skip-Gram:基於TF利用Skip-Gram模型實現詞嵌入並進行視覺化、過程全記錄

NLP之WE之Skip-Gram:基於TF利用Skip-Gram模型實現詞嵌入並進行視覺化 輸出結果 程式碼設計思路 程式碼執行過程全記錄 3081 originated -> 12 as 3081 originated

Matlab之DNN:基於Matlab利用神經網路模型(epochs=10000000)預測勒布朗詹姆斯的2018年總決賽(騎士VS勇士)第一場得分、籃板、助攻

預測勒布朗詹姆斯的2018年NBA總決賽(騎士VS勇士)第一場得分數(33.6667)預測勒布朗詹姆斯的2018年NBA總決賽(騎士VS勇士)第一場籃板數(8.7333)預測勒布朗詹姆斯的2018年NB

DL之Attention-ED:基於TF NMT利用帶有Attention的 ED模型訓練、測試(中英文平行語料庫)實現將英文翻譯為中文的LSTM翻譯模型過程全記錄

DL之Attention-ED:基於TF NMT利用帶有Attention的 ED模型訓練(中英文平行語料庫)實現將英文翻譯為中文的LSTM翻譯模型過程全記錄 測試輸出結果 模型監控 1、SCALARS clipp

DL之BigGAN:利用BigGAN演算法實現超強炸天效果——畫風的確skr、skr、skr,太特麼的skr了

文章推薦Paper之BigGAN:ICLR 2019最新論文《LARGE SCALE GAN TRAINING FOR HIGH FIDELITY NATURAL IMAGE SYNTHESIS》論文研究中 本博主剛剛利用程式碼進行測試, 結果:的確吊(不)炸(可)天(思議)! PS:B

ML之SVM:基於Js程式碼利用SVM演算法的實現根據Kaggle資料集預測泰坦尼克號生存人員

ML之SVM:基於Js程式碼利用SVM演算法的實現根據Kaggle資料集預測泰坦尼克號生存人員 實驗資料 設計思路 實現程式碼(部分程式碼) /** js程式碼實現SVM演算法 */ //ML之SVM:基於Js程式碼利用SVM演算法的實現根據Kagg

DL之perceptron:利用perceptron感知機對股票實現預測

DL之perceptron:利用perceptron感知機對股票實現預測 import numpy as np import operator import os # create a dataset which contains 3 samples with 2 classes def

Keras之DNN:基於Keras(sigmoid+binary_crossentropy+predict_proba)利用DNN實現分類預測概率——DIY二分類資料集&預測新資料點

#Keras之DNN:基於Keras(sigmoid+binary_crossentropy+predict_proba)利用DNN實現分類預測概率——DIY二分類資料集&預測新資料點 輸出結果 實現程式碼 # coding:utf-8 #Ke

Keras之DNN:基於Keras(sigmoid+linear+mse+predict)利用DNN實現迴歸預測——DIY多分類資料集&預測新資料點

Keras之DNN:基於Keras(sigmoid+linear+mse+predict)利用DNN實現迴歸預測——DIY多分類資料集&預測新資料點 輸出結果 實現程式碼 # coding:utf-8 Xa=[] Xb=[] for i in ra

DL之NN:(sklearn自帶資料集為1797個樣本*64個特徵)利用NN之sklearn、NeuralNetwor.py實現手寫數字圖片識別95%準確率

先檢視sklearn自帶digits手寫資料集(1797*64)import numpy as np from sklearn.datasets import load_digits from skl

APP精細化運營之道:基於數據的“用戶+推送”

APP APP精細化運營之道:基於數據的“用戶+推送” 市面上可供選擇的APP太多,喜新厭舊又是很多人的本性,你的APP想要從同類型產品中脫穎而出,俘獲用戶的芳心,似乎並不是一件容易的事情。為了讓你的目標用戶下載它、註冊它、使用它甚至忠於它,這裏有一個極佳的手段——以數據為驅動的精細化運營。

PID控制器開發筆記之九:基於前饋補償的PID控制器的實現

傳遞 了解 都沒有 控制 結構體 控制器 基本 跟蹤 模型 對於一般的時滯系統來說,設定值的變動會產生較大的滯後才能反映在被控變量上,從而產生合理的調節。而前饋控制系統是根據擾動或給定值的變化按補償原理來工作的控制系統,其特點是當擾動產生後,被控變量還未變化以前,根據擾