機器學習評估指標:Precision、recall、F-measure、Accuracy、ROC曲線和AUC

在使用機器學習演算法的過程中,我們需要對建立的模型進行評估來辨別模型的優劣,下文中主要介紹我在學習中經常遇見的幾種評估指標。以下指標都是對分類問題的評估指標。

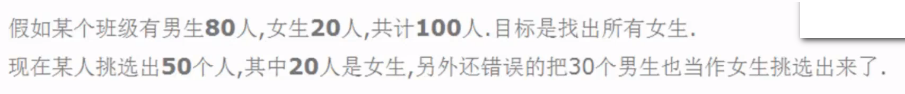

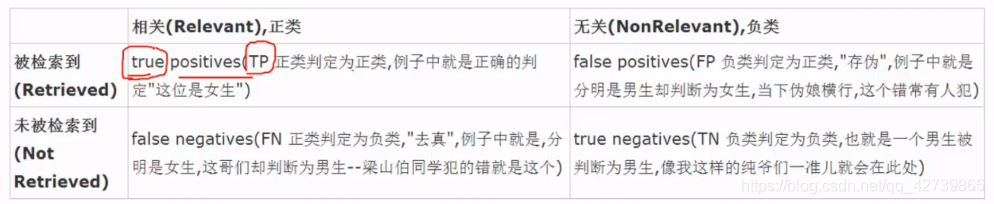

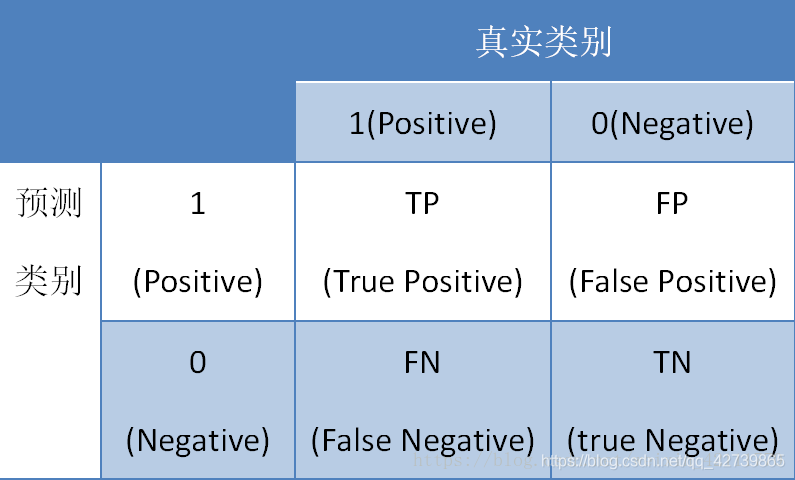

將標有正負例的資料集餵給模型後,一般能夠得到下面四種情況:

- True Positive(TP),模型將正例項判定為正類

- False Negative(FN),模型將正例項判定為負類

- False Positive(FP), 模型將負例項判定位正類

- True Negative(TN),模型將負例項判定位負類

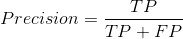

精度(Precision):精度是針對判定結果而言,預測為正類的樣本(TP+FP)中真正是正例項(TP)的比率:

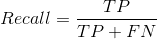

召回率(Recall):召回率是針對樣本而言,被正確判定的正例項(TP)在總的正例項中(TP+FN)的比率:

精度和召回率雖然沒有必然的關係,然而在大規模資料集合中,這兩個指標卻是相互制約的。一般情況下,召回率高時,精度低;精度高時,召回率低。

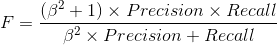

F-measure是精度(Precision)和召回率(Recall)的加權調和平均

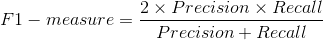

當時,就是常見的F1-measure:

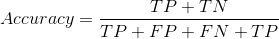

準確率(Accuracy):模型正確分類的樣本數(正例項被判定為正類,負例項被判定為負例)在總樣本中的比重

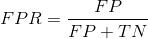

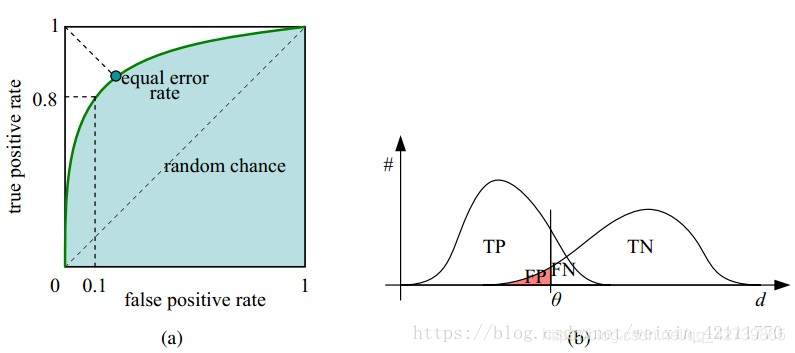

ROC曲線(受試者工作特徵曲線 receiver operating characteristic curve),是以假正性率(False positive rate,FPR)為橫軸,真正類率(True positive rate,TPR)為縱軸所組成的座標圖,和受試者在特定刺激條件下由於採用不同的判斷標準得出的不同結果畫出的曲線。ROC曲線在測試集中的正負樣本的分佈變化時,能夠保持不變。

真正類率,為被模型判定為正類的正例項在樣本中正例項中的比例

真正類率,為被模型判定為正類的正例項在樣本中正例項中的比例

假正類率,為被模型判定為正類的負例項在樣本中負例項中的比例

假正類率,為被模型判定為正類的負例項在樣本中負例項中的比例

ROC曲線上的每個點對是在某個閾值threshold下得到的(FPR, TPR)。設定一個閾值,大於這個閾值的例項被劃分為正例項,小於這個值的例項則被劃分為負例項,執行模型,得出結果,計算FPR和TPR值,更換閾值,迴圈操作,就得到不同閾值下的(FPR, TPR)對,即能繪製成ROC曲線。

AUC(Area Under Curve)是ROC曲線下的面積值,在0.5到1.0區間內。之所以使用AUC值作為評價標準是因為很多時候並不能從ROC曲線中判別模型的好壞,AUC值能量化模型的效能效果。AUC值越接近於1,說明模型效能越好,模型預測的準確率越高;如果多個模型進行效能比較,一般以AUC值大的模型比AUC值小的模型的效能好。