強化學習初步總結

阿新 • • 發佈:2018-12-17

強化學習基礎

1. 定義:

- 智慧體(agent)

- 環境(environment)

- 狀態s

- 動作a

- 策略 π(a|s),確定性策略是從狀態空間到動作空間的對映函式 π : S → A。隨機性策略 表示在給定環境狀態時,智慧體選擇某個動作的概率分佈。

- 狀態轉移概率 p(s′ |s, a)

- 即時獎勵 r(s, a, s′ )

2. 馬爾可夫決策過程

馬爾可夫過程 (Markov Process)是具有馬爾可夫性的隨機變數序列,其下一個時刻的狀態只取決於當前的狀態。

馬爾可夫決策過程(Markov Decision Process,MDP)在馬爾可夫過程中加入一個額外的變數:動作 a,即下一個時刻的狀態和當前時刻的狀態以及動作相關,

3.強化學習的目標函式

總回報:有終止狀態,無終止狀態

目標函式:最大化期望回報

4. 值函式

狀態值函式

狀態動作值函式:指初始狀態為 s 並進行動作 a,然後執行策略 π 得到的期望總回報

貝爾曼方程:表示當前值函式可由下一值函式來計算

5. 深度強化學習

用深度學習來解決策略和值函式的建模問題

基於值函式的學習方法

策略有限是可對所有策略評估,選出最優策略,現實很難滿足

1. 動態規劃演算法(model-based)

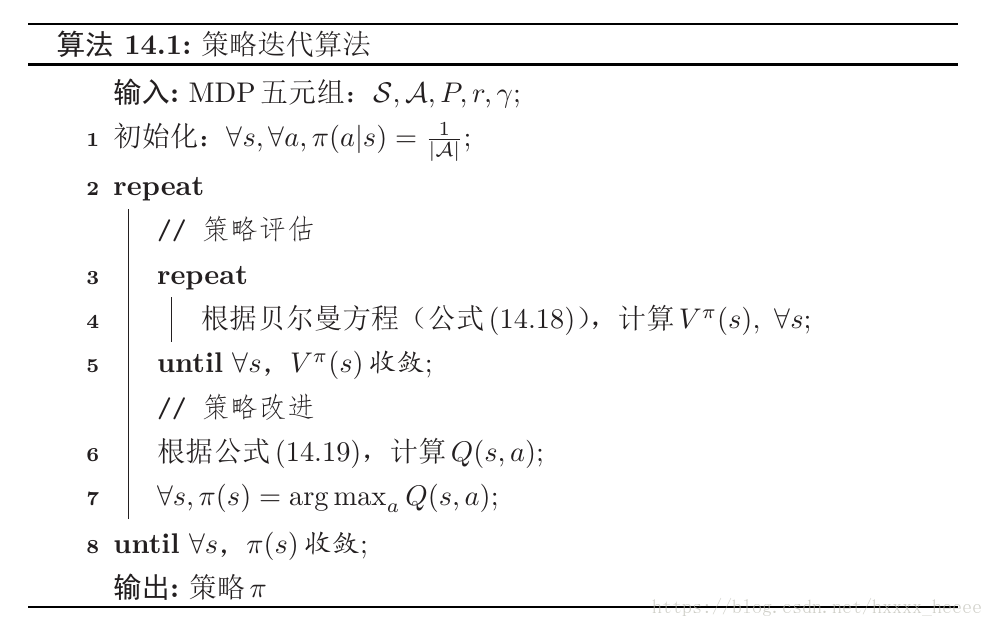

- 策略迭代

- 值迭代

2. model-free

2.1 蒙特卡羅

同策略、異策略,西瓜書p384

2.2 時序差分(TD)

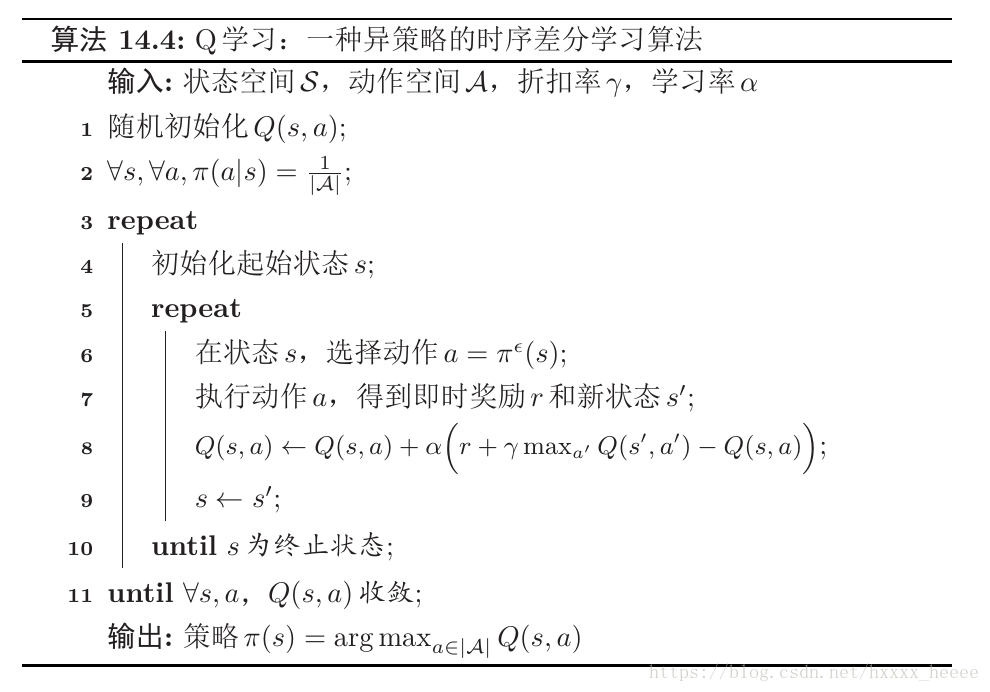

- Q學習

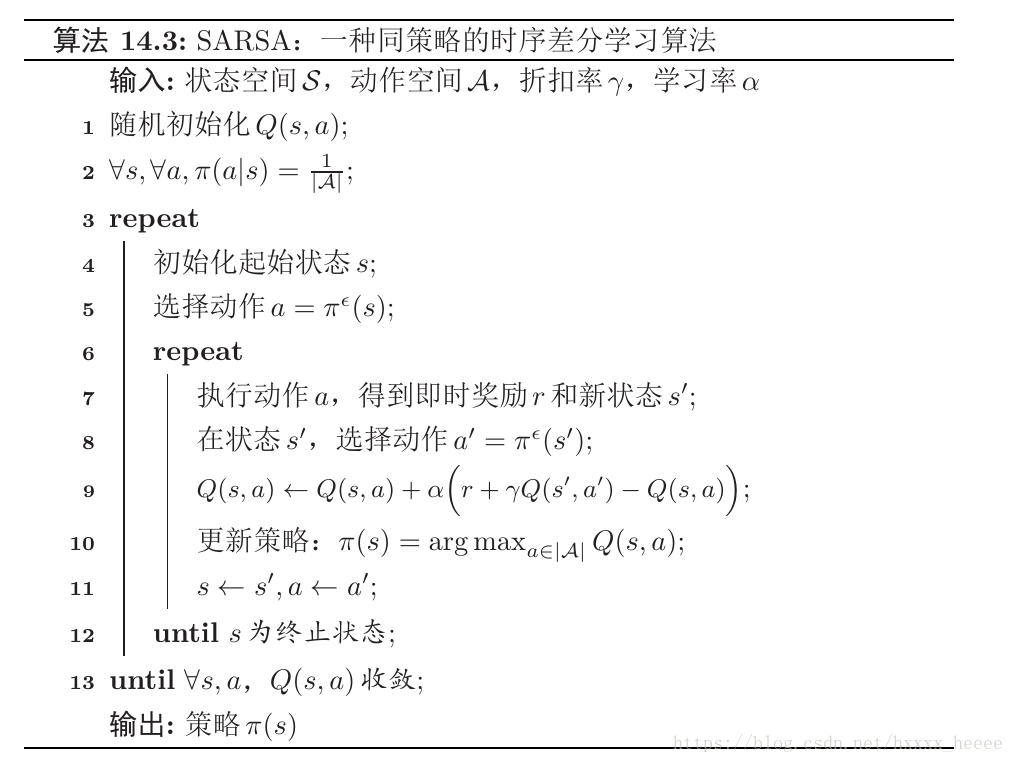

- SARSA