安裝Spark叢集(簡述)

阿新 • • 發佈:2018-12-18

前提:

已經安裝好hadoop叢集和zookeeper,功能正常

1.上傳安裝包(所有節點)(略)

2.解壓(略)

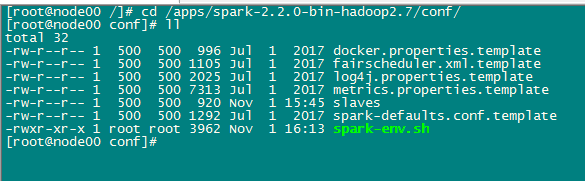

3.修改配置檔案

cd /apps/spark-2.2.0-bin-hadoop2.7/conf/ 1. vi spark-env.sh #在裡面加入jdk和zk地址 export JAVA_HOME=/usr/java/jdk1.8.0_191 export SPARK_DAEMON_JAVA_OPTS="-Dspark.deploy.recoveryMode=ZOOKEEPER -Dspark.deploy.zookeeper.url=node00:2181,node01:2181,node02:2181,node03:2181,node04:2181,node05:2181,node06:2181 -Dspark.deploy.zookeeper.dir=/spark" 2. vi slaves #在裡面新增叢集的節點,localhost可注 node00 node01 node02 node03 node04 node05 node06

4. 啟動叢集

#啟動所有的節點

/apps/spark-2.2.0-bin-hadoop2.7/sbin/start-all.sh

#另外啟動一個mater

/apps/spark-2.2.0-bin-hadoop2.7/sbin/start-master.sh 5. 測試

1. 登入瀏覽器檢視叢集是否全部啟動或者有其他異常 http://node00:8080/ 2. 官方測試用例 /apps/spark-2.2.0-bin-hadoop2.7/spark-submit --class org.apache.spark.examples.SparkPi --master spark://node00:7077 --executor-memory 8G --total-executor-cores 8 /apps/spark-2.2.0-bin-hadoop2.7/examples/jars/spark-examples_2.11-2.2.0.jar 1000 這時候檢視瀏覽器上是否有正在執行的sparkPi任務等