Spark叢集安裝搭建

阿新 • • 發佈:2018-11-10

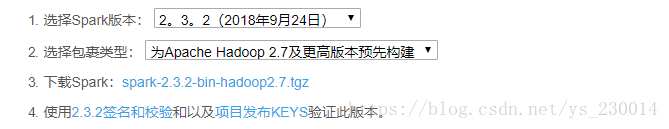

1.下載Spark

Spark是一個獨立的記憶體計算框架,如果不考慮儲存的話,可以完全獨立執行,因此這裡就只安裝Spark叢集

Spark下載地址: http://spark.apache.org/downloads.html

選擇好Spark和Hadoop的版本之後就可以下載了,從2.0版本開始,Spark預設使用Scala2.11

2.上傳解壓

將Spark的壓縮包上傳到叢集的某一臺機器上,然後解壓縮

3.進行Spark的配置檔案的配置

進入到Spark的目錄下

cd conf mv spark-env.sh.template spark-env.sh vi spark-env.sh

在該配置檔案中新增如下配置

export JAVA_HOME=你的jdk所在目錄配置slaves檔案

mv slaves.template slaves

vi slaves在slaves中新增你的Spark叢集子節點機器的主機名或者ip

4.將配置好的Spark傳輸到叢集的其他機器上

使用scp命令,如果叢集機器特別多的話,可以使用shell程式設計來迴圈自動傳輸,這裡不在詳細說明

5.啟動Spark

進入到Spark的主目錄下

sbin/start-all.sh使用jps命令可以看出,該Spark叢集有一個Master,三個Work

Spark叢集的WEBUI介面: Master所在的主機ip:8080