Hadoop叢集簡單搭建

阿新 • • 發佈:2018-12-22

修改主機名稱

vim /etc/sysconfig/network

內容:HOSTNAME=master

分別修改其他主機HOSTNAME

修改hosts檔案

- vim /etc/hosts

- 寫入mater,slave1,slave2,。。。格式為 ip name 如:192.168.202.10 master

scp /etc/hosts slave1:/etc/hosts將檔案分別複製到從機中

主從免密登入

- 主節點 通過 ssh-keygen 回車。。。直到生成檔案

- cd ~/.ssh

- 寫入檔案:

cat id_rsa.pub > authorized_keys - 從節點 ssh-keygen生成檔案

- cd ~/.ssh

- cat id_rsa.pub 將顯示出的內容複製到主節點的authorized_keys中

- 全部複製完畢後,在主節點的.ssh目錄下執行**scp authorized_keys slave1:~/.ssh/**複製到所有從節點中

- 驗證 ssh slave1直接進入從機說明操作成功

Hadoop安裝(1.0+和2.0+版本上有很多區別)

-

保證Java環境正常

-

Hadoop下載地址 選擇穩定發行版,當前選擇2.7.7

-

下載上傳到CentOS中,tar -zxvf xxxx解壓

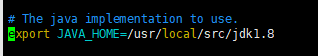

修改/hadoop-2.7.7/etc/hadoop/hadoop-env.sh

將其中的JAVA_HOME修改為本機JAVA_HOME路徑

修改hadoop/core-site.xml

hadoop 安裝目錄mkdir tmp建立臨時資料夾

vim /etc/hadoop/core-site.xml

<property> <name>hadoop.tmp.dir</name> <value>/usr/local/src/hadoop-2.7.7/tmp</value> </property> <property> <name>fs.default.name</name> <value>hdfs://192.168.202.10:9000</value> </property>

修改hadoop/mapred-site.xml

如果沒有通過cp複製一份template檔案並去掉template

開啟mapred-site.xml

<property>

<name>mapred.job.tracker</name>

<value>http://192.168.202.10:9001</value>

</property>

修改hadoop/hdfs-site.xml

配置hdfs副本數,預設3

<property>

<name>dfs.replication</name>

<value>3</value>

</property>

複製hadoop到其他從機

scp -rp xxx slave1:/hadoop 存放路徑

禁用CentOS7防火牆

systemctl stop firewalld.service 停止防火牆程序

systemctl disable firewalld.service 禁止開機啟動

關閉selinux setenforce 0

啟動Hadoop

第一次啟動需要格式化

進入bin目錄

格式化 ./hdfs namenode -format

進入sbin目錄

啟動 ./start-all.sh

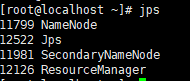

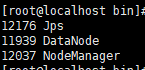

jps檢視主從節點

主節點

從節點

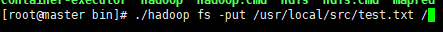

檢驗是否成功

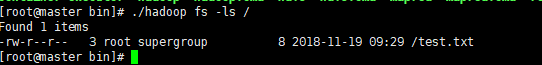

進入bin目錄

./hadoop fs -put 任意檔案 /

無報錯說明上傳成功

./hadoop fs -ls /

此時應該打印出剛才上傳的檔案

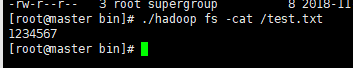

./hadoop fs -cat /test.txt

檢視檔案內容是我們上傳的

進入從節點執行檢視命令,應該可以看到我們剛才上傳的檔案