Andrew Ng's Coursera Machine Leaning(ML) Notes Week 4

Andrew Ng’s Coursera Machine Leaning(ML) Notes Week 4

Author: Yu-Shih Chen

December 22, 2018 6:55 PM

Intro:

本人目前是在加州上大學的大二生,對人工智慧和資料科學有濃厚的興趣所以在上學校的課的同時也喜歡上一些網課。主要目的是希望能夠通過在這個平臺上分享自己的筆記來達到自己更好的學習/複習效果所以notes可能會有點亂,有些我認為我自己不需要再複習的內容我也不會重複。當然,如果你也在上這門網課,然後剛好看到了我的notes,又剛好覺得我的notes可能對你有點用,那我也會很開心哈哈!有任何問題或建議OR單純的想交流OR單純想做朋友的話可以加我的微信:y802088

Week3

Note:Neural Network說實話本人還不是特別瞭解,所以以後可能還會繼續加內容。

大綱:

- Model Representation I

- Model Representation II

- Examples and Intuitions I

- Examples and Intuitions II

- Multiclass Classification

Model Repersentaion

這個section簡單的介紹了一下neural network的構造,表達方式和idea。

跟之前一樣,我們需要X,y,和h_x也就是我們的預測值,但是這裡就好像得到我們的h_x之前要先穿過幾層“篩選”一樣。

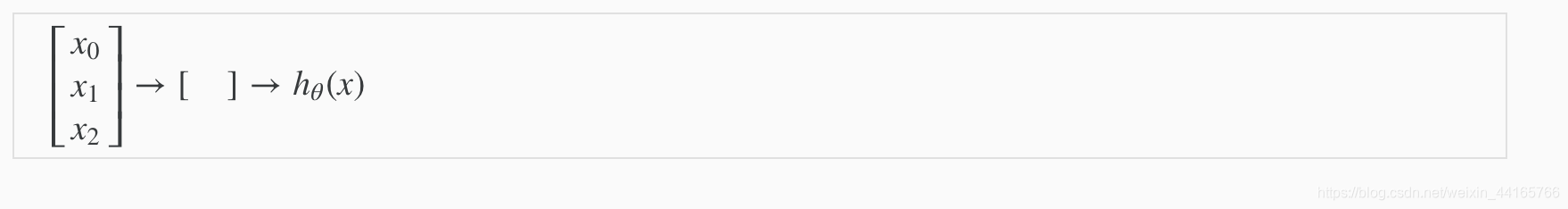

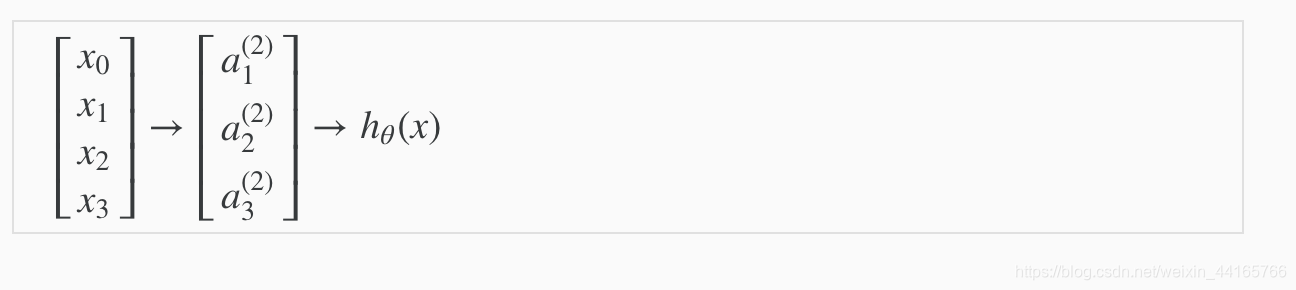

如圖:

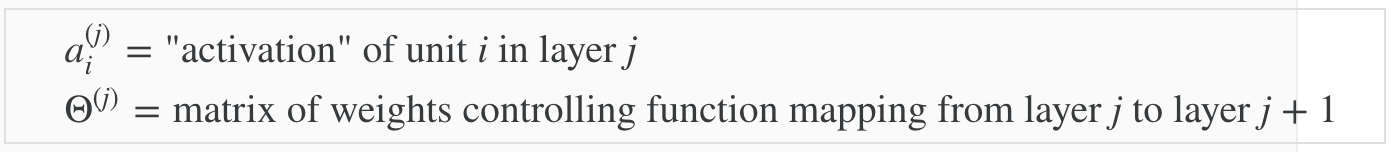

以下是這個課程用的一些notation

如圖所示,現在我們每一層都會有不同的theta,每過一層

需要注意的一點:每一層的theta的大小可以用一個公式得到:

- 當前層nodes數量= sj

- 下一層nodes數量=s(j+1)

- 當前層theta大小= s(j+1) x (sj + 1)

- 舉個栗子:如果第一層有2個input nodes,然後第二層有4個activation nodes,那第一層的theta = 4 x

(2+1) = 4x3

這個很重要,因為要使用這個去 initialize我們的theta。

section重點:Neural Network就像一層層等的篩選一樣,得到最後的h_x。

how did we choose weights? Theta1 and Theta 2

Model Representation II

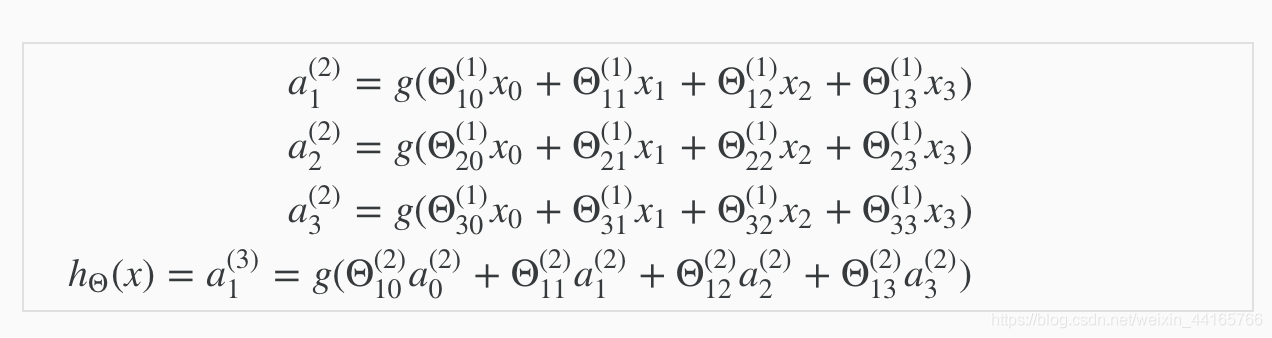

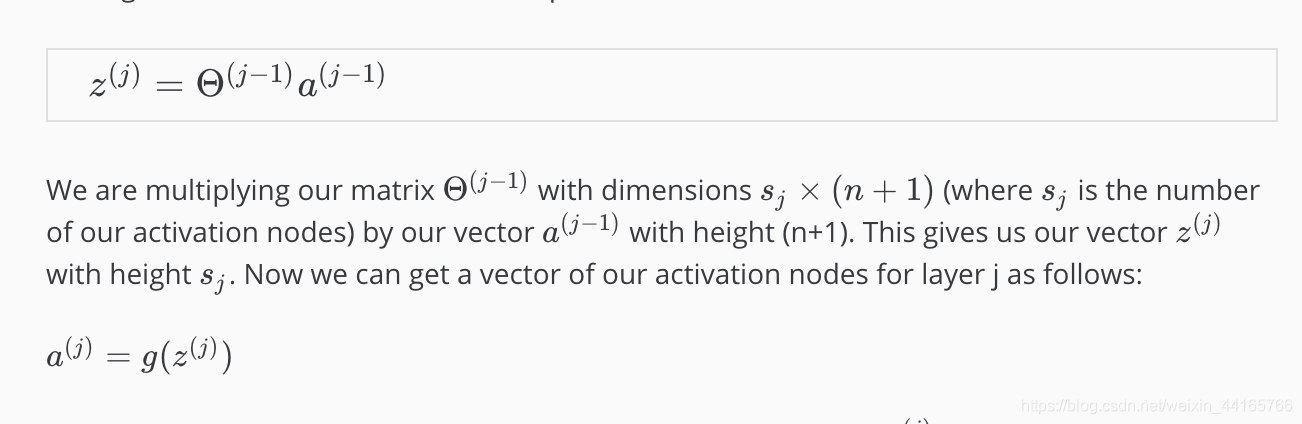

這個section會講到如何去用第一層的X和theta去推算剩下的層的activation unit。

基本上就是用第一層的X和theta得到我們圖裡寫的’z’,然後記得要放到sigmoid裡,就可以得到下一層的’a’了,然後再用第二層的a和第二層的theta得到z,然後sigmoid,然後blahblahblah…最後就會得到一個數值。

section重點:每層的’a’ 或者說’X’的推算方法。

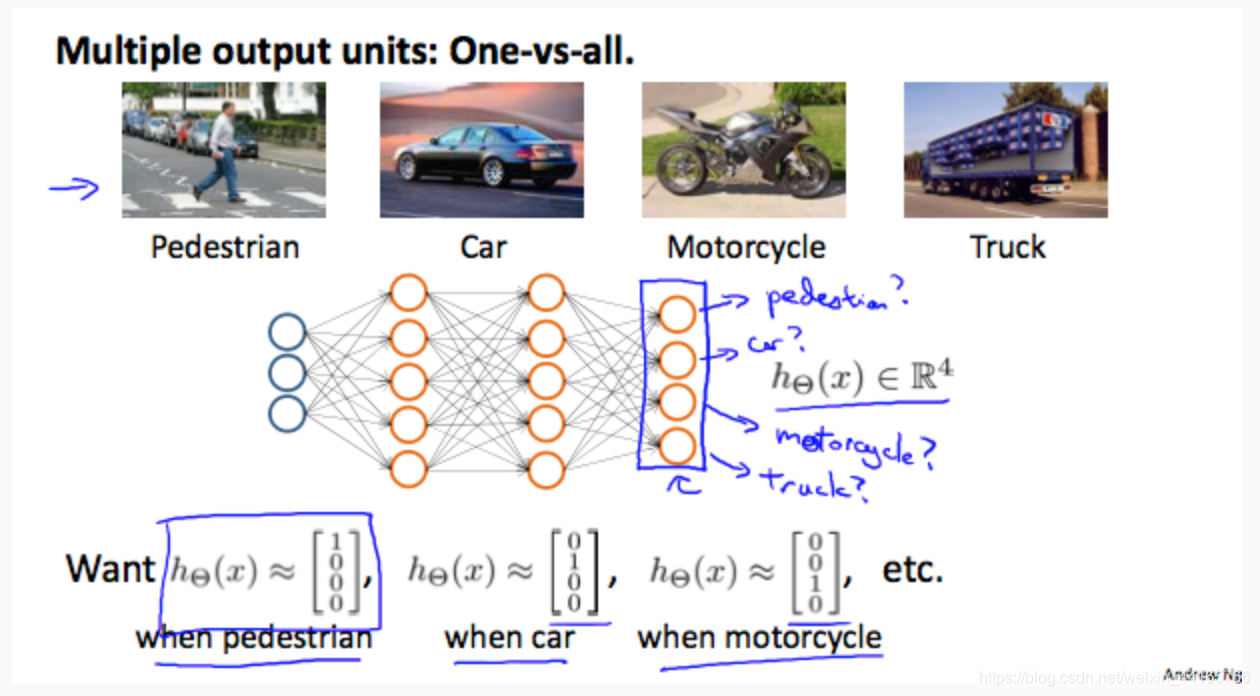

Multiclass Classification

這是一個Object Detection的例子。通過neural network和One-vs-all algorithm,可以達到multiclass的hypothesis。

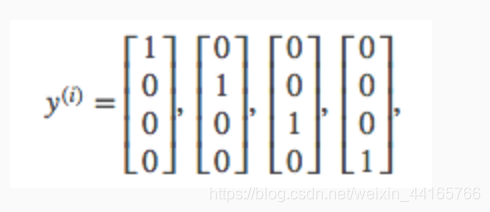

Implementation Notes:

在implement的時候,要將我們的y做成這樣的vectors來代表y = 1,2,3,4…

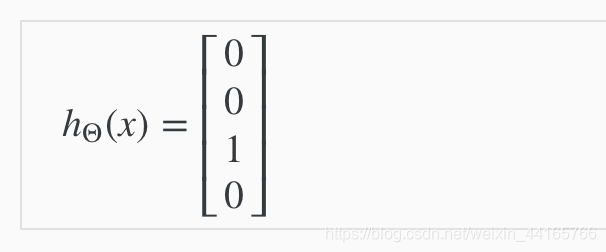

最後得到的結果可能是:

也就是這次predict的是object y = 3。