李航《統計學習方法》第一章 機器學習三要素

chapter1 統計學習方法概論

統計學習三要素

model 模型

假設空間 決策函式的集合 f={f|Y=f(X)}

引數空間 /theta

strategy 策略:

1)如何選擇模型?考量:

i.損失函式

e.g.如果是Square loss,那就是最小二乘了;如果是Hinge Loss,那就是著名的SVM了;如果是exp-Loss,那就是牛逼的 Boosting了;如果是log-Loss,那就是Logistic Regression了;還有等等。不同的loss函式,具有不同的擬合特性

ii.風險函式: 損失函式的期望

學習的目標是選擇期望風險最小的模型,而一般用經驗風險(樣本集的平均損失)來估計期望風險

2)監督學習常用的兩種策略:

i.經驗風險最小化:選擇經驗風險最小的模型

e.g.模型是條件概率分佈,損失函式是對數損失函式,模型複雜度由模型的先驗概率表示時,結構風險最小化就等價於最大後驗概率分佈

ii.結構風險最小化:引入正則化項/懲罰項,防止過擬合

e.g.模型是條件概率分佈,損失函式是對數損失函式時,經驗風險最小化等價於極大似然估計

懲罰項一般是模型複雜度的單調遞增函式,模型越複雜,規則化值就越大。

e.g.模型引數向量的

algorithm

求解最優化問題的演算法

e.g.梯度下降法,牛頓法

模型評估

泛化能力i.e.預測能力

訓練誤差

測試誤差

過擬合vs欠擬合

監督學習

監督學習方法可分為

- 生成方法 generative approach

主要學習聯合概率分佈P(X,Y)

e.g.樸素貝葉斯,隱馬爾科夫

優點:學習收斂速度更快,樣本容量增加時速度更快,適用於存在隱變數的情況

- 判別方法 discriminative approach

直接得出決策函式Y = f(X)或P(Y|X)

e.g. k-means, 感知機,決策樹,邏輯迴歸,最大熵,支援向量機,提升方法,條件隨機場

優點:準確率更高,便於資料的抽象和特徵提取

監督學習包括

- 分類問題(Y離散)

二類分類問題常用評價指標是準確率precision和召回率recall,以及綜合二者的F1 score - 標註問題

對輸入序列進行標記

常用方法:隱馬爾科夫,條件隨機場 - 迴歸問題

等價於函式擬合,常用損失函式為平方損失函式,此時可用最小二乘法求解

統計學review

大數定理

在重複試驗中,隨著試驗次數的增加,事件發生的頻率趨於一個穩定值

切比雪夫定理的一個特殊情況、辛欽定理和伯努利大數定律都概括了這一現象都稱為大數定律極大似然概率

使用情況:模型已定,引數未知

f(x1,x2,...,xn|Θ)

假設所有采樣獨立同分布,f為模型,θ 為模型引數

定義似然函式:

L(Θ|x1,x2,...,xn)=f(x1,x2,...,xn|Θ)

使函式值最大化(對Θ 取一階導數)的Θ 值就是Θ 的最大似然估計

求法:

因為獨立同分布

L(Θ|x1,x2,...,xn)=f(x1,x2,...,xn|Θ)=∏ni=1f(xi|Θ)

兩邊取對數(因為對數函式是單調增函式,與L有相同的最大值點,而求ln的值相對簡單些^[1])

lnL(Θ|x1,x2,...,xn)=∑ni=1lnf(xi|Θ)

對引數Θ 求導,令一階導數為零,就得出最大似然估計值

Θmle=argmax1nlnL

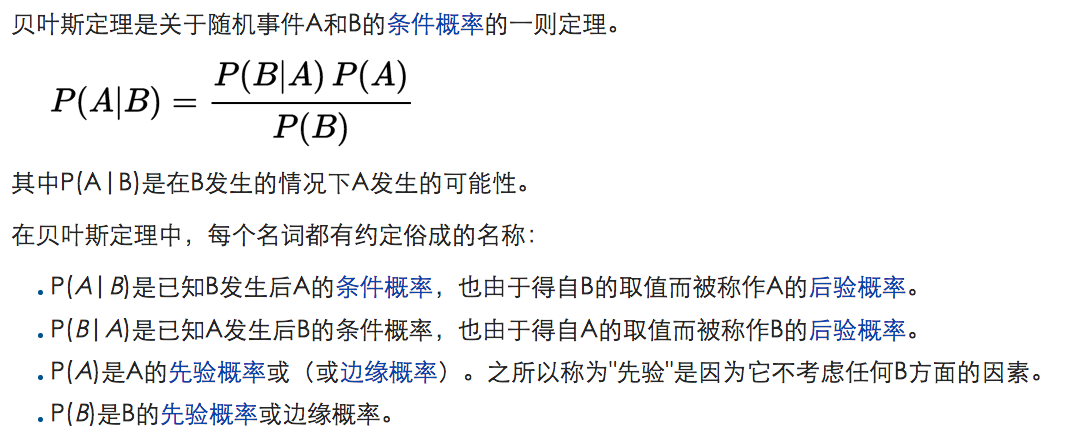

更多參考- 貝葉斯估計

假設

那麼

最大後驗概率估計 即為 後驗概率分佈的眾數

可以看做正則化的最大似然估計,當g是常數時兩者等價

極大似然估計和貝葉斯估計分別代表了頻率派和貝葉斯派的觀點。頻率派認為,引數是客觀存在的,只是未知而矣。相反的,貝葉斯派認為引數也是隨機的,和一般隨機變數沒有本質區別,正是因為引數不能固定,當給定一個輸入x後,我們不能用一個確定的y表示輸出結果,必須用一個概率的方式表達出來,所以貝葉斯學派的預測值是一個期望值。最大後驗概率和極大似然估計很像,只是多了一項先驗分佈,它體現了貝葉斯認為引數也是隨機變數的觀點,在實際運算中通常通過超引數給出先驗分佈。

- 最小二乘法

通過最小化誤差的平方和尋找資料的最佳函式匹配

範數review

L0範數

向量中非0的元素的個數

如果我們用L0範數來規則化一個引數矩陣W的話,就是希望W的大部分元素都是0

L1範數

向量中各個元素絕對值之和,i.e. “稀疏規則運算元”(Lasso regularization),lasso是套繩的意思,是 L0範數的最優凸近似

L0 v.s. L1

稀疏規則化可以實現特徵的自動選擇,在預測新樣本時自動忽略無用的特徵;而且模型更好理解。 L1範數和L0範數可以實現稀疏,L1因具有比L0更好的優化求解特性而被廣泛應用。

L2範數

向量各元素的平方和然後求平方根, i.e. “嶺迴歸”(Ridge Regression)or “權值衰減weight decay”

用於改善過擬合;有助於處理ill-condition的情況,讓優化求解更加穩定和快速。

condition number

假設我們有個方程組AX=b,我們需要求解X。如果A或者b稍微的改變,會使得X的解發生很大的改變,那麼這個方程組系統就是ill-condition的,反之就是well-condition的。一般用condition number衡量系統對微小變化的敏感度,定義為矩陣A(A是非奇異的i.e.可逆)的norm(範數)乘以它的逆的norm。condition number值小(在1附近)的就是well-conditioned的,大的(遠大於1)就是ill-conditioned的。)

以上參考 博文

習題

1、伯努利模型n次獨立實驗中k次結果為1,估計結果為1的概率

模型為

1)用極大似然估計

直接求一階導數另其等於零

得到0,1,

2)用貝葉斯估計中的最大後驗概率估計

(參考教材中“模型是條件概率分佈,損失函式是對數損失函式,模型複雜度由模型的先驗概率表示時,結構風險最小化就等價於最大後驗概率分佈”)

2、通過經驗風險最小化推導極大似然估計,證明模型是條件概率分佈,損失函式是對數損失函式時,經驗風險最小化等價於極大似然估計