文字挖掘之降維技術之特徵選擇

1、為什麼要進行降維處理?

1.多重共線性--預測變數之間相互關聯。多重共線性會導致解空間的不穩定,從而可能導致結果的不連貫。

2.高維空間本身具有稀疏性。一維正態分佈有68%的值落於正負標準差之間,而在十維空間上只有0.02%。

3.過多的變數會妨礙查詢規律的建立。

4.僅在變數層面上分析可能會忽略變數之間的潛在聯絡。例如幾個預測變數可能落入僅反映資料某一方面特徵的一個組內。

降維的目的:

1.減少預測變數的個數

2.確保這些變數是相互獨立的

3.提供一個框架來解釋結果

2.1、文件頻率(Doeument Frequency DF)

詞條的文件頻率(DF)就是指在訓練樣本集中出現該詞條的文件數。在進行特徵抽取時,將DF高於某個特定闌值的詞條提取出來,低於這個閾值的詞條給予濾除。

DF評估函式的理論假設是稀有詞條不含有有用資訊,或含有的資訊太少不足以對分類產生影響,而應當被去除。然而這種假設與一般的資訊抽取觀念有點衝突,因為在資訊抽取中,有些稀有詞條(如類別特徵詞)卻恰恰比那些中頻詞更能反映類別的特徵而不應該被濾除,因此單獨使用DF評估函式進行特徵選擇未免太武斷了。

2.2 、文件頻率-逆向文件頻率特徵

2.3、互資訊(MI)

或者使用這種公式計算

MI的缺點:在文字分類中,MI 特徵的不足之處在於極少出現的特徵詞的 MI 值要大於正常出現特徵詞的 MI,這一點與文字特徵分類恰恰相反。因此,基於 MI 特徵的文字分類演算法檢測效能較差。

2.4、資訊增益(IG)

或者用以下公式計算也可以

或者用下面的公式理解

2.5、期望交叉熵(ECE)

2.6、x^2統計法(CHI)

2.7、相關係數(CC)

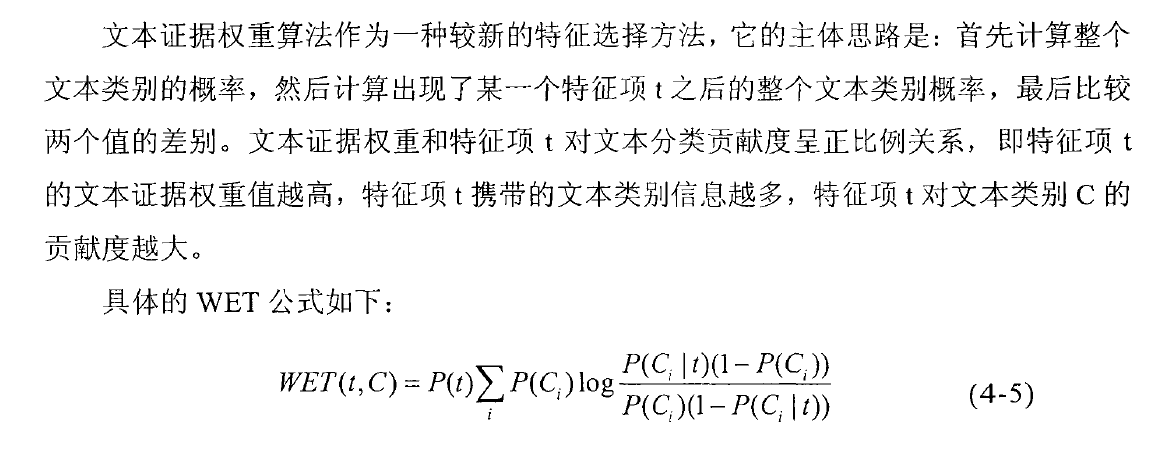

2.8、文字證據權重

或者以下理解

通過查閱大量的文獻,可以得出一些研究者對特徵選擇演算法有如下的評價分類效果最好

的是文字證據權重演算法,其次是資訊增益、期望交叉熵、卡方,最後是互資訊方法。

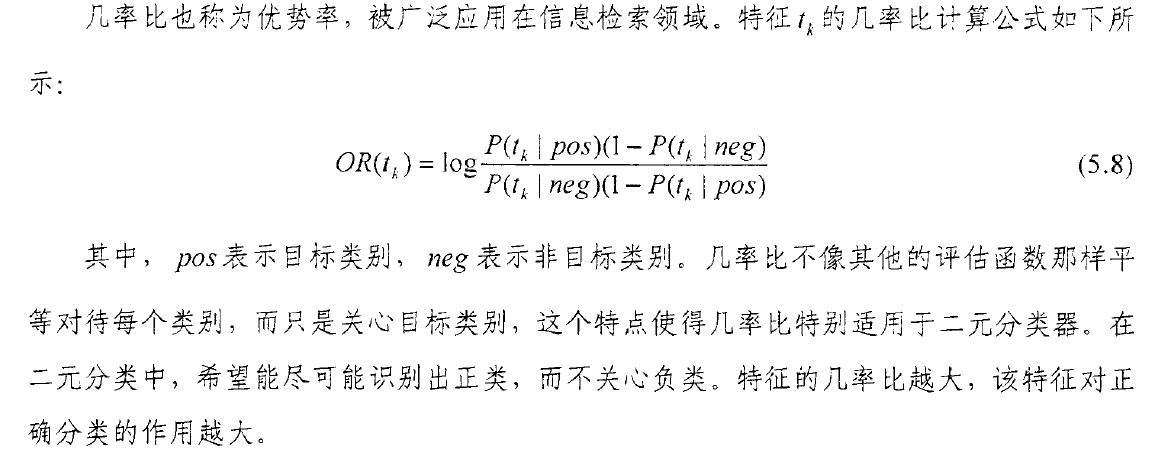

2.9、機率比(OR)