爬蟲爬取新浪微博

阿新 • • 發佈:2019-01-04

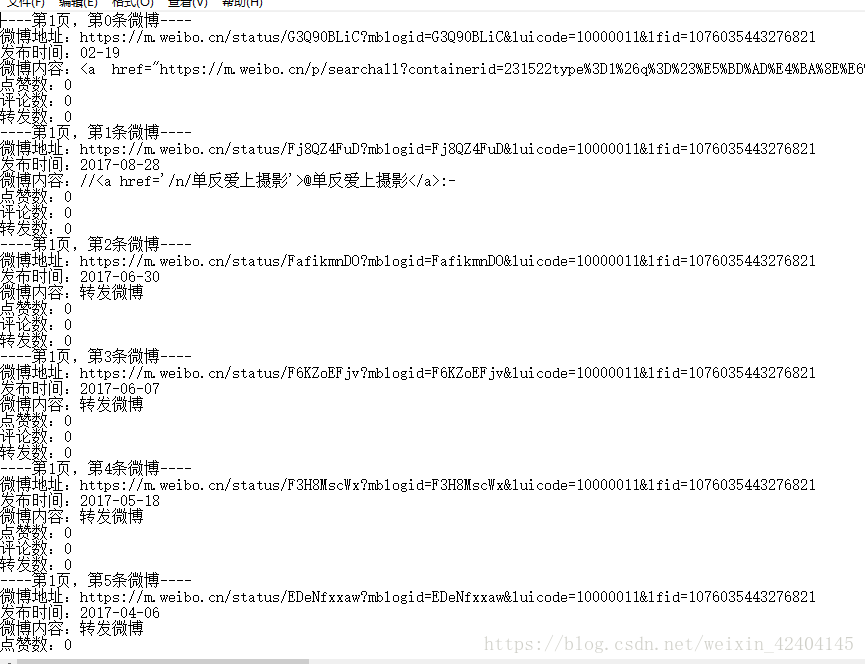

這周的第一個小任務:爬取動態網頁,拿新浪微博做例子,我爬取了指定使用者微博的基本資訊,包括暱稱,性別,粉絲數,關注人數和主頁地址,還有發過的所有微博的地址和資訊內容,如果轉發時沒有說任何內容的話只會顯示轉發了微博。

需要注意的是網頁版資訊量太大,用手機端的也就是m版的會比較容易提取資訊

下面是全部程式碼:

import urllib.request

import json

id='5443276821' #要爬取使用者的Id

proxy_addr="122.241.72.191:808"#代理地址,可以自己在西刺網裡找可用的IP

url = 'https://m.weibo.cn/api/container/getIndex?type=uid&value=' 部分結果截圖:

存入檔案結果: