HDFS小檔案優化方法

1 HDFS小檔案弊端

HDFS上每個檔案都要在NameNode上建立一個索引,這個索引的大小約為150byte,這樣當小檔案比較多的時候,就會產生很多的索引檔案,一方面會大量佔用NameNode的記憶體空間,另一方面就是索引檔案過大使得索引速度變慢。

2 HDFS小檔案解決方案

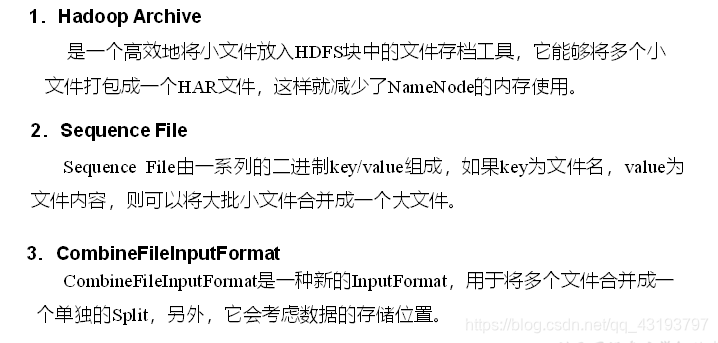

小檔案的優化無非以下幾種方式:

(1)在資料採集的時候,就將小檔案或小批資料合成大檔案再上傳HDFS。

(2)在業務處理之前,在HDFS上使用MapReduce程式對小檔案進行合併。

(3)在MapReduce處理時,可採用CombineTextInputFormat提高效率。

3.HDFS小檔案解決方案

相關推薦

HDFS小檔案優化方法

1 HDFS小檔案弊端 HDFS上每個檔案都要在NameNode上建立一個索引,這個索引的大小約為150byte,這樣當小檔案比較多的時候,就會產生很多的索引檔案,一方面會大量佔用NameNode的記憶體空間,另一方面就是索引檔案過大使得索引速度變慢。 2 HDFS小檔案解決方案 小檔案

HDFS小檔案合併問題的優化:copyMerge的改進

1.問題分析 用fsck命令統計 檢視HDFS上在某一天日誌的大小,分塊情況以及平均的塊大小,即 [[email protected] jar]$ hadoop fsck /wcc/da/kafka/report/2015-01-11 DEPRECATED: U

史上最全MapReduce小檔案優化策略

小檔案的優化無非以下幾種方式: 在資料採集的時候,就將小檔案或小批資料合成大檔案再上傳 HDFS 在業務處理之前,在 HDFS 上使用 mapreduce 程式對小檔案進行合併 在 mapreduce 處理時,可採用 CombineTextInputForma

hdfs 小檔案合併方案(附程式碼)

背景: presto計算落地出現了大量的小檔案,目前暫時沒有發現可以通過引數優化解決,所以開發了小檔案合併工具 工具架構如下 工具主要分為三部分: collector 負責將合併規則推送到redis佇列,合併規則物件定義如下, public class FileCo

HDFS小檔案處理及解決方案

小檔案為什麼會成為問題?小檔案的解決方案包括哪些?有沒有自己的解決方案?Hadoop Archive具體是如何處理小檔案的?Sequence file是如何解決小檔案的?CombineFileInputFormat是如何解決小檔案的?1、 概述小檔案是指檔案size小於H

HDFS小檔案問題解決方案+SequenceFile簡單介紹

HDFS和MR主要針對大資料檔案來設計,在小檔案處理上效率低. 解決方法是選擇一個容器,將這些小檔案包裝起來,將整個檔案作為一條記錄,可以獲取更高效率的儲存和處理,避免多次開啟關閉流耗費計算資源.

Linux下快速刪除大量小檔案的方法探索

一、前言 Linux伺服器磁碟中存在大量小檔案,需要進行刪除(檔案小於1K,數量50w~100w),發現rm刪除速度奇慢無比,甚至出現“argument list too long”的錯誤。網上資料一搜索基本都是建議rsync方法,所以本文對幾種常見的方法進行試驗對比。

解決Spark讀取HDFS小檔案的問題

若Spark讀取HDFS資料夾時, 其中的小檔案過多會降低程式效能,也給HDFS帶來壓力。 當Spark讀取檔案時, 會為每個檔案

HDFS無法高效儲存大量小檔案,如何處理好小檔案?

一、HAR檔案方案 為了緩解大量小檔案帶給namenode記憶體的壓力,Hadoop 0.18.0引入了Hadoop Archives(HAR files),其本質就是在HDFS之上構建一個分層檔案系統。通過執行hado

python spark中parquet檔案寫到hdfs,同時避免太多的小檔案(block小檔案合併)

在pyspark中,使用資料框的檔案寫出函式write.parquet經常會生成太多的小檔案,例如申請了100個block,而每個block中的結果 只有幾百K,這在機器學習演算法的結果輸出中經常出現,這是一種很大的資源浪費,那麼如何同時避免太多的小檔案(bloc

Python將一個大檔案按段落分隔為多個小檔案的簡單方法

今天幫同學處理一點語料。語料檔案有點大,並且是以連續兩個換行符作為段落標誌,他想把它按段落分隔成多個小檔案,即每3個段落組成一個新檔案。由於以前沒有遇到過類似的操作,在網上找了一些相似的方法,看起來都有點複雜。所以經嘗試,自己寫了一段程式碼,完美解決問題。 基本思路是,先讀原檔案內容,

刪除電腦上重複檔案的方法--好用小軟體推薦

長期使用的硬碟空間總是會收集很多很多的檔案,其中有很多事重複的,有的檔案在家裡放一份,在公司放一份,而且有的時候兩處的檔案裡邊有很多相同的,有很多不同的,這樣如果再把公司的資料夾copy回家做備份,家裡電腦上就會有很多的內容是重複的。我通常會手機很多的電子書和技術資料,非常的多,幾個資料夾下的電

HDFS原始碼檔案過大,IDEA開啟失敗解決方法

問題現象:hadoop 3.1.0原始碼檔案ClientNamenodeProtocolProtos大小4M+,IDEA開啟時載入失敗,ClientNamenodeProtocolPB報錯找不到類。 ----------------------------------------------------

MaxCompute小檔案問題優化方案

小檔案背景知識 小檔案定義 分散式檔案系統按塊Block存放,檔案大小比塊大小小的檔案(預設塊大小為64M),叫做小檔案。 如何判斷存在小檔案數量多的問題 檢視檔案數量 desc extended + 表名 判斷小檔案數量多的標準 1、非分割槽表,表文件數達到1000個,檔案平均大小小於64

flume向hdfs中寫入會生成很多小檔案

問題: flume監控的目錄寫入大檔案的時候不能同步記錄在hdfs中 flume監控的目錄寫入大檔案的時候,同步記錄到hdfs中後變成多個小檔案 flume從kafka中讀取資料下沉到hdfs中會生成很多小檔案 解決辦法:更改flume的配置資訊(主要更改滾動方式),滾動的意思是當flu

hive處理小檔案(進行map、reduce、壓縮、歸檔優化解決)

背景 Hive query將運算好的資料寫回hdfs(比如insert into語句),有時候會產生大量的小檔案,如果不採用CombineHiveInputFormat就對這些小檔案進行操作的話會產生大量的map task,耗費大量叢集資源,而且小檔案過多會對namenode造成很

解決Flume採集資料時在HDFS上產生大量小檔案的問題

問題:flume指定HDFS型別的Sink時,採集資料至HDFS指定目錄,會產生大量小檔案。問題重現:1、建立flume配置檔案flume-env.sh,:flume配置檔案如下(根據自身需要修改): 因為flume可以配置多種採集方式,每種採集方式對應一個agent配

kafka hdfs connect 會產生只有一個記錄的小檔案

1. 問題現象: 如果用kafka hdfs connect將流式資料匯入hdfs,處理開始一定會產生N個只有一條記錄的小檔案,其中N 為kafka topic的分割槽數。不影響功能,但不友好。 ubuntu@wonderwoman:~/databus/co

大量小檔案的儲存場景,有什麼優化辦法

可以參考Google的GFS以及變種HDFS、淘寶TFS以及騰訊TencentFS的設計。這些都是處理大量小檔案的典範。 大家知道傳統的檔案系統下,每個檔案都要被建立對應的inode之類元資料,但是在海量檔案場景下,傳統FS已經無法承載如此多的元資料IO量以及如此龐大的元資料搜尋計算量了,唯一的做法就是降低

Flume1.4 相關引數設定,將收集的資料彙總到hdfs,解決許多小檔案問題

參照官方文件,將 flume client 收集的日誌檔案 彙總到 flume sink收集端,然後儲存到hdfs 中,預設會按生成許多小檔案,如圖所示 實際中可能只需要生成一個檔案即可,這就涉及到了幾個相關引數設定如下即可 需要修改的檔案位於 flume/con