大資料學習-Hadoop生態章---HDFS完全分散式(1.X版本)搭建及eclipse外掛整合

阿新 • • 發佈:2019-01-08

完全分散式搭建(1.x版)

一.環境的準備(詳情參考Linux章)

- Linux 環境

- JDK

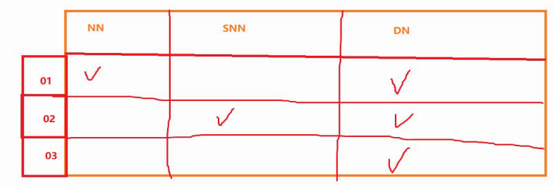

- 準備至少3臺機器(通過克隆虛擬機器;配置好網路JDK 時間 hosts,保證節點間能互ping通)

- 時間同步 (ntpdate time.nist.gov)

- ssh免祕鑰登入 (兩兩互通免祕鑰)

二.完全分散式搭建

-

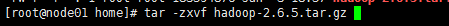

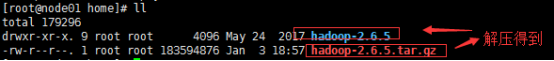

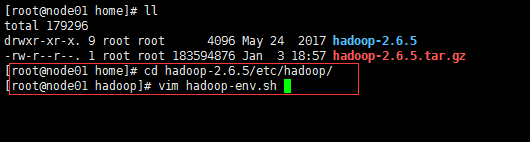

下載解壓縮Hadoop

-

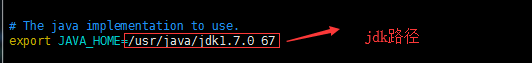

配置etc/hadoop/hadoop-env.sh

-

配置core-site.xml:

fs.defaultFS預設的服務埠NameNode URI

hadoop.tmp.dir是hadoop檔案系統依賴的基礎配置,很多路徑都依賴它。

如果hdfs-site.xml中不配 置namenode和datanode的存放位置,預設就放在這個路徑中<configuration> <property> <name>fs.defaultFS</name> <value>hdfs://node01:9000</value> </property> <property> <name>hadoop.tmp.dir</name> <value>/opt/hadoop-2.6.5</value> </property> </configuration> -

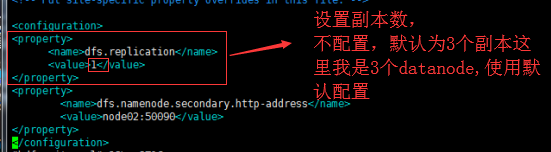

配置 hdfs-site.xml:

dfs.datanode.https.addresshttps服務的埠<configuration> <property> <name>dfs.replication</name> <value>1</value> </property> <property> <name>dfs.namenode.secondary.http-address</name> <value>node02:50090</value> </property> <property> <name>dfs.namenode.secondary.https-address</name> <value>node02:50091</value> </property> </configuration>

-

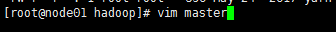

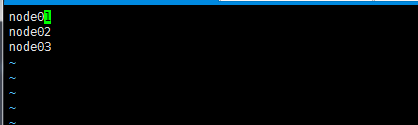

配置 masters: master 可以做主備的SNN

在/home/hadoop-2.6.5/etc/hadoop/新建masters檔案 寫上SNN節點名: node02

-

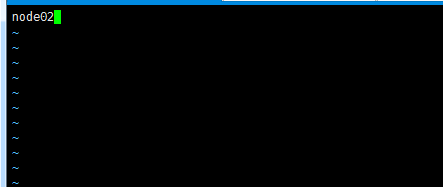

配置 slaves: slave 奴隸 苦幹;拼命工作

在/home/hadoop-2.5.1/etc/hadoop/slaves檔案中填寫DN 節點名:node2 node3 node4 [注意:每行寫一個 寫成3行]

-

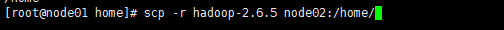

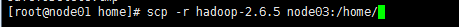

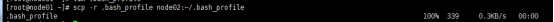

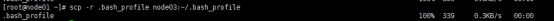

最後將配置好的Hadoop通過SCP命令傳送都其他節點

配置Hadoop的環境變數

-

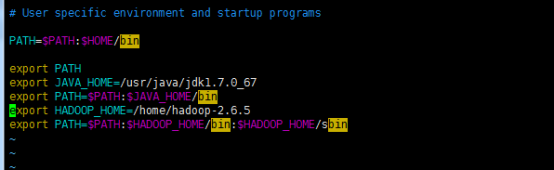

vi ~/.bash_profile (最好手敲輸入 貼上有時候會出錯)

export HADOOP_HOME=/home/hadoop-2.6.5 export PATH=$PATH:$HADOOP_HOME/bin:$HADOOP_HOME/sbin

-

記得一定要

source ~/.bash_profile -

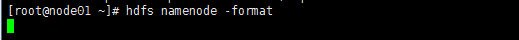

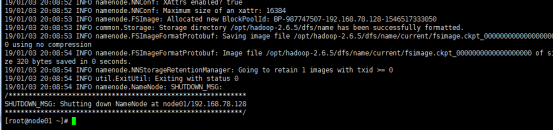

回到跟目錄下對NN進行格式化 hdfs namenode -format

hdfs namenode -format

- 關閉防火牆:service iptables stop

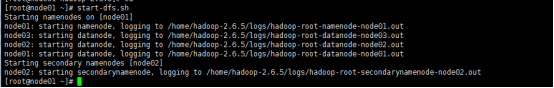

- 啟動HDFS: start-dfs.sh啟動HDFS: start-dfs.sh

啟動HDFS: start-dfs.sh

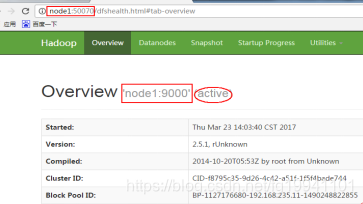

- 驗證是否成功

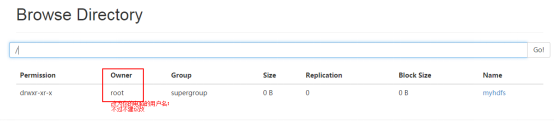

- 在瀏覽器輸入 node1:50070 出現以下介面成功

- 到datanode節點驗證hadoop.tmp.dir目錄

- 注意:HDFS叢集有clusterID,datanode啟動時會和namenode對比clusterID,如果相同,啟動成功,如果不同,自殺程序

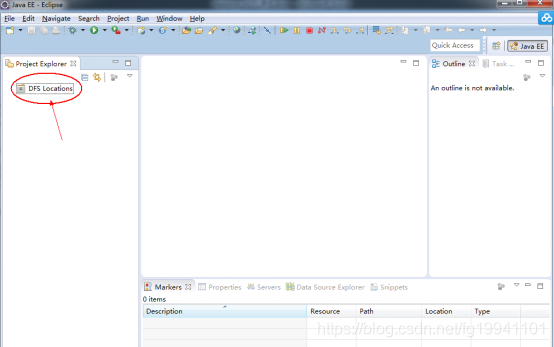

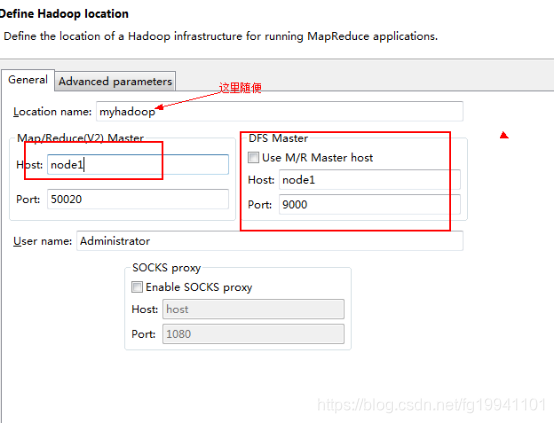

eclipse外掛安裝配置

將以下jar包放入eclipse的plugins資料夾中

hadoop-eclipse-plugin-2.6.0.jar

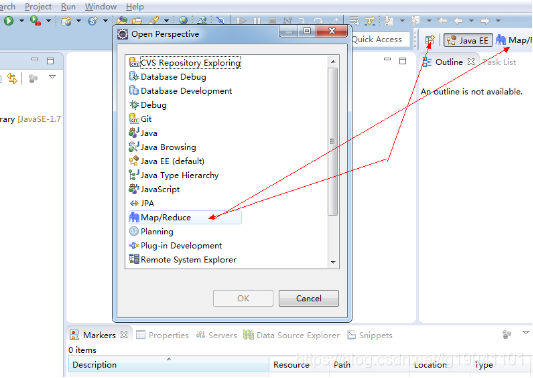

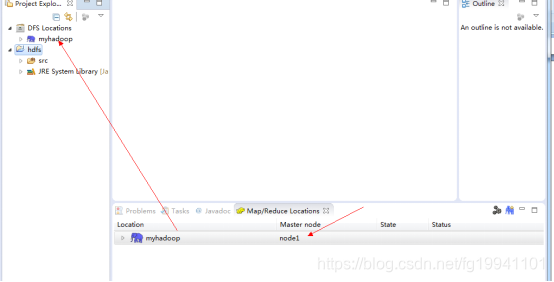

啟動eclipse:出現介面如下:

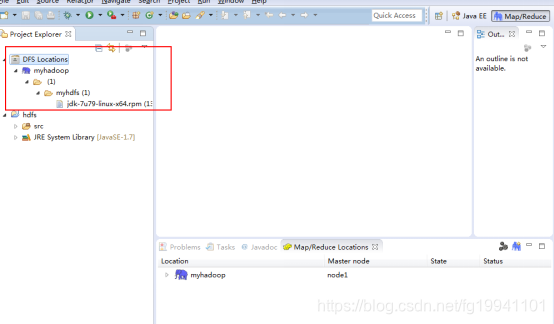

新建Java專案:

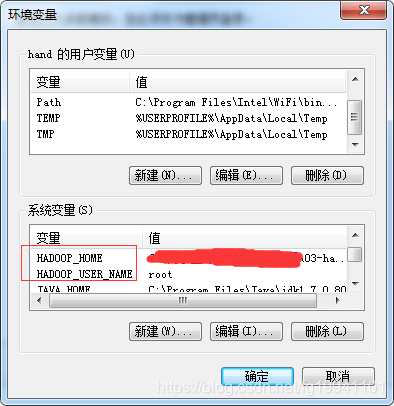

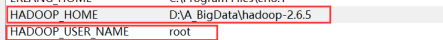

Eclipse外掛安裝完後修改windows下的使用者名稱,然後重啟:

【注意:改成Windows下使用者的使用者名稱root(重啟生效)或改Linux檔案的使用者】

或

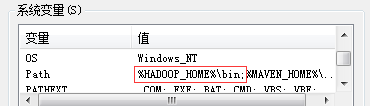

記得配置 path