[骨架動作識別]資料集

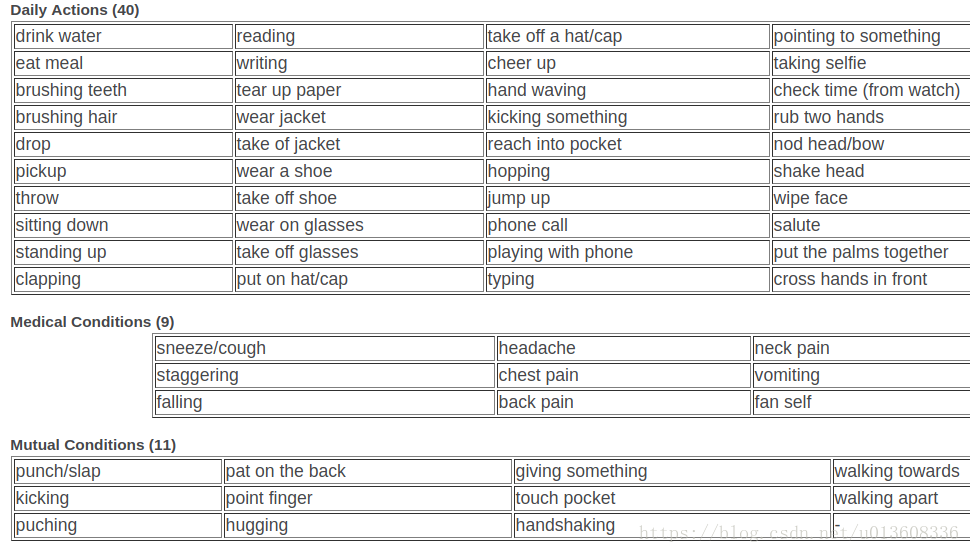

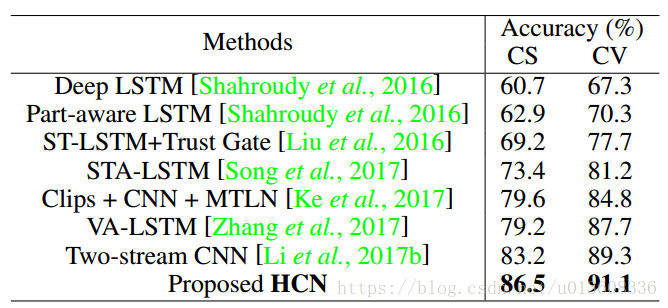

總共大約有56000個視訊,60類動作,50類是單人動作,10類是雙人互動動作。每個人捕捉了25個關節點。資料集有兩種分割方式,cross subject 和cross view ,這也是目前最大最全的一個數據集。很多動作識別的論文都是以這個資料集作為檢測標準。

包含四種類型的資料,RGB videos、 depth map sequences 、3D skeletal data、infrared videos

精度:

MSR-Action3D

20類動作,10個人,重複2到3次。總共有567個sequence,depth和skeleton 資料,沒有RGB資料,其中有10個sequence有錯誤,skeleton丟失掉了,幀率15fps

SBU

共284個視訊,8類動作,7個人,用5折交叉驗證,最長46frame,本資料集的動作全是雙人互動動作,有RGB、skeleton、depth圖片。骨架關節點有15個

動作分類:靠近, 遠離, 踢 ,推,握手,擁抱,遞書本,拳擊

x and y are normalized as [0,1] while z is normalized as [0,7.8125]

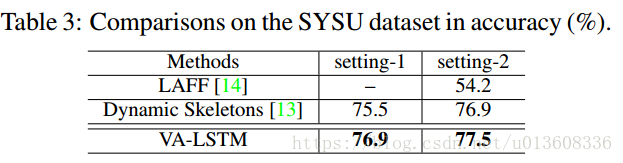

SYSU

kinect捕捉的資料集,包含12類動作,由40個人出演的。總共有480個sequence,每個人有20個關節點。40人,12個動作,480個video clip,6種object。手機,椅子,包,錢包,拖把,掃把。

0.9s-12s,但是背景非常雜亂。

這12個動作分別是:喝水,從一個杯子往另一個杯子倒水 ,打電話,玩手機,背書包,收拾書包,坐在椅子上,移動椅子,從口袋掏出錢包,從錢包裡拿錢,拖地,掃地

1.拖把和掃把非常像

2.實驗者40人遠超於之前的人數

setting 1 :一半樣本用來訓練,一半用來測試

setting 2 :一般人物用來訓練,一半人物用來測試

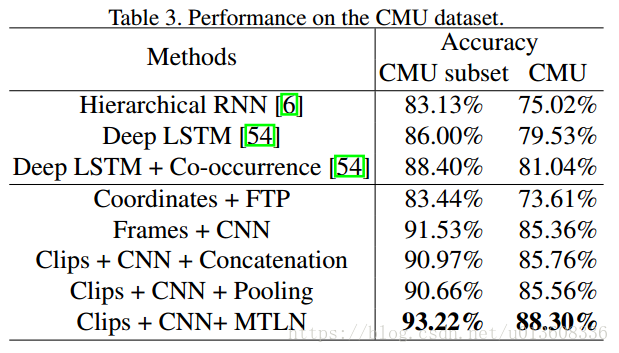

CMU dataset

總共有2235個sequence,其中subset有664個sequence

包括8個動作類別,在NTU-RGBD出現以前,這是最大的一個數據集,比較有挑戰性,主要是因為1, 視訊長度變化比較大,2,類內差距比較大,不同的人走路的姿勢和速度都不同 3,包含了比較複雜的動作比如跳舞和瑜伽。

沒有RGB視訊

是由一個靜止的kinect相機捕捉的,10個人物,10類動作

每個動作由同一個人表演兩次。

10人,(每人做10個動作,這10個sequences 是連在一起的),每個人2個視訊,總共20個sequence.

長度:5-120frames

本資料集有20個樣本,所以要計算20次

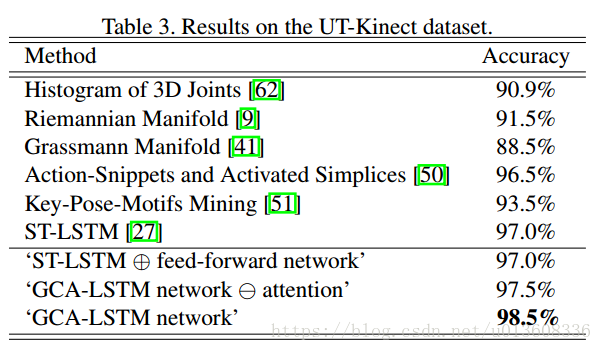

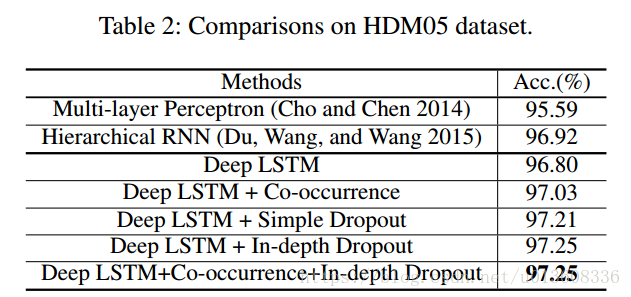

HMDB05

2,337 skeleton sequences performed by 5 actors (184,046 frames after down-sampling

以下結果是2016年AAAI的一篇文章,結果比較老了

Berkeley MHAD

已經達到100%

參考文獻

NTURGBD ,SBU 【Co-occurrence Feature Learning from Skeleton Data for Action Recognition and Detection with Hierarchical Aggregation】

SYSU 【View Adaptive Recurrent Neural Networks for High Performance Human Action Recognition from Skeleton Data】

CMU 【A New Representation of Skeleton Sequences for 3D Action Recognition】

HMDB05 【Co-Occurrence Feature Learning for Skeleton Based

Action Recognition Using Regularized Deep LSTM Networks】