python爬蟲之貓眼視訊Top100

貓眼視訊Top100

import requests

import re,json

from multiprocessing import Pool

def get_one_page(url,head):

#異常處理

try:

#傳送請求

response=requests.get(url,headers=head)

#判斷網頁狀態碼是否成功獲取網頁

if response.status_code==200:

return response.text

return None

except 效果如下

相關推薦

python爬蟲之貓眼視訊Top100

貓眼視訊Top100 import requests import re,json from multiprocessing import Pool def get_one_page(url,h

Python爬蟲之requests+正則表示式抓取貓眼電影top100以及瓜子二手網二手車資訊(四)

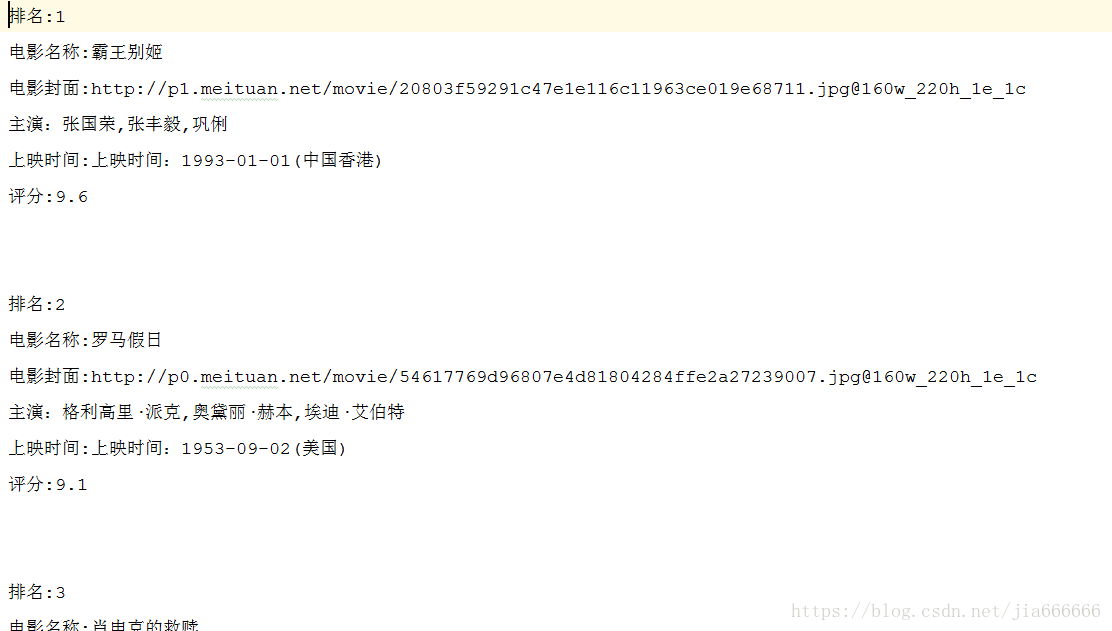

{'index': '1', 'image': 'http://p1.meituan.net/movie/[email protected]_220h_1e_1c', 'title': '霸王別姬', 'actor': '張國榮,張豐毅,鞏俐', 'time': '1993-01-01', 'sc

Python爬蟲之三:抓取貓眼電影TOP100

今天我要利用request庫和正則表示式抓取貓眼電影Top100榜單。 執行平臺: Windows Python版本: Python3.6 IDE: Sublime Text 其他工具: Chrome瀏覽器 1. 抓取單頁內容 瀏

Python爬蟲之抓取貓眼電影TOP100

執行平臺:windowsPython版本:Python 3.7.0IDE:Sublime Text瀏覽器:Chrome瀏覽器思路: 1.檢視網頁原始碼 2.抓取單頁內容 3.正則表示式提取資訊

python爬蟲之騰訊視訊vip下載

執行環境 IDE:pycharm python:3.6.5 實現目的 實現對騰訊視訊目標url的解析與下載,由於第三方vip解析,只提供線上觀看,隱藏想實現對目標視訊的下載 實現思路 首先拿到想要看的騰訊電影url,通過第三方vip視訊解析網

Python爬蟲之如何爬取抖音小姐姐的視訊

介紹這次爬的是當下大火的APP--抖音,批量下載一個使用者釋出的所有視訊。各位也應該知道,抖音只

一個鹹魚的Python爬蟲之路(三):爬取網頁圖片

you os.path odin 路徑 生成 存在 parent lose exist 學完Requests庫與Beautifulsoup庫我們今天來實戰一波,爬取網頁圖片。依照現在所學只能爬取圖片在html頁面的而不能爬取由JavaScript生成的圖。所以我找了這個網站

[Python爬蟲] 之十五:Selenium +phantomjs根據微信公眾號抓取微信文章

頭部 drive lac 過程 標題 操作 函數 軟件測試 init 借助搜索微信搜索引擎進行抓取 抓取過程 1、首先在搜狗的微信搜索頁面測試一下,這樣能夠讓我們的思路更加清晰 在搜索引擎上使用微信公眾號英文名進行“搜公眾號&r

玩轉python爬蟲之URLError異常處理

bsp 無法識別 pac 使用 cin lai 網絡 處理方式 地址 這篇文章主要介紹了python爬蟲的URLError異常處理,詳細探尋一下URL\HTTP異常處理的相關內容,通過一些具體的實例來分析一下,非常的簡單,但是卻很實用,感興趣的小夥伴們可以參考一下 本節

python爬蟲之正則表達式

ner cde 輸入 set 神奇 tro 轉義 規則 error 一、簡介 正則表達式,又稱正規表示式、正規表示法、正規表達式、規則表達式、常規表示法(英語:Regular Expression,在代碼中常簡寫為regex、regexp或RE),計算機科學的一個概念。

[Python爬蟲] 之十九:Selenium +phantomjs 利用 pyquery抓取超級TV網數據

images 判斷 nco dex onf etc lac lin 利用 一、介紹 本例子用Selenium +phantomjs爬取超級TV(http://www.chaojitv.com/news/index.html)的資訊信息,輸入給定關鍵字抓取

Python爬蟲之爬取煎蛋網妹子圖

創建目錄 req add 註意 not 相同 esp mpi python3 這篇文章通過簡單的Python爬蟲(未使用框架,僅供娛樂)獲取並下載煎蛋網妹子圖指定頁面或全部圖片,並將圖片下載到磁盤。 首先導入模塊:urllib.request、re、os import

python爬蟲之git的使用

mage .cn 沒有 倉庫 本地倉庫 odin src python爬蟲 建立 1、初始化文件夾為版本控制文件夾,首先建立一個文件夾,進入這個文件夾以後輸入git init初始化這個文件夾。 2、Git幾種位置概念 1、本地代碼:本地更改完代碼以後,雖然是存放在git的

python爬蟲之git的使用(coding.net的使用)

git push github上 版本 es2017 push 我們 執行命令 pytho 最好的 1、註冊coding.net賬號,然後登陸。 2、創建項目 套路和github都一樣。 1.1、我們在遠程倉庫上創建了一個倉庫,這樣的話,我們需要在本地隨便建立一

python爬蟲之requests模塊

.post 過大 form表單提交 www xxxxxx psd method date .com 一. 登錄事例 a. 查找汽車之家新聞 標題 鏈接 圖片寫入本地 import requests from bs4 import BeautifulSoup import

Python爬蟲之利用正則表達式爬取內涵吧

file res start cnblogs all save nts quest ide 首先,我們來看一下,爬蟲前基本的知識點概括 一. match()方法: 這個方法會從字符串的開頭去匹配(也可以指定開始的位置),如果在開始沒有找到,立即返回None,匹配到一個結果

Python爬蟲之利用BeautifulSoup爬取豆瓣小說(三)——將小說信息寫入文件

設置 one 行為 blog 應該 += html uil rate 1 #-*-coding:utf-8-*- 2 import urllib2 3 from bs4 import BeautifulSoup 4 5 class dbxs: 6 7

python爬蟲之scrapy的pipeline的使用

python爬蟲 pre ram .py pid cati port 目錄 自動創建 scrapy的pipeline是一個非常重要的模塊,主要作用是將return的items寫入到數據庫、文件等持久化模塊,下面我們就簡單的了解一下pipelines的用法。 案例一:

python爬蟲之解析網頁的工具pyquery

div blog import 很多 aof pyquery from text lec 主要是對http://www.cnblogs.com/zhaof/p/6935473.html這篇博客所做的筆記有疑惑可以去看這篇文章from pyquery import PyQue

python爬蟲之scrapy文件下載

files 下載 item toc mat spider color pid 一點 我們在寫普通腳本的時候,從一個網站拿到一個文件的下載url,然後下載,直接將數據寫入文件或者保存下來,但是這個需要我們自己一點一點的寫出來,而且反復利用率並不高,為了不重復造輪子,scra