資料探勘一般過程

目錄

1.資料集選取

2.資料預處理

(1)資料清理

(2)資料整合

(3)資料歸約

(4)資料變換和資料離散化

3.資料分析演算法

4.分析總結改進

這學期提前選課學習了Data Mining,最近提交了論文已經徹底結了。想來想去還是寫點東西記一下,假如以後能用上呢?僅供參考哈

參考書:《資料探勘概念與技術》 Jiawei Han 等著

首先一些基本概念還是要了解一下的,資料探勘是從大量資料中挖掘出有趣模式和知識的過程。資料來源一般是資料庫、資料倉庫、Web等,得到的資料稱為資料集(dataset)。其中資料倉庫是data mining獨有內容,是從多個數據源收集的資訊儲存庫。按照William H.Inmon的說法,“資料倉庫是一個面向主題的、整合的、時變的、非易失的資料集合,支援管理者的決策過程”。對比資料庫的概念,“長期儲存在計算機內、有組織的、可共享的大量資料的集合”(《資料庫系統概論》(第四版)王珊等),可以分為兩類,聯機資料處理(Online Transaction Processing,OLTP)系統和聯機分析處理(Online Analytical Processing,OLAP)系統。資料庫屬於前一個,資料倉庫屬於後一個,對比如下:

圖1 OLTP和OLAP對比圖

然後是重點:資料探勘的一般過程。

1.資料集選取

一般資料集是已經存在的或者至少知道如何獲得的(訪問某個資料庫,網上過濾抓取需要的資料,問卷調查手動收集等)。資料集的選取對資料探勘模式是否有趣起決定作用。一般的資料探勘模式有頻繁模式,用於預測分析的分類和迴歸模式,聚類分析模式等,代表著資料探勘的某種目的。最開始做實驗的時候並不知道自己想要做什麼(一般都是現有資料集或者想法,再有資料探勘),於是檢視一些常見的資料集網站(下附),尋找自己感興趣的資料集,畢竟興趣是最好的老師,興趣有了,資料探勘才能開心地做下去。

資料探勘 資料集下載蒐集整理版 http://blog.sina.com.cn/s/blog_5c9288aa01014a56.html

2.資料預處理

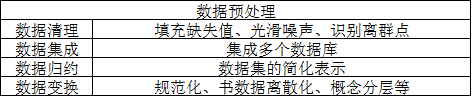

選取了資料集之後,就開始對資料進行預處理使得資料能夠為我們所用了。資料預處理提高資料質量:準確性、完整性和一致性,包括資料清理、資料整合、資料規約和資料變換方法。

圖2資料預處理方法

(1)資料清理

忽略元祖

人工填寫缺失值

使用屬性的中心度量填充

給定同一類所有樣本的屬性均值或中位數填充

最可能的值填充

(2)資料整合

實體識別

冗餘和相關分析(卡方檢驗,相關係數,協方差等,用spss比較方便)

(3)資料歸約

維規約(小波變換和主成分分析,最常用)

數量規約(較小的資料替代原始資料)

資料壓縮(有損無損兩種,尤其對於影象視訊等多媒體常用)

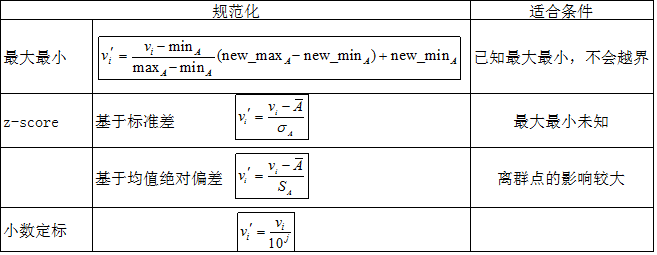

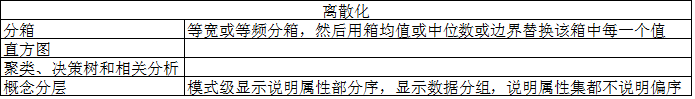

(4)資料變換和資料離散化

資料變換:光滑,屬性構造,聚集,規範化,離散化和概念分層。

圖3 資料規範化常見方法

圖4 資料離散化

Eg:3-4-5規則,根據最高有效位個數分:

分為3類:最高有效位個數為 3 6 7 9

4 2 4 8

5 1 5

一般步驟:取min5%,max95%;根據3-4-5規則分段;根據兩端調整分段

3.資料分析演算法

這個裡面的內容就多而且複雜了,僅提出一些常見的供參考吧:

最經典的莫過於頻繁模式挖掘了,物件為事物出現的次數。如著名的啤酒尿布。其中最典型的演算法為Apriori演算法,包括連線和剪枝。其中有置信度,支援度,頻繁項集最小置信度閾值等重要概念,到相關分析中還有提升度,全置信度,Kulczy和餘弦等判斷標準和零不變度量考慮。個人覺得Uber就是看到了大量的零事物,從而開拓私家車市場並取得巨大成功的典型案例,也可以說換角度思考吧。

資料探勘不僅僅用於挖掘頻繁模式之間的聯絡,還常常用來分類和聚類。

分類的一般過程為用分類演算法分析訓練資料,然後用檢驗資料評估分類規則的準確率。常用的分類準則有決策樹歸納、屬性選擇度量、樹剪枝等,具體的常見演算法有樸素貝葉斯(前提屬性之間相互獨立),貝葉斯信念網路,k-最近鄰分類,遺傳演算法,神經網路,模糊集方法等。由此機器學習智慧演算法的強大可見一斑。

聚類由於是非指導學習,就相對麻煩些了。聚類的常見劃分方法有k-均值和k-中心點,都是基於抽象距離的(實際度量為密度,網格等)。還有比較高階版本的,比如說基於概率的。聚類中有很多重要的概念,如劃分準則,簇的離散型,相似性度量,聚類空間。個人覺得聚類其實就是自己按照一定的理解嘗試去定製標準進行分類,然後檢驗自己的標準(尤其是離群點)。

演算法弄完了,別忘了檢驗哦。

4.分析總結改進

世界上沒有任何東西生而完美,因而我們常常有很奇特的體驗:過了一段時間後看自己以前做的事情,覺得自己以前怎麼會做得那麼二!

在資料探勘中分析是很重要的,因此自己有任何的想法,即便自己當時覺得不好,也應該記下來,最後分析的時候再看看,假如又覺得有用呢。分析的物件主要是模型的優缺點(或者叫模型的評估),客觀公正的評判自己的作品(能有高手幫忙最好啦)能清醒自己的認知。改進就是從分析當中來。一般而言,做這種帶一定學術性的東西,確定好自己的基本想法和實踐過程後去大型資料庫(如中國知網)搜一搜,看看別人是如何處理相關事情的,對比一下。不管怎麼說,高屋建瓴總比平地蓋樓容易吧。

總結是對自己的肯定,別的不說,寫完總結後看看前面自己做的事情,肯定還是有不小的自豪感的!總結的過程就是思考的過程,讓自己後面的每一個作品都比現在的要好!

以我目前所學的粗淺知識,也就能寫這麼點了。。。

相關推薦

資料探勘一般過程

目錄 1.資料集選取 2.資料預處理 (1)資料清理 (2)資料整合 (3)資料歸約 (4)資料變換和資料離散化 3.資料分析演算法 4.分析總結改進 這學期提前選課學習了Data Mining,最近提交了論文已經徹底結了。想來想去還是寫點東西記一下,假如以後能用上呢?僅供參考哈

第六章 資料探勘建模過程

資料預處理 資料讀寫 JSON 資料結構 import json匯入json包。json.loads(josn格式的物件) 返回一個字典 ,json.load(檔名)讀取檔案.json.dumps(josn格式的物件)寫成字串,json.dump(josn格式的物件,檔名)

資料探勘一般流程(資料清洗,特徵提取,建模,調參)

最近一直在實習,好長時間沒更新部落格了。哎,懶惰之心不可有啊!! 實習的崗位是資料探勘相關的,所以正好把到目前為止實習期間遇到的一些問題、學到的一些東西總結一下,並參考了一些部落格,自我提升。嘿嘿嘿~

一個AI產品(資料探勘)的產生過程

模型的訓練一般包括以下步驟: 1:資料的輸入: 一般使用pandas庫,他有幾種常用的讀入不同檔案型別的函式: 一般我使用read_csv(File_Path,[params]);(對應的檔案型別為csv檔案,這是資料探勘中的常用檔案格式) 2:資料的預處理: 1):缺失值的處理

Python資料探勘過程

資料探勘的建模過程 定義挖掘目標 明確系統完成後想要達成什麼樣的效果。 我們需要分析應用領域,瞭解相關領域的情況,熟悉背景知識,弄清使用者需求。 資料取樣 從業務系統中抽取一個與挖掘目標相關的樣本資料子集。 抽取資料的標準,一是相關性,二是可靠性,三是有效性。 衡量取樣

資料探勘的一般流程

資料探勘的一般流程 介紹資料探勘的一般流程。尚未明瞭的地方綠字標註,繼續學習。 資料探勘是從大量資料中挖掘出有趣模式和知識的過程。資料來源一般是資料庫、資料倉庫、Web等,得到的資料稱為資料集(dataset)。其中資料倉庫是data mining獨有內容,是從多個數據源

【機器學習】資料探勘演算法——關聯規則(二),挖掘過程,Aprioir演算法

關聯規則挖掘的原理和過程 從關聯規則(一)的分析中可知,關聯規則挖掘是從事務集合中挖掘出這樣的關聯規則:它的支援度和置信度大於最低閾值(minsup,minconf),這個閾值是由使用者指定的。根據 support=(X,Y).count/T.countsupp

資料探勘過程模型研究

(CRoss Industry Standard Process for Data Mining)即"跨行業資料探勘標準流程"。1999年,SIG(CRISP-DMSpecial Interest Group)組織開發並提煉出CRISP-DM,同時在Mercedes-Benz和OHRA(保險領域)企業進行了

python資料探勘課程 十三.WordCloud詞雲配置過程及詞頻分析

一. 安裝WordCloud 在使用WordCloud詞雲之前,需要使用pip安裝相應的包。 pip install WordCloud pip install jieba 其中WordCloud是詞雲,ji

資料探勘過程中的問題集合

問題1:以bid(客戶一次消費行為id)進行建模,導致同一個客戶對應的label不同 解決:以cid(客戶id,人維度)進行建模,對label歸一化,統一處理為0或者1,相當於加權操作 問題2:訓練集和測試集中有重複資料,可能造成過擬合 解決:實際訓練時,對重複

資料探勘領域中的分類和迴歸區別是什麼?

先簡單的說下吧,下面給出實際例子 類和迴歸的區別在於輸出變數的型別。定量輸出稱為迴歸,或者說是連續變數預測;定性輸出稱為分類,或者說是離散變數預測。舉個例子:預測明天的氣溫是多少度,這是一個迴歸任務;預測明天是陰、晴還是雨,就是一個分類任務。 拿支援向量機舉個例子,分類問題

大資料就業前景怎麼樣?hadoop工程師、資料探勘、資料分析師薪資多少?

近幾年來,大資料這個詞突然變得很火,不僅納入阿里巴巴、谷歌等網際網路公司的戰略規劃中,同時也在我國國務院和其他國家的政府報告中多次提及,大資料無疑成為當今網際網路世界中的新寵兒。 《大資料人才報告》顯示,目前全國的大資料人才僅46萬,未來3-5年內大資料人才的缺口將高達150萬,越來越多

利用Python學習資料探勘【0】

相信看到這篇文章的你一定是對資料分析,資料探勘有興趣,或者想從事和方面。本文不再累述python對資料分析的重要,資料分析這門的由來之類的。 在這裡,我單刀直入,已我學習資料探勘3年來的經歷告訴大家怎麼去學,以讓大家少走彎路。純個人見解,如有不對,還請各位留言指教。 話不多說,直接放圖。

利用Python學習資料探勘【2】

本文結合程式碼例項待你上手python資料探勘和機器學習技術。 本文包含了五個知識點: 1. 資料探勘與機器學習技術簡介 2. Python資料預處理實戰 3. 常見分類演算法介紹

利用 Python學習資料探勘【1】

覆蓋使用Python進行資料探勘查詢和描述資料結構模式的實踐工具。 第一節 介紹 資料探勘是一個隱式提取以前未知的潛在有用的資料資訊提取方式。它使用廣泛,並且是眾多應用的技術基礎。 本文介紹那些使用Python資料探勘實踐用於發現和描述結構模式資料的工具。近些年來,Python在

《資料探勘核心技術揭祕》筆記

原先我對於資料探勘只停留在了爬蟲獲取資料,使用工具對資料進行清洗,然後整理彙總出需要的資訊的這個層次。看完這本書之後才發現了之前使用爬蟲得到資料只能叫做資料獲取,真正的資料探勘遠遠複雜,在資料探勘中有著那麼多的magic的演算法,其中每個單元的知識都需要一本書去好好學習,這裡只是簡單的介

python 資料分析 資料探勘 人工智慧 教程

python 資料分析 資料探勘 人工智慧 教程 python 資料分析 資料探勘 人工智慧 教程 資料分析 pyhon程式碼 資料分析英文教程 上百g資料,用於資料分析,大資料 新聞資料 產業資料 谷歌資料 維基百科等等 資料 統一解壓密碼 qq92313271

【Mark Schmidt課件】機器學習與資料探勘——特徵選擇

本課件的主要內容如下: 上次課程回顧:尋找“真實”模型 資訊準則 貝葉斯資訊準則 關於食物過敏 特徵選擇 全基因組關聯分析 “迴歸權重”方法 搜尋評分法 評分函式的選擇 “特徵數量”懲罰

【Mark Schmidt課件】機器學習與資料探勘——非線性迴歸

本課件主要內容包括: 魯棒迴歸 體育運動中的非線性級數 自適應計數/距離法 線性模型的侷限性 非線性特徵變換 一般多項式特徵(d = 1) 英文原文課件下載地址: http://page5.dfpan

【Mark Schmidt課件】機器學習與資料探勘——數值優化與梯度下降

本課件主要包括以下內容: 優化簡介 上次課程回顧:線性迴歸 大規模最小二乘 尋找區域性最小值的梯度下降法 二維梯度下降 存在奇異點的最小二乘 魯棒迴歸 基於L1-範數的迴歸 L1-範數的平滑近似