淺談作業系統對記憶體的管理

簡介

記憶體是計算機中最重要的資源之一,通常情況下,實體記憶體無法容納下所有的程序。雖然實體記憶體的增長現在達到了N個GB,但比實體記憶體增長還快的是程式,所以無論實體記憶體如何增長,都趕不上程式增長的速度,所以作業系統如何有效的管理記憶體便顯得尤為重要。本文講述作業系統對於記憶體的管理的過去和現在,以及一些頁替換的演算法的介紹。

對於程序的簡單介紹

在開始之前,首先從作業系統的角度簡單介紹一下程序。程序是佔有資源的最小單位,這個資源當然包括記憶體。在現代作業系統中,每個程序所能訪問的記憶體是互相獨立的(一些交換區除外)。而程序中的執行緒所以共享程序所分配的記憶體空間。

在作業系統的角度來看,程序=程式+資料+PCB(程序控制塊)。這個概念略微有點抽象,我通過一個類比來說吧:比如,你正在廚房做飯,你一邊看著菜譜一邊按照菜譜將原料做成菜,就在這時,你兒子進來告訴你他擦破了腿,此時你停下手中的工作,將菜譜反扣過來,然後找來急救書按照書中的內容給你兒子貼上創口貼,貼完後你繼續回去開啟菜譜,然後繼續做飯。在這個過程中,你就好比CPU,菜譜就好比程式,而做菜的原料就好比資料。你按照程式指令加工資料,而急救工作好比一個更高優先順序的程序,中斷了你當前做飯的工作,然後你將菜譜反扣過來(保護現場),轉而去處理高優先順序的程序,處理完畢後你繼續從剛才的頁讀菜譜(恢復現場),然後繼續執行做菜這個程序。

在簡單介紹完程序的概念後,我們來轉入記憶體。

沒有記憶體抽象的年代

在早些的作業系統中,並沒有引入記憶體抽象的概念。程式直接訪問和操作的都是實體記憶體。比如當執行如下指令時:

mov reg1,1000

這條指令會毫無想象力的將實體地址1000中的內容賦值給暫存器。不難想象,這種記憶體操作方式使得作業系統中存在多程序變得完全不可能,比如MS-DOS,你必須執行完一條指令後才能接著執行下一條。如果是多程序的話,由於直接操作實體記憶體地址,當一個程序給記憶體地址1000賦值後,另一個程序也同樣給記憶體地址賦值,那麼第二個程序對記憶體的賦值會覆蓋第一個程序所賦的值,這回造成兩條程序同時崩潰。

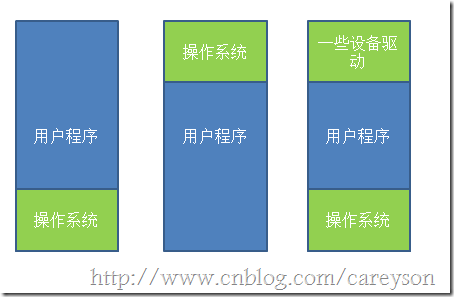

沒有記憶體抽象對於記憶體的管理通常非常簡單,除去作業系統所用的記憶體之外,全部給使用者程式使用。或是在記憶體中多留一片區域給驅動程式使用,如圖1所示。

圖1.沒有記憶體抽象時,對記憶體的使用

第一種情況作業系統存於RAM中,放在記憶體的低地址,第二種情況作業系統存在於ROM中,存在記憶體的高地址,一般老式的手機作業系統是這麼設計的。

如果這種情況下,想要作業系統可以執行多程序的話,唯一的解決方案就是和硬碟搞交換,當一個程序執行到一定程度時,整個存入硬碟,轉而執行其它程序,到需要執行這個程序時,再從硬碟中取回記憶體,只要同一時間記憶體中只有一個程序就行,這也就是所謂的交換(Swapping)技術。但這種技術由於還是直接操作實體記憶體,依然有可能引起程序的崩潰。

所以,通常來說,這種記憶體操作往往只存在於一些洗衣機,微波爐的晶片中,因為不可能有第二個程序去徵用記憶體。

記憶體抽象

在現代的作業系統中,同一時間執行多個程序是再正常不過的了。為了解決直接操作記憶體帶來的各種問題,引入的地址空間(Address Space),這允許每個程序擁有自己的地址。這還需要硬體上存在兩個暫存器,基址暫存器(base register)和界址暫存器(limit register),第一個暫存器儲存程序的開始地址,第二個暫存器儲存上界,防止記憶體溢位。在記憶體抽象的情況下,當執行

mov reg1,20

這時,實際操作的實體地址並不是20,而是根據基址和偏移量算出實際的實體地址程序操作,此時操作的實際地址可能是:

mov reg1,16245

在這種情況下,任何操作虛擬地址的操作都會被轉換為操作實體地址。而每一個程序所擁有的記憶體地址是完全不同的,因此也使得多程序成為可能。

但此時還有一個問題,通常來說,記憶體大小不可能容納下所有併發執行的程序。因此,交換(Swapping)技術應運而生。這個交換和前面所講的交換大同小異,只是現在講的交換在多程序條件下。交換的基本思想是,將閒置的程序交換出記憶體,暫存在硬碟中,待執行時再交換回記憶體,比如下面一個例子,當程式一開始時,只有程序A,逐漸有了程序B和C,此時來了程序D,但記憶體中沒有足夠的空間給程序D,因此將程序B交換出記憶體,分給程序D。如圖2所示。

圖2.交換技術

通過圖2,我們還發現一個問題,程序D和C之間的空間由於太小無法另任何程序使用,這也就是所謂的外部碎片。一種方法是通過緊湊技術(Memory Compaction)解決,通過移動程序在記憶體中的地址,使得這些外部碎片空間被填滿。還有一些討巧的方法,比如記憶體整理軟體,原理是申請一塊超大的記憶體,將所有程序置換出記憶體,然後再釋放這塊記憶體,從而使得從新載入程序,使得外部碎片被消除。這也是為什麼執行完記憶體整理會狂讀硬碟的原因。另外,使用緊湊技術會非常消耗CPU資源,一個2G的CPU沒10ns可以處理4byte,因此多一個2G的記憶體進行一次緊湊可能需要好幾秒的CPU時間。

上面的理論都是基於程序所佔的記憶體空間是固定的這個假設,但實際情況下,程序往往會動態增長,因此建立程序時分配的記憶體就是個問題了,如果分配多了,會產生內部碎片,浪費了記憶體,而分配少了會造成記憶體溢位。一個解決方法是在程序建立的時候,比程序實際需要的多分配一點記憶體空間用於程序的增長。一種是直接多分配一點記憶體空間用於程序在記憶體中的增長,另一種是將增長區分為資料段和棧(用於存放返回地址和區域性變數),如圖3所示。

圖3.建立程序時預留空間用於增長

當預留的空間不夠滿足增長時,作業系統首先會看相鄰的記憶體是否空閒,如果空閒則自動分配,如果不空閒,就將整個程序移到足夠容納增長的空間記憶體中,如果不存在這樣的記憶體空間,則會將閒置的程序置換出去。

當允許程序動態增長時,作業系統必須對記憶體進行更有效的管理,作業系統使用如下兩種方法之一來得知記憶體的使用情況,分別為1)點陣圖(bitmap) 2)連結串列

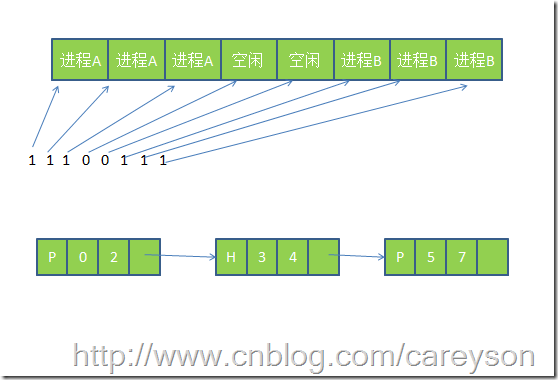

使用點陣圖,將記憶體劃為多個大小相等的塊,比如一個32K的記憶體1K一塊可以劃為32塊,則需要32位(4位元組)來表示其使用情況,使用點陣圖將已經使用的塊標為1,位使用的標為0.而使用連結串列,則將記憶體按使用或未使用分為多個段進行連結,這個概念如圖4所示。

圖4.點陣圖和連結串列表示記憶體的使用情況

使用連結串列中的P表示程序,從0-2是程序,H表示空閒,從3-4表示是空閒。

使用位圖表示記憶體簡單明瞭,但一個問題是當分配記憶體時必須在記憶體中搜索大量的連續0的空間,這是十分消耗資源的操作。相比之下,使用連結串列進行此操作將會更勝一籌。還有一些作業系統會使用雙向連結串列,因為當程序銷燬時,鄰接的往往是空記憶體或是另外的程序。使用雙向連結串列使得連結串列之間的融合變得更加容易。

還有,當利用連結串列管理記憶體的情況下,建立程序時分配什麼樣的空閒空間也是個問題。通常情況下有如下幾種演算法來對程序建立時的空間進行分配。

- 臨近適應演算法(Next fit)---從當前位置開始,搜尋第一個能滿足程序要求的記憶體空間

- 最佳適應演算法(Best fit)---搜尋整個連結串列,找到能滿足程序要求最小記憶體的記憶體空間

- 最大適應演算法(Wrost fit)---找到當前記憶體中最大的空閒空間

- 首次適應演算法(First fit) ---從連結串列的第一個開始,找到第一個能滿足程序要求的記憶體空間

虛擬記憶體(Virtual Memory)

虛擬記憶體是現代作業系統普遍使用的一種技術。前面所講的抽象滿足了多程序的要求,但很多情況下,現有記憶體無法滿足僅僅一個大程序的記憶體要求(比如很多遊戲,都是10G+的級別)。在早期的作業系統曾使用覆蓋(overlays)來解決這個問題,將一個程式分為多個塊,基本思想是先將塊0加入記憶體,塊0執行完後,將塊1加入記憶體。依次往復,這個解決方案最大的問題是需要程式設計師去程式進行分塊,這是一個費時費力讓人痛苦不堪的過程。後來這個解決方案的修正版就是虛擬記憶體。

虛擬記憶體的基本思想是,每個程序有用獨立的邏輯地址空間,記憶體被分為大小相等的多個塊,稱為頁(Page).每個頁都是一段連續的地址。對於程序來看,邏輯上貌似有很多記憶體空間,其中一部分對應實體記憶體上的一塊(稱為頁框,通常頁和頁框大小相等),還有一些沒載入在記憶體中的對應在硬碟上,如圖5所示。

圖5.虛擬記憶體和實體記憶體以及磁碟的對映關係

由圖5可以看出,虛擬記憶體實際上可以比實體記憶體大。當訪問虛擬記憶體時,會訪問MMU(記憶體管理單元)去匹配對應的實體地址(比如圖5的0,1,2),而如果虛擬記憶體的頁並不存在於實體記憶體中(如圖5的3,4),會產生缺頁中斷,從磁碟中取得缺的頁放入記憶體,如果記憶體已滿,還會根據某種演算法將磁碟中的頁換出。

而虛擬記憶體和實體記憶體的匹配是通過頁表實現,頁表存在MMU中,頁表中每個項通常為32位,既4byte,除了儲存虛擬地址和頁框地址之外,還會儲存一些標誌位,比如是否缺頁,是否修改過,防寫等。可以把MMU想象成一個接收虛擬地址項返回實體地址的方法。

因為頁表中每個條目是4位元組,現在的32位作業系統虛擬地址空間會是2的32次方,即使每頁分為4K,也需要2的20次方*4位元組=4M的空間,為每個程序建立一個4M的頁表並不明智。因此在頁表的概念上進行推廣,產生二級頁表,二級頁表每個對應4M的虛擬地址,而一級頁表去索引這些二級頁表,因此32位的系統需要1024個二級頁表,雖然頁表條目沒有減少,但記憶體中可以僅僅存放需要使用的二級頁表和一級頁表,大大減少了記憶體的使用。

頁面替換演算法

因為在計算機系統中,讀取少量資料硬碟通常需要幾毫秒,而記憶體中僅僅需要幾納秒。一條CPU指令也通常是幾納秒,如果在執行CPU指令時,產生幾次缺頁中斷,那效能可想而知,因此儘量減少從硬碟的讀取無疑是大大的提升了效能。而前面知道,實體記憶體是極其有限的,當虛擬記憶體所求的頁不在實體記憶體中時,將需要將實體記憶體中的頁替換出去,選擇哪些頁替換出去就顯得尤為重要,如果演算法不好將未來需要使用的頁替換出去,則以後使用時還需要替換進來,這無疑是降低效率的,讓我們來看幾種頁面替換演算法。

最佳置換演算法(Optimal Page Replacement Algorithm)

最佳置換演算法是將未來最久不使用的頁替換出去,這聽起來很簡單,但是無法實現。但是這種演算法可以作為衡量其它演算法的基準。

最近不常使用演算法(Not Recently Used Replacement Algorithm)

這種演算法給每個頁一個標誌位,R表示最近被訪問過,M表示被修改過。定期對R進行清零。這個演算法的思路是首先淘汰那些未被訪問過R=0的頁,其次是被訪問過R=1,未被修改過M=0的頁,最後是R=1,M=1的頁。

先進先出頁面置換演算法(First-In,First-Out Page Replacement Algorithm)

這種演算法的思想是淘汰在記憶體中最久的頁,這種演算法的效能接近於隨機淘汰。並不好。

改進型FIFO演算法(Second Chance Page Replacement Algorithm)

這種演算法是在FIFO的基礎上,為了避免置換出經常使用的頁,增加一個標誌位R,如果最近使用過將R置1,當頁將會淘汰時,如果R為1,則不淘汰頁,將R置0.而那些R=0的頁將被淘汰時,直接淘汰。這種演算法避免了經常被使用的頁被淘汰。

時鐘替換演算法(Clock Page Replacement Algorithm)

雖然改進型FIFO演算法避免置換出常用的頁,但由於需要經常移動頁,效率並不高。因此在改進型FIFO演算法的基礎上,將佇列首位相連形成一個環路,當缺頁中斷產生時,從當前位置開始找R=0的頁,而所經過的R=1的頁被置0,並不需要移動頁。如圖6所示。

圖6.時鐘置換演算法

最久未使用演算法(LRU Page Replacement Algorithm)

LRU演算法的思路是淘汰最近最長未使用的頁。這種演算法效能比較好,但實現起來比較困難。

下面表是上面幾種演算法的簡單比較:

| 演算法 | 描述 |

| 最佳置換演算法 | 無法實現,最為測試基準使用 |

| 最近不常使用演算法 | 和LRU效能差不多 |

| 先進先出演算法 | 有可能會置換出經常使用的頁 |

| 改進型先進先出演算法 | 和先進先出相比有很大提升 |

| 最久未使用演算法 | 效能非常好,但實現起來比較困難 |

| 時鐘置換演算法 | 非常實用的演算法 |

上面幾種演算法或多或少有一些區域性性原理的思想。區域性性原理分為時間和空間上的區域性性

1.時間上,最近被訪問的頁在不久的將來還會被訪問。

2.空間上,記憶體中被訪問的頁周圍的頁也很可能被訪問。

總結

本文簡單介紹了作業系統對記憶體的管理。這些基礎概念對於很多開發人員是很有幫助的。記憶體管理中還有一種分段式管理,也就是一個程序可以擁有多個獨立的邏輯地址,以後有時間了再補上一篇。