KITTI資料集測試

KITTI資料集是目前為止為數不多的機器人定位,製圖,導航演算法測試的資料集,使用成熟的資料集有利於和同行同類演算法進行比較,也不用花大量時間去採集自己的資料集。

本文主要目的就自己在使用KITTI資料集過程中遇到的問題進行總結,並從實際的角度出發讓我們如何儘快的將資料集用到自己的機器人導航演算法中進行測試。

一句話:儘快把KITTI資料用起來。

從KITTI主頁可以發現,KITTI資料集主要包括三個部分,相機和鐳射資料,calibration檔案,groundtruth位置。如何明白三個部分的資料構成和引數意義,將會是我們使用KITTI資料的關鍵。

接下來將從三個部分展開。

為了在機器人導航系統中方便測試,先將KITTI圖片資料轉到ROS系統相容的rosbag檔案,以便於做出一個通用的資料集藉口進行測試。

poses檔案其實已經很方便的展示了相機的位姿,為了全面,也為了記錄自己遇到問題過程,依然附上完整解釋。

描述了相機的引數,以及感測器之間的關係,理解引數將有利於用於其他SLAM系統中,比如DSO,SVO,ORB-SLAM。

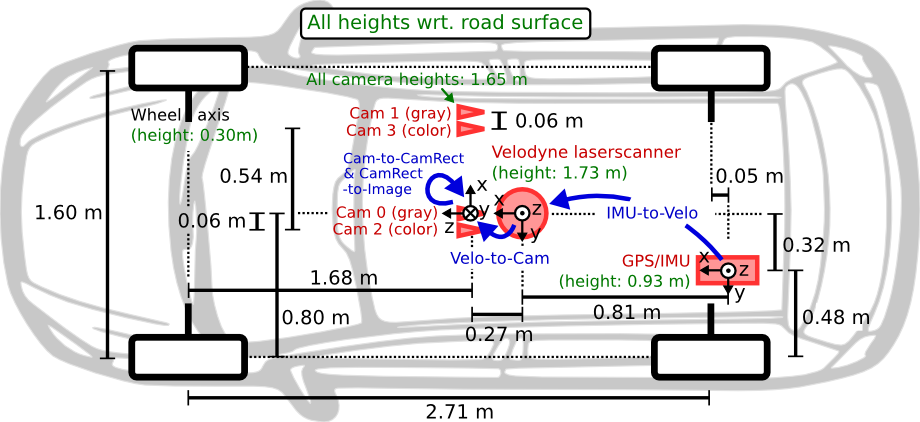

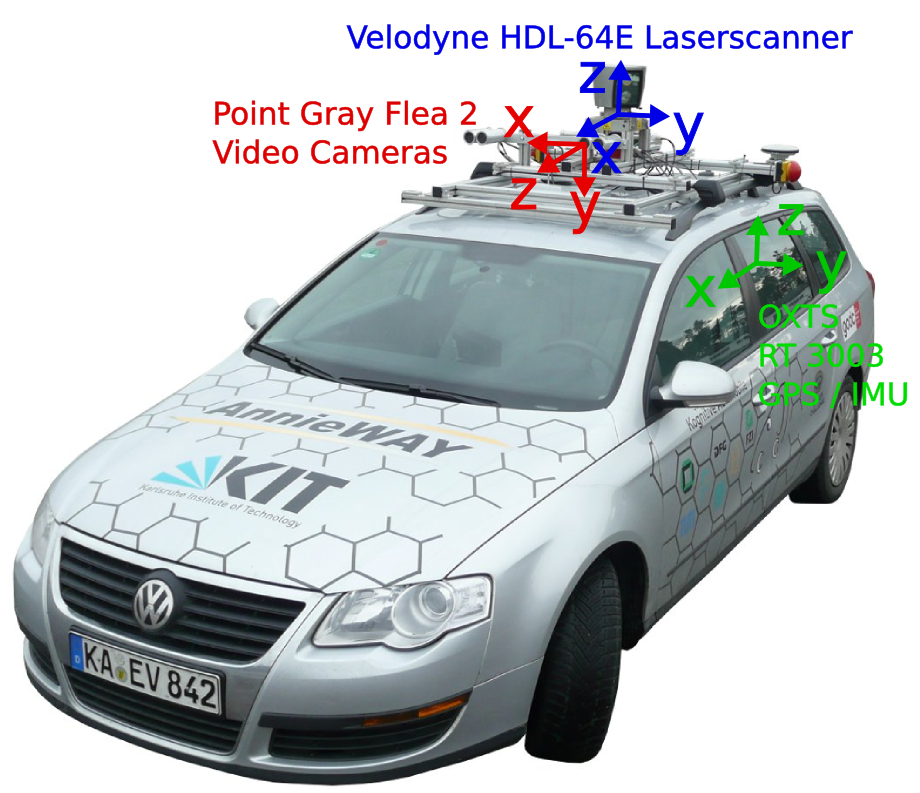

感測器設定如下圖所示:

相關推薦

KITTI資料集測試 :MATLAB繪製groundtruth 真實地圖

在poses目錄下,包含00.txt-10.txt 11個序列,每一個檔案包換Nx12個表格,N代表幀數。每一行利用3x4轉移矩陣代表左邊相機系統位姿,轉移矩陣將當前幀左邊相機系統中的一個點對映到第0幀的座標系統中。轉移矩陣中平移的部分表示當前相機位置(相對於第0幀)。 Groundtrut

KITTI資料集測試 :groundtruth 真實地圖

在poses目錄下,包含00.txt-10.txt 11個序列,每一個檔案包換Nx12個表格,N代表幀數。每一行利用3x4轉移矩陣代表左邊相機系統位姿,轉移矩陣將當前幀左邊相機系統中的一個點對映到第0幀的座標系統中。轉移矩陣中平移的部分表示當前相機位置(相對於第

KITTI資料集測試

KITTI資料集是目前為止為數不多的機器人定位,製圖,導航演算法測試的資料集,使用成熟的資料集有利於和同行同類演算法進行比較,也不用花大量時間去採集自己的資料集。 本文主要目的就自己在使用KITTI資料集過程中遇到的問題進行總結,並從實際的角度出發讓我們如何儘

Kitti資料集使用之坑

KITTI資料集簡介與使用: https://blog.csdn.net/solomon1558/article/details/70173223 接下來是我使用時遇到的坑: 一、label檔案中ry的含義 按照文件中圖示,ry應該是小車朝向和相機座標系z軸的夾角

Kitti資料集轉成VOC(xml)資料集格式

本文將kitti資料集中的檢測部分的資料標註轉換成voc格式的xml,用於生成caffe-ssd訓練的lmdb資料,具體資料集自己下載,標註圖片大概七千多張。 kitti格式標註及圖片轉voc格式標註及圖片(主要是扣掉了dontcare部分), 具體程式碼如下: #!/usr/bin

KITTI資料集--引數

一、kitti資料集,label解析 16個數代表的含義: 第1個字串:代表物體類別 'Car', 'Van', 'Truck','Pedestrian', 'Person_sitting', 'Cyclist','Tram', 'Misc' or

【深度學習】2個經典的練手CNN原始碼與MNIST資料集測試結果

對剛入門深度學習的童鞋,這2個簡單的工程可快速入門。建議手敲一遍,可快速熟悉程式碼和CNN的實現流程。 #1、匯入相關庫 import numpy as np import tensorflow as tf import matplotlib.pyplot as plt import inp

基於KITTI資料集的KERAS-YOLOV3實踐

資料整理 One row for one image; Row format: image_file_path box1 box2 … boxN; Box format: x_min,y_min,x_max,y_max,class_id (no spa

【輔助駕駛】KITTI鐳射資料與影象資料的融合MATLAB實現[2]——KITTI資料集簡介

一、選擇KITTI的原因 我知道並有使用的資料集只有CityScapes和KITTI,其中CityScapes主要包括語義分割資料,沒有鐳射雷達資料,Github關於雷達影象融合開原始碼找到的也是KITTI的程式碼。 二、資料集簡介 1、網址:http://www.cvlibs.ne

KITTI 資料集

欄位一:type物體類別:‘Car’, ‘Van’, ‘Truck’,‘Pedestrian’, ‘Person_sitting’, ‘Cyclist’,‘Tram’, ‘Misc’ or ‘DontCare’注意,’DontCare’ 標籤表示該區域沒有被標註,比如由於目標物體距離鐳射雷達太遠。為了防止

利用faster rcnn 訓練自己的資料集——kitti資料集

前言:非常感謝https://blog.csdn.net/flztiii/article/details/73881954,這篇部落格,本文主要參考這篇文章kitti資料集是一個車輛檢測的資料集資料集的準備Kitti資料集的下載只需要第一個圖片集(12G)和標註檔案即可【第一

SSD-Tensorflow:利用KITTI資料集進行訓練

# Copyright 2015 Paul Balanca. All Rights Reserved. # # Licensed under the Apache License, Version 2.0 (the "License"); # you may not use this file except

深度學習之路:(一)Keras中mnist資料集測試

Keras環境搭建 本地環境 MacOS 一、安裝Anaconda 1、下載Anaconda最新版本:官網下載地址 附:清華映象源 2、下載後直接安裝,點選next 3、檢測版本 開啟終端 輸入conda -

KITTI資料集簡介與使用

摘要:本文融合了Are we ready for Autonomous Driving? The KITTI Vision Benchmark Suite和Vision meets Robotics: The KITTI Dataset兩篇論文的內容,主要介紹KITTI資料

300W資料集測試MTCNN的landmark效果程式碼

300W資料集測試MTCNN的landmark效果,用提取其中afw資料集337張圖片的預測關鍵點並寫入到txt中,再用測試程式和標註landmark做對比。 處理得到的預測landmark格式如下: 1051618982(圖片名) 1(landmark個數) 543

KITTI資料集資料初體驗

KITTI簡介 KITTI資料集由德國卡爾斯魯厄理工學院和豐田美國技術研究院聯合創辦,是目前國際上最大的自動駕駛場景下的計算機視覺演算法評測資料集。該資料集用於評測立體影象(stereo),光流(optical flow),視覺測距(visual odo

Tensorflow mnist 資料集測試程式碼 + 自己下載資料

import tensorflow as tf from tensorflow.examples.tutorials.mnist import input_data # 自己下載 MNIST_data 資料集, csdn 上下載很快 mnist_dat

ubuntu下caffe實戰---mnist資料集測試

測試用到手寫體識別模型LeNet,mnist資料集 其中LeNet是一種CNN模型,由一個卷積層、後面跟一個下采樣層、再跟另外一個卷積層和另一個下采樣層,再之後是兩個全連線層組成。 mnist資料集:包括60000個訓練集和10000個驗證集 訓練過程: 1.下載mni

mxnet卷積神經網路訓練MNIST資料集測試

import numpy as np import mxnet as mx import logging logging.getLogger().setLevel(logging.DEBUG) batch_size = 100 mnist = mx.test_utils

SSD: Single Shot MultiBox Detector 訓練KITTI資料集(1)

前言 之前介紹了SSD的基本用法和檢測單張圖片的方法,那麼本篇部落格將詳細記錄如何使用SSD檢測框架訓練KITTI資料集。SSD專案中自帶了用於訓練PASCAL VOC資料集的指令碼,基本不用做修改就可以輕鬆完成訓練;但是想要訓練其他資料集比如KITTI,則