java爬取鬥魚:與虎牙對比

阿新 • • 發佈:2019-02-06

看了下鬥魚的基礎頁面,感覺和虎牙的有點像,但是實際上確有點不同。

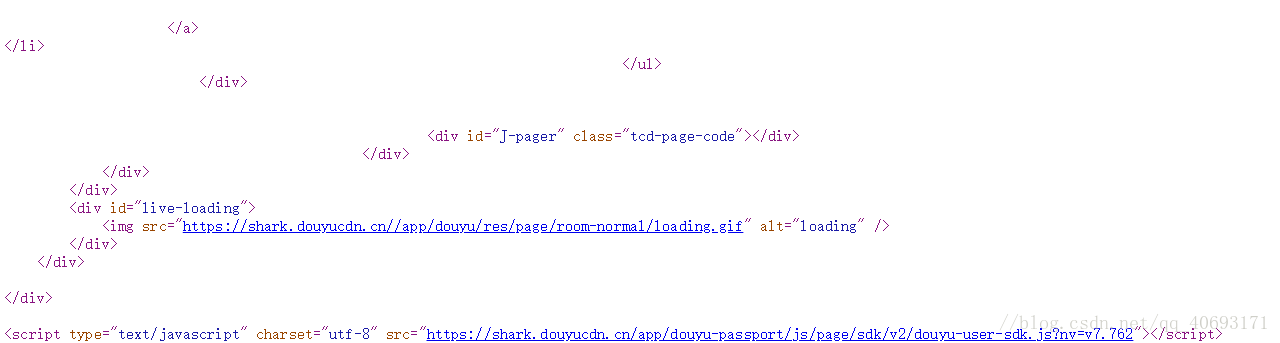

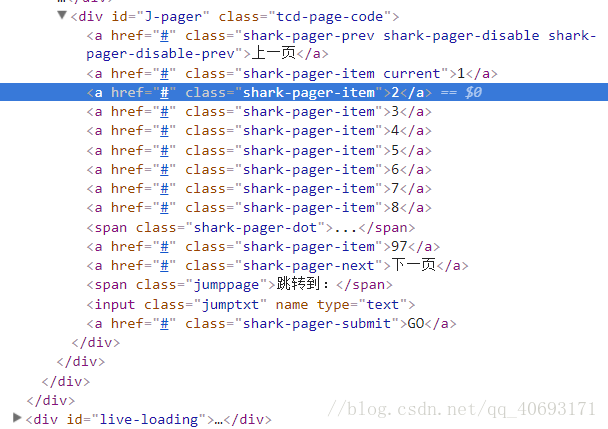

首先想要獲取頁數,看了鬥魚的html頁面,發現卻不顯示頁面。

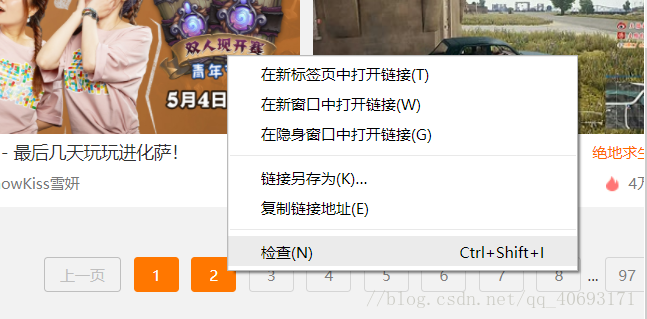

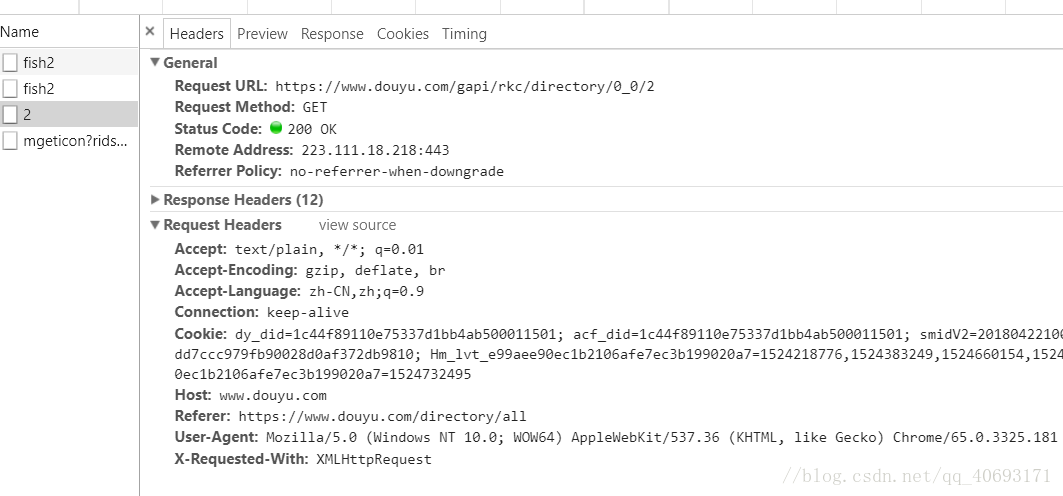

這是因為鬥魚把介面藏在了js頁面中,谷歌瀏覽器的右擊檢查

那麼接下來就是選取一款可以解析js的工具並且提取裡面的資訊了。jsoup不支援js的提取,我們用htmlunit實現。抓取頁面數。

*/

詳細看程式碼

/*

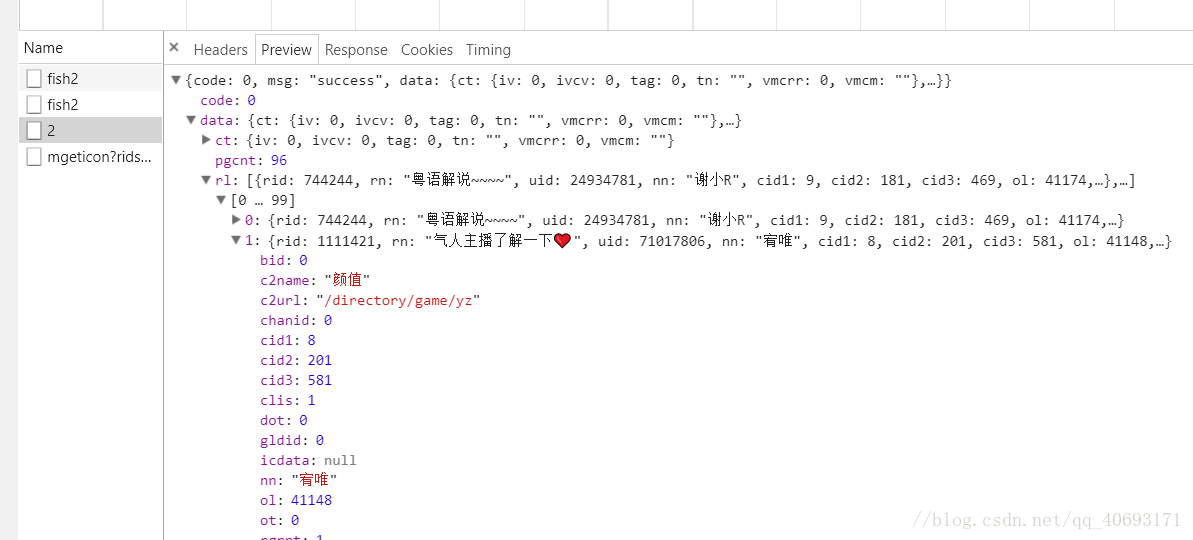

假設我們已經獲取了頁面總數,下一步需要執行的是模擬訪問,請求url解析資料,查詢json檔案

對沒錯,資料就再這個檔案裡,再檢視請求

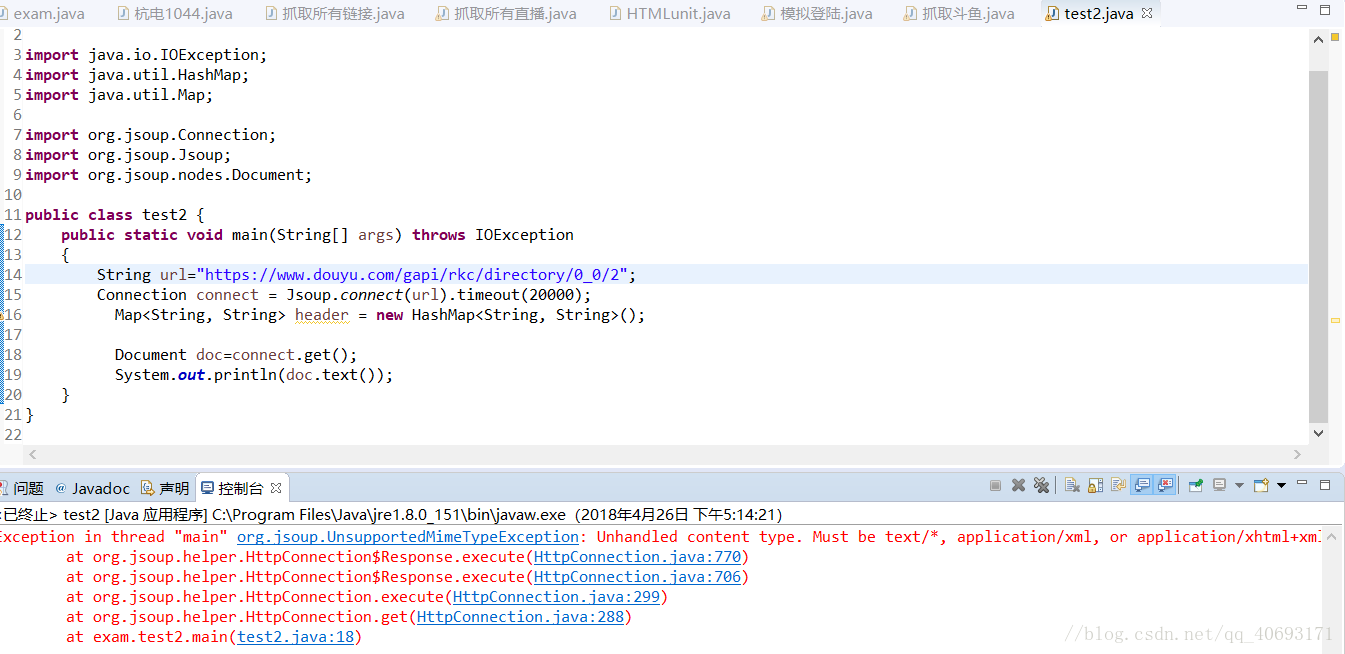

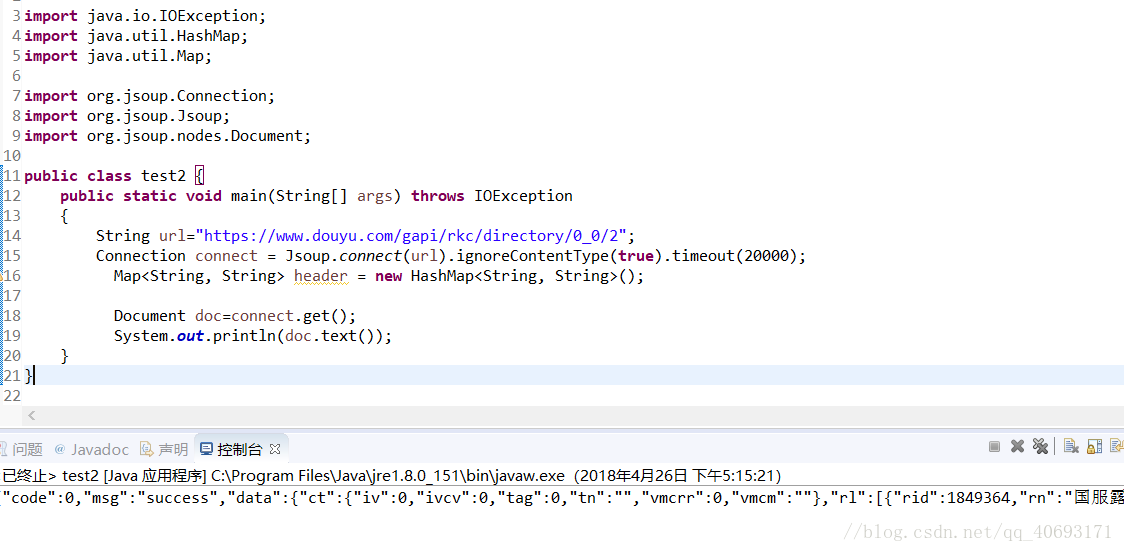

你會發現這個請求和抓取虎牙的不一樣!但是細心一點你會發現request url有規律可循,這個爬取就需要我們拼湊地址。唯一不同的就是結尾。我們先試著訪問下這個檔案。

發現報錯了,百度查明原因少了ignoreContentType(true)。

這樣就成功訪問這個json串了,剩下的就是根據需求,爬取你想要的資訊了

import java.io.IOException;

import java.sql.DriverManager;

import java.sql.PreparedStatement;

import java.sql.SQLException;

import java.util.ArrayList;

import java.util.HashMap;

import java.util.List;

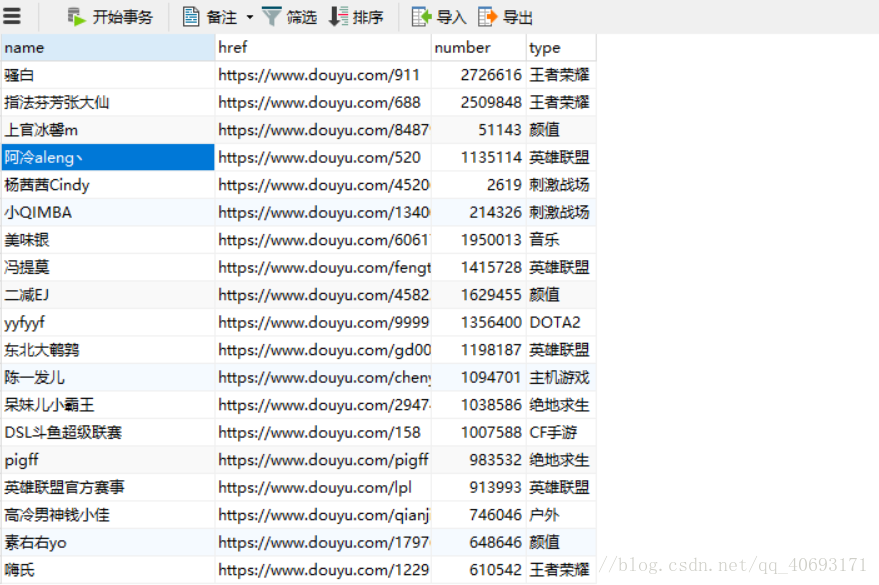

import java.util 別忘記try catch。這樣,資料就存在mysql中了

晚上都是大主播呢!同理,如果想爬取他們直播間彈幕,也可以進入他的直播間試試找到他的json檔案。不過那個可能處理會很麻煩。