機器學習之神經網路bp演算法推導

這是一篇學習UFLDL反向傳導演算法的筆記,按自己的思路捋了一遍,有不對的地方請大家指點。

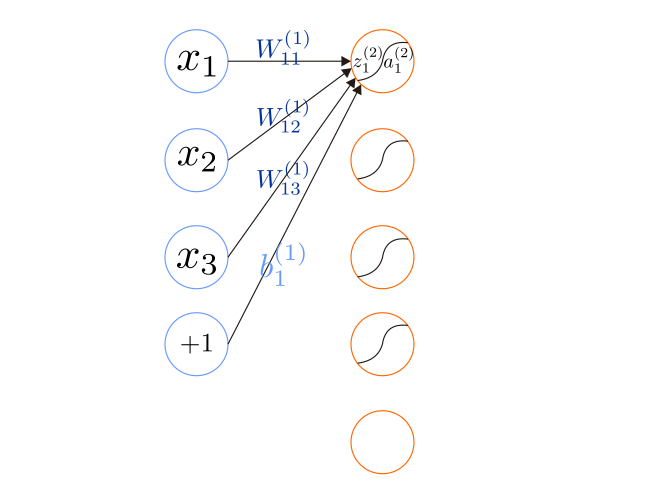

首先說明一下神經網路的符號:

1.

2.

3.

4.

第二層各神經元的計算方法如下:

我們可以將其向量化表示:

這裡的矩陣

相關推薦

機器學習之神經網路bp演算法推導

這是一篇學習UFLDL反向傳導演算法的筆記,按自己的思路捋了一遍,有不對的地方請大家指點。 首先說明一下神經網路的符號: 1. nl 表示神經網路的層數。 2. sl 表示第 l 層神經元個數,不包含偏置單元。 3. z(l)i 表示第 l 層第 i 個

機器學習入門-神經網路&BP演算法的實現

在MP神經元模型之中,神經元接收到來自其它n個神經元傳遞過來的輸入訊號,這些輸入訊號通過帶權重的連線2進行傳遞,神經元接收到的總輸入值與神經元的閾值進行比較,然後通過啟用函式處理以產生神經元的輸出。一般而言選取sigmoid函式作為啟用函式來使用,因為其相對啟用

深度學習-神經網路 BP 演算法推導過程

BP 演算法推導過程 一.FP過程(前向-計算預測值) 定義sigmoid啟用函式 import numpy as np def sigmoid(z): return 1.0 / (1 + np.exp(-z)) 輸入層值和 標籤結果 l = [5.0, 10.0] y = [0.01,

機器學習之神經網路及python實現

神經網路在機器學習中有很大的應用,甚至涉及到方方面面。本文主要是簡單介紹一下神經網路的基本理論概念和推算。同時也會介紹一下神經網路在資料分類方面的應用。 首先,當我們建立一個迴歸和分類模型的時候,無論是用最小二乘法(OLS)還是最大似然值(MLE)都用來使得殘差達到最小。因此我們在建立模型的時候,都會有一個l

機器學習之神經網路:離線安裝tensorflow

Python學習中安裝方面是一個大坑,後面我會把所有的安裝過程都總結下來,這裡先推送一個tensorflow的安裝,大家不用慌,按照下面的過程一步一步來. 1、 準備工作 電腦安裝好anaconda,python(python,我是強烈推薦使用anaconda,

系統學習機器學習之神經網路(十一) --TDNN

近來在瞭解卷積神經網路(CNN),後來查到CNN是受語音訊號處理中時延神經網路(TDNN)影響而發明的。本篇的大部分內容都來自關於TDNN原始文獻【1】的理解和整理。該文寫與1989年,在識別"B", "D", "G"三個濁音中得到98.5%的準確率,高於HMM的93.7%。是CNN的先驅。 &

機器學習之神經網路(機器學習技法)

神經網路的動機感知器的線性融合前面我們知道了將簡單的模型進行融合之後會得到一個非常強大的模型。我們試著將感知器(簡單的二元分類模型)做線性融合之後得到下圖:其中每一個節點都是一個感知器,其第一層的感知器都是由前一層X向量與W權重的線性組合,而第二層的感知器又是由前一層的得到的

python3__機器學習__神經網路基礎演算法__偏執項b

1.前言 很多人不明白為什麼要在神經網路、邏輯迴歸中要在樣本X的最前面加一個1,使得 X=[x1,x2,…,xn] 變成 X=[1,x1,x2,…,xn] 。因此可能會犯各種錯誤,比如漏了這個1,或者錯誤的將這個1加到W·X的結果上,導致模型出各種bug甚至

python3__機器學習__神經網路基礎演算法__反向傳播演算法

1.反饋神經網路原理及公式推導 梯度下降演算法在衡量模型的優劣的過程中,需要計算梯度,即求不同權重的偏導數。因此,當隱層神經元個數增加(權重個數增加)或隱層個數增加(求導過程拉長)會大大拉長計算過程,即很多偏導數的求導過程會反覆涉及到,因此在實際中對於權值達到上十萬和上百萬的神經網路

python3__機器學習__神經網路基礎演算法__最小二乘法(LS演算法)

1.LS演算法說明 LS演算法是一種數學優化技術,也是一種機器學習常用演算法。他通過最小化誤差的平方和尋找資料的最佳函式匹配。利用最小二乘法可以簡便的求得未知的資料(1),並使得這些求得的資料與實際資料之間誤差的平方和最小。除此之外最小二乘法還可用於曲線擬合(2),其他一些優化問題(

python3__機器學習__神經網路基礎演算法__梯度下降演算法

1.概述 【說明】 梯度下降演算法(Gradient Descent Optimization)是神經網路模型訓練最常用的優化演算法(n緯問題求最優解,梯度下降是最常用的方法);對於深度學習模型,基本都是採用梯度下降演算法來進行優化訓練。 【場景假設】 一人被困山上

系統學習機器學習之神經網路(四) --SOM

轉自:http://blog.csdn.net/xbinworld/article/details/50818803,其實內容更多的是百度文庫裡叫《SOM自組織特徵對映神經網路》這篇文章上的,博主增加了一些理解。 本文詳細介紹一下自組織神經網路概念和原理,並重點介紹一下自組

系統學習機器學習之神經網路(十二) --人工神經網路總結

本來這篇還缺個RBM,但RBM在DBN中使用,暫時放在深度學習那裡。這裡看到一篇非常好的總結,儲存下來。 轉自:http://blog.csdn.net/fengbingchun/article/details/50274471 本文主要對人工神經網路基礎進行了描述,主要包

python機器學習之神經網路(二)

來自:http://blog.csdn.net/cui134/article/details/26823101 由於Rosenblatt感知器的侷限性,對於非線性分類的效果不理想。為了對線性分類無法區分的資料進行分類,需要構建多層感知器結構對資料進行分類,多層感

【機器學習】神經網路及BP推導

1 前向傳播 這裡的推導都用矩陣和向量的形式,計算單個變數寫起來太麻煩。矩陣、向量求導可參見上面參考的部落格,個人覺得解釋得很直接很好。 前向傳播每一層的計算如下: z(l+1)=W(l,l+1)a(l)+b(l,l+1)(1.1) a(l+

機器學習_3.神經網路之CNN

卷積神經網路 卷積神經網路(Convoltional Neural Networks, CNN)是一類包含卷積或相關計算且具有深度結構的前饋神經網路(Feedforward Neural Networks),是深度學習(deep learning)的代表演算法之一

機器學習_2.神經網路之DBN

深度信念網路(DBN) 深度信念網路是一個概率生成模型,與傳統的判別模型的神經網路相對,生成模型是建立一個觀察資料和標籤之間的聯合分佈,對P(Observation|Label)和 P(Label|Observation)都做了評估,而判別模型僅僅而已評估了後者,也就是P(Label|O

深度學習之神經網路(CNN/RNN/GAN)演算法原理+實戰目前最新

第1章 課程介紹 深度學習的導學課程,主要介紹了深度學習的應用範疇、人才需求情況和主要演算法。對課程章節、課程安排、適用人群、前提條件以及學習完成後達到的程度進行了介紹,讓同學們對本課程有基本的認識。 1-1 課程導學 第2章 神經網路入門 本次實戰課程的入門課程。對機器學習和深度學習做了引入

吳恩達機器學習筆記-神經網路的代價函式和反向傳播演算法

代價函式 在神經網路中,我們需要定義一些新的引數來表示代價函式。 L = total number of layers in the network $s_l$ = number of units (not counting bias unit) in layer

深度學習之神經網路(CNN/RNN/GAN) (演算法原理+實戰) 完整版下載

第1章 課程介紹 深度學習的導學課程,主要介紹了深度學習的應用範疇、人才需求情況和主要演算法。對課程章節、課程安排、適用人群、前提條件以及學習完成後達到的程度進行了介紹,讓同學們對本課程有基本的認識。 第2章 神經網路入門 本次實戰課程的入門課程。對機器學習和深