Hive自定義函式

當Hive提供的內建函式無法滿足你的業務處理需要時,此時就可以考慮使用使用者自定義函式(UDF:user-defined function)。

Hive目前只支援用java語言書寫自定義函式。如果需要採用其他語言,比如Python,可以考慮上一節提到的transform語法來實現。

Hive支援三種自定義函式,我們逐個講解。

UDF

這是普通的使用者自定義函式。接受單行輸入,併產生單行輸出。

編寫java程式碼如下:

package com.oserp.hiveudf;

import org.apache.hadoop.hive.ql.exec.UDF;

import org.apache.hadoop.io.Text;

public classPassExam extendsUDF {

publicText evaluate(Integer score)

{

Text result = new Text();

if(score < 60)

result.set("Failed");

else

result.set("Pass");

return result;

}

}

然後,打包成.jar檔案,比如hiveudf.jar。

執行以下語句:

add jar /home/user/hadoop_jar/hiveudf.jar;

create temporary function pass_scorecom.oserp.hiveudf.PassExam;

select stuNo,pass_score(score) from student;

輸出結果為:

N0101 Pass

N0102 Failed

N0201 Pass

N0103 Pass

N0302 Pass

N0202 Pass

N0203 Pass

N0301 Failed

N0306 Pass

第一個語句註冊jar檔案;第二個語句為自定義函式取別名;第三個語句呼叫自定義函式。

Java程式碼中,自定義函式的類繼承自UDF類,且提供了一個evaluate方法。這個方法接受一個整數值作為引數,並返回字串。結構十分明瞭。其中的evaluate方法並沒有作為interface提供,因為實際使用時,函式的引數個數及型別是多變的。

以上UDF名稱是不區分大小寫的,比如呼叫時寫成PASS_SCORE也是可以的(因為它是hive中的別名,不是java類名)。

使用完成後,可呼叫以下語句刪除函式別名:

Drop temporary function pass_score;

UDAF

使用者定義聚集函式(User-defined aggregate function)。接受多行輸入,併產生單行輸出。比如MAX,COUNT函式。

編寫以下Java程式碼:

packagecom.oserp.hiveudf;

importorg.apache.hadoop.hive.ql.exec.UDAF;

importorg.apache.hadoop.hive.ql.exec.UDAFEvaluator;

importorg.apache.hadoop.hive.serde2.io.DoubleWritable;

importorg.apache.hadoop.io.IntWritable;

publicclass HiveAvgextends UDAF {

public staticclass AvgEvaluate implements UDAFEvaluator

{

public staticclass PartialResult

{

public intcount;

public doubletotal;

public PartialResult()

{

count = 0;

total = 0;

}

}

private PartialResultpartialResult;

@Override

public voidinit() {

partialResult = new PartialResult();

}

public booleaniterate(IntWritable value)

{

// 此處一定要判斷partialResult是否為空,否則會報錯

// 原因就是init函式只會被呼叫一遍,不會為每個部分聚集操作去做初始化

//此處如果不加判斷就會出錯

if (partialResult==null)

{

partialResult =new PartialResult();

}

if (value !=null)

{

partialResult.total =partialResult.total +value.get();

partialResult.count=partialResult.count + 1;

}

return true;

}

public PartialResult terminatePartial()

{

returnpartialResult;

}

public booleanmerge(PartialResult other)

{

partialResult.total=partialResult.total + other.total;

partialResult.count=partialResult.count + other.count;

return true;

}

public DoubleWritable terminate()

{

return newDoubleWritable(partialResult.total /partialResult.count);

}

}

}

然後打包成jar檔案,比如hiveudf.jar。

執行以下語句:

add jar/home/user/hadoop_jar/hiveudf.jar;

create temporary function avg_udf as'com.oserp.hiveudf.HiveAvg';

select classNo, avg_udf(score) from studentgroup by classNo;

輸出結果如下:

C01 68.66666666666667

C02 80.66666666666667

C03 73.33333333333333

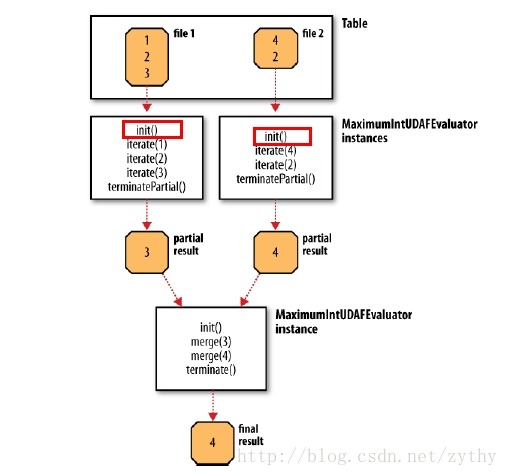

參照以上圖示(來自Hadoop權威教程)我們來看看各個函式:

l Init在類似於建構函式,用於UDF的初始化。

注意上圖中紅色框中的init函式。在實際執行中,無論hive將記錄集劃分了多少個部分去做(比如上圖中的file1和file2兩個部分),init函式僅被呼叫一次。所以上圖中的示例是有歧義的。這也是為什麼上面的程式碼中加了特別的註釋來說明。或者換一句話說,init函式中不應該用於初始化部分聚集值相關的邏輯,而應該處理全域性的一些資料邏輯。

l Iterate函式用於聚合。當每一個新的值被聚合時,此函式被呼叫。

l TerminatePartial函式在部分聚合完成後被呼叫。當hive希望得到部分記錄的聚合結果時,此函式被呼叫。

l Merge函式用於合併先前得到的部分聚合結果(也可以理解為分塊記錄的聚合結果)。

l Terminate返回最終的聚合結果。

我們可以看出merge的輸入引數型別和terminatePartial函式的返回值型別必須是一致的。

UDTF

使用者定義表生成函式(User-defined table-generating function)。接受單行輸入,併產生多行輸出(即一個表)。不是特別常用,此處不詳述。