低秩表示的學習--Latent Low-Rank Representation(LatLLR)

最近讀了LLR(Low Rank Representation)的文章,所以整理一下。本文的主線是LLR-->LantLLR-->RobustLLR

一、低秩表示

剛開始接觸低秩表示是看到一篇論文裡面對公式進行了低秩約束,感覺很好奇,查了一下後,發現低秩很神奇,可以將噪聲和乾淨資料自動分割出來。因為這一部分比較基礎所以參考一篇中文論文[1]

稀疏表示也是將資料集矩陣表示成字典的線性組合,但是不同的是稀疏表示希望係數是稀疏的。

舉例:

可以把Ui理解為空間裡的基,然後Q是係數,相當於座標點,20個4維的座標點。X是100個數據,隨機選20個加噪聲,最後用低秩表示,可以看到相似度矩陣的塊效應非常顯著,這個和定義的5個子空間是吻合,這說明,對子空間的分割具有魯棒性,同時可以看到近乎完美的恢復了噪聲,所以具有良好的去噪性。

二、低秩子空間恢復的聯合稀疏表示

本部分參考的論文也是一篇中文論文[2]

最後計算測試樣本對各類訓練樣本的殘差,測試樣本屬於殘差最小的那個類。

三、Latent Low-Rank Representation(LatLLR)[3]

下面按照這兩個問題討論

1)無噪聲資料

先給出一個定理並證明

接下來還是用舉例證明

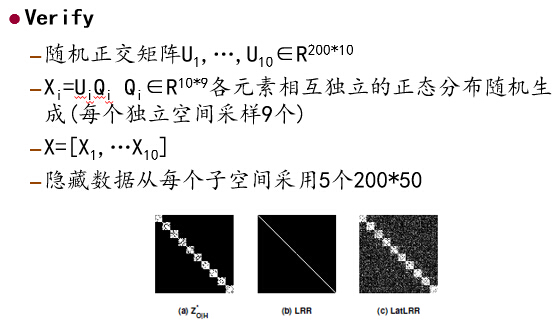

一共是10個空間,選擇了9個所以樣本是不充分的,但是我們使用lantLLR,從效果可以看出能魯棒的分割出9個子空間,其中b圖因為是不充分的LLR只能是對角線為1矩陣。

本例中樣本是充分的,只是在噪聲不同的情況下,比較LLR和LatLLR

最後一部分是在真實場景中的實驗應用

三種不同的點代表不同的空間,紅色左右轉,藍色的上下轉,黃色的不動。

整個視訊序列是29幀,459個點,3個motion,一個motion對應一個子空間

[1]史加榮,低秩矩陣恢復演算法綜述,[J]計算機應用研究,2013

[2]胡正平,基於低秩子空間恢復的聯合稀疏表示人臉識別演算法,[J]電子學報,2013

[3]Guangcan Liu, Latent Low-Rank Representation for Subspace Segmentation and Feature Extraction,ICCV,2011