斯坦福大學-自然語言處理與深度學習(CS224n) 筆記 第六課 依存句法分析

阿新 • • 發佈:2019-02-12

課程概要

1、句法結構:成分句法、依存句法

2、依存語法

3、 Transition-based依存句法分析

4、神經網路的依存句法分析

一、句法結構:成分句法、依存句法

二、依存語法

三、Transition-based依存句法分析

四、神經網路的依存句法分析

- 為什麼我們要在這個領域引入神經網路?

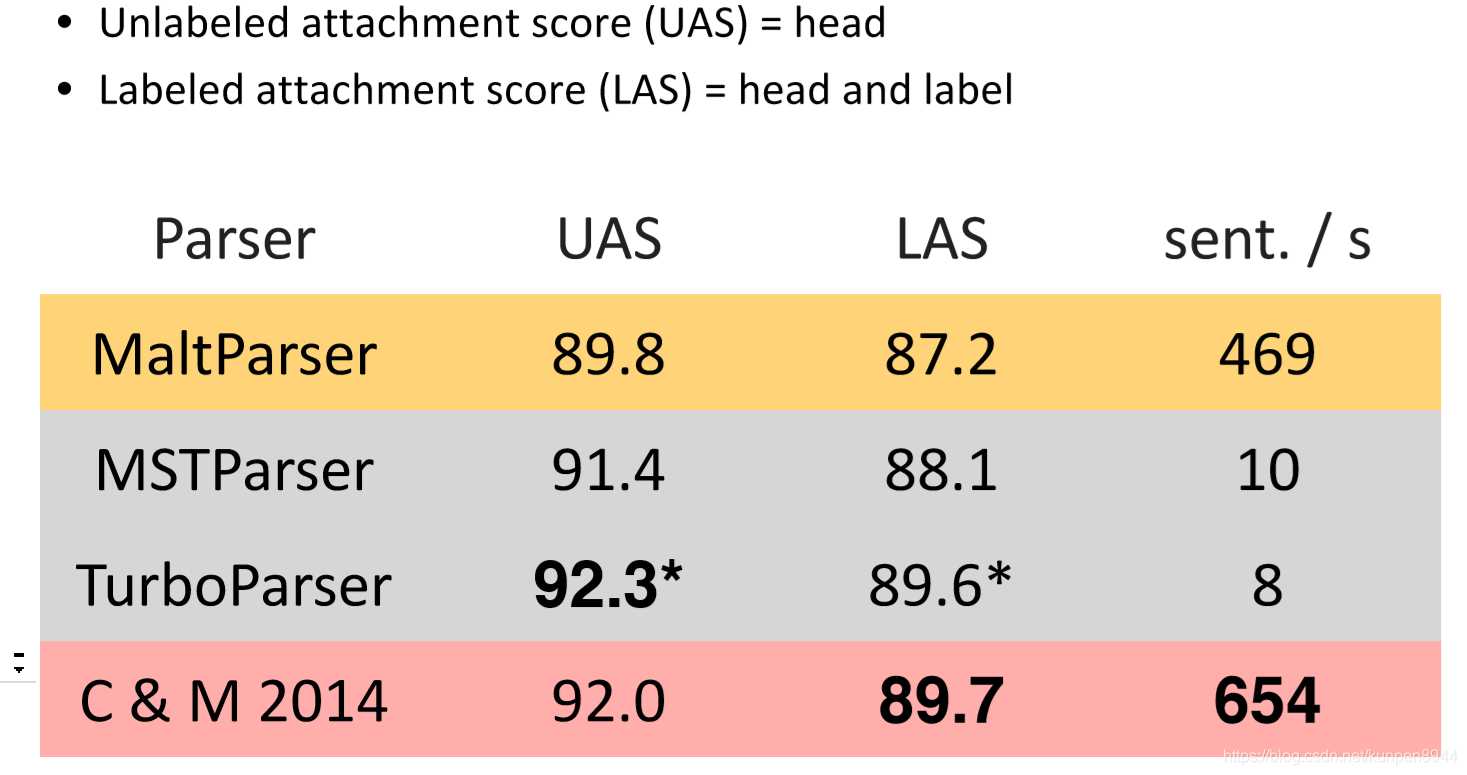

因為在Transition-based依存句法分析中,我們面臨一些問題:特徵稀疏,很多特徵只出現很少幾次,導致我們會花費95%的時間在特徵計算上。所以我們希望使用一個更稠密的,更可比的特徵表示。 - 從實踐的結果來看,這樣模型的效果也是很好的(Chen and Manning 2014,為下圖紅色的部分)

- 分佈的表徵

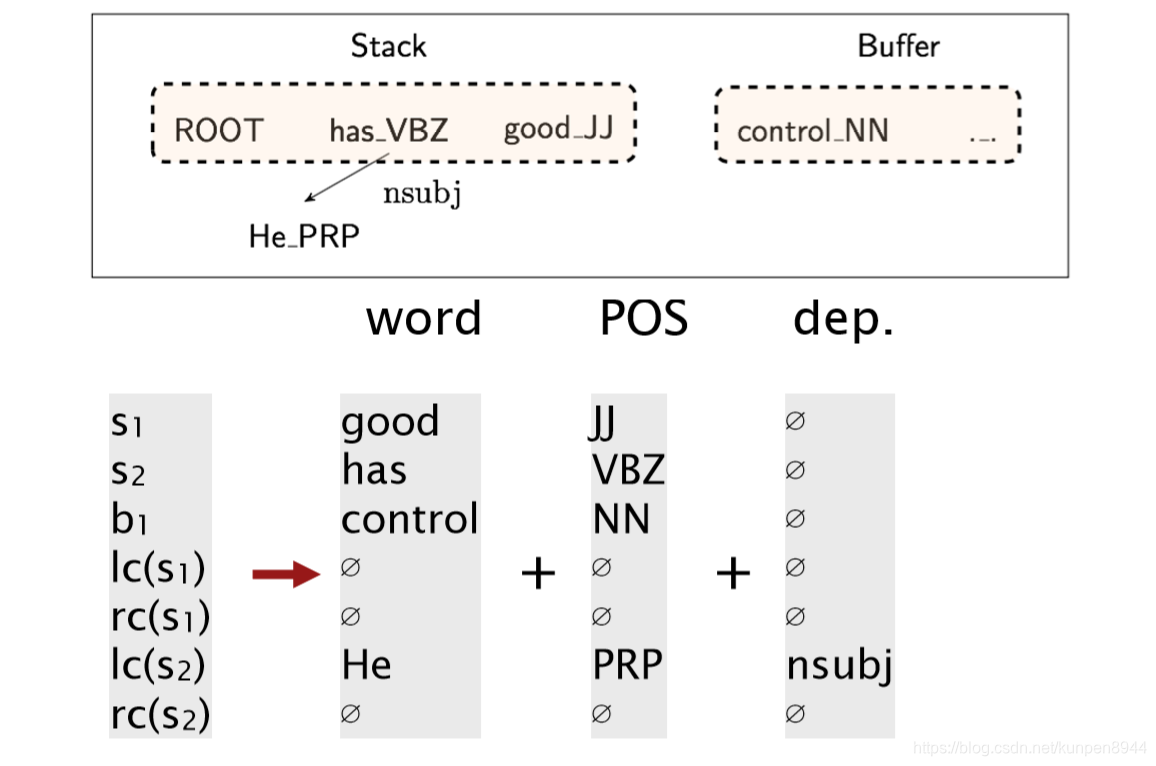

我們使用了d維的稠密向量來代表每一個單詞,相似的單詞會有更近的向量。同時詞性和依存關係也用稠密的向量來表示,向量之間更近的距離也表示語義上的一些相近。比如NNS(名詞複數)接近於NN(名詞單數)

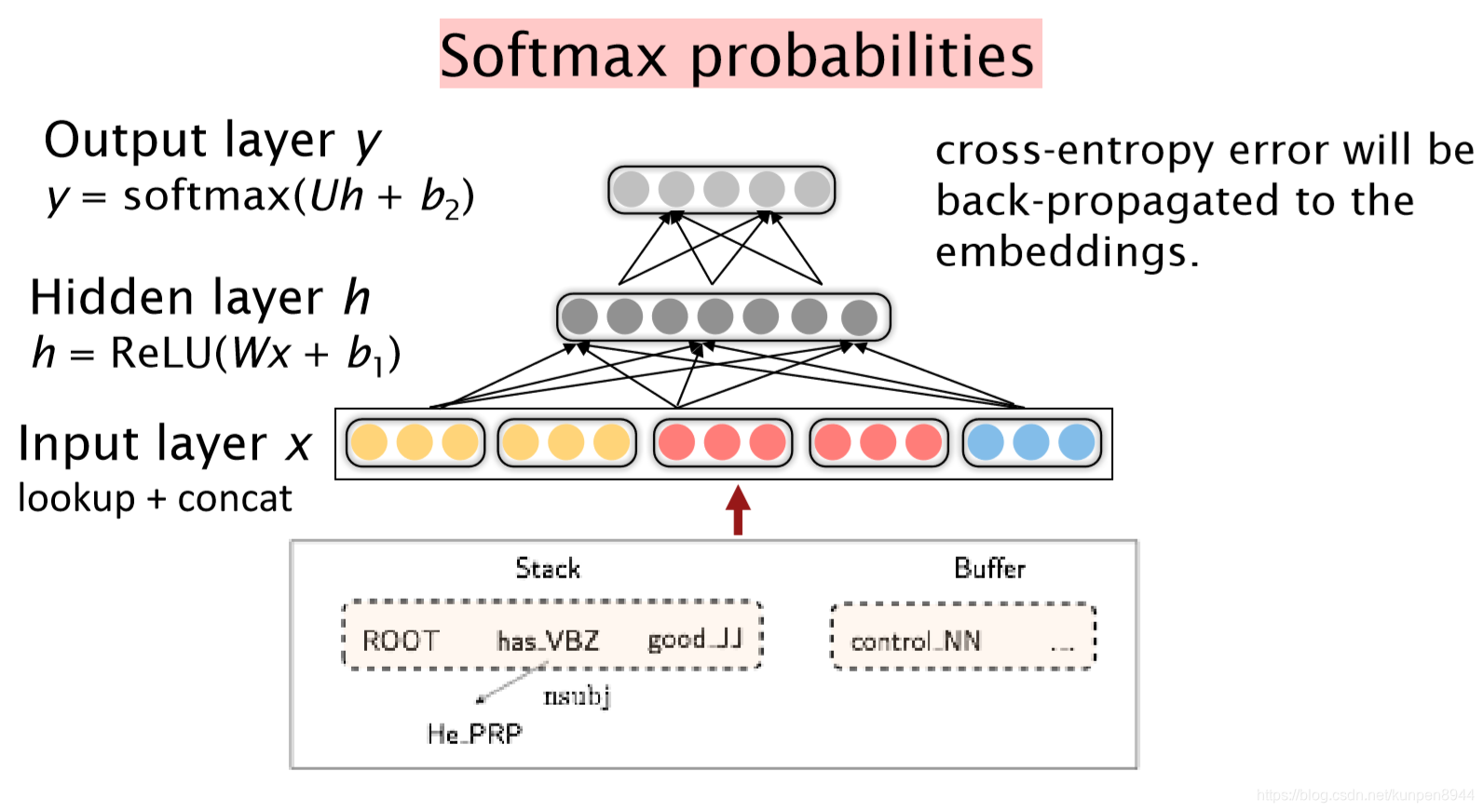

基於他們在buffer(儲存區)和stack(棧)的位置來抽取token,將他們轉換成為向量表徵,併合並起來。

- 模型結構

一層輸入是連線一起來的向量,一層隱層,一層輸出。損失函式是交叉熵。

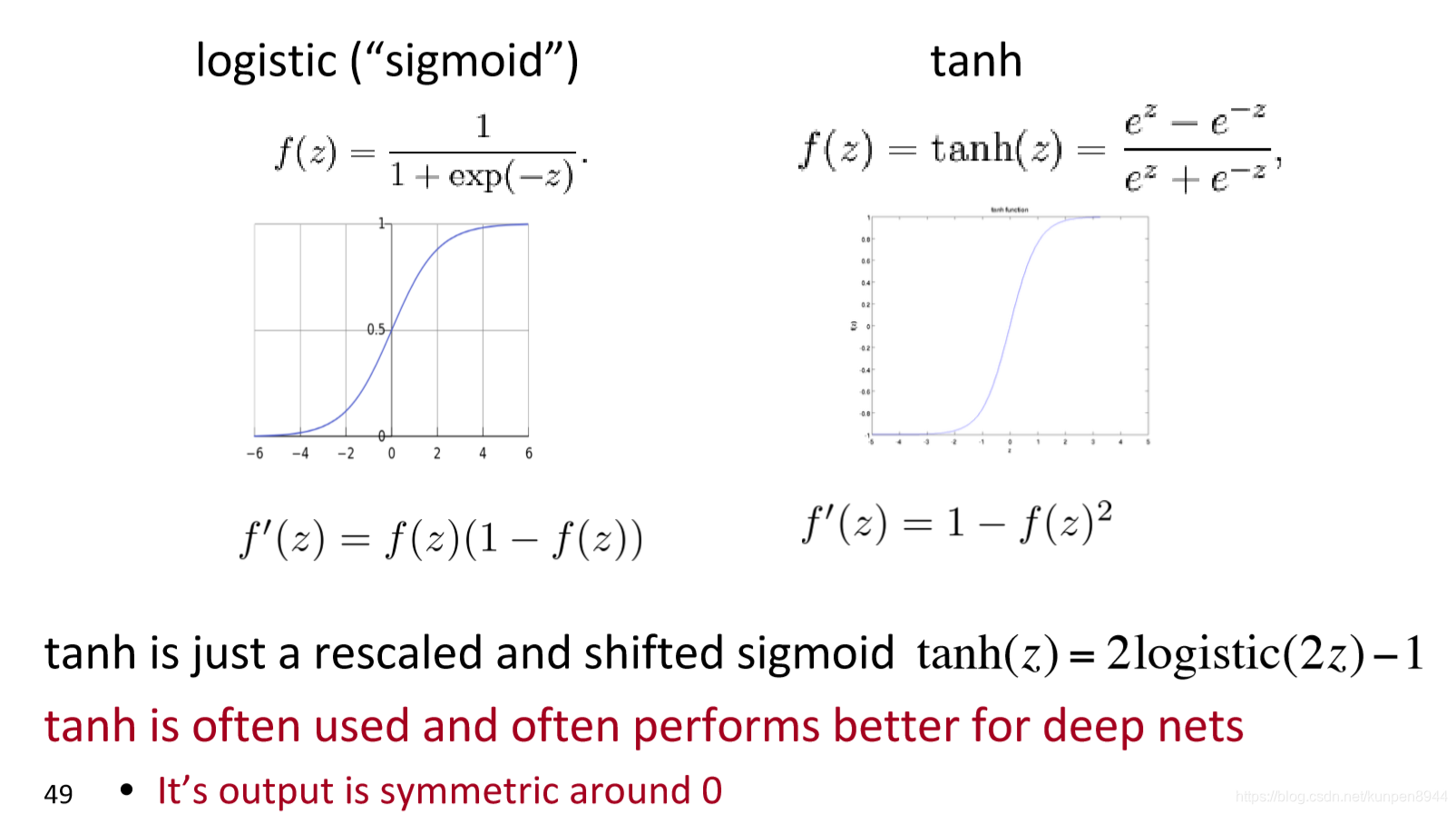

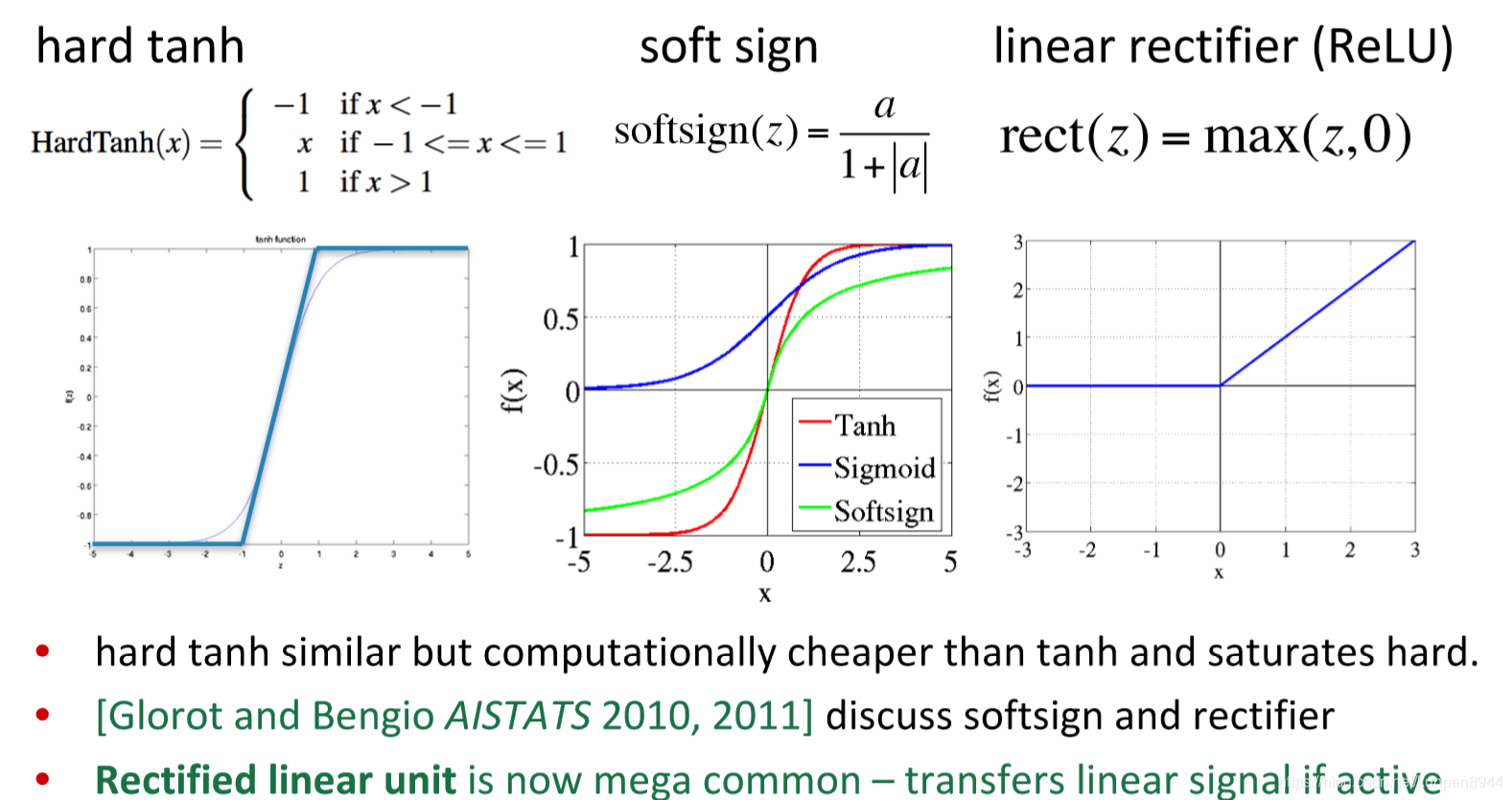

- 關於啟用函式的介紹:下面有幾種常見的啟用函式

tanh就是sigmoid在規模上和位置上的變形產生的,輸出是對0對稱,在深度學習中表現的很好。

ReLU是目前最流行的啟用函式

- 進一步拓展

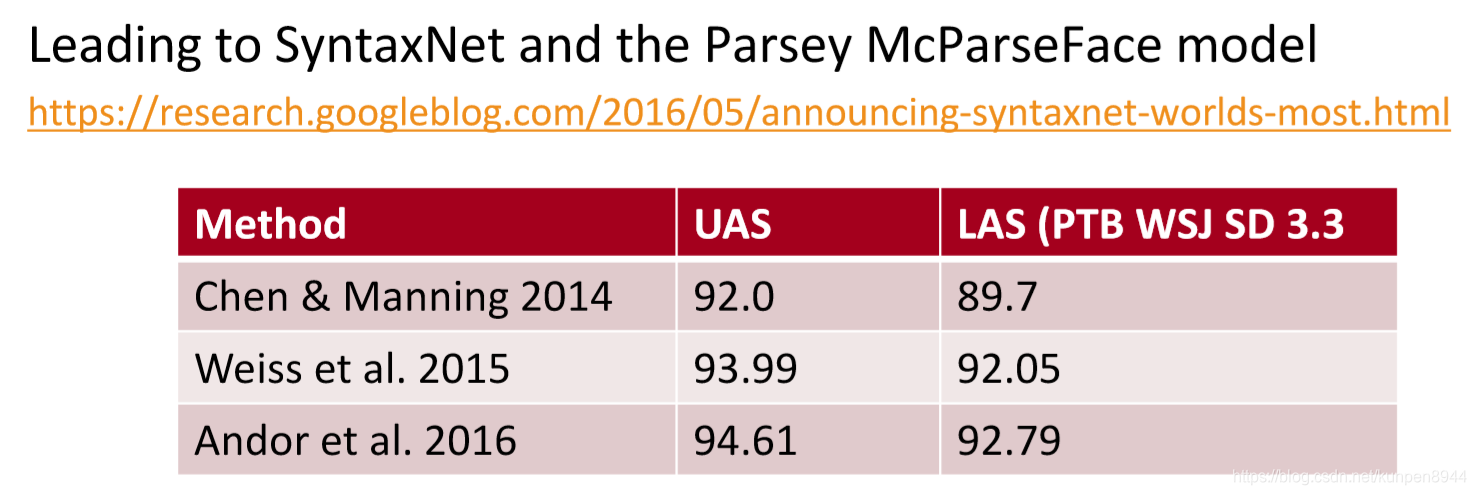

這個思想被後來的研究者進一步發揚光大,特別是google- 更大、更深的神經網路,更好的超參

- 束搜尋(beam search)

- 基於決策序列的條件隨機場(CRF)