Stage生成Task

一、stage 的處理過程

1、從下圖可以看出stage是通過遞歸的形式,從開始依次提交每個stage,直到ResultStage。

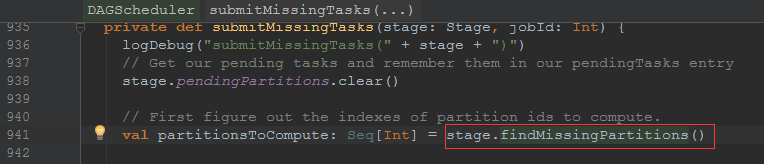

2、生成task的主要代碼

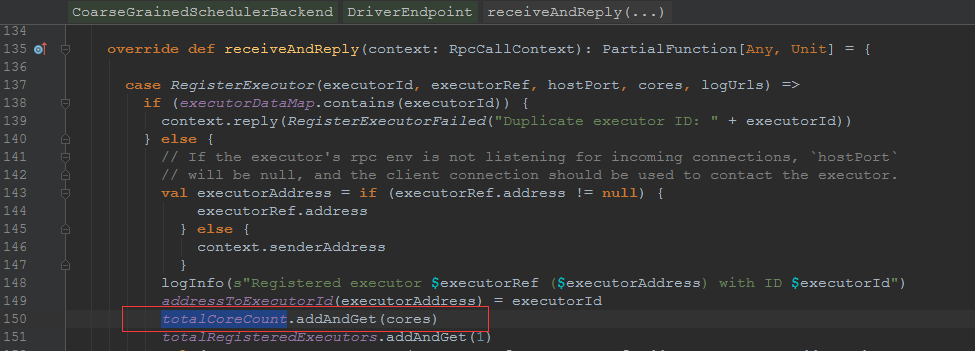

3、提交到taskScheduler

4、

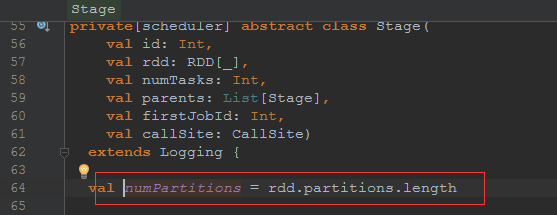

二、每個stage生成的task的個數

從以上的幾幅圖不難發現task的數量其實只與rdd的partition的數量是一致的,所以每個stage的Task的個數其實早就已經確定。

而通過追蹤 sc.textFile 這個方法得到partition是由core數和最小值2所確定的(如下圖)。當然其他的RDD有不同的設定,但是可以知道的

是partition的數量在stage之前就確定,也就是說task的數量其實早已經確定。

Task的具體情況,下次繼續分解。

Stage生成Task

相關推薦

Stage生成Task

情況 分享 個數 開始 過程 數量 images image sta 一、stage 的處理過程 1、從下圖可以看出stage是通過遞歸的形式,從開始依次提交每個stage,直到ResultStage。 2、生成task的主要代碼

Spark的stage & job & task 到底是什麼 ,以及劃分原理

這幾個概念很容易混淆,需要寫一遍文章梳理 Spark的stage & job & task 到底是什麼 ,以及劃分原理 Stage 是spark 中一個非常重要的概念 , 在一個job 中劃分stage 的一個重要依據是否有shuflle 發生 ,也就是是

sparksql 報錯 ERROR TaskSetManager: Task 0 in stage 0.0 failed 1 times; aborting job 大神解釋一下 謝謝

ERROR TaskSetManager: Task 0 in stage 0.0 failed 1 times; aborting job Exception in thread "main" org.apache.spark.SparkException: Job aborted d

DAGScheduler原始碼分析stage劃分演算法,task最佳位置計算演算法

在DAGScheduler類中的HandleJobSubmitted是job排程的核心入口 進入了newStage()方法它會建立一個stage物件 進入submitStage()方法 進入getMissingParentStages方法() 進入s

sparksql 報錯 ERROR TaskSetManager: Task 0 in stage 0.0 failed 1 times; aborting job 大神解釋一下 謝謝

ERROR TaskSetManager: Task 0 in stage 0.0 failed 1 times; aborting job Exception in thread "main" org.apache.spark.SparkException: Job ab

spark中job stage task關係

1.1 例子,美國 1880 - 2014 年新生嬰兒資料統計 目標:用美國 1880 - 2014 年新生嬰兒的資料來做做簡單的統計 資料格式: 每年的新生嬰兒資料在一個檔案裡面 每個檔案的每一條資料格式:姓名,性別,新生人數 1.2 執行流程概覽 上面

15.5.1【Task實現細節】 生成的程式碼

還在嗎?我們開始吧。由於深入講解需上百頁的篇幅,因此這裡我不會講得太深。但我會提 供足夠的背景知識,以有助於你對整個結構的理解。之後可通過閱讀我近些年來撰寫的部落格文章, 來了解更加錯綜複雜的細節,或簡單地編寫一些非同步程式碼並反編譯。同樣地,這裡我只介紹非同步 方法,它包含了所有有趣的機制,並且不需要處

大資料:Spark Core(二)Driver上的Task的生成、分配、排程

1. 什麼是Task?在前面的章節裡描述過幾個角色,Driver(Client),Master,Worker(Executor),Driver會提交Application到Master進行Worker上的Executor上的排程,顯然這些都不是Task.Spark上的幾個關係

自定義task生成jar包

背景:之前轉載過別人的在build.gradle中自定義task來打Jar包的文章 文章地址:http://blog.csdn.net/u010479969/article/details/76096162 如果是簡單的單一工程需求,這個完全可以滿足,但是作為如果想要支撐

Spark2.3.2原始碼解析: 10. 排程系統 Task任務提交 (一) DAGScheduler 之 stage 提交

一個Spark Application分為stage級別和task級別的排程, task來源於stage,所有本文先從stage提交開始講解task任務提交。 架構圖: Standalone模式提交執行流程圖: 首先寫一個W

opencv3.0訓練自己的級聯分類器(traincascade),將已經生成的stage.xml合成最終的分類器xml

最近一段在用opencv自帶的分類器訓練函式訓練分類器,遇到了一點問題: 分類器預設的stage=20太深,當訓練到第6層時,已經收斂,而由於訓練資料非常多,再往下訓練非常耗時(已經卡住三天了),因此我就想,如何把目前生成的6層弱分類器連線起來,當做最終的分類

Spark中Task,Partition,RDD、節點數、Executor數、core數目的關係和Application,Driver,Job,Task,Stage理解

梳理一下Spark中關於併發度涉及的幾個概念File,Block,Split,Task,Partition,RDD以及節點數、Executor數、core數目的關係。 輸入可能以多個檔案的形式儲存在HDFS上,每個File都包含了很多塊,稱為Block。 當Spar

Spark排程系列-----5.Spark task和Stage的跳過執行(ui顯示task和stage skipped)

在spark的首頁ui上經常顯示任務和Stage被skipped,如以下截圖所式: 本文將闡述什麼情況下Stage或者Task會顯示為skipped,以及stage和task顯示為skipped的時候是否spark application執行會出問題? Sp

spark 原始碼分析之十九 -- DAG的生成和Stage的劃分

上篇文章 spark 原始碼分析之十八 -- Spark儲存體系剖析 重點剖析了 Spark的儲存體系。從本篇文章開始,剖析Spark作業的排程和計算體系。 在說DAG之前,先簡單說一下RDD。 對RDD的整體概括 文件說明如下: RDD全稱Resilient Distribu

Spark Job-Stage-Task例項理解

# Spark Job-Stage-Task例項理解 基於一個word count的簡單例子理解Job、Stage、Task的關係,以及各自產生的方式和對並行、分割槽等的聯絡; ### 相關概念 - Job:Job是由Action觸發的,因此一個Job包含一個Action和N個Transform操作;

JS生成指定位數的隨機

可能 過程 con 次方 blog dom and 定位 問題: <html><script> //獲取指定位數的隨機數 function getRandom(num){ var random = Math.floor((Math.

WF4.0以上使用代碼完整自定義動態生成執行工作流Xaml文件

load 控制 brush 類型 rpv 返回 cap 並且 sco 給大家分享一下,如何完全使用代碼自定義的創建生成工作流文件(用代碼創建Xaml文件),並且動態加載運行所生成的工作流。 工作流生成後 在Xaml文件裏的主要節點如下: 輸入輸出參數 <x

國家商用password(五)基於SM2的軟件授權碼生成及校驗

clas 信息 ecp register 方法 序列號 mod 生成 pub 將公開密鑰算法作為軟件註冊算法的優點是Cracker非常難通過跟蹤驗證算法得到註冊機。以下。將介紹使用SM2國密算法進行軟件註冊的方法。 生成授權碼 選擇SM2橢圓曲線參數(P,a,b,N,

Web驗證碼圖片的生成-基於Java的實現

submit esc page resp ioe 代碼 oge cnblogs pro 驗證碼圖片是由程序動態產生的,每次訪問的內容都是隨機的。那麽如何采用程序動態產生圖片,並能夠顯示在客戶端頁面中呢?原理很簡單,對於java而言,我們首先開發一個Servlet,這個Se

生成本月日歷

copy 時間 sel join 返回 max edi ges images 如果對日期函數比較熟悉的話,要實現日歷的功能並不難。本文中主要用到的日期函數有: DATEADD(datepart,number,date) --在日期中添加或減去指定的時間間隔 DAT