2018.10.31 作業八

阿新 • • 發佈:2018-10-31

1.用python實現K均值演算法

K-means是一個反覆迭代的過程,演算法分為四個步驟:

(x,k,y)

1) 選取資料空間中的K個物件作為初始中心,每個物件代表一個聚類中心;

def initcenter(x, k): kc

2) 對於樣本中的資料物件,根據它們與這些聚類中心的歐氏距離,按距離最近的準則將它們分到距離它們最近的聚類中心(最相似)所對應的類;

def nearest(kc, x[i]): j

def xclassify(x, y, kc):y[i]=j

3) 更新聚類中心:將每個類別中所有物件所對應的均值作為該類別的聚類中心,計算目標函式的值;

def kcmean(x, y, kc, k):

4) 判斷聚類中心和目標函式的值是否發生改變,若不變,則輸出結果,若改變,則返回2)。

while flag:

y = xclassify(x, y, kc)

kc, flag = kcmean(x, y, kc, k)

4. 鳶尾花完整資料做聚類並用散點圖顯示.

import numpy as np

x = np.random.randint(1,100,[20,1])

y = np.zeros(20)

k = 3

#1) 選取資料空間中的K個物件作為初始中心,每個物件代表一個聚類中心

def initcenter(x,k):

return x[:k].reshape(k)

#2) 對於樣本中的資料物件,根據它們與這些聚類中心的歐氏距離,按距離最近的準則將它們分到距離它們最近的聚類中心(最相似)所對應的類

def nearest(kc,i):

d = abs(kc-i)

w = np.where(d == np.min(d))

return w[0][0]

#用for迴圈遍歷,把隨機陣列自動劃分到與它距離最近的類,返回類的下標y

def xclassify(x,y,kc):

for i in range(x.shape[0]):

y[i] = nearest(kc,x[i])

return y

#3) 更新聚類中心:將每個類別中所有物件所對應的均值作為該類別的聚類中心,計算目標函式的值

def kcmean(x,y,kc,k):

l = list(kc)

flag = False

for c in range(k):

m = np.where(y==c)

if m[0].shape != (0,):

n = np.mean(x[m])

if l[c] != n:

l[c] = n

flag = True

return(np.array(l),flag)

#4) 判斷聚類中心和目標函式的值是否發生改變,若不變,則輸出結果,若改變,則返回2

kc = initcenter(x,k)

flag = True

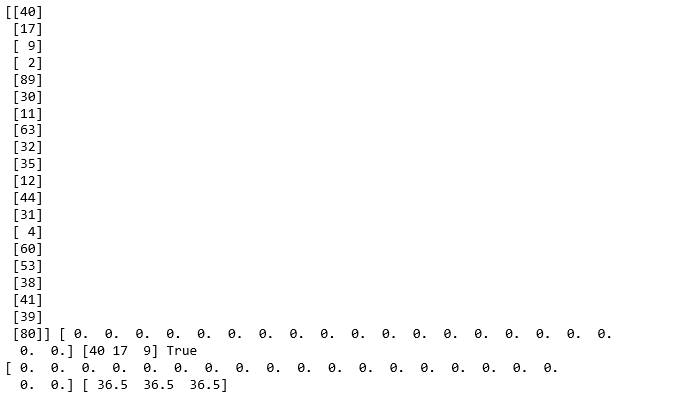

print(x,y,kc,flag)

while flag:

y = xclassify(x,y,kc)

kc,flag = kcmean(x,y,kc,k)

print(y,kc)

執行結果:

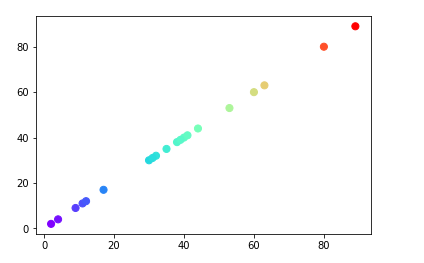

2. 鳶尾花花瓣長度資料做聚類並用散點圖顯示

import matplotlib.pyplot as plt plt.scatter(x,x,c=x,s=50,cmap="rainbow"); plt.show()

執行結果:

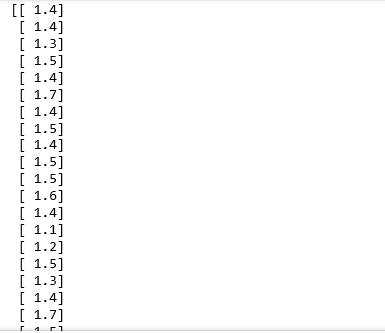

3. 用sklearn.cluster.KMeans,鳶尾花花瓣長度資料做聚類並用散點圖顯示

from sklearn.cluster import KMeans import numpy as np from sklearn.datasets import load_iris import matplotlib.pyplot as plt data = load_iris() iris = data.data petal_len = iris[:,2:3] print(petal_len) k_means = KMeans(n_clusters=3) #三個聚類中心 result = k_means.fit(petal_len) #Kmeans自動分類 kc = result.cluster_centers_ #自動分類後的聚類中心 y_means = k_means.predict(petal_len) #預測Y值 plt.scatter(petal_len,np.linspace(1,150,150),c=y_means,marker='x') plt.show()

執行結果:

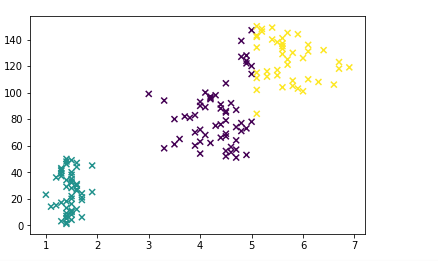

4. 鳶尾花完整資料做聚類並用散點圖顯示

import matplotlib.pyplot as plt import numpy as np from sklearn.datasets import load_iris iris = load_iris() X = iris.data X from sklearn.cluster import KMeans est = KMeans(n_clusters = 3) est.fit(X) kc = est.cluster_centers_ y_kmeans = est.predict(X) #預測每個樣本的聚類索引 print(y_kmeans,kc) print(kc.shape,y_kmeans.shape,np.shape) plt.scatter(X[:,0],X[:,1],c=y_kmeans,s=50,cmap='rainbow'); plt.show()

執行結果: